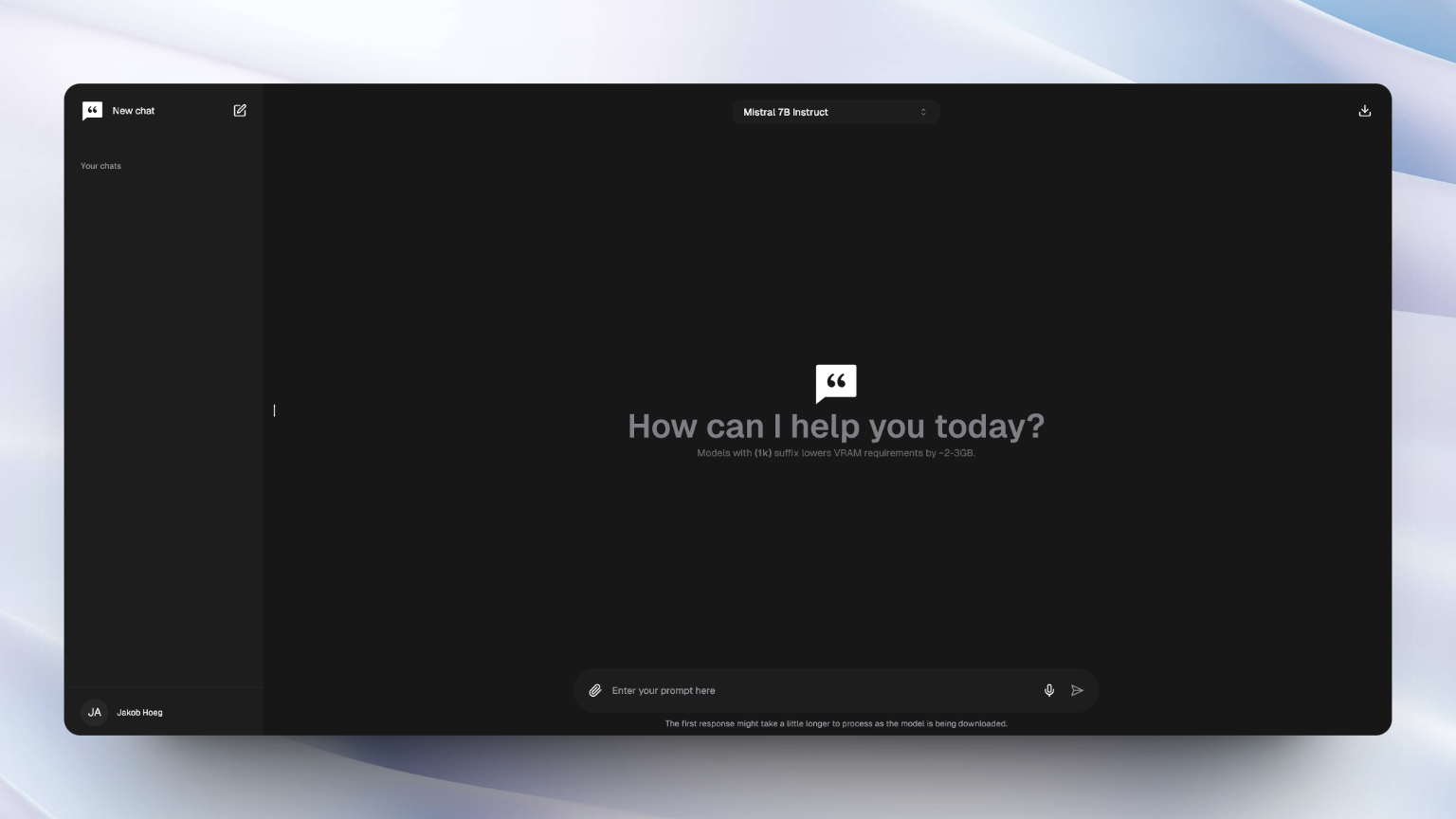

Chatty é a sua IA privada que utiliza o WebGPU para executar grandes modelos de idiomas (LLMS) nativamente e privadamente no seu navegador, trazendo a você a experiência mais rica de AI no navegador.

Este projeto deve ser a tentativa mais próxima de trazer a família e a funcionalidade de interfaces populares de IA, como ChatGPT e Gemini, para uma experiência no navegador.

Por padrão, o WebGPU é ativado e suportado no Chrome e no Edge. No entanto, é possível habilitá -lo no Firefox e no Firefox todas as noites. Verifique a compatibilidade do navegador para obter mais informações.

Se você deseja apenas experimentar o aplicativo, ele está ao vivo neste site.

Este é um aplicativo Next.js e requer Node.js (18+) e NPM instalados para executar o projeto localmente.

Se você deseja configurar e executar o projeto localmente, siga as etapas abaixo:

1. Clone o repositório para um diretório no seu PC via prompt de comando:

git clone https://github.com/addyosmani/chatty

2. Abra a pasta:

cd chatty

3. Instale dependências:

npm install

4. Inicie o servidor de desenvolvimento:

npm run dev

5. Vá para localhost: 3000 e comece a conversar!

Observação

O Dockerfile ainda não foi otimizado para um ambiente de produção. Se você deseja fazer isso a si mesmo, consulte o exemplo do próximojs

docker build -t chattyui .

docker run -d -p 3000:3000 chattyui

Ou use docker-compose :

docker compose up

Se você fez alterações e deseja se reconstruir, você pode simplesmente executar

docker-compose up --build

As contribuições são mais do que bem -vindas! No entanto, certifique -se de ler as diretrizes contribuintes primeiro :)

Observação

Para executar os modelos com eficiência, você precisará de uma GPU com memória suficiente. Os modelos 7b requerem uma GPU com memória de cerca de 6 GB, enquanto os modelos 3b requerem cerca de 3 GB.

Modelos menores podem não ser capazes de processar incorporações de arquivos tão eficientes quanto os maiores.

Chatty é construído usando o projeto Webllm, utilizando o HuggingFace, o Open Source LLMS e o Langchain. Queremos reconhecer seu excelente trabalho e agradecer à comunidade de código aberto.

A conversação é criada e mantida por Addy Osmani e Jakob Hoeg Mørk.