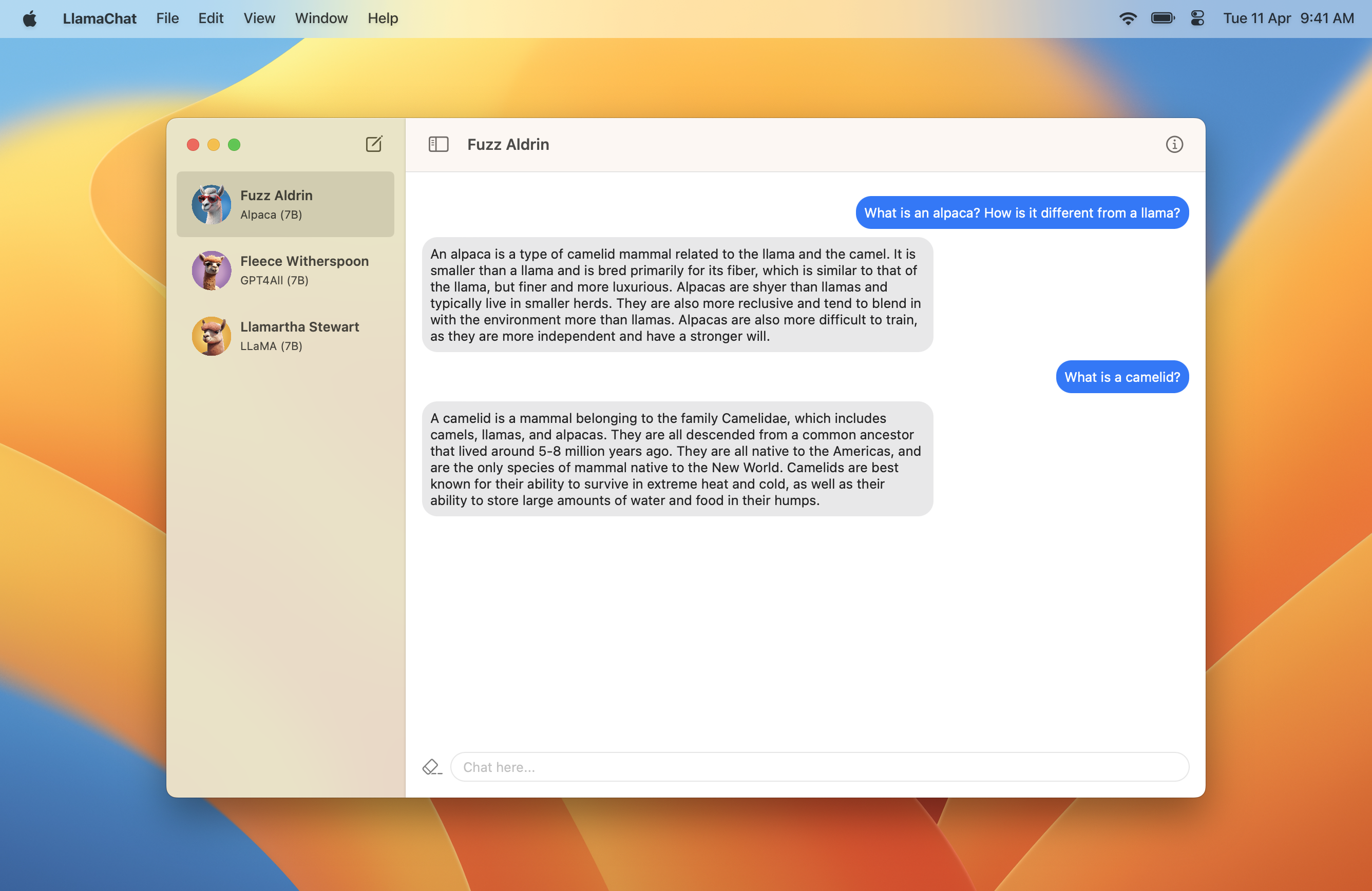

LlamaChat

v1.2.0: Model Hyperparameters ⚡️

Llamachat是一个MacOS应用程序,可让您与Llama,羊驼和GPT4All模型聊天,这些模型均在Mac上本地运行。

Llamachat需要Macos 13 Ventura,以及Intel或Apple Silicon处理器。

在此处下载包含最新版本的.dmg 。

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeproj注意: Llamachat包括用于自动汇款的闪光,如果没有签署Llamachat,它们将无法加载。确保在建造和运行Llamachat时使用有效的签名证书。

注意:模型推理在调试构建中非常缓慢地运行,因此,如果从源构建构建,请确保Llamachat中的Build Configuration LlamaChat > Edit Scheme... > Run设置为Release 。

.pth Pytorch检查点表单或.ggml格式中添加Llama型号。.ggml文件。注意: Llamachat不使用任何型号文件运送,并且要求您根据各自的条款和条件从各个来源获得这些文件。

.pth )或预转换的.ggml文件(Llama.cpp使用的格式)中使用Llama模型家族。.pth格式导入Llama模型时:7B , 13B等),其中包括consolidated.NN.pth和params.json文件。tokenizer.model 。例如,要使用Llama-13b模型,您的模型目录应该看起来像以下内容,并且应该选择13B目录: .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggml文件,请确保这些文件是最新的。如果遇到问题,则可能需要使用Llama.cpp的转换脚本:欢迎拉拉请求和问题。请确保始终遵守行为准则。

Llamachat是使用Swift and Swiftui完全建造的,并利用Llama.swift在引擎盖下进行推理和执行模型操作。

该项目主要是使用MVVM构建的,并大量使用联合收割机和快速并发。

Llamachat已获得MIT许可证的许可。