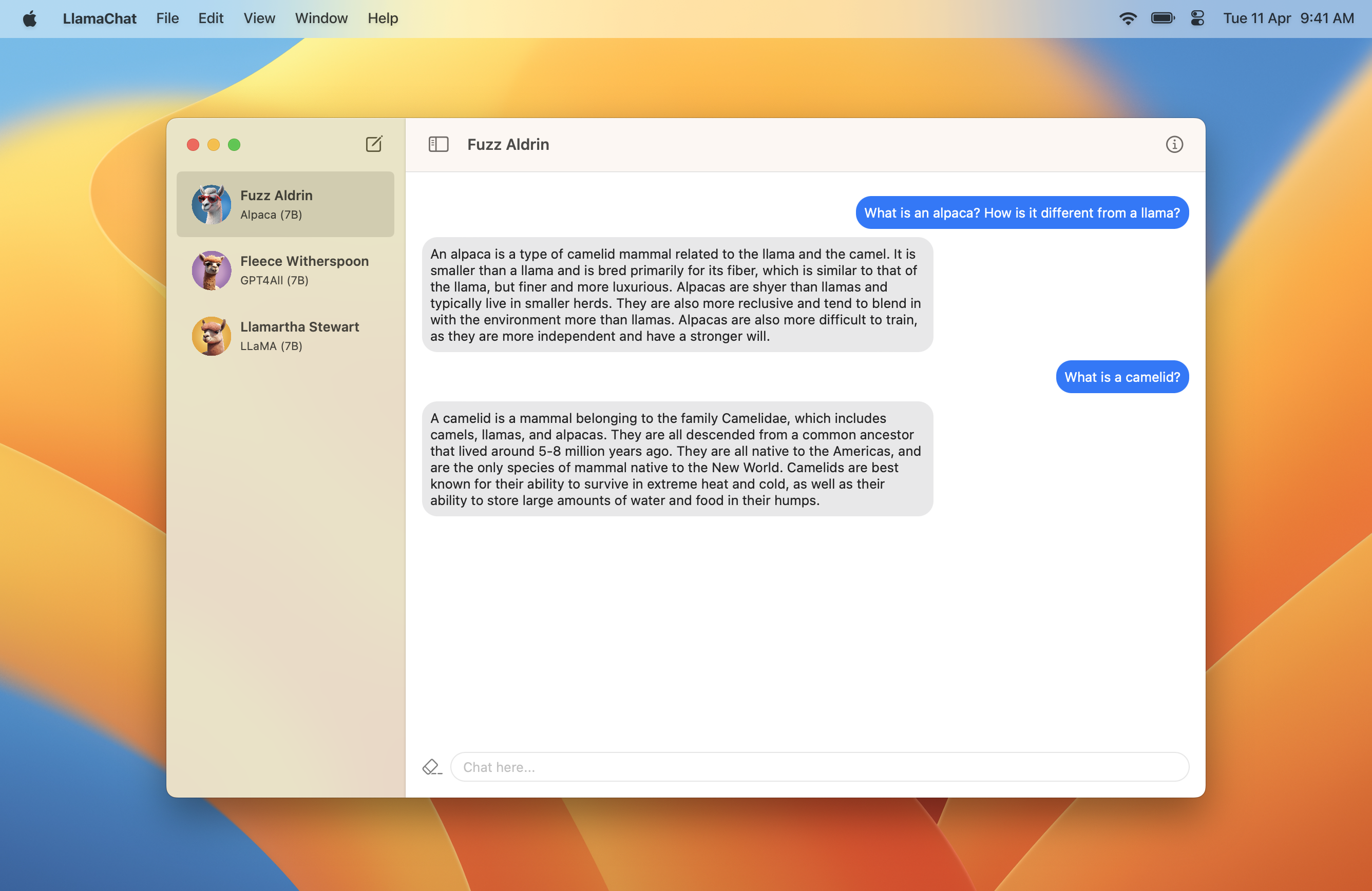

Llamachat ist eine MacOS -App, mit der Sie mit Lama-, Alpaka- und GPT4all -Modellen chatten können, die alle lokal auf Ihrem Mac ausgeführt werden.

Llamachat benötigt MacOS 13 Ventura und entweder einen Intel- oder Apfel -Siliziumprozessor.

Laden Sie hier eine .dmg herunter, die die neueste Version enthält?

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeprojHINWEIS: Lamachat enthält Sparkle für Autoupdates, die nicht geladen werden, wenn Lamachat nicht unterschrieben ist. Stellen Sie sicher, dass Sie beim Aufbau und Betrieb von Lamachat ein gültiges Unterschriftenzertifikat verwenden.

HINWEIS: Die Modellinferenz läuft in Debug -Builds sehr langsam. Wenn Sie also aus Source erstellen, stellen Sie sicher, dass die Build Configuration in LlamaChat > Edit Scheme... > Run für Release ist.

.pth -Pytorch -Checkpoints -Formular oder im .ggml -Format..ggml -Dateien konvertiert werden, die mit Llamachat und Lama.cpp in der App kompatibel sind.Hinweis: Lamachat wird nicht mit Modelldateien versendet und verlangt, dass Sie diese aus den jeweiligen Quellen gemäß ihren jeweiligen Bedingungen erhalten.

.pth ) oder in der vorkonvertierten .ggml Datei (das von llama.cpp verwendete Format zu verwenden, das Llamachat verwendet)..pth -Format:params.json B. 7B , 13B usw.) im Konvertierungsfluss auswählen, der die consolidated.NN.pth Dateien enthält.tokenizer.model enthalten. Zum Beispiel sollte Ihr Modellverzeichnis etwa das LLAMA-13B-Modell verwenden, und Sie sollten das 13B Verzeichnis auswählen: .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggml Dateien verwenden, stellen Sie sicher, dass diese aktuell sind. Wenn Sie auf Probleme stoßen, müssen Sie möglicherweise die Conversion -Skripte von llama.cpp verwenden:Anfragen und Probleme sind willkommen und sehr geschätzt. Bitte halten Sie sich jederzeit an den Verhaltenskodex.

Llamachat ist mit Swift und Swiftui vollständig gebaut und nutzt Lama. Widdet unter der Motorhaube, um Schluss zu führen und Modellvorgänge auszuführen.

Das Projekt wird hauptsächlich mit MVVM gebaut und nutzt die Kombination und die schnelle Parallelität stark.

Llamachat ist unter der MIT -Lizenz lizenziert.