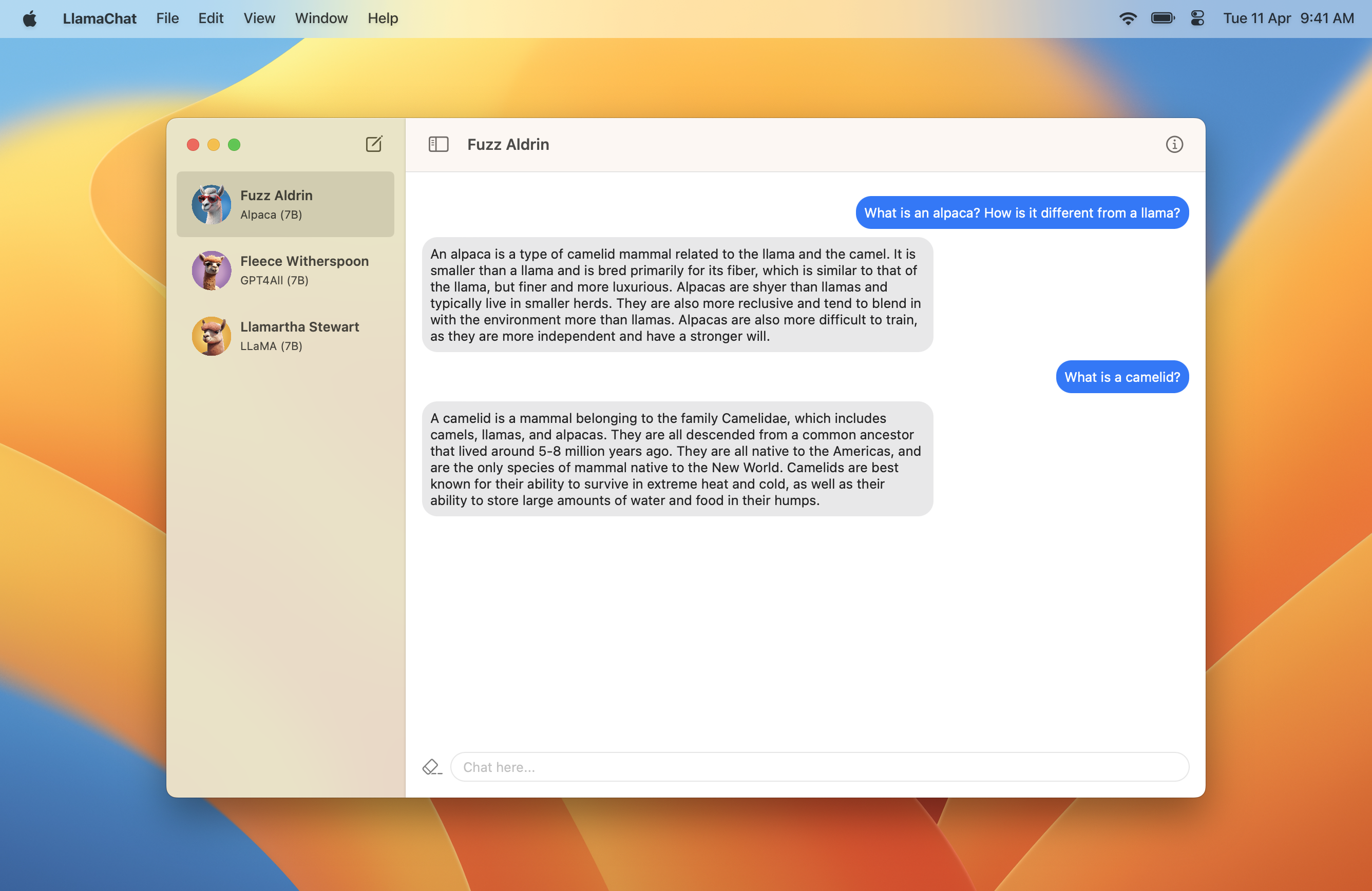

LlamaChat

v1.2.0: Model Hyperparameters ⚡️

Llamachat 은 Mac에서 Llama, Alpaca 및 GPT4ALL 모델과 채팅 할 수있는 MACOS 앱입니다.

Llamachat에는 MacOS 13 Ventura와 Intel 또는 Apple Silicon 프로세서가 필요합니다.

여기에 최신 버전이 포함 된 .dmg 다운로드 하시겠습니까?.

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeproj참고 : Llamachat에는 Autupdates 용 Sparkle이 포함되어 있으며 Llamachat이 서명되지 않으면로드하지 않습니다. Llamachat을 구축하고 실행할 때 유효한 서명 인증서를 사용하는지 확인하십시오.

참고 : 디버그 빌드에서 모델 추론이 실제로 느리게 실행되므로 소스로부터 빌드가 Llamachat> 편집 체계의 Build Configuration LlamaChat > Edit Scheme... > Run Release 되도록 설정되어 있는지 확인하십시오.

.pth Pytorch 체크 포인트 양식 또는 .ggml 형식으로 LLAMA 모델을 추가하는 것을 지원합니다..ggml 파일로 변환 할 수 있습니다.참고 : Llamachat은 모델 파일과 함께 배송되지 않으며 해당 이용 약관에 따라 해당 소스에서이를 얻어야합니다.

.pth ) 또는 사전 전환 된 .ggml 파일 (llama.cpp에서 사용하는 형식, llamachat에 전원)으로 사용할 수 있습니다..pth 형식으로 라마 모델을 가져올 때 :consolidated.NN.pth 및 params.json 파일을 포함하는 변환 흐름에서 적절한 매개 변수 크기 디렉토리 (예 : 7B , 13B 등)를 선택해야합니다.tokenizer.model 포함되어야합니다. 예를 들어 LLAMA-13B 모델을 사용하려면 모델 디렉토리가 아래와 같은 것으로 보이며 13B 디렉토리를 선택해야합니다. .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggml 파일을 사용하는 경우 최신 상태인지 확인하십시오. 문제가 발생하면 llama.cpp의 변환 스크립트를 사용해야 할 수도 있습니다.풀 요청과 문제를 환영하며 대단히 감사합니다. 항상 행동 강령을 준수해야합니다.

Llamachat은 Swift와 Swiftui를 사용하여 완전히 구축되었으며 Llama.swift를 사용하여 추론을 실행하고 모델 작업을 수행합니다.

이 프로젝트는 주로 MVVM을 사용하여 구축되며 Combine 및 Swift 동시성을 많이 사용합니다.

Llamachat은 MIT 라이센스에 따라 라이센스가 부여됩니다.