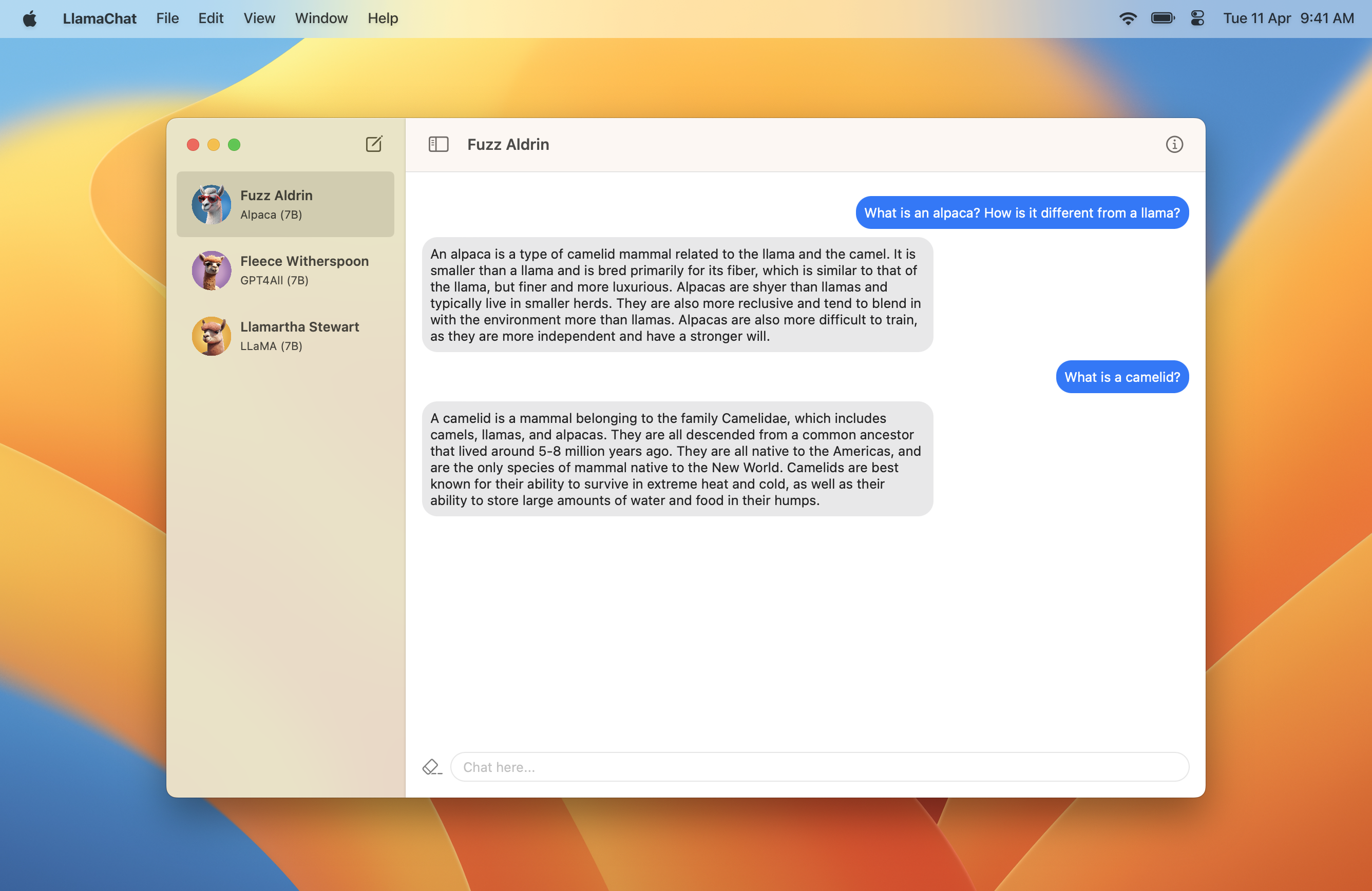

LlamaChat

v1.2.0: Model Hyperparameters ⚡️

LlamachatはMacOSアプリで、Llama、Alpaca、およびGPT4Allモデルとチャットできます。

Llamachatには、Macos 13 Ventura、およびIntelまたはApple Siliconプロセッサが必要です。

ここに最新バージョンを含む.dmgをダウンロードしますか?

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeproj注: Llamachatには、llamachatが署名されていない場合、オートペンツのSparkle for AutopDatesが含まれています。 Llamachatを構築および実行するときに、有効な署名証明書を使用していることを確認してください。

注:モデルの推論はデバッグビルドで非常にゆっくりと実行されるため、ソースからビルドがLlamaChat > Edit Scheme... > RunのBuild Configuration ...>実行がReleaseように設定されていることを確認してください。

.pth 、rlamaモデルの追加の追加.ggmlサポートしています。.ggmlファイルに変換できます。注: Llamachatはモデルファイルを搭載しておらず、それぞれの利用規約に従ってそれぞれのソースからこれらを取得する必要があります。

.pth )または事前に変換された.ggmlファイル(Llamachatを搭載しているLlama.cppが使用する形式)のいずれかを使用できます。.pth形式でllamaモデルをインポートする場合:consolidated.NN.pthおよびparams.jsonファイルを含む、変換フローで適切なパラメーターサイズディレクトリ( 7B 、 13Bなど)を選択する必要があります。tokenizer.modelを含める必要があります。たとえば、LLAMA-13Bモデルを使用するには、モデルディレクトリが以下のように見える必要があります。13Bディレクトリ13B選択する必要があります。 .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggmlファイルを使用する場合、これらが最新であることを確認してください。問題が発生した場合は、llama.cppからの変換スクリプトを使用する必要がある場合があります。リクエストと問題を歓迎し、大いに感謝しています。常に行動規範を遵守してください。

Llamachatは、SwiftとSwiftuiを使用して完全に構築されており、Llama.swiftを使用して、推論を実行してモデル操作を実行します。

このプロジェクトは、主にMVVMを使用して構築されており、コンバインとスウィフトの並行性を重視しています。

LlamachatはMITライセンスの下でライセンスされています。