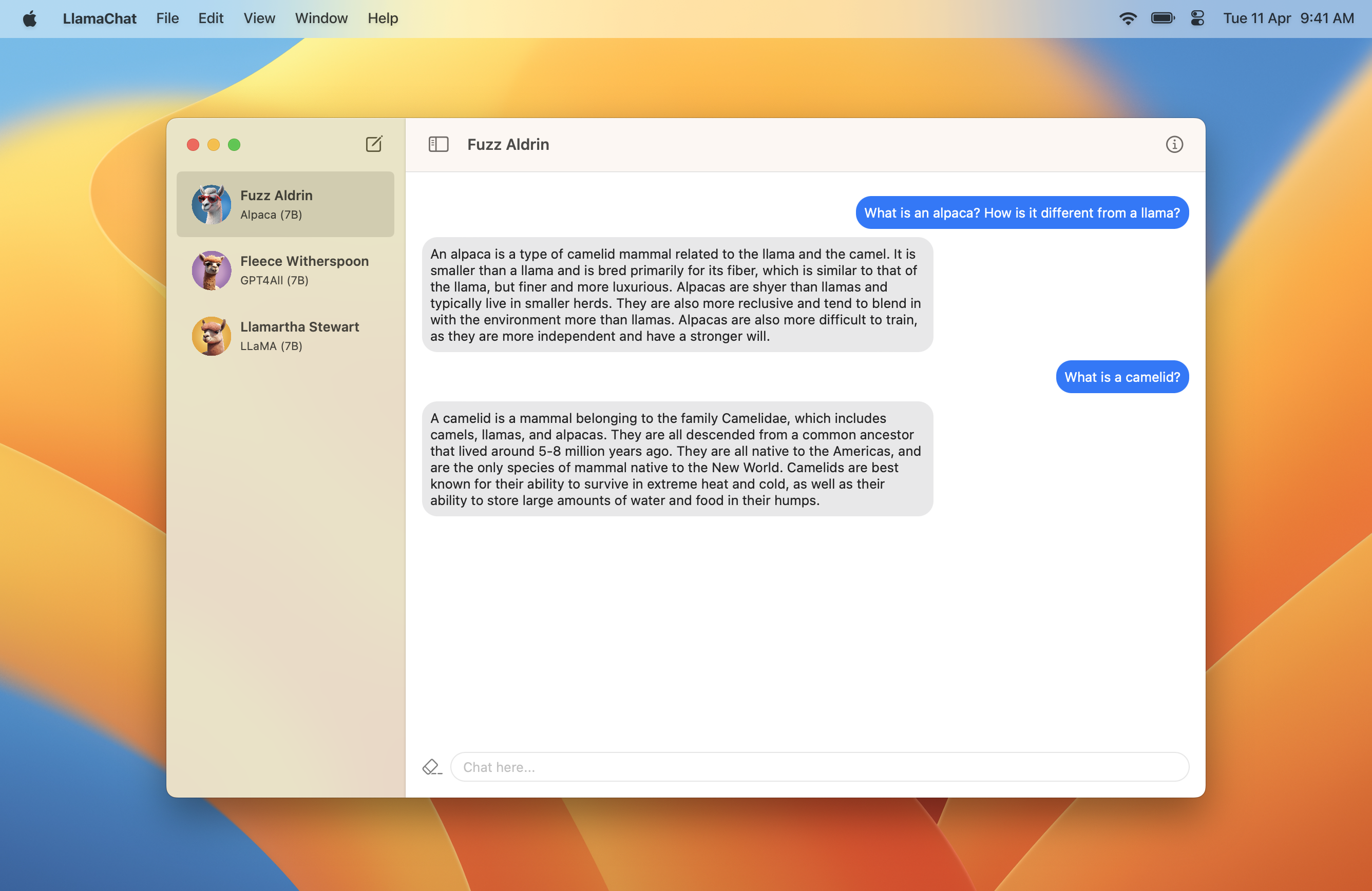

Llamachat est une application macOS qui vous permet de discuter avec les modèles LLAMA, Alpaca et GPT4ALL tous en cours d'exécution localement sur votre Mac.

Llamachat a besoin de macOS 13 Ventura et d'un processeur Intel ou Apple Silicon.

Téléchargez un .dmg contenant la dernière version ici ?.

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeprojRemarque: Llamachat comprend Sparkle pour Autoupdates, qui ne se chargera pas si Llamachat n'est pas signé. Assurez-vous d'utiliser un certificat de signature valide lors de la construction et de la gestion de Llamachat.

Remarque: L'inférence du modèle s'exécute très lentement dans les builds de débogage, donc si la construction à partir de la source assurez-vous que la Build Configuration dans LlamaChat > Edit Scheme... > Run est définie à Release .

.pth pytorch de contrôle ou le format .ggml ..ggml compatibles avec llamachat et llama.cpp au sein de l'application.Remarque: Llamachat n'en est-il pas expédié avec des fichiers de modèle et exige que vous les obteniez à partir des sources respectives conformément à leurs termes et conditions respectifs.

.pth ) ou le fichier .ggml pré-converti (le format utilisé par llama.cpp, qui alimente Llamachat)..pth :7B , 13B , etc.) dans le flux de conversion, qui comprend les fichiers consolidated.NN.pth et params.json .tokenizer.model . Par exemple, pour utiliser le modèle LLAMA-13B, votre répertoire de modèle doit ressembler à ce qui ci-dessous, et vous devez sélectionner le répertoire 13B : .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggml , assurez-vous qu'ils sont à jour. Si vous rencontrez des problèmes, vous devrez peut-être utiliser les scripts de conversion de llama.cpp:Les demandes de traction et les problèmes sont les bienvenues et très appréciées. Veuillez vous assurer d'adhérer au code de conduite à tout moment.

Llamachat est entièrement construit à l'aide de Swift et Swiftui, et utilise Llama.swift sous le capot pour exécuter l'inférence et effectuer des opérations de modèle.

Le projet est principalement construit à l'aide de MVVM et utilise fortement la concurrence combinée et rapide.

Llamachat est autorisé en vertu de la licence du MIT.