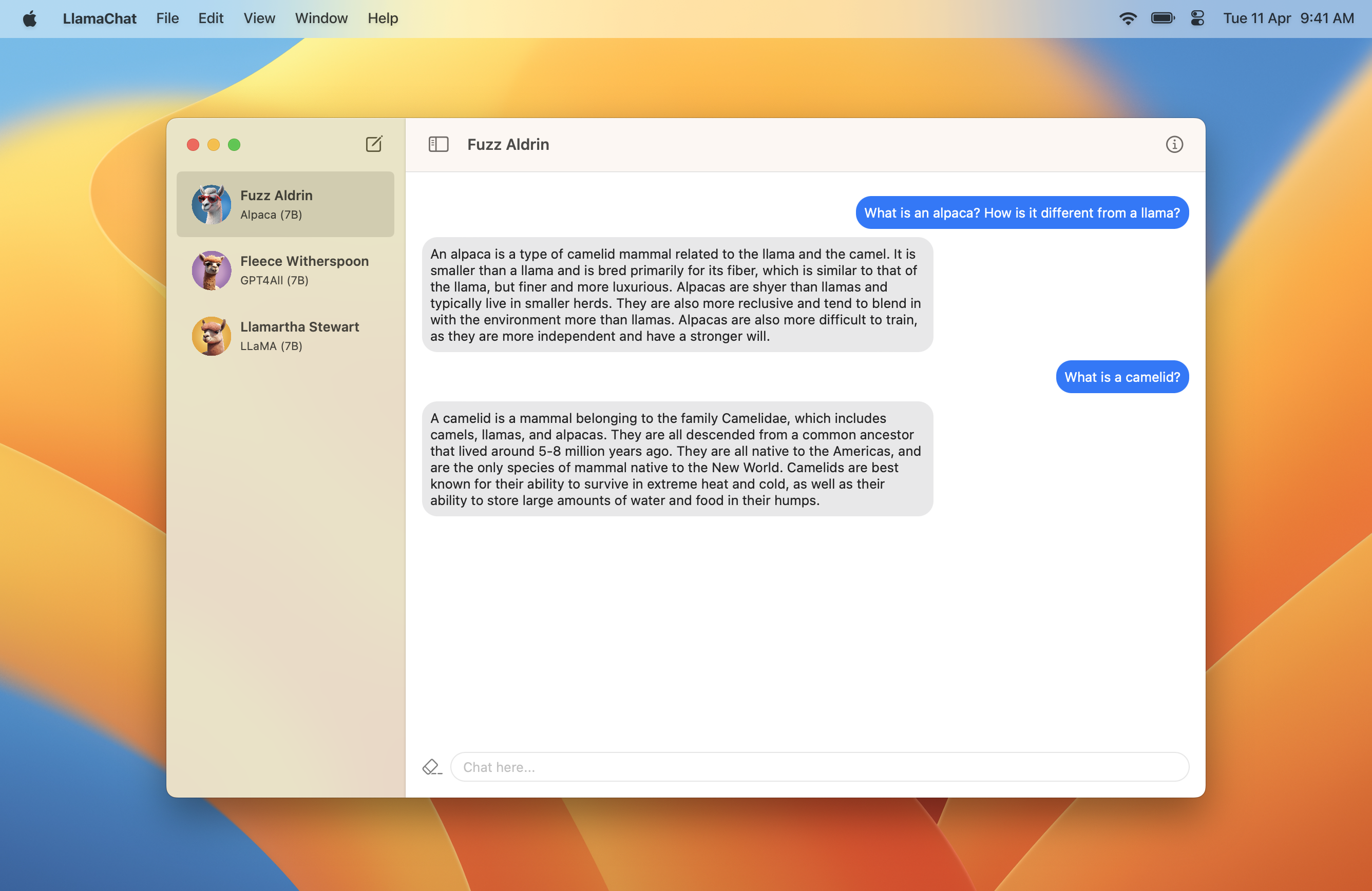

Llamachat هو تطبيق MacOS يتيح لك الدردشة مع طرازات Llama و Alpaca و GPT4ALL التي تعمل محليًا على جهاز Mac.

يتطلب Llamachat MacOS 13 Ventura ، وإما معالج Intel أو Apple Silicon.

قم بتنزيل .dmg يحتوي على أحدث إصدار هنا؟

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeprojملاحظة: يتضمن Llamachat Sparkle for AutoupDates ، والذي سيفشل في التحميل إذا لم يتم توقيع Llamachat. تأكد من استخدام شهادة توقيع صالحة عند بناء وتشغيل Llamachat.

ملاحظة: يعمل استدلال النموذج ببطء شديد في بناء التصحيح ، لذلك إذا تم بناء من المصدر ، تأكد من أن Build Configuration في LlamaChat > Edit Scheme... > Run Release

.pth أو تنسيق .ggml ..ggml متوافقة مع Llamachat و Llama.cpp داخل التطبيق.ملاحظة: لا يشحن Llamachat مع أي ملفات نموذجية ويتطلب أن تحصل على هذه المصادر المعنية وفقًا لشروطها وأحكامها.

.pth ) أو ملف .ggml المحول مسبقًا (التنسيق الذي يستخدمه Llama.cpp ، الذي يعمل على تشغيل Llamachat)..pth :7B ، 13B إلخ) في تدفق التحويل ، والذي يتضمن ملفات consolidated.NN.pth و params.json .tokenizer.model . على سبيل المثال لاستخدام نموذج LLAMA-13B ، يجب أن يبدو دليل النموذج الخاص بك مثل ما يلي ، ويجب عليك تحديد دليل 13B : .

│ ...

├── 13B

│ ├── checklist.chk.txt

│ ├── consolidated.00.pth

│ ├── consolidated.01.pth

│ └── params.json

│ ...

└── tokenizer.model.ggml ، تأكد من أنها محدثة. إذا واجهت مشكلات ، فقد تحتاج إلى استخدام البرامج النصية للتحويل من llama.cpp:طلبات السحب والمشكلات موضع ترحيب وتقدير كبير. يرجى التأكد من الالتزام بقواعد السلوك في جميع الأوقات.

تم تصميم Llamachat بالكامل باستخدام Swift و Swiftui ، ويستفيد من llama.swift تحت الغطاء لتشغيل الاستدلال وأداء عمليات النموذج.

تم تصميم المشروع في الغالب باستخدام MVVM ويستفيد بشكل كبير من التزامن السريع.

Llamachat مرخصة بموجب ترخيص معهد ماساتشوستس للتكنولوجيا.