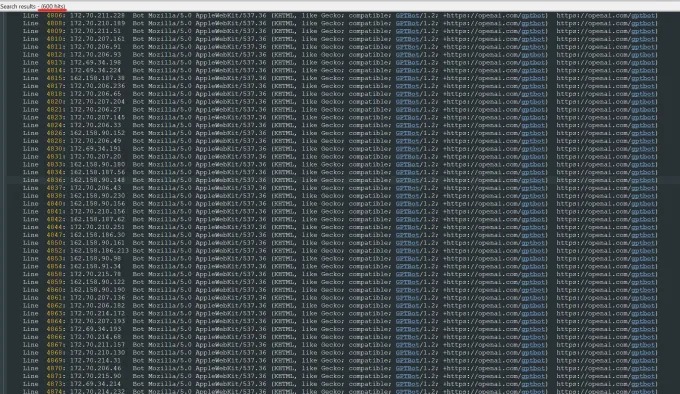

เมื่อเร็ว ๆ นี้ Oleksandr Tomchuk ซีอีโอของ Trilegangers ได้รับการแจ้งเตือนฉุกเฉินว่าเว็บไซต์อีคอมเมิร์ซของ บริษัท ของเขาเป็นอัมพาตทันที หลังจากการสอบสวนในเชิงลึกเขาพบว่ารากของปัญหาอยู่ในหุ่นยนต์ Openai ที่รวบรวมเนื้อหาของเว็บไซต์ทั้งหมดอย่างไม่ลดละ เว็บไซต์ของ TrileGangers มีผลิตภัณฑ์มากกว่า 65,000 รายการแต่ละรายการมีหน้าโดยละเอียดและอย่างน้อยสามภาพ หุ่นยนต์ของ Openai ส่งคำขอเซิร์ฟเวอร์นับหมื่นครั้งเพื่อพยายามดาวน์โหลดทุกอย่างรวมถึงรูปภาพหลายแสนภาพและคำอธิบายของพวกเขา

Tomchuk ชี้ให้เห็นว่า Crawler ของ Openai มีผลกระทบร้ายแรงต่อเว็บไซต์เกือบจะเทียบเท่ากับการโจมตีการปฏิเสธการบริการ (DDOS) ธุรกิจหลักของ TrileGangers คือการจัดหาไฟล์วัตถุและรูปภาพ 3 มิติให้กับศิลปิน 3D นักพัฒนาวิดีโอเกมและผู้ใช้อื่น ๆ ที่ต้องการทำซ้ำลักษณะของมนุษย์ที่แท้จริง เอกสารเหล่านี้รวมถึงข้อมูลการสแกนโดยละเอียดจากมือถึงเส้นผมผิวหนังและร่างกายทั้งหมด

เว็บไซต์ของ TrileGangers เป็นหัวใจสำคัญของธุรกิจ บริษัท ใช้เวลากว่าทศวรรษในการสร้างฐานข้อมูล "สแตนด์อโลนดิจิตอลมนุษย์ที่ใหญ่ที่สุดในเครือข่ายทั้งหมดจากการสแกน 3 มิติของร่างกายมนุษย์จริง ทีมงานของ Tomchuk มีสำนักงานใหญ่ในยูเครน แต่ก็ได้รับใบอนุญาตในแทมปารัฐฟลอริดาสหรัฐอเมริกา แม้ว่าจะมีหน้าข้อกำหนดในการให้บริการในเว็บไซต์ที่ห้ามการรวบรวมข้อมูลหุ่นยนต์ที่ไม่ได้รับอนุญาตอย่างชัดเจน แต่ก็ไม่ได้ปิดกั้นหุ่นยนต์ของ Openai อย่างมีประสิทธิภาพ

เพื่อป้องกันการรวบรวมข้อมูลหุ่นยนต์อย่างมีประสิทธิภาพเว็บไซต์จะต้องกำหนดค่าไฟล์ Robot.txt อย่างถูกต้อง Robot.txt หรือที่เรียกว่าโปรโตคอลการยกเว้นบอทได้รับการออกแบบมาเพื่อแจ้งเครื่องมือค้นหาว่าเนื้อหาไม่ควรจัดทำดัชนี Openai กล่าวในหน้าอย่างเป็นทางการว่าจะเคารพไฟล์เมื่อเว็บไซต์ถูกกำหนดค่าด้วยแท็กที่ถูกห้ามไม่ให้คลาน แต่ยังเตือนว่าหุ่นยนต์ของมันอาจใช้เวลานานถึง 24 ชั่วโมงในการรับรู้ไฟล์ robot.txt ที่อัปเดต

Tomchuk เน้นว่าหากเว็บไซต์ไม่ได้ใช้ Robot.txt อย่างถูกต้อง Openai และ บริษัท อื่น ๆ อาจคิดว่าพวกเขาสามารถรวบรวมข้อมูลได้ตามต้องการ นี่ไม่ใช่ระบบเสริม แต่เป็นมาตรการที่จำเป็นในการปกป้องเนื้อหาของเว็บไซต์ ที่แย่กว่านั้นไม่เพียง แต่ Trilegangers ถูกบังคับให้ออฟไลน์โดยหุ่นยนต์ของ Openai ในช่วงเวลาทำงานของเรา Tomchuk ยังคาดว่าจะเพิ่มขึ้นอย่างมากในค่าใช้จ่าย AWS เนื่องจาก CPU ขนาดใหญ่ของหุ่นยนต์และกิจกรรมดาวน์โหลด

อย่างไรก็ตาม Robot.txt ไม่ใช่ทางออกที่สมบูรณ์ บริษัท AI ปฏิบัติตามข้อตกลงนี้ขึ้นอยู่กับความสมัครใจทั้งหมดหรือไม่ ฤดูร้อนที่ผ่านมาการเริ่มต้น AI อีกครั้งคือ Perplexity ถูกตรวจสอบโดย Wired เนื่องจากความล้มเหลวที่ถูกกล่าวหาว่าไม่ปฏิบัติตามโปรโตคอล Robot.txt ซึ่งดึงดูดความสนใจอย่างกว้างขวาง

Tomchuk กล่าวว่าเขาไม่สามารถหาวิธีติดต่อ Openai และถามเกี่ยวกับเรื่องนี้ได้ Openai ยังไม่ตอบสนองต่อคำขอของ TechCrunch สำหรับความคิดเห็น นอกจากนี้ OpenAI ยังล้มเหลวในการให้ความมุ่งมั่นในระยะยาวของเครื่องมือเลือกไม่รับซึ่งทำให้ปัญหามีความซับซ้อนมากขึ้น

นี่เป็นปัญหาที่ยุ่งยากโดยเฉพาะอย่างยิ่งสำหรับ trilegangers Tomchuk ตั้งข้อสังเกตว่าธุรกิจที่พวกเขามีส่วนร่วมในประเด็นเรื่องสิทธิร้ายแรงเพราะพวกเขากำลังสแกนสำหรับคนจริง ภายใต้ GDPR ของยุโรปและกฎหมายอื่น ๆ เป็นเรื่องผิดกฎหมายที่จะใช้ภาพถ่ายสดออนไลน์โดยไม่ได้รับอนุญาต

กระแทกแดกดันพฤติกรรมโลภของ Openai Robots ทำให้ Trilegangers ตระหนักถึงความอ่อนแอของเว็บไซต์ของพวกเขา Tomchuk กล่าวว่าหากหุ่นยนต์คลานข้อมูลอย่างอ่อนโยนมากขึ้นเขาอาจไม่เคยสังเกตเห็นปัญหา

“ มันน่ากลัวเพราะ บริษัท เหล่านี้ดูเหมือนจะใช้ประโยชน์จากช่องโหว่ในการรวบรวมข้อมูลและพวกเขาพูดว่า“ ถ้าคุณอัปเดต Robot.txt ด้วยแท็กของเราคุณสามารถยกเลิกการไม่เข้า” Tomchuk กล่าว อย่างไรก็ตามสิ่งนี้ทำให้เกิดความผิดต่อเจ้าของธุรกิจขอให้พวกเขาเข้าใจวิธีหยุดหุ่นยนต์เหล่านี้

Tomchuk หวังว่าธุรกิจออนไลน์ขนาดเล็กอื่น ๆ จะตระหนักว่าวิธีเดียวที่จะค้นพบว่าบอท AI กำลังขโมยสินทรัพย์ลิขสิทธิ์บนเว็บไซต์คือการแสวงหาอย่างแข็งขันหรือไม่ เขาไม่ใช่คนเดียวที่หุ่นยนต์ AI มีปัญหา เจ้าของเว็บไซต์อื่น ๆ ยังเปิดเผยต่อ Business Insider ว่าบอทของ Openai รบกวนเว็บไซต์ของพวกเขาอย่างไรและเพิ่มค่าธรรมเนียม AWS ของพวกเขา

ภายในปี 2567 ปัญหานี้คาดว่าจะแย่ลงไปอีก การวิจัยใหม่โดย บริษัท โฆษณาดิจิทัล Doubleverify พบว่า AI Crawlers และ Crawlers ส่งผลให้“ การรับส่งข้อมูลที่ไม่ถูกต้องทั่วไป” เพิ่มขึ้น 86% ซึ่งไม่ได้มาจากผู้ใช้จริง แต่มาจากกิจกรรมของบอท