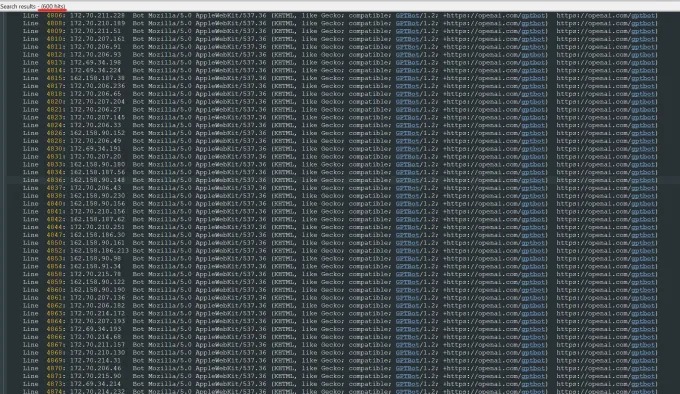

Recentemente, Oleksandr Tomchuk, CEO da TrileGangers, recebeu um alerta de emergência dizendo que o site de comércio eletrônico de sua empresa ficou subitamente paralisado. Após uma investigação aprofundada, ele descobriu que a raiz do problema está em um robô Openai que está incansavelmente rastejando o conteúdo de todo o seu site. O site da TrileGangers possui mais de 65.000 produtos, cada um com páginas detalhadas e pelo menos três imagens. O robô do OpenAI enviou dezenas de milhares de solicitações de servidor para tentar baixar tudo, incluindo centenas de milhares de imagens e suas descrições.

Tomchuk apontou que o rastreador do Openai teve um sério impacto no site, quase equivalente a um ataque de negação de serviço distribuído (DDoS). O principal negócio da TrileGangers é fornecer arquivos e imagens de objeto 3D a artistas 3D, desenvolvedores de videogames e outros usuários que precisam reproduzir digitalmente características humanas reais. Esses documentos incluem dados detalhados de varredura das mãos para os cabelos, a pele e todo o corpo.

O site da TrileGangers está no centro de seus negócios. A empresa passou mais de uma década construindo o maior banco de dados "Digital Human Digital" da rede, tudo a partir de varreduras 3D de corpos humanos reais. A equipe de Tomchuk está sediada na Ucrânia, mas também foi licenciada em Tampa, Flórida, EUA. Embora exista uma página de termos de serviço no site que proíba explicitamente o rastreamento de robô não autorizado, isso não bloqueou efetivamente os robôs do OpenAI.

Para impedir efetivamente o rastreamento do robô, o site deve configurar corretamente o arquivo robot.txt. Robot.txt, também conhecido como protocolo de exclusão de bot, foi projetado para informar os mecanismos de pesquisa que conteúdo não deve ser indexado. O OpenAI disse em sua página oficial que respeita os arquivos quando o site é configurado com tags proibidas de rastrear, mas também adverte que seu robô pode levar até 24 horas para reconhecer o arquivo robot.txt atualizado.

Tomchuk enfatizou que, se o site não usar o robot.txt corretamente, o Openai e outras empresas poderão pensar que podem rastejar dados à vontade. Este não é um sistema opcional, mas uma medida necessária para proteger o conteúdo do site. Pior, não apenas os TrileGangers foram forçados a ficar offline pelos robôs do Openai durante o horário de trabalho dos EUA, o Tomchuk também esperava um aumento significativo nas contas da AWS devido à enorme CPU e atividade de download do robô.

No entanto, o robot.txt não é uma solução completa. Se as empresas de IA estão em conformidade com este Contrato depende inteiramente de seu voluntário. No verão passado, outra startup de IA, Perplexity, foi investigada pela Wired por suposta falha em cumprir o protocolo Robot.txt, que atraiu atenção generalizada.

Tomchuk disse que não conseguiu encontrar uma maneira de entrar em contato com o Openai e perguntar sobre isso. O Openai também não respondeu ao pedido de comentário da TechCrunch. Além disso, o OpenAI até agora não forneceu seu compromisso de longo prazo da ferramenta de opção, o que torna o problema ainda mais complicado.

Este é um problema particularmente complicado para os trilegangers. Tomchuk observou que os negócios em que estão envolvidos envolve questões sérias de direitos porque estão digitalizando pessoas reais. Sob GDPR europeu e outras leis, é ilegal usar fotos ao vivo on -line sem permissão.

Ironicamente, o comportamento ganancioso dos robôs OpenAi conscientizou os trileganizadores da vulnerabilidade de seus sites. Tomchuk disse que, se o robô rastejasse os dados de uma maneira mais gentil, ele nunca poderá notar o problema.

"É assustador porque essas empresas parecem estar explorando uma vulnerabilidade aos dados de rastejar e dizem 'se você atualizar seu robot.txt com nossas tags, poderá optar por não participar'", disse Tomchuk. No entanto, isso realmente coloca a culpa aos empresários, pedindo que eles entendam como interromper esses robôs.

Tomchuk espera que outras pequenas empresas on -line percebam que a única maneira de descobrir se os bots de IA estão roubando ativos de direitos autorais no site é buscá -lo ativamente. Ele não é o único a ser perturbado pelos robôs da IA. Os proprietários de outros sites também revelaram ao Business Insider como os bots da OpenAI interrompem o site e aumentam suas taxas da AWS.

Até 2024, esse problema deverá piorar ainda mais. Novas pesquisas da empresa de publicidade digital DoubleVerify descobriram que os rastreadores e os rastreadores de IA resultaram em um aumento de 86% no "tráfego inválido geral" que não vem de usuários reais, mas da atividade dos bots.