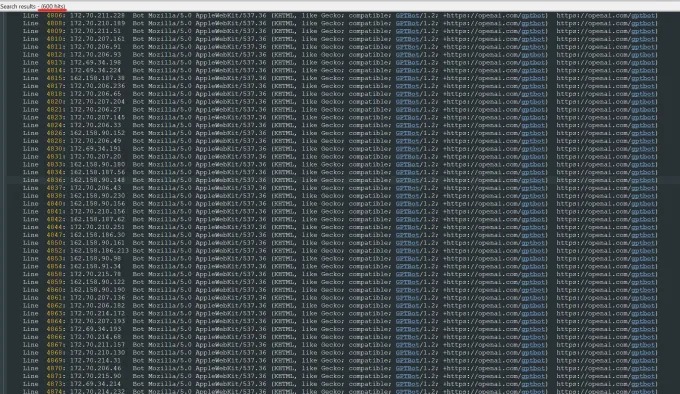

Récemment, Oleksandr Tomchuk, PDG de TrileGangers, a reçu une alerte d'urgence disant que le site Web de commerce électronique de son entreprise était soudainement paralysé. Après une enquête approfondie, il a constaté que la racine du problème réside dans un robot Openai qui rampe sans relâche le contenu de tout son site Web. Le site Web de TrileGangers compte plus de 65 000 produits, chacun avec des pages détaillées et au moins trois images. Le robot d'Openai a envoyé des dizaines de milliers de demandes de serveurs pour essayer de tout télécharger, y compris des centaines de milliers d'images et leurs descriptions.

Tomchuk a souligné que le robot d'Openai a eu un impact sérieux sur le site Web, presque équivalent à une attaque de déni de service distribué (DDOS). Les principales activités de TrileGangers sont de fournir des fichiers et des images d'objets 3D aux artistes 3D, aux développeurs de jeux vidéo et aux autres utilisateurs qui ont besoin de reproduire numériquement de vraies caractéristiques humaines. Ces documents comprennent des données de numérisation détaillées des mains aux cheveux, à la peau et à l'ensemble du corps.

Le site Web de TrileGangers est au cœur de ses activités. L'entreprise a passé plus d'une décennie à construire la plus grande base de données "stand-in pour les corps humains" sur le réseau, tous à partir de scans 3D de vrais corps humains. L'équipe de Tomchuk a son siège social en Ukraine, mais a également été autorisée à Tampa, en Floride, aux États-Unis. Bien qu'il existe une page de service sur le site Web qui interdit explicitement le robot non autorisé rampant, cela n'a pas effectivement bloqué les robots d'Openai.

Afin d'éviter efficacement le robot rampant, le site Web doit configurer correctement le fichier robot.txt. Robot.txt, également connu sous le nom de Protocole d'exclusion BOT, est conçu pour informer les moteurs de recherche quel contenu ne doit pas être indexé. Openai a déclaré sur sa page officielle qu'il respecte les fichiers lorsque le site Web est configuré avec des balises qui sont interdites de ramper, mais avertissent également que son robot peut prendre jusqu'à 24 heures pour reconnaître le fichier robot.txt mis à jour.

Tomchuk a souligné que si le site Web n'utilise pas Robot.txt correctement, OpenAI et d'autres sociétés peuvent penser qu'ils peuvent explorer les données à volonté. Ce n'est pas un système facultatif, mais une mesure nécessaire pour protéger le contenu du site Web. Pire, non seulement TrileGangers était forcé d'être hors ligne par les robots d'Openai pendant les heures de travail américains, mais Tomchuk s'attendait également à une augmentation significative des factures AWS en raison de l'activité CPU et de téléchargement massive du robot.

Cependant, Robot.txt n'est pas une solution complète. La question de savoir si les sociétés d'IA se conforment au présent accord dépendent entièrement de leur volontaire. L'incident a attiré une grande attention l'été dernier lorsqu'une autre startup de l'IA, Perplexity, a fait l'objet d'une enquête par Wired pour non-respect du protocole robot.txt.

Tomchuk a déclaré qu'il ne pouvait pas trouver de moyen de contacter Openai et de lui demander. Openai n'a pas non plus répondu à la demande de commentaires de TechCrunch. De plus, OpenAI n'a jusqu'à présent pas réussi à fournir son engagement à long terme de l'outil d'opt-out, ce qui rend la question encore plus compliquée.

C'est un problème particulièrement délicat pour les trilegangers. Tomchuk a noté que l'entreprise dans laquelle ils sont engagés implique de graves problèmes de droits car ils scrassent de vraies personnes. En vertu du RGPD européen et d'autres lois, il est illégal d'utiliser des photos en direct en ligne sans autorisation.

Ironiquement, le comportement gourmand des robots Openai a fait prendre conscience de TrileGangers de la vulnérabilité de leurs sites Web. Tomchuk a déclaré que si le robot rampait les données d'une manière plus douce, il pourrait ne jamais remarquer le problème.

"C'est effrayant parce que ces entreprises semblent exploiter une vulnérabilité aux données de crawl, et elles disent" si vous mettez à jour votre robot.txt avec nos balises, vous pouvez vous retirer "", a déclaré Tomchuk. Cependant, cela met en fait le blâme sur les propriétaires d'entreprise, leur demandant de comprendre comment arrêter ces robots.

Tomchuk espère que d'autres petites entreprises en ligne se rendront compte que la seule façon de découvrir si les robots de l'IA volent les actifs du droit d'auteur sur le site Web est de le rechercher activement. Il n'est pas le seul à être troublé par les robots d'IA. Les propriétaires d'autres sites Web ont également révélé à Business Insider comment les robots d'Openai perturbent leur site Web et augmentent leurs frais AWS.

D'ici 2024, ce problème devrait aggraver davantage. De nouvelles recherches de la société de publicité numérique, DoubleVerify, a révélé que les robots et les robots de nageoires d'IA ont entraîné une augmentation de 86% du «trafic général invalide» qui ne vient pas d'utilisateurs réels mais de l'activité des robots.