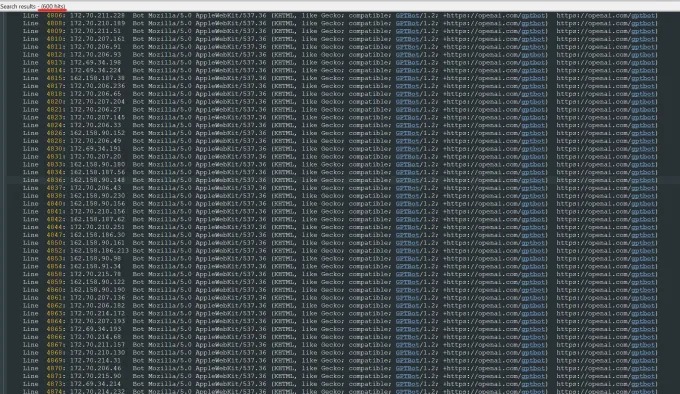

Recientemente, Oleksandr Tomchuk, CEO de Trilegangers, recibió una alerta de emergencia que decía que el sitio web de comercio electrónico de su compañía estaba paralizado repentinamente. Después de una investigación en profundidad, descubrió que la raíz del problema se encuentra en un robot de OpenAI que está arrastrando implacablemente el contenido de todo su sitio web. El sitio web de Trilegangers tiene más de 65,000 productos, cada uno con páginas detalladas y al menos tres imágenes. El robot de Openai envió decenas de miles de solicitudes de servidores para tratar de descargar todo, incluidos cientos de miles de imágenes y sus descripciones.

Tomchuk señaló que el rastreador de OpenAi ha tenido un grave impacto en el sitio web, casi equivalente a un ataque distribuido de denegación de servicio (DDoS). El principal negocio de los trilegangers es proporcionar archivos e imágenes de objetos en 3D a artistas 3D, desarrolladores de videojuegos y otros usuarios que necesitan reproducir digitalmente las características humanas reales. Estos documentos incluyen datos detallados de escaneo de las manos al cabello, la piel y todo el cuerpo.

El sitio web de Trilegangers está en el corazón de su negocio. La compañía ha pasado más de una década construyendo la base de datos más grande de "sustituto digital para los cuerpos humanos" en la red, todo de escaneos 3D de cuerpos humanos reales. El equipo de Tomchuk tiene su sede en Ucrania, pero también tiene licencia en Tampa, Florida, EE. UU. Aunque hay una página de Términos de servicio en el sitio web que prohíbe explícitamente el rastreo de robots no autorizado, esto no ha bloqueado efectivamente los robots de OpenAI.

Para evitar efectivamente el rastreo de robot, el sitio web debe configurar correctamente el archivo robot.txt. Robot.txt, también conocido como protocolo de exclusión BOT, está diseñado para informar a los motores de búsqueda qué contenido no debe indexarse. Operai dijo en su página oficial que respeta los archivos cuando el sitio web está configurado con etiquetas que están prohibidas para el rastreo, pero también advierte que su robot puede tardar hasta 24 horas en reconocer el archivo Robot.txt actualizado.

Tomchuk enfatizó que si el sitio web no usa robot.txt correctamente, OpenAI y otras compañías pueden pensar que pueden arrastrar los datos a voluntad. Este no es un sistema opcional, sino una medida necesaria para proteger el contenido del sitio web. Peor aún, los robots de OpenAi no solo se vieron obligados a estar fuera de línea durante los robots de OpenAi durante las horas de trabajo de los Estados Unidos, Tomchuk también esperaba un aumento significativo en las facturas de AWS debido a la CPU masiva y la actividad de descarga del robot.

Sin embargo, Robot.txt no es una solución completa. Si las empresas de IA cumplen con este acuerdo depende completamente de su voluntario. El incidente atrajo una atención generalizada el verano pasado cuando otra startup de IA, perplejidad, fue investigada por Wired por presunto incumplimiento del protocolo robot.txt.

Tomchuk dijo que no podía encontrar una manera de contactar a Openi y preguntarle al respecto. Operai tampoco respondió a la solicitud de comentarios de TechCrunch. Además, Operai hasta ahora no ha logrado proporcionar su compromiso a largo plazo de la herramienta de exclusión, lo que hace que el problema sea aún más complicado.

Este es un problema particularmente complicado para los trilegangers. Tomchuk señaló que el negocio en el que se dedican implica problemas de derechos graves porque están escaneando para personas reales. Según el GDPR europeo y otras leyes, es ilegal usar fotos en vivo en línea sin permiso.

Irónicamente, el comportamiento codicioso de los robots de Operai ha hecho que los trilegangers sean conscientes de la vulnerabilidad de sus sitios web. Tomchuk dijo que si el robot arrastraba los datos de una manera más gentil, podría nunca notar el problema.

"Da miedo porque estas compañías parecen estar explotando una vulnerabilidad para rastrear los datos, y dicen" si actualiza su robot.txt con nuestras etiquetas, puede optar por no participar ", dijo Tomchuk. Sin embargo, esto realmente culpa a los dueños de negocios, pidiéndoles que entiendan cómo detener estos robots.

Tomchuk espera que otras pequeñas empresas en línea se den cuenta de que la única forma de descubrir si los bots de IA están robando activos de derechos de autor en el sitio web es buscarlo activamente. Él no es el único que se preocupa por los robots de IA. Los propietarios de otros sitios web también revelaron a Business Insider cómo los bots de Openai interrumpen su sitio web y aumentan sus tarifas de AWS.

Para 2024, se espera que este problema empeore aún más. Una nueva investigación realizada por la firma de publicidad digital Doubeverify descubrió que los rastreadores de IA y los rastreadores han dado como resultado un aumento del 86% en el "tráfico inválido general" que no proviene de usuarios reales sino de la actividad de los bots.