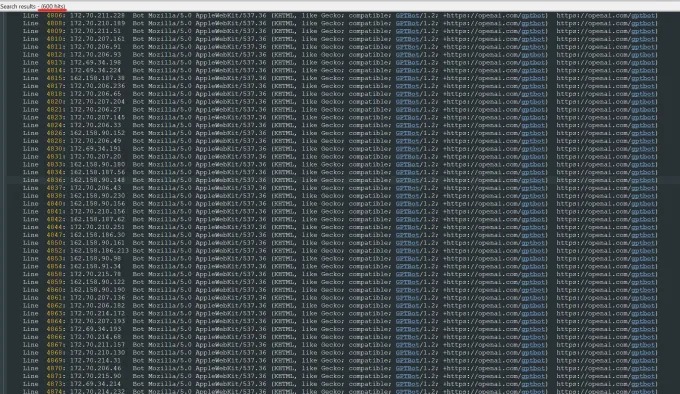

Kürzlich erhielt Oleksandr Tomchuk, CEO von Trilegangers, eine Notfallwarnung, in der die E-Commerce-Website seines Unternehmens plötzlich gelähmt sei. Nach einer eingehenden Untersuchung stellte er fest, dass die Wurzel des Problems in einem Openai-Roboter liegt, der den Inhalt seiner gesamten Website unerbittlich kriecht. Die Trilegangers -Website hat über 65.000 Produkte mit jeweils detaillierten Seiten und mindestens drei Bildern. OpenAIs Roboter hat Zehntausende von Serveranfragen gesendet, um alles herunterzuladen, einschließlich Hunderttausender Bilder und deren Beschreibungen.

Tomchuk wies darauf hin, dass OpenAIs Crawler einen ernsthaften Einfluss auf die Website hatte, fast gleichbedeutend mit einem DDOS -Angriff (Distributed Denial of Service). Das Hauptgeschäft von Trilegangers besteht darin, 3D -Objektdateien und Bilder 3D -Künstlern, Videospielentwicklern und anderen Benutzern bereitzustellen, die echte menschliche Eigenschaften digital reproduzieren müssen. Diese Dokumente enthalten detaillierte Scandaten von den Händen bis zum Haar, die Haut und den ganzen Körper.

Die Trilegangers -Website ist das Herzstück seines Geschäfts. Das Unternehmen hat mehr als ein Jahrzehnt damit verbracht, die größte Datenbank "Human Digital Digital Stand-Alone" im Netzwerk zu bauen, alle aus 3D-Scans realer menschlicher Körper. Das Team von Tomchuk hat seinen Hauptsitz in der Ukraine, wurde aber auch in Tampa, Florida, USA, lizenziert. Obwohl es auf der Website eine Seite der Service -Seite gibt, die ausdrücklich das nicht autorisierte Roboterkrieger verbietet, hat dies die Roboter von OpenAI nicht effektiv blockiert.

Um das Roboter -Kriechen effektiv zu verhindern, muss die Website die Robot.txt -Datei korrekt konfigurieren. Robot.txt, auch als Bot -Ausschlussprotokoll bekannt, soll Suchmaschinen darüber informieren, welche Inhalte nicht indiziert werden sollten. OpenAI sagte auf seiner offiziellen Seite, dass sie die Dateien respektiert, wenn die Website mit Tags konfiguriert ist, die von der Krabbeln verboten sind, aber auch warnt, dass der Roboter möglicherweise bis zu 24 Stunden dauern kann, bis die aktualisierte Robot.txt -Datei erfasst wird.

Tomchuk betonte, dass OpenAI und andere Unternehmen, wenn die Website Robot.txt nicht korrekt verwendet, nach Belieben denken, dass sie Daten nach Belieben kriechen können. Dies ist kein optionales System, sondern ein notwendiges Maß, um den Inhalt der Website zu schützen. Schlimmer noch, Trileganger wurden nicht nur während der Arbeitszeit von OpenAIs Robotern von OpenAIs gezwungen, Tomchuk erwartete auch einen signifikanten Anstieg der AWS -Rechnungen aufgrund der massiven CPU- und Download -Aktivität des Roboters.

Robot.txt ist jedoch keine vollständige Lösung. Ob KI -Unternehmen diese Vereinbarung einhalten, hängt vollständig von ihrem freiwilligen Abhängigkeit ab. Im vergangenen Sommer wurde ein weiteres KI -Startup, Verwirrung, durch Kabel untersucht

Tomchuk sagte, er könne keinen Weg finden, Openai zu kontaktieren und danach zu fragen. OpenAI antwortete auch nicht auf die Anfrage von TechCrunch um einen Kommentar. Darüber hinaus hat OpenAI bisher nicht das langfristige Engagement für das Opt-out-Tool vorgesehen, was das Problem noch komplizierter macht.

Dies ist ein besonders kniffliges Problem für Trilankanger. Tomchuk stellte fest, dass das Geschäft, an dem sie beteiligt sind, ernsthafte Rechteprobleme beinhaltet, weil sie nach echten Menschen scannen. Nach der europäischen DSGVO und anderen Gesetzen ist es illegal, ohne Erlaubnis Live -Fotos online zu verwenden.

Ironischerweise hat das gierige Verhalten von OpenAI -Robotern Trileganger auf die Sicherheitsanfälligkeit ihrer Websites aufmerksam gemacht. Tomchuk sagte, wenn der Roboter auf sanftere Weise Daten krabbelte, wird er das Problem möglicherweise nie bemerken.

"Es ist beängstigend, weil diese Unternehmen scheinbar eine Anfälligkeit für Kriechen von Daten ausnutzen, und sie sagen:" Wenn Sie Ihren Robot.txt mit unseren Tags aktualisieren, können Sie sich abmelden ", sagte Tomchuk. Dies gibt den Geschäftsinhabern jedoch tatsächlich die Schuld und fordert sie auf, zu verstehen, wie diese Roboter aufgehalten werden können.

Tomchuk hofft, dass andere kleine Online -Unternehmen erkennen werden, dass der einzige Weg, um herauszufinden, ob KI -Bots das Urheberrecht auf der Website stehlen, darin besteht, sie aktiv zu suchen. Er ist nicht der einzige, der von KI -Robotern beunruhigt wird. Eigentümer anderer Websites gaben auch den Business Insider heraus, wie die Bots von OpenAI ihre Website stören und ihre AWS -Gebühren erhöhen.

Bis 2024 wird erwartet, dass dieses Problem weiter verschlechtert. Neue Forschungsergebnisse des digitalen Werbeunternehmens Doubverify ergaben, dass KI -Crawler und Crawler zu einer Erhöhung des „allgemeinen ungültigen Verkehrs“ um 86% geführt haben, der nicht von echten Benutzern stammt, sondern von der Aktivität von Bots.