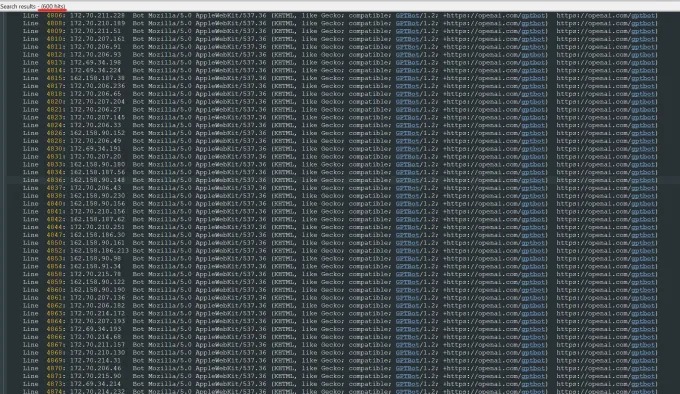

Недавно Олександр Томчук, генеральный директор Trilegangers, получил неотложное оповещение, заявив, что веб-сайт электронной коммерции его компании был внезапно парализован. После глубокого расследования он обнаружил, что корень проблемы лежит в роботе Openai, который неуклонно ползает по содержанию всего его веб-сайта. Веб -сайт Trilegangers содержит более 65 000 продуктов, каждый из которых имеет подробные страницы и не менее трех изображений. Робот Openai отправил десятки тысяч запросов на сервера, чтобы попытаться загрузить все, включая сотни тысяч изображений и их описания.

Томчук отметил, что Crawler Openai оказал серьезное влияние на веб -сайт, почти эквивалентный атаке распределенного отказа в обслуживании (DDOS). Основным бизнесом Trilegangers является предоставление трехмерных объектных файлов и изображений 3D -артистам, разработчикам видеоигр и другим пользователям, которым необходимо цифровое воспроизведение реальных человеческих характеристик. Эти документы включают подробные данные сканирования от рук до волос, кожу и все тело.

Веб -сайт Trilegangers лежит в основе его бизнеса. Компания потратила более десяти лет, создавая самую большую базу данных «цифрового замены для человеческих тел» в сети, все из 3D-сканирования настоящих человеческих тел. Команда Томчука со штаб -квартирой в Украине, но также была лицензирована в Тампе, штат Флорида, США. Несмотря на то, что на веб -сайте существуют страницу условий обслуживания, которые явно запрещают несанкционированному ползанию роботов, это не заблокировало роботов Openai.

Чтобы эффективно предотвратить ползание роботов, веб -сайт должен правильно настроить файл robot.txt. Robot.txt, также известный как протокол исключения бота, предназначен для информирования поисковых систем, какой контент не следует индексировать. OpenAI заявила на своей официальной странице, что он уважает файлы, когда веб -сайт настроен с тегами, которые запрещены от ползания, но также предупреждает, что его робот может занять до 24 часов, чтобы распознать обновленный файл robot.txt.

Томчук подчеркнул, что если веб -сайт не использует Robot.txt правильно, OpenAI и другие компании могут подумать, что они могут ползти данных по желанию. Это не дополнительная система, а необходимая мера для защиты содержания веб -сайта. Хуже того, трилегангеры были вынуждены быть офлайн роботами Openai в рабочее время США, но и ожидали значительного увеличения счетов AWS из -за массового процессора робота и загрузки.

Тем не менее, robot.txt не является полным решением. Соблюдение этого соглашения полностью зависит от их добровольных компаний. Инцидент привлек широкое внимание прошлым летом, когда Wired был расследован еще один стартап искусственного интеллекта, смущенности, за то, что он предполагал, что не выполнит протокол Robot.txt.

Томчук сказал, что не может найти способ связаться с Openai и спросить об этом. Openai также не ответил на запрос TechCrunch о комментариях. Кроме того, OpenAI до сих пор не смог предоставить свою долгосрочную приверженность инструменту отказа, что делает проблему еще более сложной.

Это особенно сложная проблема для трилегангеров. Томчук отметил, что бизнес, в котором они занимаются серьезными проблемами прав, потому что они сканируют на реальных людей. В соответствии с европейским GDPR и другими законами незаконно использовать живые фотографии в Интернете без разрешения.

По иронии судьбы, жадное поведение роботов Openai дало трилегангерам осознавать уязвимость своих веб -сайтов. Томчук сказал, что если робот ползет данные более нежным образом, он никогда не заметит проблему.

«Это страшно, потому что эти компании, похоже, используют уязвимость для данных для сканирования, и они говорят:« Если вы обновляете свой robot.txt с нашими тегами, вы можете отказаться », - сказал Томчук. Тем не менее, это фактически возлагает вину на владельцев бизнеса, прося их понять, как остановить этих роботов.

Томчук надеется, что другие небольшие онлайн -бизнеса поймут, что единственный способ выяснить, будут ли AI -боты красть активы об авторском праве на веб -сайте, - это активно искать его. Он не единственный, кто беспокоит роботы ИИ. Владельцы других веб -сайтов также рассказали Business Insider, как боты Openai разрушают их веб -сайт и увеличивают свои платы за AWS.

К 2024 году эта проблема ожидается дальше. Новое исследование фирмы цифровой рекламы DoubleVerify показало, что Clawlers и Clawlers AI привели к увеличению «общего недопустимого трафика» на 86%, которое происходит не от реальных пользователей, а от деятельности ботов.