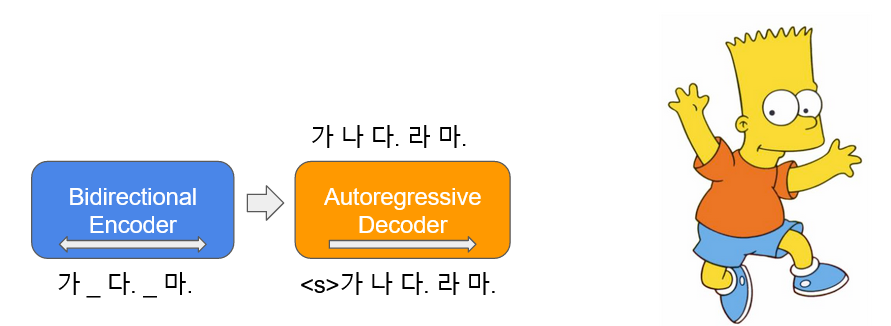

BART ( B idirectional และ uto- r reanassive t ransformers) ได้เรียนรู้ในรูปแบบของ autoencoder ซึ่งเพิ่มเสียงรบกวนให้กับข้อความอินพุตบางส่วนและเรียกคืนเป็นข้อความต้นฉบับ เกาหลีบาร์ต ( Kobart ) เป็นรูปแบบภาษา encoder-decoder เกาหลีที่ได้เรียนรู้เกี่ยวกับข้อความเกาหลี 40GB หรือมากกว่าโดยใช้ฟังก์ Text Infilling ที่ใช้ในกระดาษ สิ่งนี้จะแจกจ่าย KoBART-base ที่ได้รับ

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| ข้อมูล | # ของประโยค |

|---|---|

| วิกิเกาหลี | 5m |

| คลังอื่น ๆ | 0.27b |

นอกเหนือจากวิกิพีเดียเกาหลีข้อมูลต่าง ๆ เช่นข่าวหนังสือและม้าทั้งหมดของ v1.0 (การสนทนา, ข่าว, ... ) ถูกนำมาใช้สำหรับการเรียนรู้แบบจำลอง

เรียนรู้ด้วย Character BPE tokenizer ในแพ็คเกจ tokenizers

ขนาด vocab คือ 30,000 และเพิ่มอิโมติคอนและอิโมจิซึ่งมักใช้สำหรับการสนทนาและความสามารถในการรับรู้ของโทเค็นจะเพิ่มขึ้น

?,

:),?,(-:-):-)

นอกจากนี้เราได้กำหนดโทเค็นที่ไม่ได้ใช้เช่น <unused0> ถึง <unused99> เพื่อให้พวกเขาสามารถกำหนดได้อย่างอิสระตาม subtasks ที่จำเป็น

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| แบบอย่าง | # ของ params | พิมพ์ | # ของเลเยอร์ | # ของหัว | ffn_dim | hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124m | เครื่องเข้ารหัส | 6 | 16 | 3072 | 768 |

| ตัวถอดรหัส | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | Korsts (Spearman) | คู่คำถาม (ACC) | |

|---|---|---|---|

| - | |||

| Kobart-base | 90.24 | 81.66 | 94.34 |

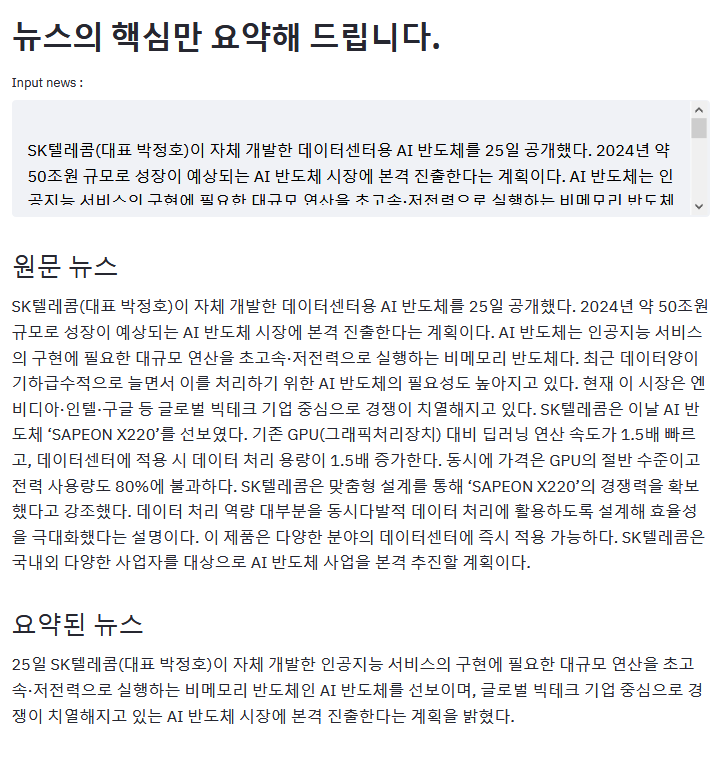

ตัวอย่างข้างต้นเป็นผลลัพธ์ของการสรุปบทความ ZDNET

หากคุณมีตัวอย่างที่น่าสนใจโดยใช้ Kobart โปรดประชาสัมพันธ์!

aws s3<unk> หายไปเนื่องจากข้อผิดพลาดที่ดีกว่าKoBART (ตัวอย่างประสิทธิภาพดีขึ้น)모두의 말뭉치pip โปรดอัปโหลดปัญหาที่เกี่ยวข้องกับ KoBART ที่นี่

KoBART เปิดตัวภายใต้ใบอนุญาต modified MIT หากคุณใช้โมเดลและรหัสโปรดติดตามเนื้อหาใบอนุญาต ผู้เชี่ยวชาญด้านใบอนุญาตสามารถพบได้ในไฟล์ LICENSE