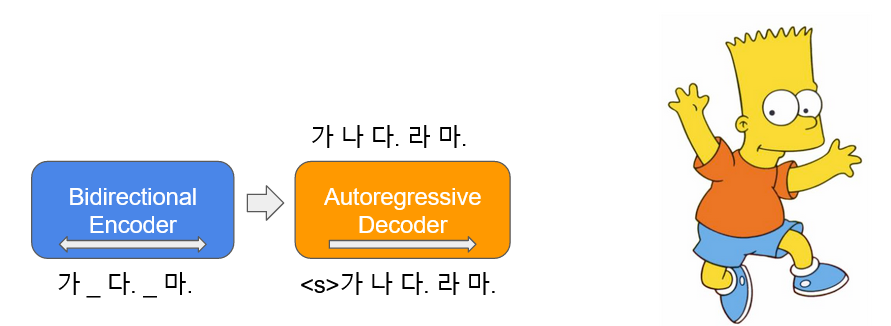

Bart ( B -Idectional и Uto - r Egrerassive T Ransformers) изучается в виде autoencoder , который добавляет шум к некоторому входному тексту и восстанавливает его в качестве исходного текста. Корейский Барт ( Kobart )-это корейская языковая модель encoder-decoder , которая была изучена о корейском тексте 40 ГБ или более, используя функцию, Text Infilling шум, используемая в статье. Это распространяет полученную KoBART-base .

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| Данные | # предложений |

|---|---|

| Корейская вики | 5 м |

| Другой корпус | 0,27b |

В дополнение к корейской Википедии, различные данные, такие как новости, книги и все лошади V1.0 (разговор, новости, ...), использовались для обучения моделям.

Учился с Character BPE tokenizer в пакете tokenizers .

Размер vocab составляет 30 000, и добавлены смайлики и смайлики, которые часто используются для разговоров, и повышается способность распознавания токена.

?,

:),?,(-:-):-)

Кроме того, мы определили неиспользованные токены, такие как <unused0> , до <unused99> , чтобы они могли быть свободно определены в соответствии с необходимыми subtasks .

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Модель | # параметров | Тип | # слоев | # голов | ffn_dim | hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124 м | Энкодер | 6 | 16 | 3072 | 768 |

| Декодер | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | Корсты (Спирмен) | Пара вопросов (ACC) | |

|---|---|---|---|

| ----------------------------------------- | |||

| Kobart-Base | 90.24 | 81.66 | 94,34 |

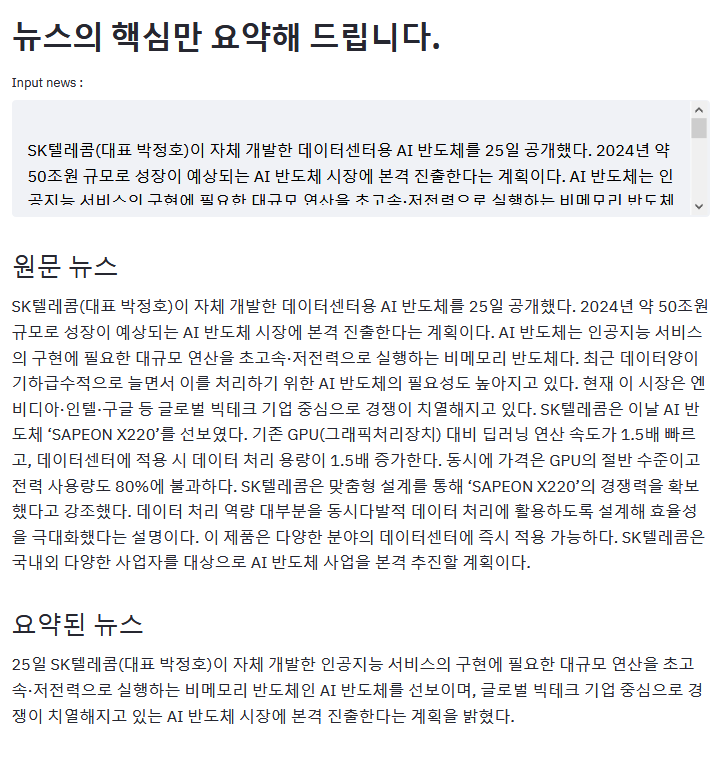

Приведенный выше пример является результатом суммирования статьи ZDNet.

Если у вас есть интересный пример, используя Kobart, пожалуйста, PR!

aws s3<unk> токен исчезает из -за более хорошей ошибкиKoBART (эффективность образца улучшается)모두의 말뭉치pip Пожалуйста, загрузите здесь проблемы KoBART .

KoBART выпускается по modified MIT . Если вы используете модели и код, пожалуйста, следуйте контенту лицензии. Специалисты по лицензии можно найти в файле LICENSE .