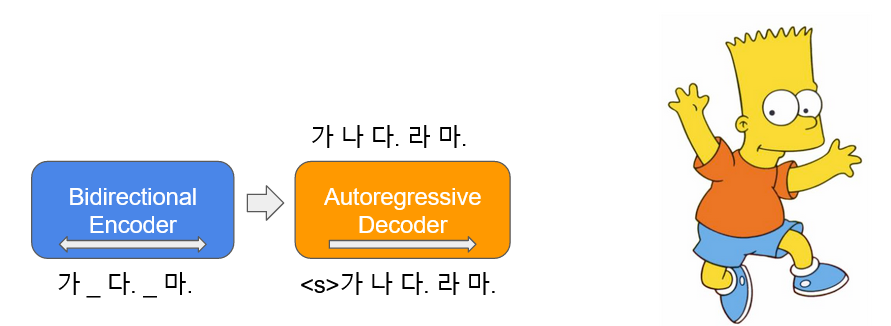

Bart ( B ransformers dan uton -r egrerasif ) dipelajari dalam bentuk autoencoder , yang menambahkan noise ke beberapa teks input dan mengembalikannya sebagai teks asli. Bart Korea ( Kobart ) adalah model bahasa encoder-decoder Korea yang telah dipelajari tentang teks Korea 40GB atau lebih menggunakan fungsi Text Infilling yang digunakan dalam makalah. Ini mendistribusikan KoBART-base yang diturunkan.

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| Data | # kalimat |

|---|---|

| Wiki Korea | 5m |

| Corpus lainnya | 0.27b |

Selain wikipedia Korea, berbagai data seperti berita, buku, dan semua kuda V1.0 (percakapan, berita, ...) digunakan untuk pembelajaran model.

Belajar dengan Character BPE tokenizer dalam paket tokenizers .

Ukuran vocab adalah 30.000 dan ditambahkan emotikon dan emoji, yang sering digunakan untuk percakapan, dan kemampuan pengakuan token dinaikkan.

?,

:),?,(-:-):-)

Selain itu, kami telah mendefinisikan token yang tidak digunakan seperti <unused0> ke <unused99> sehingga mereka dapat didefinisikan secara bebas sesuai dengan subtasks yang diperlukan.

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Model | # Params | Jenis | # lapisan | # kepala | ffn_dim | Hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124m | Encoder | 6 | 16 | 3072 | 768 |

| Decoder | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | Korsts (Spearman) | Tanya pasangan (ACC) | |

|---|---|---|---|

| ----------------------------------------- | |||

| Kobart-base | 90.24 | 81.66 | 94.34 |

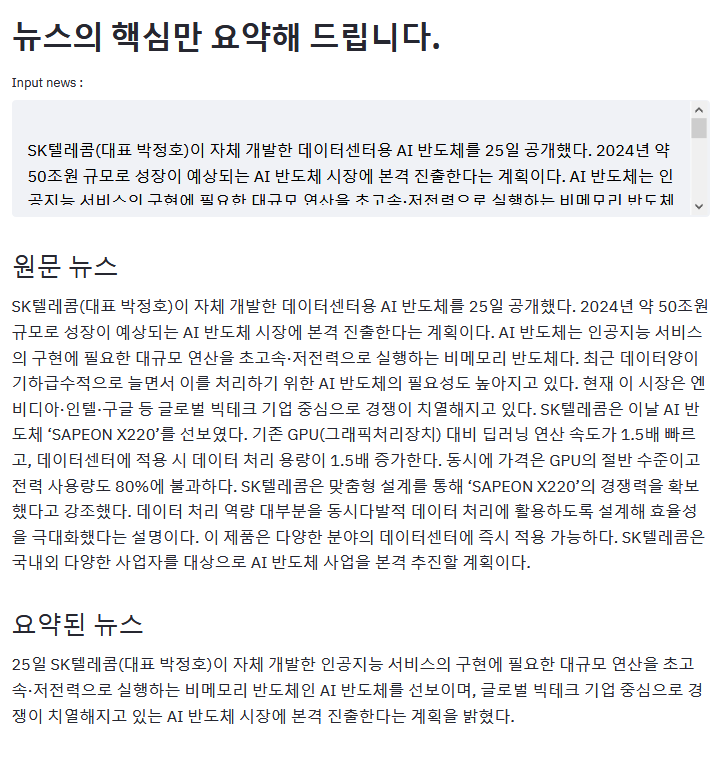

Contoh di atas adalah hasil meringkas artikel ZDNET.

Jika Anda memiliki contoh yang menarik menggunakan Kobart, silakan PR!

aws s3<unk> menghilang karena pembicaraan yang lebih bagusKoBART (Sampel Efektif Meningkatkan)모두의 말뭉치pip Harap unggah masalah terkait KoBART di sini.

KoBART dirilis di bawah lisensi modified MIT . Jika Anda menggunakan model dan kode, silakan ikuti konten lisensi. Spesialis lisensi dapat ditemukan di file LICENSE .