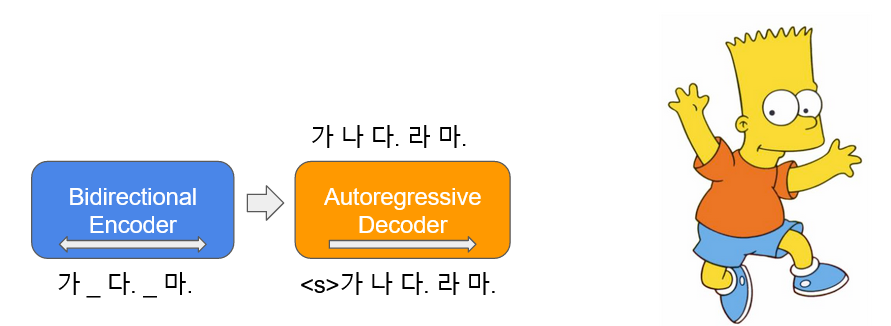

BART ( b idirectionnel et un uto- r egrerassive t ransformateurs) est appris sous forme d' autoencoder , ce qui ajoute du bruit à une partie du texte d'entrée et le restaure comme un texte d'origine. Le Bart coréen ( Kobart ) est un modèle de langue encoder-decoder coréen qui a été appris sur le texte coréen de 40 Go ou plus en utilisant Text Infilling utilisé dans l'article. Cela distribue la KoBART-base dérivée.

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| Données | # de phrases |

|---|---|

| Wiki coréen | 5m |

| Autre corpus | 0,27b |

En plus du wikipedia coréen, diverses données telles que des nouvelles, des livres et tous les chevaux de V1.0 (conversation, nouvelles, ...) ont été utilisés pour l'apprentissage des modèles.

Appris avec Character BPE tokenizer dans le package tokenizers .

vocab est de 30 000 et des émoticônes et des emoji ajoutés, qui sont souvent utilisés pour les conversations, et la capacité de reconnaissance du jeton est augmentée.

?,

:),? ,(-:-):-)

De plus, nous avons défini des jetons inutilisés tels que <unused0> à <unused99> afin qu'ils puissent être définis librement en fonction des subtasks nécessaires.

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Modèle | # de paramètres | Taper | # de couches | # de têtes | ffn_dim | Hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124m | Encodeur | 6 | 16 | 3072 | 768 |

| Décodeur | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | Korsts (Spearman) | Paire de questions (ACC) | |

|---|---|---|---|

| ----------------------------------------- | |||

| Base de Kobart | 90.24 | 81,66 | 94.34 |

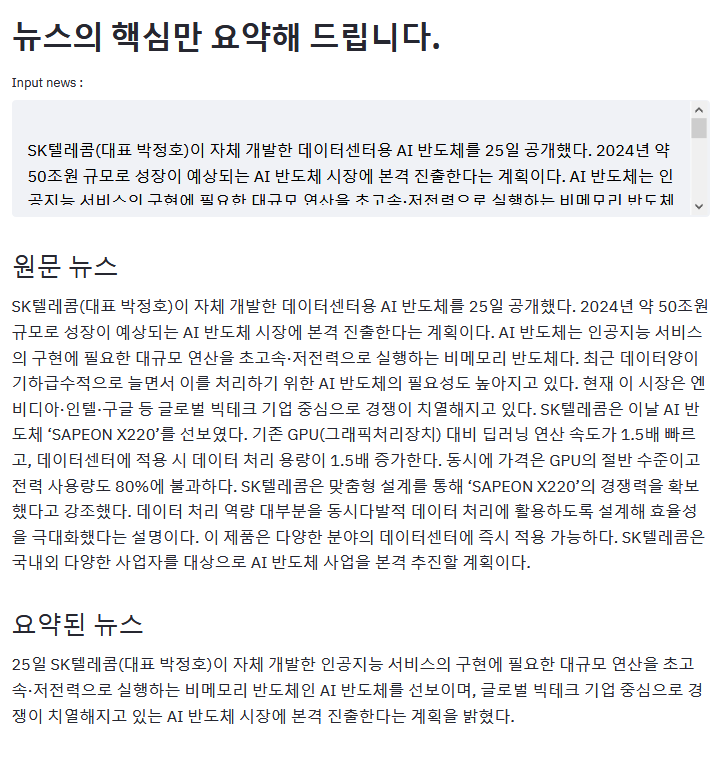

L'exemple ci-dessus est le résultat de la résumé de l'article ZDNET.

Si vous avez un exemple intéressant en utilisant Kobart, veuillez pr!

aws s3<unk> en raison du bug plus agréableKoBART (l'échantillon efficace efficace)모두의 말뭉치pip Veuillez télécharger les problèmes liés KoBART ici.

KoBART est libéré sous la licence modified MIT . Si vous utilisez des modèles et du code, veuillez suivre le contenu de la licence. Les spécialistes de la licence peuvent être trouvés dans LICENSE .