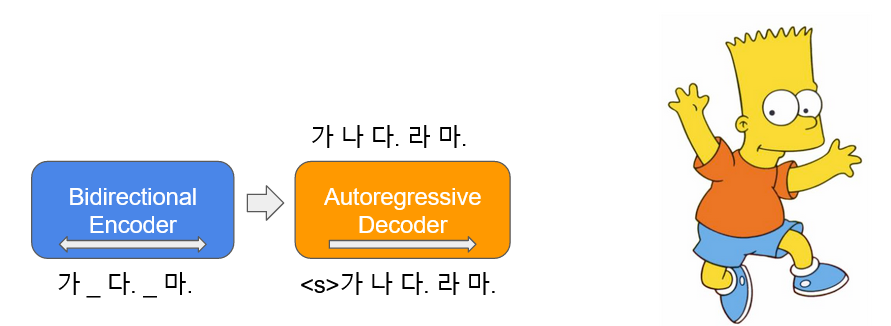

يتم تعلم BART ( B idirectional و ug - r egrerassive t- ransformers) في شكل autoencoder ، مما يضيف ضوضاء إلى بعض نص الإدخال ويعيده كنص أصلي. الكوري بارت ( Kobart ) هو نموذج لغة encoder-decoder كوري تم تعلمه حول النص الكوري البالغ 40 جيجابايت أو أكثر باستخدام وظيفة ضوضاء Text Infilling المستخدمة في الورقة. هذا يوزع KoBART-base المشتقة.

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| بيانات | # من الجمل |

|---|---|

| ويكي الكورية | 5M |

| مجموعة أخرى | 0.27B |

بالإضافة إلى ويكيبيديا الكورية ، تم استخدام بيانات مختلفة مثل الأخبار والكتب وجميع خيول V1.0 (المحادثة ، الأخبار ، ...) للتعلم النموذجي.

تعلمت مع Character BPE tokenizer في حزمة tokenizers .

حجم vocab هو 30،000 ويتم إضافة الرموز والرموز التعبيرية ، والتي تستخدم غالبًا للمحادثات ، ويتم رفع قدرة التعرف على الرمز المميز.

؟ ،

:)،؟ ،(-:-):-)

بالإضافة إلى ذلك ، قمنا بتعريف الرموز غير المستخدمة مثل <unused0> إلى <unused99> بحيث يمكن تعريفها بحرية وفقًا subtasks اللازمة.

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| نموذج | # من المعلمات | يكتب | # من الطبقات | # من الرؤوس | FFN_DIM | hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124m | تشفير | 6 | 16 | 3072 | 768 |

| فك التشفير | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | كورستس (سبيرمان) | زوج أسئلة (ACC) | |

|---|---|---|---|

| ------------------------------------- | |||

| Kobart-base | 90.24 | 81.66 | 94.34 |

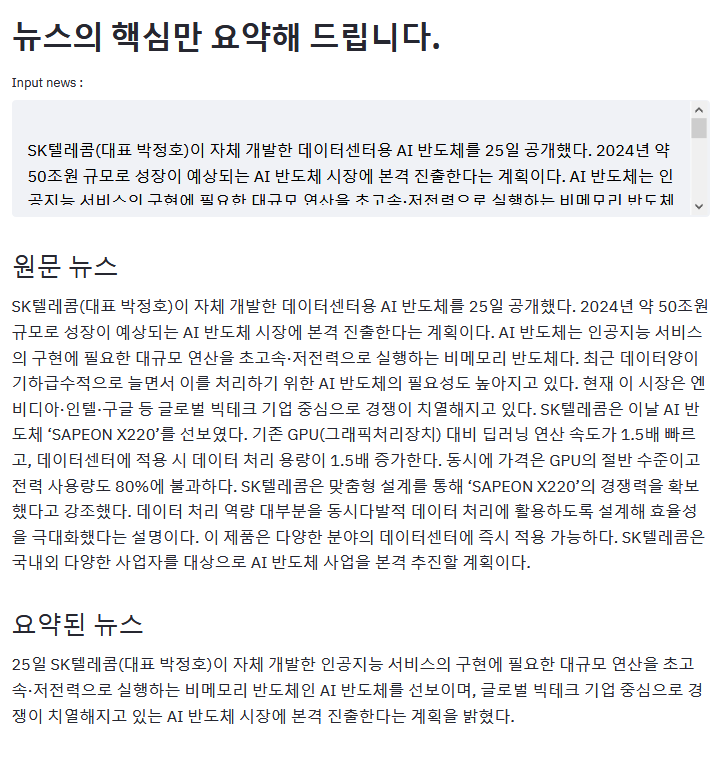

المثال أعلاه هو نتيجة لتلخيص مقالة ZDNET.

إذا كان لديك مثال مثير للاهتمام باستخدام Kobart ، يرجى PR!

aws s3<unk> تختفي بسبب الحديث عن علةKoBART (يتحسن عينة فعالية)모두의 말뭉치pip دعم تثبيت يرجى تحميل القضايا المرتبطة بـ KoBART هنا.

يتم إصدار KoBART تحت رخصة modified MIT . إذا كنت تستخدم النماذج والرمز ، فيرجى اتباع محتوى الترخيص. يمكن العثور على أخصائيي الترخيص في ملف LICENSE .