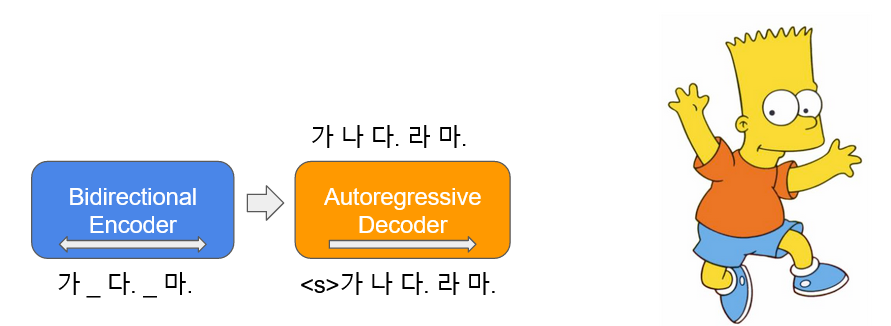

BART ( B idirectional und A Uto- r egrerassive T- Ransformer) wird in Form von autoencoder gelernt, was zu einigen der Eingabetext Rauschen hinzufügt und ihn als Originaltext wiederherstellt. Koreaner Bart ( Kbart ) ist ein koreanisches encoder-decoder Sprachmodell, das über den koreanischen Text von 40 GB oder mehr gelernt wurde, indem Text Infilling . Dies verteilt die abgeleitete KoBART-base .

pip install git+https://github.com/SKT-AI/KoBART#egg=kobart| Daten | Anzahl der Sätze |

|---|---|

| Koreanisch -Wiki | 5m |

| Anderer Korpus | 0,27b |

Neben koreanischer Wikipedia wurden verschiedene Daten wie Nachrichten, Bücher und alle Pferde von V1.0 (Gespräch, Nachrichten, ...) zum Modelllernen verwendet.

Mit Character BPE tokenizer im tokenizers -Paket gelernt.

vocab Vokabellengröße beträgt 30.000 und ergänzt Emoticons und Emoji, die häufig für Gespräche verwendet werden, und die Erkennungsfähigkeit des Tokens wird angehoben.

?,

:),?,(-:-):-)

Darüber hinaus haben wir ungenutzte Token wie <unused0> bis <unused99> definiert, damit sie entsprechend den erforderlichen subtasks frei definiert werden können.

> >> from kobart import get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> kobart_tokenizer . tokenize ( "안녕하세요. 한국어 BART 입니다.?:)l^o" )

[ '▁안녕하' , '세요.' , '▁한국어' , '▁B' , 'A' , 'R' , 'T' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Modell | Anzahl der Parameter | Typ | Anzahl der Schichten | Anzahl der Köpfe | ffn_dim | Hidden_dims |

|---|---|---|---|---|---|---|

KoBART-base | 124 m | Encoder | 6 | 16 | 3072 | 768 |

| Decoder | 6 | 16 | 3072 | 768 |

> >> from transformers import BartModel

> >> from kobart import get_pytorch_kobart_model , get_kobart_tokenizer

> >> kobart_tokenizer = get_kobart_tokenizer ()

> >> model = BartModel . from_pretrained ( get_pytorch_kobart_model ())

> >> inputs = kobart_tokenizer ([ '안녕하세요.' ], return_tensors = 'pt' )

> >> model ( inputs [ 'input_ids' ])

Seq2SeqModelOutput ( last_hidden_state = tensor ([[[ - 0.4418 , - 4.3673 , 3.2404 , ..., 5.8832 , 4.0629 , 3.5540 ],

[ - 0.1316 , - 4.6446 , 2.5955 , ..., 6.0093 , 2.7467 , 3.0007 ]]],

grad_fn = < NativeLayerNormBackward > ), past_key_values = (( tensor ([[[[ - 9.7980e-02 , - 6.6584e-01 , - 1.8089e+00 , ..., 9.6023e-01 , - 1.8818e-01 , - 1.3252e+00 ],| NSMC (ACC) | Korst (Spearman) | Fragepaar (ACC) | |

|---|---|---|---|

| ----------------------------------------- | |||

| Kbart-Base | 90.24 | 81.66 | 94.34 |

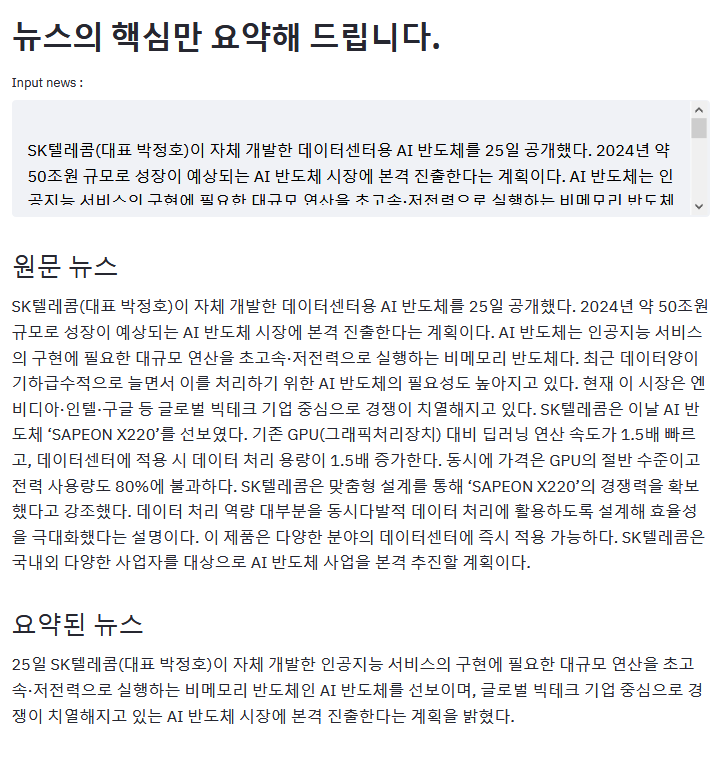

Das obige Beispiel ist das Ergebnis der Zusammenfassung des ZDNET -Artikels.

Wenn Sie ein interessantes Beispiel mit Kbart haben, bitte PR!

aws s3 herunter<unk> Token, der aufgrund des sprechenden Fehlers verschwindetKoBART -Modell -Update (Beispieleffizienz verbessert)모두의 말뭉치pip -Installationsunterstützung Bitte laden Sie hier KoBART -bezogene Probleme hoch.

KoBART wird unter modified MIT -Lizenz veröffentlicht. Wenn Sie Modelle und Code verwenden, befolgen Sie bitte den Lizenzinhalt. Lizenzspezialisten finden Sie in LICENSE .