For those enquiring about how to extract visual and audio features, please check this out: https://github.com/soujanyaporia/MUStARD

| วันที่ | การประกาศ |

|---|---|

| 10/03/2024 | หากคุณสนใจในการทดสอบ IQ LLM ให้ตรวจสอบงานใหม่ของเรา: Algopuzzlevqa |

| 03/08/2021 | - - เราได้เปิดตัวชุดข้อมูลใหม่ M2H2: ชุดข้อมูลภาษาฮินดีหลายรูปแบบหลายรูปแบบสำหรับการจดจำอารมณ์ขันในการสนทนา ลองดู: M2H2 baselines สำหรับชุดข้อมูล M2H2 ถูกสร้างขึ้นตาม Dialoguernn และ BCLSTM |

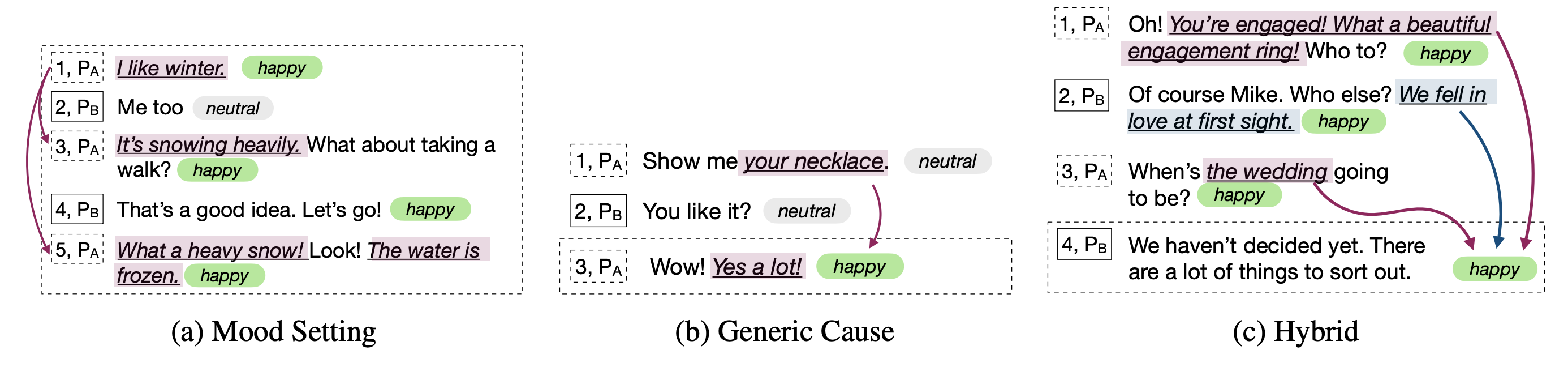

| 18/05/2021 | - - เราได้เปิดตัว repo ใหม่ที่มีโมเดลเพื่อแก้ปัญหาของอารมณ์ทำให้เกิดการจดจำในการสนทนา ลองดูสิ: การสกัดทางอารมณ์ ขอบคุณ Pengfei Hong สำหรับการรวบรวมสิ่งนี้ |

| 24/12/2020 | - - สนใจในหัวข้อของการรับรู้สาเหตุทางอารมณ์ในการสนทนาหรือไม่? เราเพิ่งเปิดตัวชุดข้อมูลสำหรับเรื่องนี้ ตรงไปที่ https://github.com/declare-lab/reccon |

| 06/10/2020 | - - กระดาษใหม่และ SOTA ในการจดจำอารมณ์ในการสนทนา อ้างถึง Directory Cosmic สำหรับรหัส อ่านบทความ - Cosmic: ความรู้ทั่วไปสำหรับการระบุอารมณ์ในการสนทนา |

| 30/09/2020 | บทความใหม่และพื้นฐานในการเจรจาการสนทนาระดับคำพูดได้รับการเผยแพร่แล้ว อ่านความเข้าใจในการสนทนาระดับคำพูดของเรา: การศึกษาเชิงประจักษ์ แยกรหัส |

| 26/07/2020 | รหัส DialogueGCN ใหม่ได้รับการเผยแพร่แล้ว กรุณาเยี่ยมชม https://github.com/declare-lab/conv-emotion/tree/master/dialoguegcn-mianzhang เครดิตทั้งหมดไปที่ Mian Zhang (https://github.com/mianzhang/) |

| 11/07/2020 | สนใจอ่านเอกสารเกี่ยวกับ ERC หรืองานที่เกี่ยวข้องเช่นการตรวจจับการเสียดสีในการสนทนา? เราได้รวบรวมรายการการอ่านที่ครอบคลุมสำหรับเอกสาร กรุณาเยี่ยมชม https://github.com/declare-lab/awesome-emotion-recognition-in-conversations |

| 07/06/2020: | ผลลัพธ์ที่ทันสมัยใหม่สำหรับงาน ERC จะได้รับการปล่อยตัวในไม่ช้า |

| 07/06/2020: | repo conv-emotion จะได้รับการดูแลใน https://github.com/declare-lab/ |

| 22/12/2019: | รหัสสำหรับ DialogueGCN ได้รับการเผยแพร่แล้ว |

| 11/10/2019: | บทความใหม่: การเรียนรู้การถ่ายโอนการสนทนาเพื่อการจดจำอารมณ์ |

| 09/08/2019: | บทความใหม่เกี่ยวกับการจดจำอารมณ์ในการสนทนา (ERC) |

| 06/03/2019: | คุณสมบัติและรหัสในการฝึกอบรม Dialoguernn บนชุดข้อมูล MELD ได้รับการเผยแพร่แล้ว |

| 20/11/2018: | ไอคอนและ Dialoguernn เวอร์ชันแบบ end-to-end ได้รับการเผยแพร่แล้ว |

Cosmic เป็นรูปแบบที่มีประสิทธิภาพดีที่สุดใน repo นี้และโปรดเยี่ยมชมลิงค์ด้านล่างเพื่อเปรียบเทียบโมเดลในชุดข้อมูล ERC ที่แตกต่างกัน

พื้นที่เก็บข้อมูลนี้มีการใช้งานสำหรับการจดจำอารมณ์หลายอย่างในวิธีการสนทนารวมถึงอัลกอริทึมสำหรับการรับรู้สาเหตุทางอารมณ์ในการสนทนา:

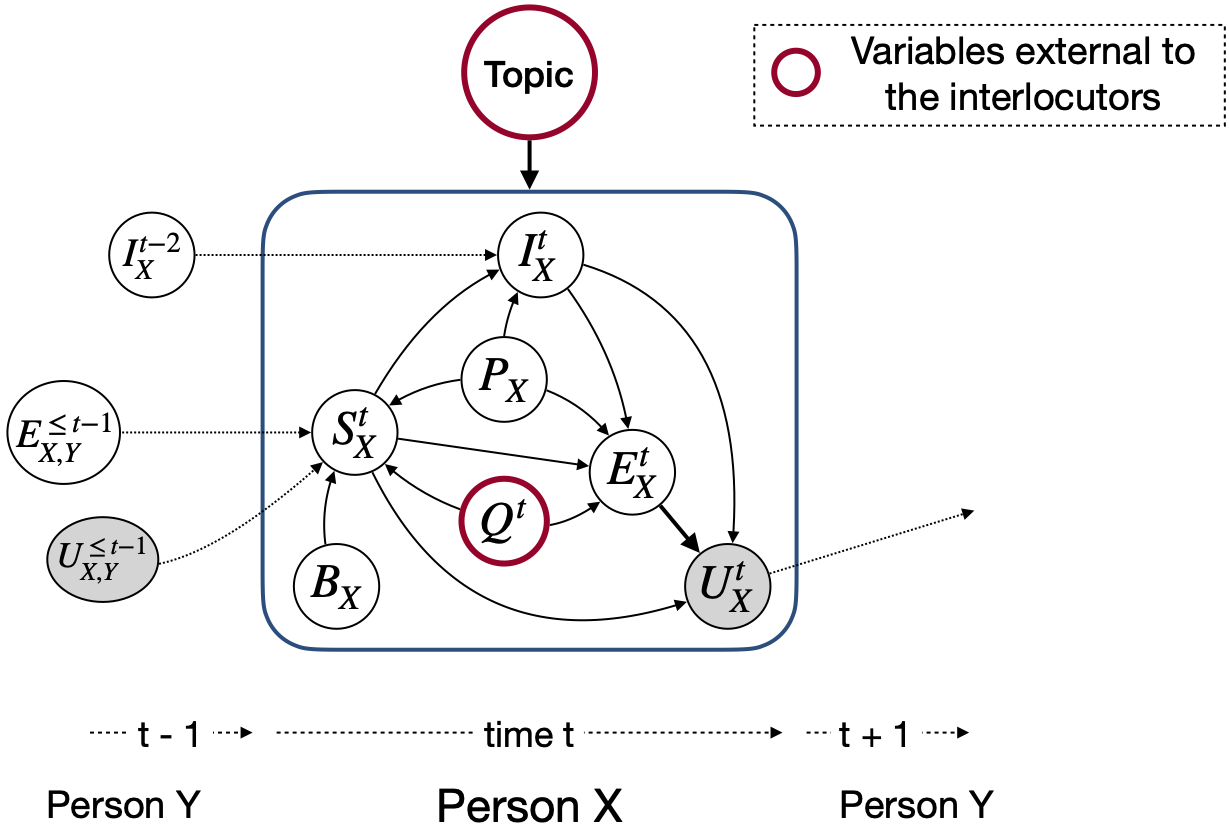

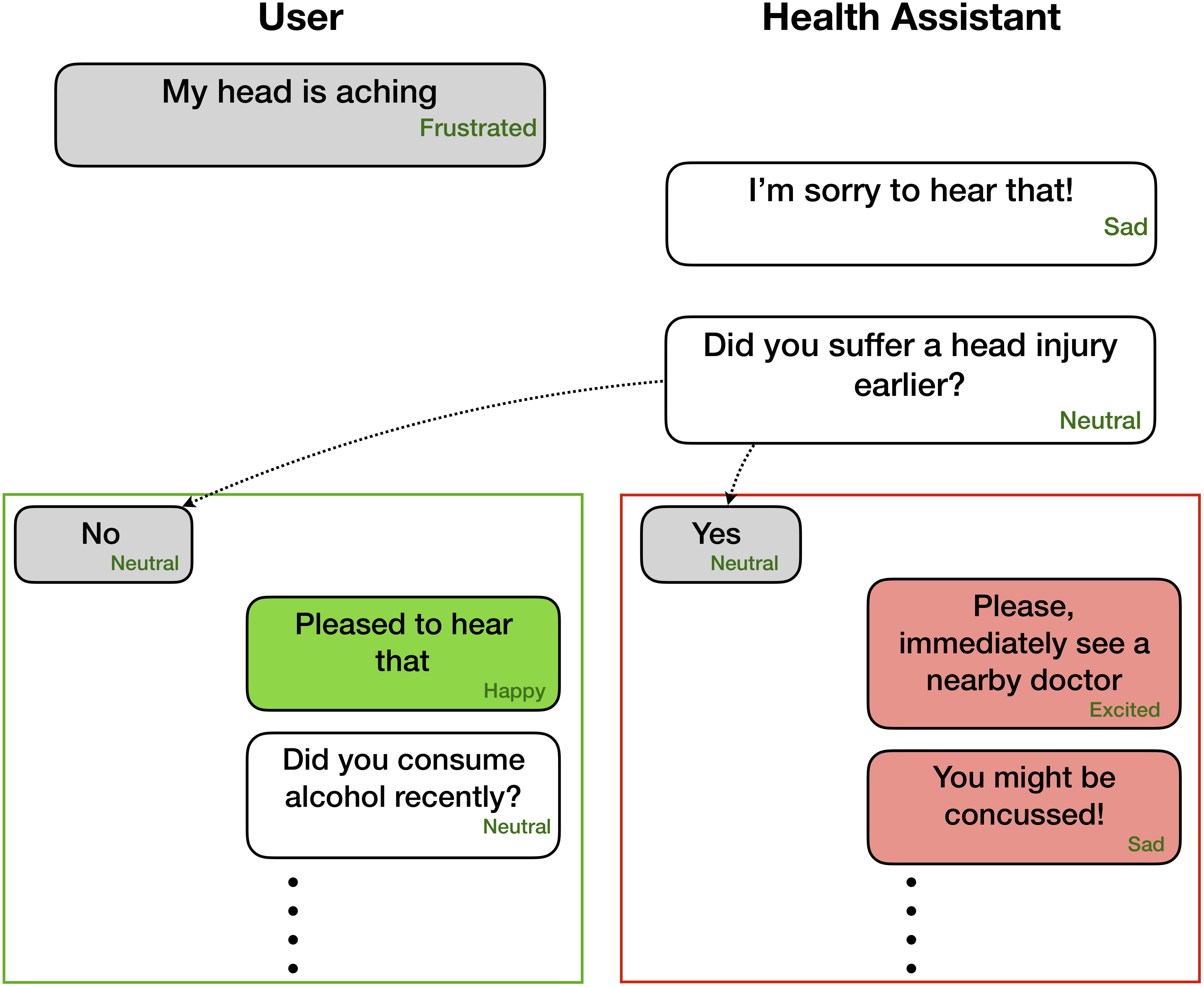

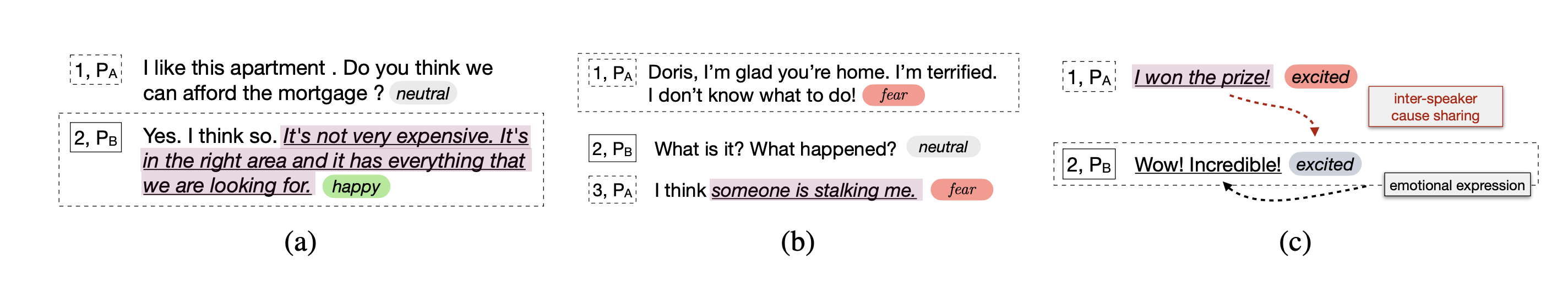

ซึ่งแตกต่างจากรูปแบบการตรวจจับอารมณ์อื่น ๆ เทคนิคเหล่านี้พิจารณารัฐปาร์ตี้และการพึ่งพาระหว่างพรรคสำหรับการสร้างแบบจำลองบริบทการสนทนาที่เกี่ยวข้องกับการจดจำอารมณ์ วัตถุประสงค์หลักของเทคนิคทั้งหมดเหล่านี้คือการเตรียมรูปแบบการตรวจจับอารมณ์สำหรับการสร้างบทสนทนาที่เห็นอกเห็นใจ

การจดจำอารมณ์มีประโยชน์มากสำหรับการสร้างความเห็นอกเห็นใจและการสนทนาทางอารมณ์ -

เครือข่ายเหล่านี้คาดว่าจะมีฉลากอารมณ์/ความเชื่อมั่นและข้อมูลลำโพงสำหรับแต่ละคำพูดที่มีอยู่ในบทสนทนาเช่น

Party 1: I hate my girlfriend (angry)

Party 2: you got a girlfriend?! (surprise)

Party 1: yes (angry)

อย่างไรก็ตามรหัสสามารถ adpated เพื่อดำเนินการงานที่มีเพียงคำพูดก่อนหน้านี้โดยไม่มีฉลากที่สอดคล้องกันเนื่องจากบริบทและเป้าหมายคือการติดฉลากเฉพาะคำพูดปัจจุบัน/เป้าหมาย ตัวอย่างเช่น บริบท คือ

Party 1: I hate my girlfriend

Party 2: you got a girlfriend?!

เป้าหมาย คือ

Party 1: yes (angry)

อารมณ์ความรู้สึกของเป้าหมาย โกรธ ยิ่งไปกว่านั้นรหัสนี้ยังสามารถหล่อขึ้นรูปเพื่อฝึกอบรมเครือข่ายในลักษณะ end-to-end ในไม่ช้าเราจะผลักดันการเปลี่ยนแปลงที่เป็นประโยชน์เหล่านี้

| วิธีการ | Iemocap | DailyDialog | หลอมละลาย | Emorynlp | |||

|---|---|---|---|---|---|---|---|

| W-AVG F1 | มาโคร F1 | Micro F1 | W-AVG F1 (3-Cls) | W-AVG F1 (7-Cls) | W-AVG F1 (3-Cls) | W-AVG F1 (7-Cls) | |

| โรเบอร์ต้า | 54.55 | 48.20 | 55.16 | 72.12 | 62.02 | 55.28 | 37.29 |

| Roberta Dialoguernn | 64.76 | 49.65 | 57.32 | 72.14 | 63.61 | 55.36 | 37.44 |

| Roberta Cosmic | 65.28 | 51.05 | 58.48 | 73.20 | 65.21 | 56.51 | 38.11 |

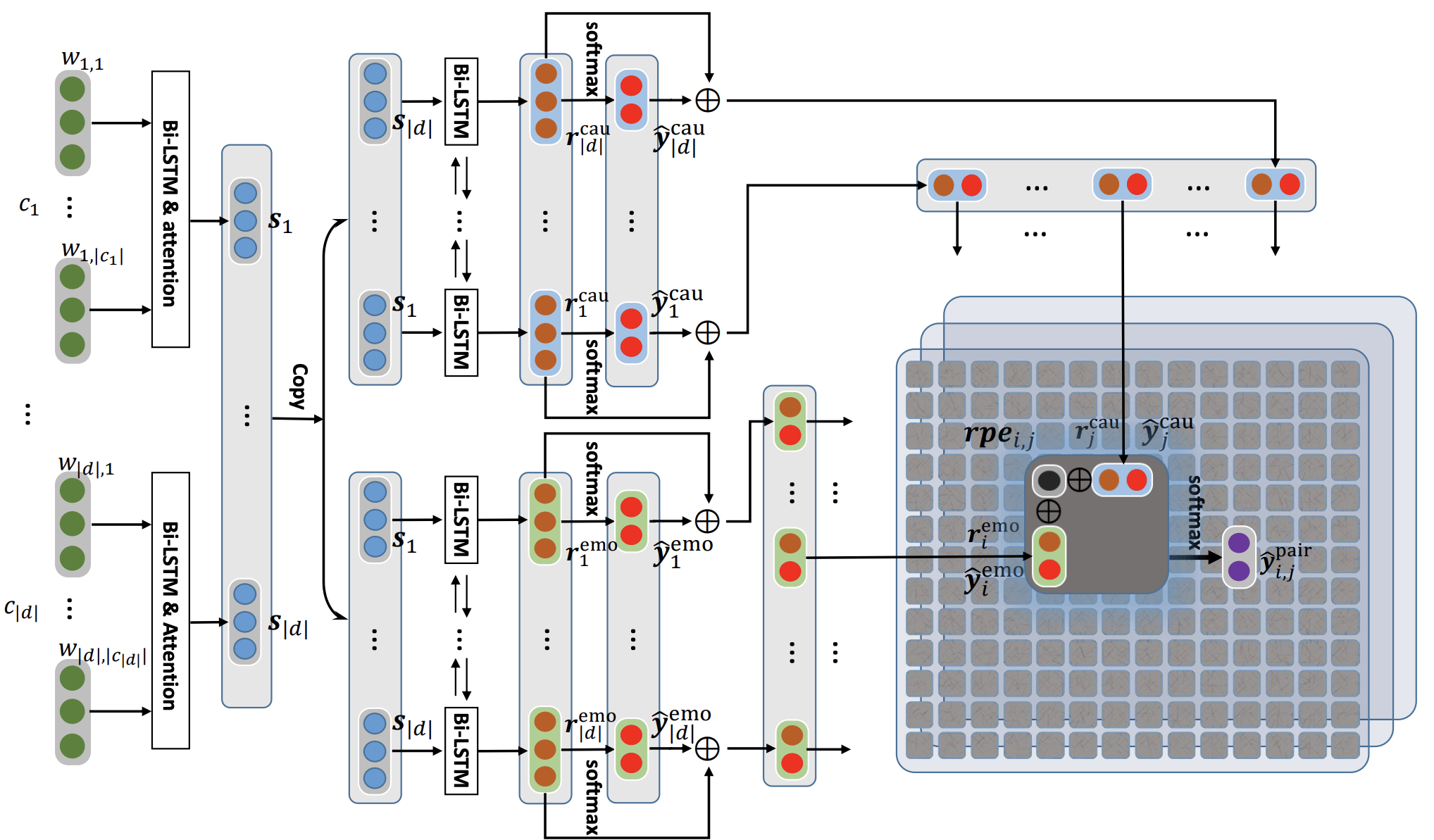

Cosmic กล่าวถึงภารกิจของการรับรู้ระดับอารมณ์ในการสนทนาในการสนทนาโดยใช้ความรู้ทั่วไป มันเป็นเฟรมเวิร์กใหม่ที่รวมองค์ประกอบต่าง ๆ ของการรวมกันเช่นรัฐทางจิตเหตุการณ์และความสัมพันธ์เชิงสาเหตุและสร้างพวกเขาเพื่อเรียนรู้การมีปฏิสัมพันธ์ระหว่างคู่สนทนาที่เข้าร่วมในการสนทนา วิธีการที่ทันสมัยในปัจจุบันมักจะประสบปัญหาในการเผยแพร่บริบทการตรวจจับการเปลี่ยนอารมณ์และการแยกความแตกต่างระหว่างคลาสอารมณ์ที่เกี่ยวข้อง ด้วยการเรียนรู้การเป็นตัวแทนทั่วไปที่แตกต่างกัน Cosmic จัดการกับความท้าทายเหล่านี้และบรรลุผลลัพธ์ที่ทันสมัยใหม่สำหรับการจดจำอารมณ์ในชุดข้อมูลการสนทนามาตรฐานที่แตกต่างกันสี่ชุด

ก่อนอื่นดาวน์โหลดคุณสมบัติ Roberta และ Comet ที่นี่และเก็บไว้ในไดเรกทอรีที่เหมาะสมใน COSMIC/erc-training จากนั้นการฝึกอบรมและการประเมินผลในชุดข้อมูลทั้งสี่จะต้องทำดังนี้:

python train_iemocap.py --active-listenerpython train_dailydialog.py --active-listener --class-weight --residualpython train_meld.py --active-listener --attention simple --dropout 0.5 --rec_dropout 0.3 --lr 0.0001 --mode1 2 --classify emotion --mu 0 --l2 0.00003 --epochs 60python train_meld.py --active-listener --class-weight --residual --classify sentimentpython train_emorynlp.py --active-listener --class-weight --residualpython train_emorynlp.py --active-listener --class-weight --residual --classify sentimentโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

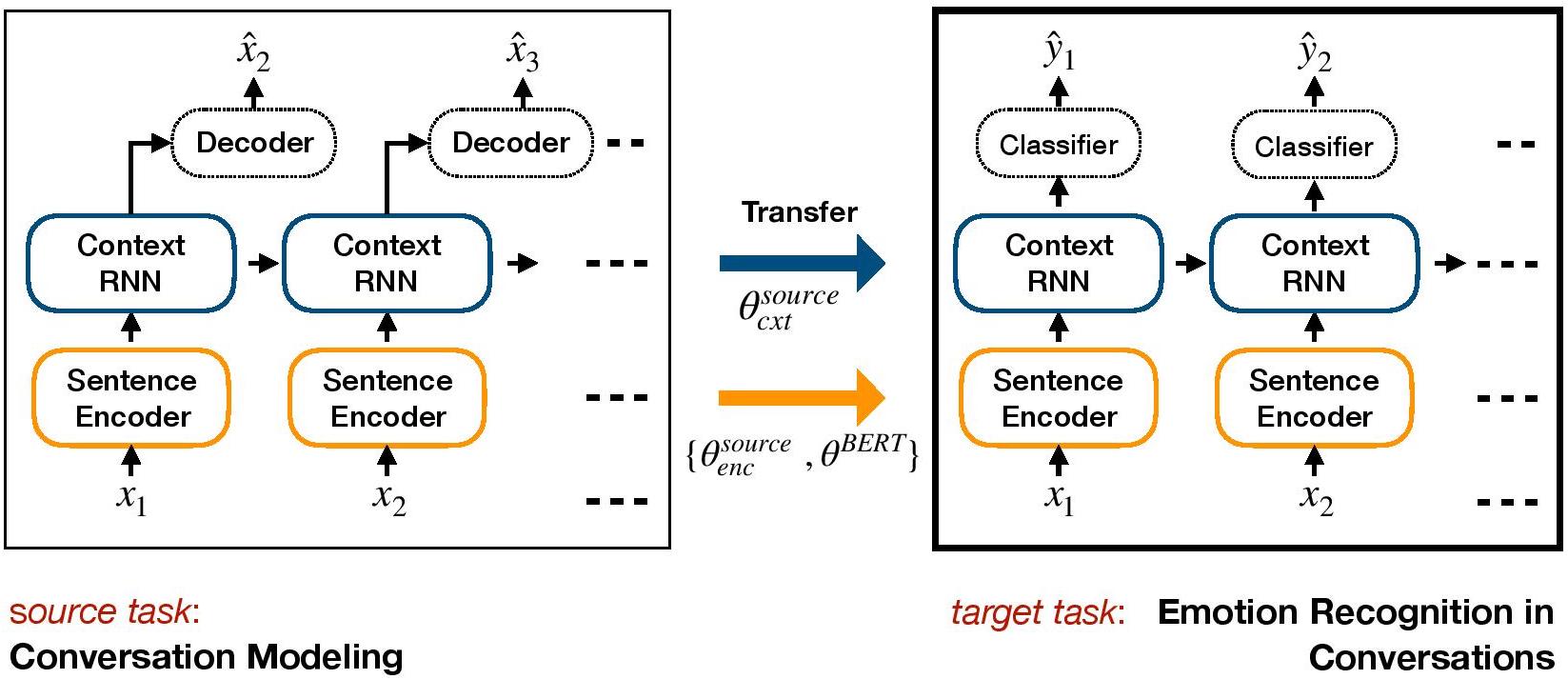

COSMIC: COmmonSense knowledge for eMotion Identification in Conversations. D. Ghosal, N. Majumder, A. Gelbukh, R. Mihalcea, & S. Poria. Findings of EMNLP 2020.TL-ERC เป็นกรอบการเรียนรู้ที่ใช้การเรียนรู้สำหรับ ERC มันเป็นแบบจำลองการสนทนาแบบกำเนิดและถ่ายทอดน้ำหนักระดับบริบทซึ่งรวมถึงความรู้ทางอารมณ์ในรูปแบบการเลือกปฏิบัติเป้าหมายสำหรับ ERC

ตั้งค่าสภาพแวดล้อมด้วย conda:

conda env create -f environment.yml

conda activate TL_ERC

cd TL_ERC

python setup.py ดาวน์โหลดไฟล์ชุดข้อมูล iemocap, dailyDialog และจัดเก็บไว้ใน ./datasets/ /

ดาวน์โหลดชุดข้อมูล Hred บนชุดข้อมูล Cornell และ Ubuntu ที่ผ่านการฝึกอบรมมาก่อนและเก็บไว้ใน ./generative_weights/

[ไม่บังคับ]: ในการฝึกอบรมน้ำหนักกำเนิดใหม่จากแบบจำลองการสนทนาโปรดดู https://github.com/ctr4si/a-hierarchical-latent-structure-for-variational-conversation-modeling

cd bert_modelpython train.py --load_checkpoint=../generative_weights/cornell_weights.pkl --data=iemocapcornell เป็น ubuntu และ iemocap เป็น dailydialog สำหรับชุดข้อมูลอื่น ๆload_checkpoint เพื่อหลีกเลี่ยงการเริ่มต้นน้ำหนักตามบริบทconfigs.pypython iemocap_preprocess.py ในทำนองเดียวกันสำหรับ dailydialogโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

Conversational transfer learning for emotion recognition. Hazarika, D., Poria, S., Zimmermann, R., & Mihalcea, R. (2020). Information Fusion.DialogueGCN (Dialogue Graph Network Convolutional Network) เป็นวิธีการใช้เครือข่ายระบบประสาทกราฟเพื่อ ERC เราใช้ประโยชน์จากการพึ่งพาตัวเองและผู้พูดคุยกันของคู่สนทนาเพื่อจำลองบริบทการสนทนาสำหรับการจดจำอารมณ์ ผ่านเครือข่ายกราฟ DialogueGCN จัดการปัญหาการแพร่กระจายบริบทที่มีอยู่ในวิธีการที่ใช้ RNN ปัจจุบัน DialogueGCN เหมาะสำหรับการสนทนาหลายพรรค

หมายเหตุ : Pytorch Geometric ทำให้การใช้งานของ CUDA Atomic อย่างหนักและเป็นแหล่งที่มาของการไม่ตัดสินใจ ในการทำซ้ำผลลัพธ์ที่รายงานในกระดาษเราขอแนะนำให้ใช้คำสั่งการดำเนินการต่อไปนี้ โปรดทราบว่าสคริปต์นี้จะดำเนินการใน CPU เราลดคะแนนเฉลี่ยถ่วงน้ำหนัก F1 ที่ 64.67 ในเครื่องของเราและ 64.44 ใน Google Colaboratory สำหรับชุดข้อมูล IEMOCAP ด้วยคำสั่งต่อไปนี้

python train_IEMOCAP.py --base-model 'LSTM' --graph-model --nodal-attention --dropout 0.4 --lr 0.0003 --batch-size 32 --class-weight --l2 0.0 --no-cudaโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.การใช้ Pytorch ไปยัง Paper "DialogueGCN: เครือข่ายนิวรัลแบบกราฟที่มีความสุขสำหรับการจดจำอารมณ์ในการสนทนา"

คุณสามารถเรียกใช้กระบวนการทั้งหมดได้อย่างง่ายดาย ใช้คลังข้อมูล IEMOCAP เช่น:

./scripts/iemocap.sh preprocess./scripts/iemocap.sh train| - | ชุดข้อมูล | ถ่วงน้ำหนัก F1 |

|---|---|---|

| ต้นฉบับ | Iemocap | 64.18% |

| การใช้งานนี้ | Iemocap | 64.10% |

Mian Zhang (GitHub: Mianzhang)

โปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

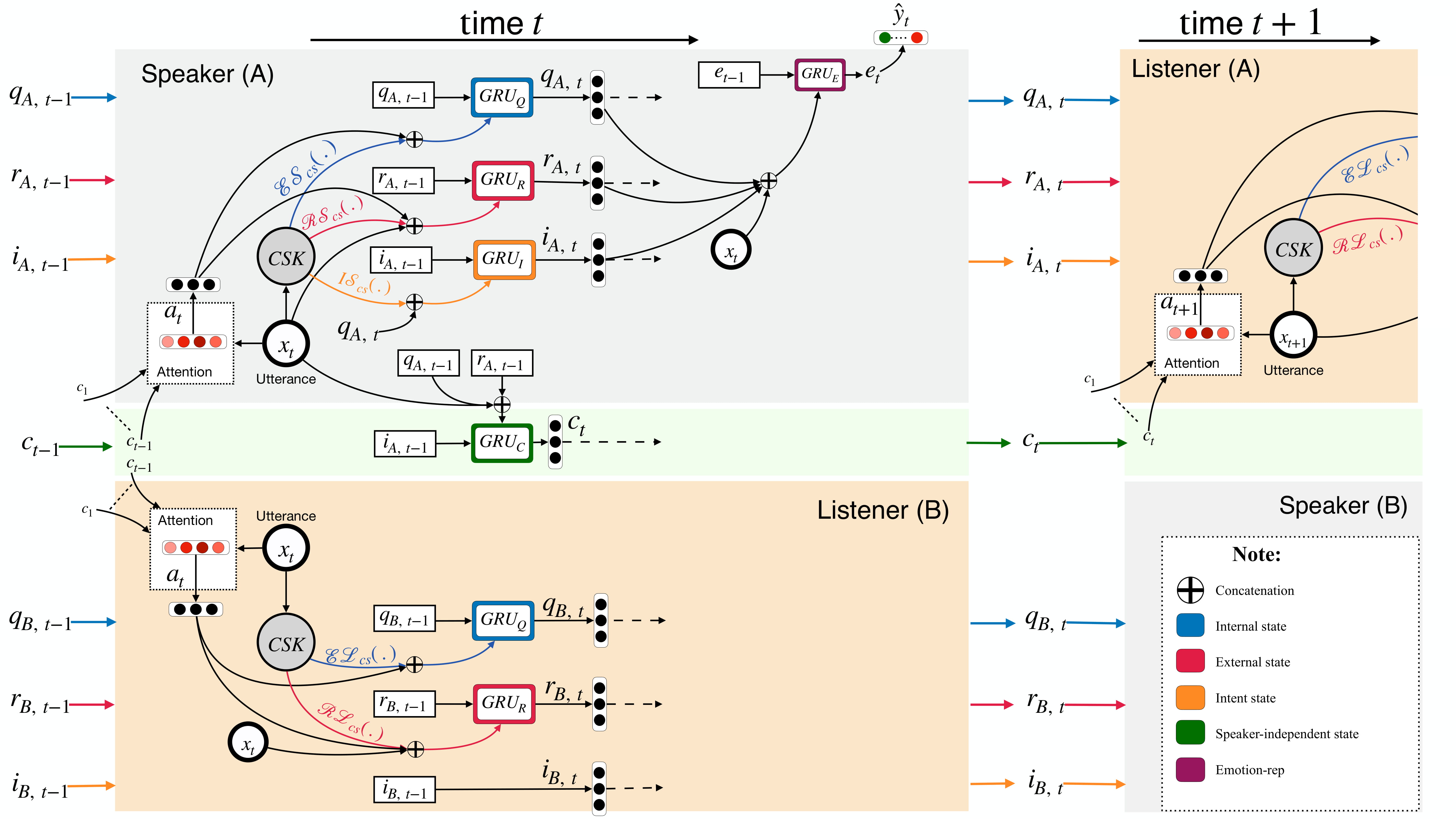

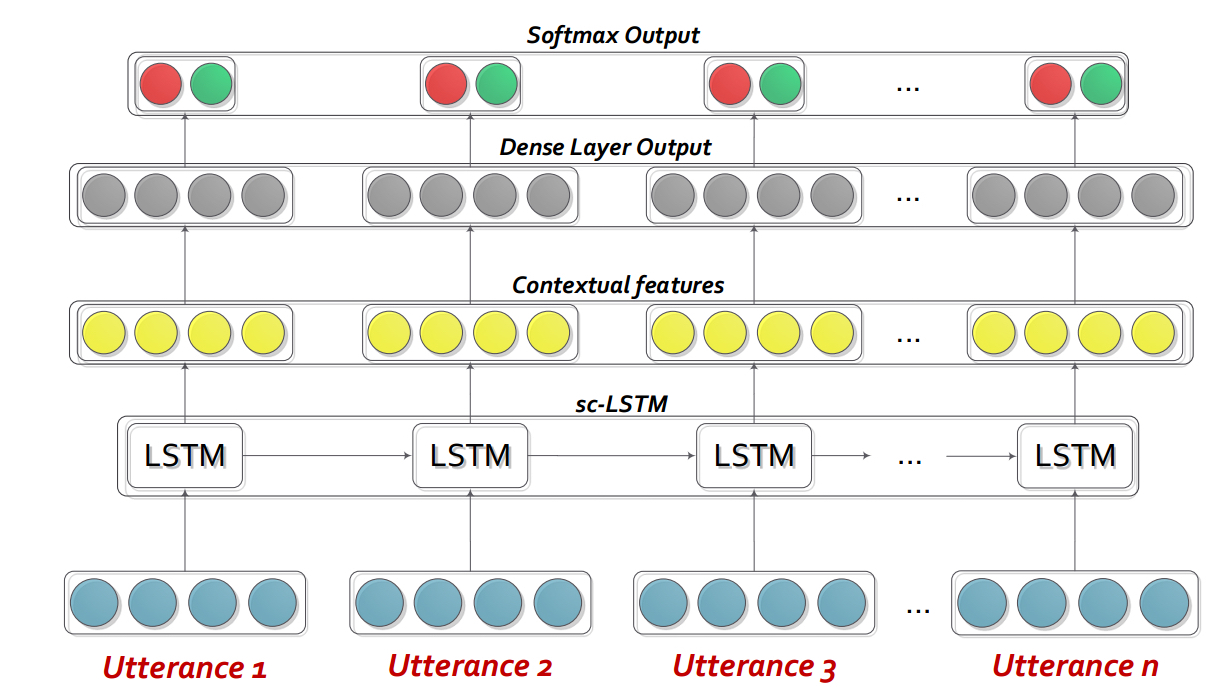

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.Dialoguernn เป็นเครือข่ายประสาทกำเริบที่กำหนดเอง (RNN) ที่กำหนดเองซึ่งโปรไฟล์ผู้พูดแต่ละคนในการสนทนา/บทสนทนาในขณะที่จำลองบริบทของการสนทนาในเวลาเดียวกัน รุ่นนี้สามารถขยายไปยังสถานการณ์หลายพรรคได้อย่างง่ายดาย นอกจากนี้ยังสามารถใช้เป็นแบบจำลองการเตรียมการสำหรับการสร้างบทสนทนาที่เห็นอกเห็นใจ

หมายเหตุ : การตั้งค่าเริ่มต้น (hyperparameters และอาร์กิวเมนต์ commandline) ในรหัสมีความหมายสำหรับ bidialoguernn+att ผู้ใช้จำเป็นต้องปรับการตั้งค่าให้เหมาะสมสำหรับตัวแปรและการเปลี่ยนแปลงอื่น ๆ

โปรดแยกเนื้อหาของ DialogueRNN_features.zip

python train_IEMOCAP.py <command-line arguments>python train_AVEC.py <command-line arguments>--no-cuda : ไม่ใช้ GPU--lr : อัตราการเรียนรู้--l2 : น้ำหนักการทำให้เป็นมาตรฐาน L2--rec-dropout : DROPOUT ซ้ำ--dropout : Dropout--batch-size : ขนาดแบทช์--epochs : จำนวนยุค--class-weight : น้ำหนักคลาส (ไม่สามารถใช้ได้กับ Avec)--active-listener : โหมด Lisnener ที่ชัดเจน--attention : ประเภทความสนใจ--tensorboard : เปิดใช้งานบันทึก Tensorboard--attribute : แอตทริบิวต์ 1 ถึง 4 (เฉพาะสำหรับ AVEC; 1 = Valence, 2 = การเปิดใช้งาน/เร้าอารมณ์, 3 = ความคาดหวัง/ความคาดหวัง, 4 = พลังงาน)โปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

DialogueRNN: An Attentive RNN for Emotion Detection in Conversations. N. Majumder, S. Poria, D. Hazarika, R. Mihalcea, E. Cambria, and G. Alexander. AAAI (2019), Honolulu, Hawaii, USAInteractive Conversational Memory Network (ICON) เป็นกรอบการตรวจจับอารมณ์หลายรูปแบบที่แยกคุณลักษณะหลายรูปแบบจากวิดีโอการสนทนาและแบบจำลองแบบลำดับชั้น textit {self self} และ textit {inter-speaker} อิทธิพลทางอารมณ์เข้าสู่ความทรงจำระดับโลก ความทรงจำดังกล่าวสร้างบทสรุปตามบริบทซึ่งช่วยในการทำนายการวางแนวอารมณ์ของ Videos-Videos

cd ICON

เปิดเครื่องซิปข้อมูลดังนี้:

/ICON/IEMOCAP/data/ คำสั่งตัวอย่างเพื่อให้ได้สิ่งนี้: unzip {path_to_zip_file} -d ./IEMOCAP/ฝึกอบรมโมเดลไอคอน:

python train_iemocap.py สำหรับ iemocapICON: Interactive Conversational Memory Networkfor Multimodal Emotion Detection. D. Hazarika, S. Poria, R. Mihalcea, E. Cambria, and R. Zimmermann. EMNLP (2018), Brussels, Belgium CMN เป็นกรอบประสาทสำหรับการตรวจจับอารมณ์ในการสนทนา dyadic มันใช้ประโยชน์จากสัญญาณ mutlimodal จากข้อความเสียงและภาพ มันรวมการพึ่งพาเฉพาะของผู้พูดลงในสถาปัตยกรรมสำหรับการสร้างแบบจำลองบริบท สรุปจะถูกสร้างขึ้นจากบริบทนี้โดยใช้เครือข่ายหน่วยความจำแบบหลายฮอป

cd CMN

เปิดเครื่องซิปข้อมูลดังนี้:

/CMN/IEMOCAP/data/ คำสั่งตัวอย่างเพื่อให้ได้สิ่งนี้: unzip {path_to_zip_file} -d ./IEMOCAP/ฝึกอบรมโมเดลไอคอน:

python train_iemocap.py สำหรับ iemocapโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

Hazarika, D., Poria, S., Zadeh, A., Cambria, E., Morency, L.P. and Zimmermann, R., 2018. Conversational Memory Network for Emotion Recognition in Dyadic Dialogue Videos. In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers) (Vol. 1, pp. 2122-2132).BC-LSTM-PYTORCH เป็นเครือข่ายสำหรับการใช้บริบทเพื่อตรวจจับอารมณ์ของคำพูดในบทสนทนา แบบจำลองนั้นง่าย แต่มีประสิทธิภาพซึ่งใช้ LSTM เพื่อสร้างแบบจำลองความสัมพันธ์ชั่วคราวระหว่างคำพูด ใน repo นี้เราให้ข้อมูลของ Semeval 2019 ภารกิจ 3 เราได้ใช้และให้ข้อมูลที่เผยแพร่โดย Semeval 2019 Task 3 - "การจดจำอารมณ์ในบริบท" ในภารกิจนี้มีเพียง 3 คำพูด - คำพูด 1 (user1), คำพูด 2 (user2), คำพูด 3 (user1) ติดต่อกัน ภารกิจคือการทำนายฉลากอารมณ์ของคำพูด 3 ฉลากอารมณ์ของแต่ละคำพูดยังไม่ได้รับการจัดเตรียม อย่างไรก็ตามหากข้อมูลของคุณมีฉลากอารมณ์ของแต่ละคำพูดคุณยังสามารถใช้รหัสนี้และปรับให้เข้ากันได้ ดังนั้นรหัสนี้ยังคงสามารถใช้งานได้สำหรับชุดข้อมูลเช่น MOSI, Mosei, IEMOCAP, AVEC, DailyDialogue ฯลฯ BC-LSTM ไม่ได้ใช้ประโยชน์จากข้อมูลลำโพงเช่น CMN, ไอคอนและบทสนทนา

cd bc-LSTM-pytorch

ฝึกอบรมรุ่น BC-LSTM:

python train_IEMOCAP.py สำหรับ iemocapโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).การใช้งาน Keras ของ BC-LSTM

cd bc-LSTM

ฝึกอบรมรุ่น BC-LSTM:

python baseline.py -config testBaseline.config สำหรับ iemocapโปรดอ้างอิงกระดาษต่อไปนี้หากคุณพบว่ารหัสนี้มีประโยชน์ในงานของคุณ

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).พื้นที่เก็บข้อมูลนี้ยังมีการใช้งานสถาปัตยกรรมที่แตกต่างกันเพื่อตรวจจับความรู้สึกในการสนทนา

| แบบอย่าง | emo_f1 | pos_f1 | neg_f1 | macro_avg |

|---|---|---|---|---|

| ECPE-2D Cross_road (0 Transform Layer) | 52.76 | 52.39 | 95.86 | 73.62 |

| ECPE-2D window_constrained (1 แปลงเลเยอร์) | 70.48 | 48.80 | 93.85 | 71.32 |

| ECPE-2D Cross_road (2 Transform Layer) | 52.76 | 55.50 | 94.96 | 75.23 |

| ECPE-MLL | - | 48.48 | 94.68 | 71.58 |

| จัดอันดับอารมณ์สาเหตุ | - | 33.00 | 97.30 | 65.15 |

| เบสโรเบอร์ต้า | - | 64.28 | 88.74 | 76.51 |

| Roberta-large | - | 66.23 | 87.89 | 77.06 |

การอ้างอิง: โปรดอ้างอิงเอกสารต่อไปนี้หากคุณใช้รหัสนี้

การอ้างอิง: โปรดอ้างอิงเอกสารต่อไปนี้หากคุณใช้รหัสนี้

การอ้างอิง: โปรดอ้างอิงเอกสารต่อไปนี้หากคุณใช้รหัสนี้

Roberta และ Spanbert Baselines ตามที่อธิบายไว้ในกระดาษ Reccon ต้นฉบับ อ้างถึงสิ่งนี้

การอ้างอิง: โปรดอ้างอิงเอกสารต่อไปนี้หากคุณใช้รหัสนี้