For those enquiring about how to extract visual and audio features, please check this out: https://github.com/soujanyaporia/MUStARD

| Дата | Объявления |

|---|---|

| 10/03/2024 | Если вы заинтересованы в IQ Testing LLMS, ознакомьтесь с нашей новой работой: Algopuzzzzzqa |

| 03/08/2021 | ? ? Мы выпустили новый набор данных M2H2: мультимодальный многопартийный набор данных хинди для распознавания юмора в разговорах. Проверьте это: M2H2. Базовые линии для набора данных M2H2 созданы на основе Dialoguernn и BCLSTM. |

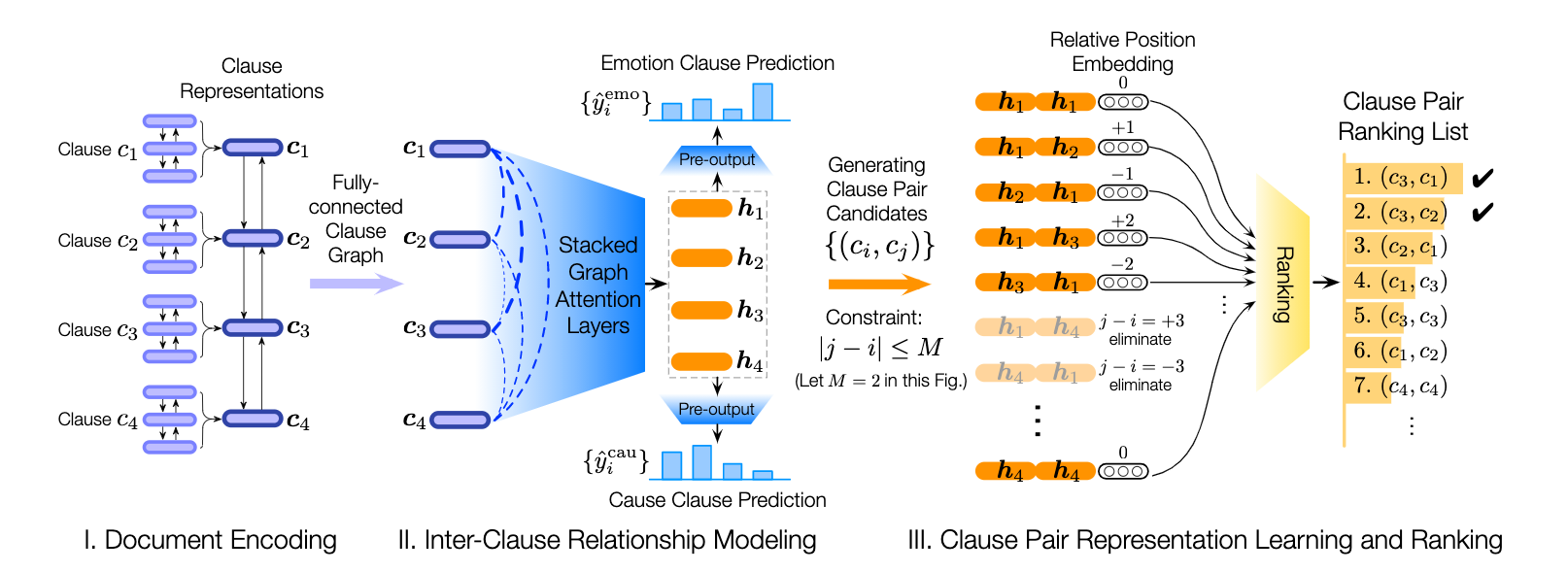

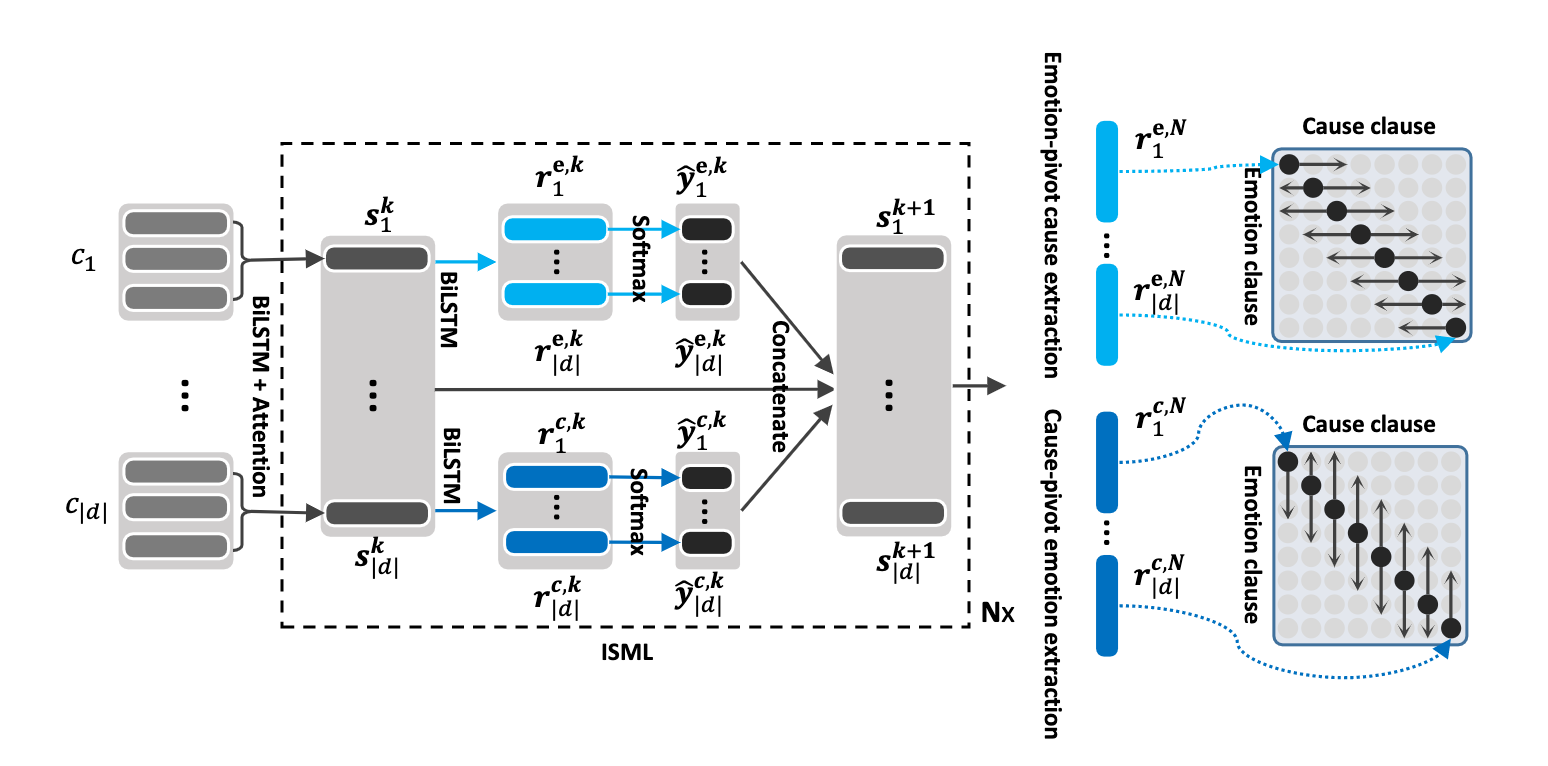

| 18/05/2021 | ? ? Мы выпустили новую репо, содержащую модели для решения проблемы эмоций, вызвав распознавание в разговорах. Проверьте это: Emotion Case-Extraction. Спасибо Пенгфей Хонгу за то, что он собирал это. |

| 24/12/2020 | ? ? Заинтересованы в теме признания эмоций в разговорах? Мы только что выпустили набор данных для этого. Перейдите на https://github.com/declare-lab/reccon. |

| 10/10/2020 | ? ? Новая статья и SOTA в распознавании эмоций в разговорах. Обратитесь к COSMIC Directory для кода. Прочитайте статью - Cosmic: знание здравого смысла для идентификации эмоций в разговорах. |

| 30/09/2020 | Новая статья и базовые показатели в понимании диалога на уровне высказывания были выпущены. Прочитайте нашу статью о диалоге на уровне высказывания: эмпирическое исследование. Вилка кодов. |

| 26/07/2020 | Новый DialogueGCN Code был выпущен. Пожалуйста, посетите https://github.com/declare-lab/conv-emotion/tree/master/dialoguggcn-mianzhang. Весь кредит идет на Миан Чжан (https://github.com/mianzhang/) |

| 11/07/2020 | Заинтересованы в чтении документов по ERC или связанных задачам, таким как обнаружение сарказма в разговорах? Мы собрали комплексный список чтения для бумаг. Пожалуйста, посетите https://github.com/declare-lab/awesome-emotion-recognition-in-conversations |

| 07/06/2020: | Новые современные результаты для задачи ERC в ближайшее время будут опубликованы. |

| 07/06/2020: | Репонирование Conv-Emotion будет поддерживаться на https://github.com/declare-lab/ |

| 22/12/2019: | Код для DialogueGCN был выпущен. |

| 10/10/2019: | Новая статья: разговорная передача обучения для распознавания эмоций. |

| 09/08/2019: | Новая статья об распознавании эмоций в разговоре (ERC). |

| 06/03/2019: | Функции и коды для обучения Dialoguernn на наборе данных MELD были выпущены. |

| 20/11/2018: | Средняя версия Icon и Dialoguernn была выпущена. |

Cosmic является лучшей моделью в этом репо, и, пожалуйста, посетите ссылки ниже, чтобы сравнить модели в разных наборах данных ERC.

Этот репозиторий содержит реализации для нескольких методов распознавания эмоций в методах разговоров, а также алгоритмы для распознавания эмоций в разговорах:

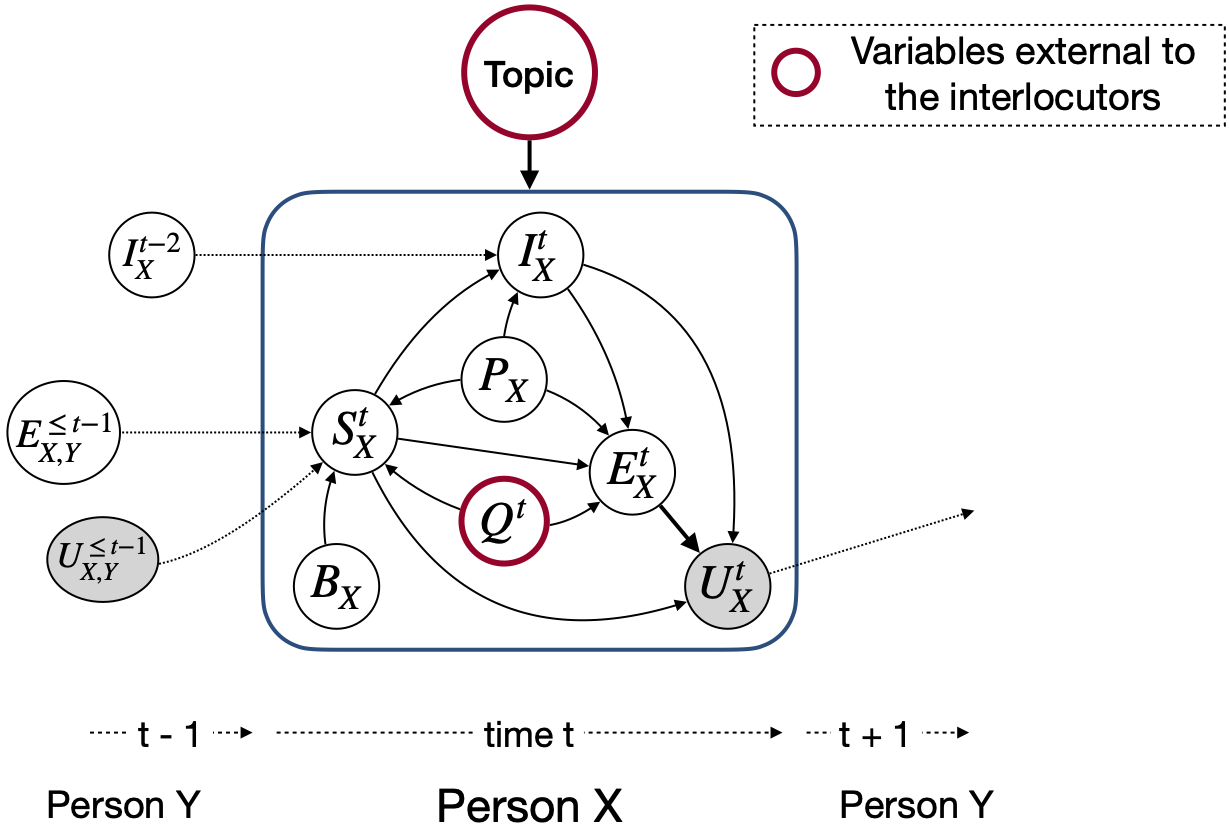

В отличие от других моделей обнаружения эмоций, эти методы рассматривают партийные государства и межпартийные зависимости для моделирования разговорного контекста, относящегося к распознаванию эмоций. Основной целью всех этих методов является предварительное определение модели обнаружения эмоций для эмпатического генерации диалога.

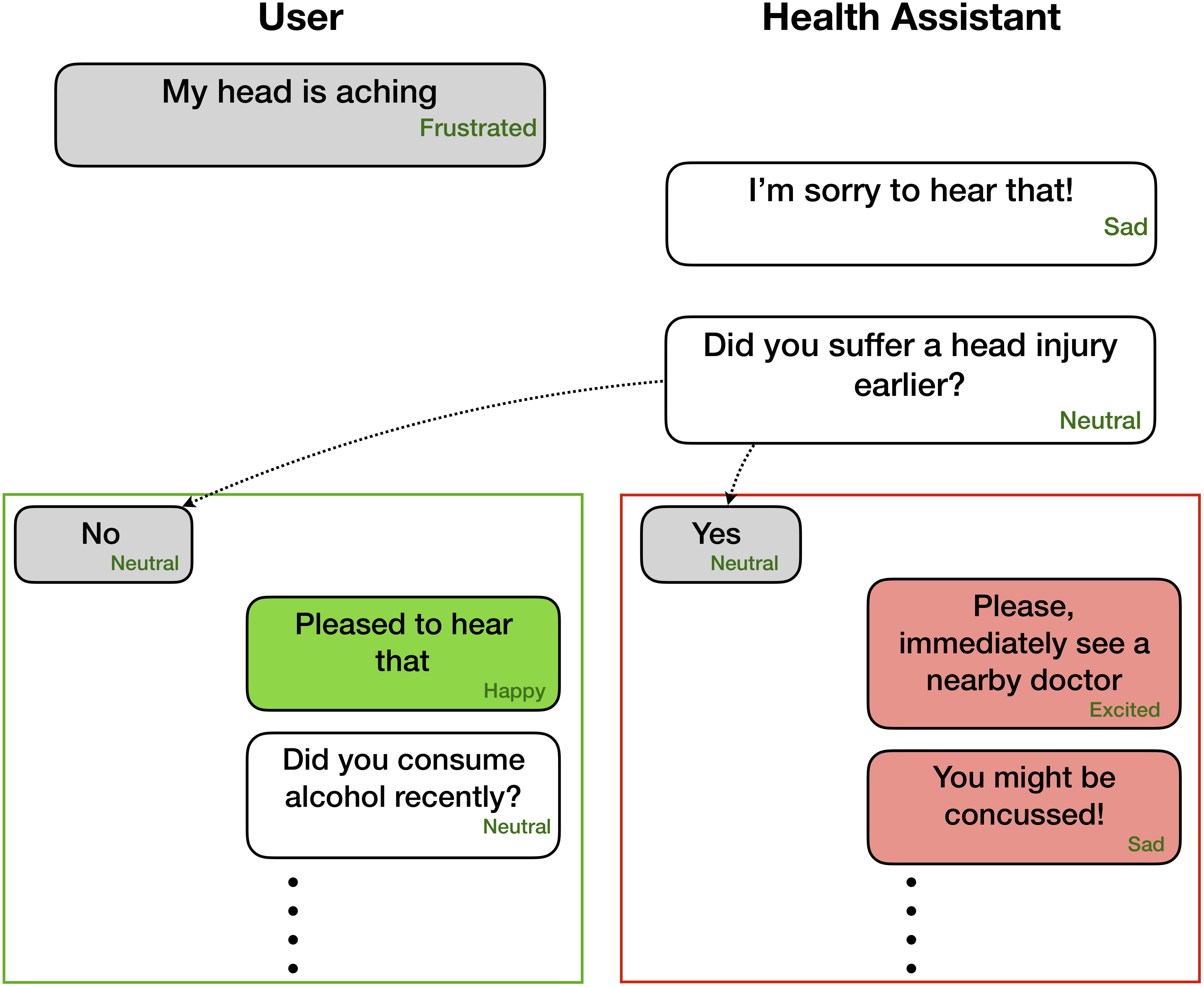

Распознавание эмоций может быть очень полезным для эмпатического и аффективного поколения диалога -

Эти сети ожидают информацию о эмоциональных/настроениях и докладчике для каждого высказывания, присутствующего в таком диалоге, как

Party 1: I hate my girlfriend (angry)

Party 2: you got a girlfriend?! (surprise)

Party 1: yes (angry)

Тем не менее, код может быть акцентирован для выполнения задач, когда доступны только предыдущие высказывания, без соответствующих этикетков, поскольку контекст и цель состоит в том, чтобы пометить только текущее/целевое высказывание. Например, контекст

Party 1: I hate my girlfriend

Party 2: you got a girlfriend?!

цель

Party 1: yes (angry)

Где целевая эмоция злится . Более того, этот код также может быть формирован для обучения сети в сквозной манере. Вскоре мы продвинем эти полезные изменения.

| Методы | Iemocap | DailyDialog | Смеситель | Emorynlp | |||

|---|---|---|---|---|---|---|---|

| W-AVG F1 | Макро F1 | Micro F1 | W-AVG F1 (3-CLS) | W-AVG F1 (7-CLS) | W-AVG F1 (3-CLS) | W-AVG F1 (7-CLS) | |

| Роберта | 54,55 | 48.20 | 55,16 | 72.12 | 62,02 | 55,28 | 37.29 |

| Роберта Диалогернн | 64,76 | 49,65 | 57.32 | 72.14 | 63,61 | 55,36 | 37.44 |

| Роберта Космик | 65,28 | 51.05 | 58.48 | 73,20 | 65,21 | 56.51 | 38.11 |

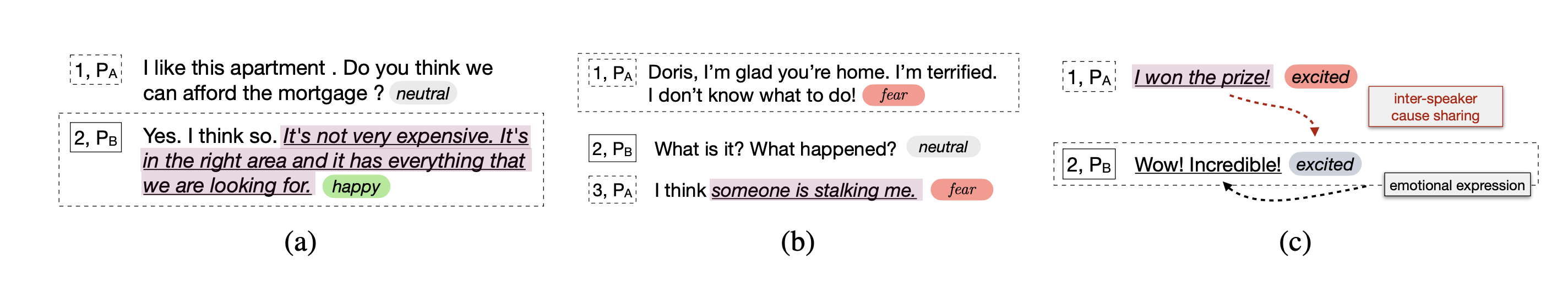

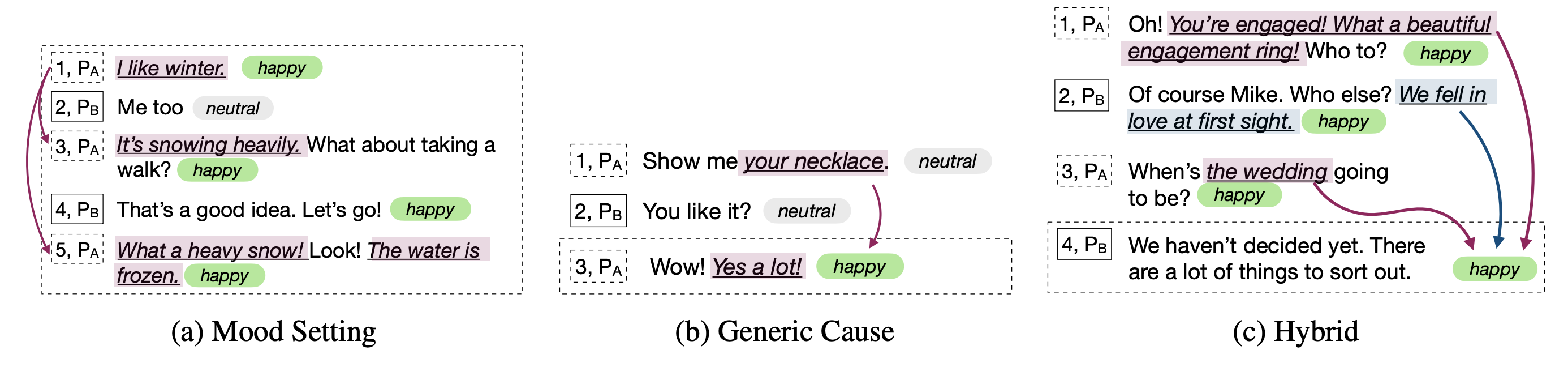

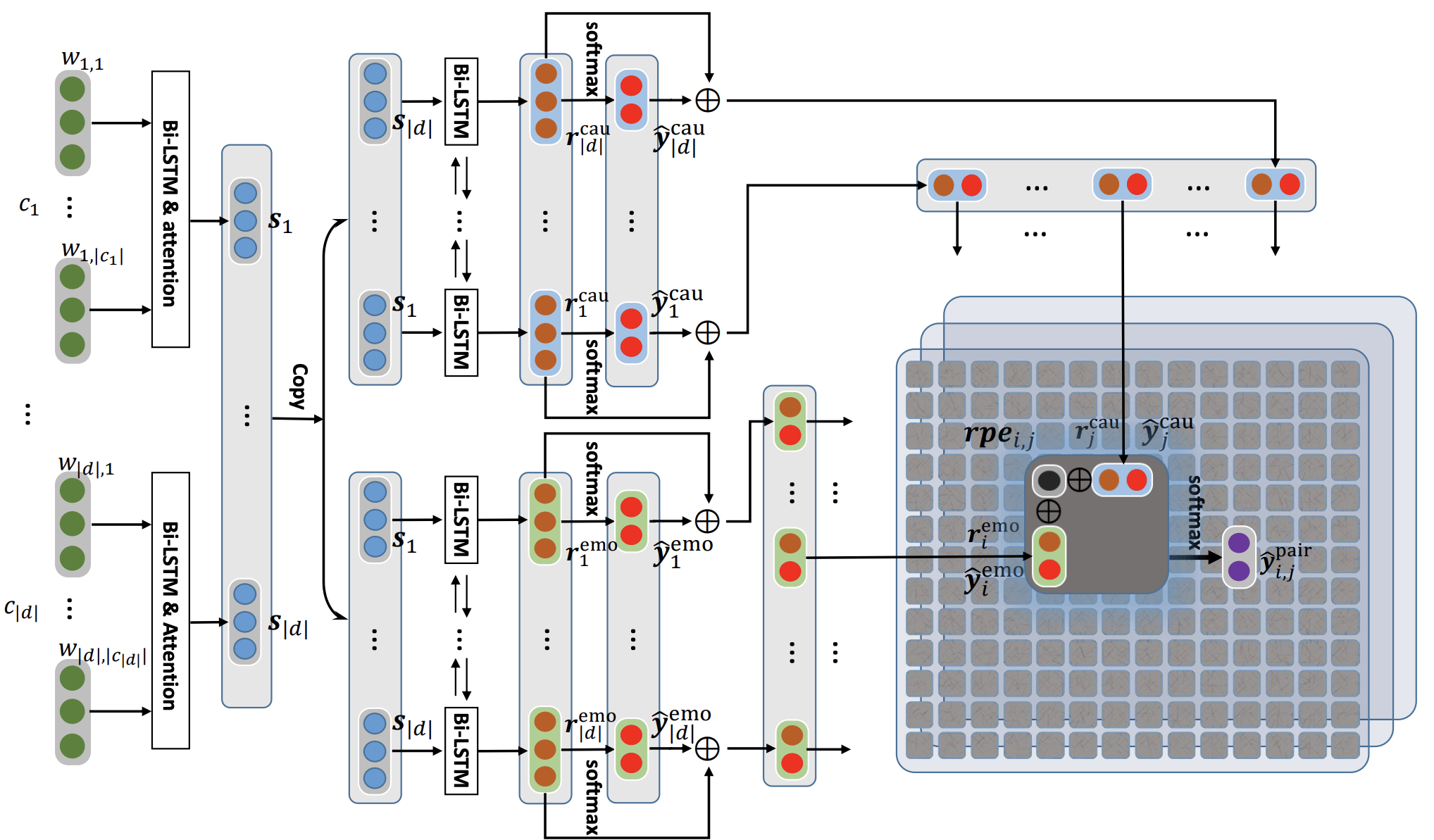

Cosmic решает задачу распознавания эмоций на уровне высказывания в разговорах с использованием знаний здравого смысла. Это новая структура, которая включает в себя различные элементы здравого смысла, такие как психические состояния, события и причинно -следственные связи, и опираются на них для изучения взаимодействия между собеседниками, участвующими в разговоре. Текущие современные методы часто сталкиваются с трудностями в распространении контекста, обнаружении эмоций и дифференциации между родственными классами эмоций. Изучая четкие представления Commonsense, Cosmic решает эти проблемы и достигает новых современных результатов для распознавания эмоций на четырех различных тесных разговорных наборах.

Сначала загрузите функции Roberta и Comet здесь и держите их в соответствующих каталогах в COSMIC/erc-training . Затем обучение и оценка по четырем наборам данных должны быть сделаны следующим образом:

python train_iemocap.py --active-listenerpython train_dailydialog.py --active-listener --class-weight --residualpython train_meld.py --active-listener --attention simple --dropout 0.5 --rec_dropout 0.3 --lr 0.0001 --mode1 2 --classify emotion --mu 0 --l2 0.00003 --epochs 60python train_meld.py --active-listener --class-weight --residual --classify sentimentpython train_emorynlp.py --active-listener --class-weight --residualpython train_emorynlp.py --active-listener --class-weight --residual --classify sentimentПожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

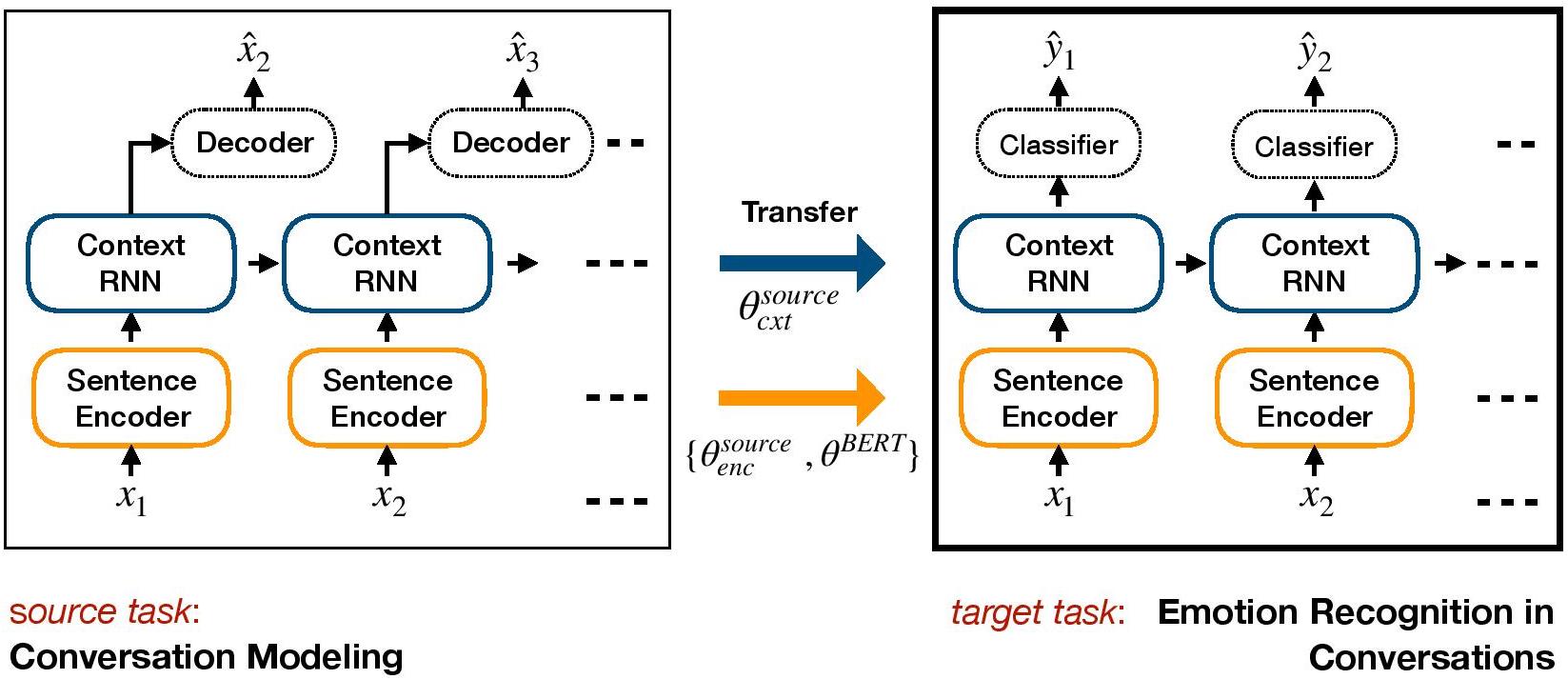

COSMIC: COmmonSense knowledge for eMotion Identification in Conversations. D. Ghosal, N. Majumder, A. Gelbukh, R. Mihalcea, & S. Poria. Findings of EMNLP 2020.TL-ERC -это основанная на переносном обучении структуру для ERC. Он предварительно обучает генеративную модель диалога и передает веса уровня контекста, которые включают аффективные знания в целевую дискриминационную модель для ERC.

Установите среду с Conda:

conda env create -f environment.yml

conda activate TL_ERC

cd TL_ERC

python setup.py Загрузите файлы набора данных iemocap, DailyDialog и храните их в ./datasets/ .

Загрузите предварительно обученные веса Hred на наборах данных Cornell и Ubuntu и храните их в ./generative_weights/

[Необязательно]: чтобы обучить новые генеративные веса из моделей диалога, см. Https://github.com/ctr4si/a-hierarchical-latent-ructure-for-wariational-conversation-doling.

cd bert_modelpython train.py --load_checkpoint=../generative_weights/cornell_weights.pkl --data=iemocap .cornell на ubuntu и iemocap на dailydialog для других комбинаций наборов данных.load_checkpoint , чтобы избежать инициализации контекстуальных весов.configs.pypython iemocap_preprocess.py . Точно так же для dailydialog .Пожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

Conversational transfer learning for emotion recognition. Hazarika, D., Poria, S., Zimmermann, R., & Mihalcea, R. (2020). Information Fusion.DialogeGCN (Dialoge Graph Convotortal Network) - это подход, основанный на нейронной сети графиков, к ERC. Мы используем себя и межпрояча, зависимость от собеседников для моделирования разговорного контекста для распознавания эмоций. Через графическую сеть DialogugeGCN решает проблемы распространения контекста, представленные в текущих методах RNN. DialogeGCN естественным образом подходит для многопартийных диалогов.

ПРИМЕЧАНИЕ : Geometric Pytorch делает тяжелое использование атомных операций CUDA и является источником нетерминизма. Чтобы воспроизвести результаты, представленные в статье, мы рекомендуем использовать следующую команду выполнения. Обратите внимание, что этот скрипт будет выполняться в процессоре. Мы обязывали средневзвешенные баллы F1 64,67 в нашей машине и 64,44 в Google Colaboratory для набора данных IEMOCAP со следующей командой.

python train_IEMOCAP.py --base-model 'LSTM' --graph-model --nodal-attention --dropout 0.4 --lr 0.0003 --batch-size 32 --class-weight --l2 0.0 --no-cudaПожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.Реализация Pytorch к бумаге "DialogeGCN: графическая сверточная нейронная сеть для распознавания эмоций в разговоре".

Вы можете запустить весь процесс очень легко. Возьмите, например, Corpus Iemocap:

./scripts/iemocap.sh preprocess./scripts/iemocap.sh train| - | Набор данных | Взвешен F1 |

|---|---|---|

| Оригинал | Iemocap | 64,18% |

| Эта реализация | Iemocap | 64,10% |

Миан Чжан (GitHub: Mianzhang)

Пожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

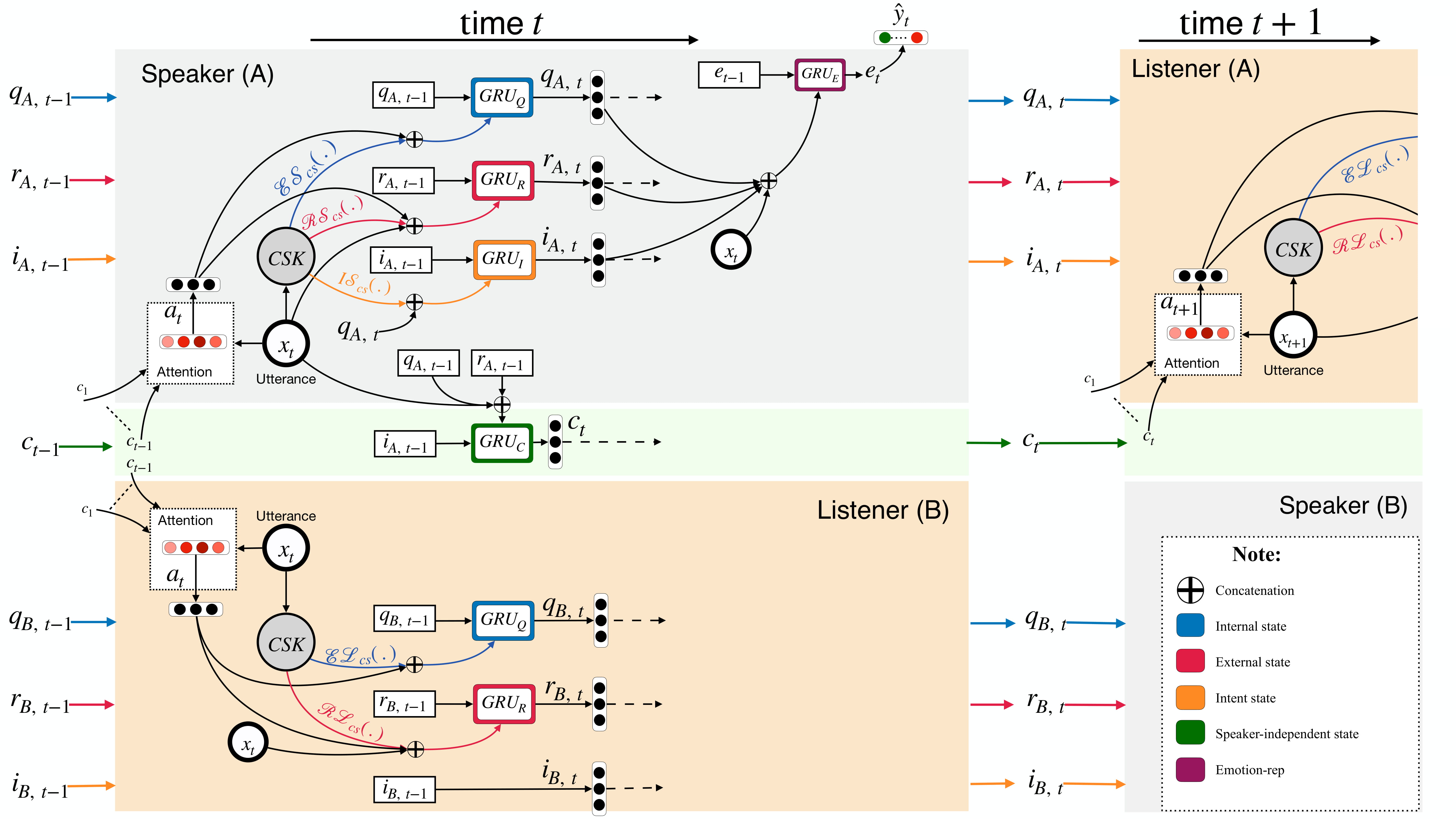

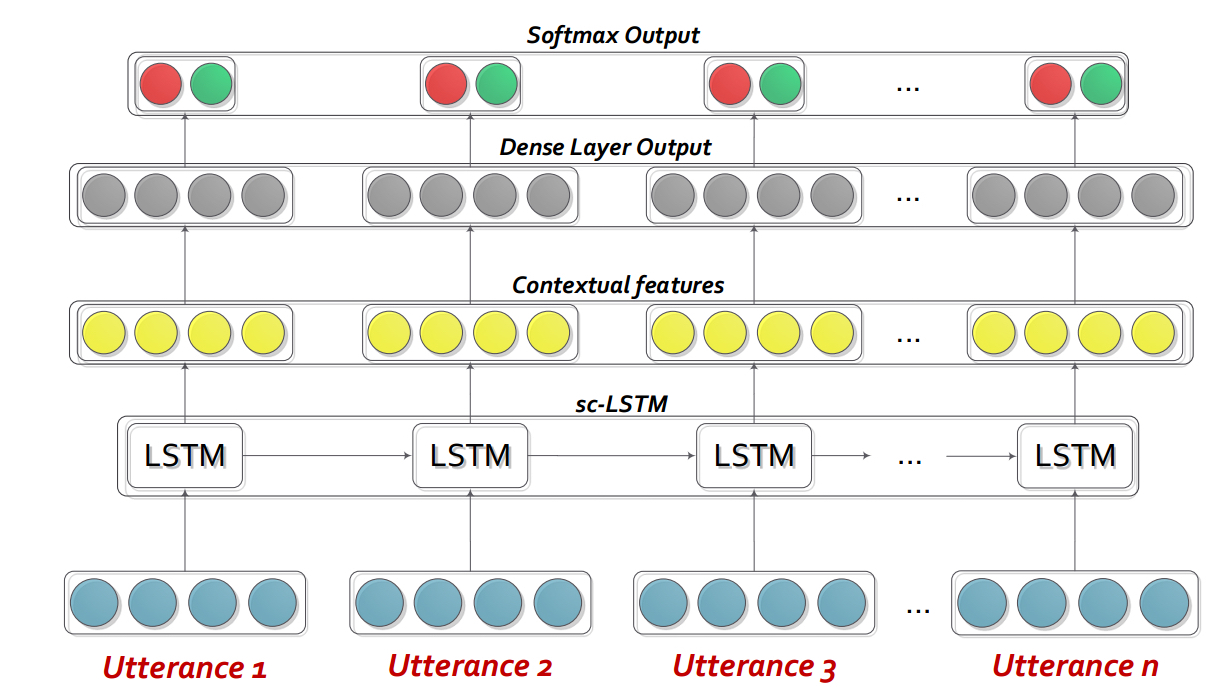

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.Dialoguernn - это в основном индивидуальная повторяющаяся нейронная сеть (RNN), которая профилирует каждого динамика в разговоре/диалоге на лету, в то время как моделирует контекст разговора одновременно. Эта модель может быть легко распространена на многопартийный сценарий. Кроме того, его можно использовать в качестве модели предварительной подготовки для сочувственного генерации диалога.

ПРИМЕЧАНИЕ . Настройки по умолчанию (гиперпараметры и аргументы командной линии) в коде предназначены для Bidialoguernn+Att. Пользователь должен оптимизировать настройки для других вариантов и изменений.

Пожалуйста, извлеките содержимое DialogueRNN_features.zip .

python train_IEMOCAP.py <command-line arguments>python train_AVEC.py <command-line arguments>--no-cuda : не использует графический процессор--lr : скорость обучения--l2 : вес регуляризации L2--rec-dropout : повторяющийся отсек--dropout : выбросит--batch-size : размер партии--epochs : количество эпох--class-weight : вес класса (не применимо к AVEC)--active-listener : явный режим Lisnener--attention : тип внимания--tensorboard : включает журнал Tensorboard--attribute : атрибут от 1 до 4 (только для avec; 1 = валентность, 2 = активация/возбуждение, 3 = ожидание/ожидание, 4 = власть)Пожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

DialogueRNN: An Attentive RNN for Emotion Detection in Conversations. N. Majumder, S. Poria, D. Hazarika, R. Mihalcea, E. Cambria, and G. Alexander. AAAI (2019), Honolulu, Hawaii, USAИнтерактивная сеть разговорной памяти (ICON)-это мультимодальная структура обнаружения эмоций, которая извлекает мультимодальные функции из разговорных видеороликов и иерархически моделирует textIt {self} и textIt {Inter-Speaker} эмоциональные влияния в глобальные воспоминания. Такие воспоминания генерируют контекстуальные резюме, которые помогают предсказать эмоциональную ориентацию высказывания.

cd ICON

Разанизируйте данные следующим образом:

/ICON/IEMOCAP/data/ . Пример команды для достижения этого: unzip {path_to_zip_file} -d ./IEMOCAP/Обучить модель значка:

python train_iemocap.py для iemocapICON: Interactive Conversational Memory Networkfor Multimodal Emotion Detection. D. Hazarika, S. Poria, R. Mihalcea, E. Cambria, and R. Zimmermann. EMNLP (2018), Brussels, Belgium CMN - это нейронная рамка для обнаружения эмоций в диадических разговорах. Он использует Mutlimodal Signals из текста, аудио и визуальных методов. Он специфически включает в себя зависимости, специфичные для оратора, в свою архитектуру для контекстного моделирования. Затем из этого контекста генерируются резюме с использованием сетей памяти с несколькими хопами.

cd CMN

Разанизируйте данные следующим образом:

/CMN/IEMOCAP/data/ . Пример команды для достижения этого: unzip {path_to_zip_file} -d ./IEMOCAP/Обучить модель значка:

python train_iemocap.py для iemocapПожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

Hazarika, D., Poria, S., Zadeh, A., Cambria, E., Morency, L.P. and Zimmermann, R., 2018. Conversational Memory Network for Emotion Recognition in Dyadic Dialogue Videos. In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers) (Vol. 1, pp. 2122-2132).BC-LSTM-Pytorch -это сеть для использования контекста для обнаружения эмоций высказывания в диалоге. Модель проста, но эффективна, которая использует только LSTM для моделирования временной связи между высказываниями. В этом репо мы дали данные о Semeval 2019 Задаче 3. Мы использовали и предоставили данные, опубликованные Semeval 2019 Task 3 - «Распознавание эмоций в контексте» организаторы. В этой задаче было предоставлено только 3 высказывания - высказывание1 (user1), shirtance2 (user2), высказывание3 (пользователь1) последовательно. Задача состоит в том, чтобы предсказать эмоциональный ярлык высказывания3. Эмоциональный ярлык каждого высказывания не была предоставлена. Однако, если ваши данные содержит метку эмоций каждого высказывания, вы все равно можете использовать этот код и соответствующим образом адаптировать его. Следовательно, этот код по-прежнему подходит для наборов данных, таких как MOSI, Mosei, IEMOCAP, AVEC, DailyDialogue и т. Д. BC-LSTM не использует информацию о динамике, такую как CMN, значок и диалог.

cd bc-LSTM-pytorch

Обучить модель BC-LSTM:

python train_IEMOCAP.py для iemocapПожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).Керас реализация BC-LSTM .

cd bc-LSTM

Обучить модель BC-LSTM:

python baseline.py -config testBaseline.config для iemocapПожалуйста, цитируйте следующую статью, если вы найдете этот код полезным в своей работе.

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).Этот репозиторий также содержит реализации различных архитектур для выявления эмоций в разговорах.

| Модель | eMO_F1 | pos_f1 | neg_f1 | macro_avg |

|---|---|---|---|---|

| ECPE-2D Cross_road (0 преобразование слой) | 52,76 | 52,39 | 95,86 | 73,62 |

| Ecpe-2d window_condessed (1 слой преобразования) | 70.48 | 48.80 | 93,85 | 71.32 |

| ECPE-2D Cross_road (2 преобразования слой) | 52,76 | 55,50 | 94,96 | 75,23 |

| Ecpe-mll | - | 48.48 | 94,68 | 71.58 |

| Ранжировать эмоции причина | - | 33,00 | 97.30 | 65,15 |

| Роберта-баз | - | 64,28 | 88.74 | 76.51 |

| Роберта-Ларж | - | 66.23 | 87.89 | 77.06 |

Цитация: Пожалуйста, цитируйте следующие документы, если вы используете этот код.

Цитация: Пожалуйста, цитируйте следующие документы, если вы используете этот код.

Цитация: Пожалуйста, цитируйте следующие документы, если вы используете этот код.

Базовые линии Роберты и Спанберта, как объяснены в оригинальной бумаге Reccon. См. Это.

Цитация: Пожалуйста, цитируйте следующие документы, если вы используете этот код.