For those enquiring about how to extract visual and audio features, please check this out: https://github.com/soujanyaporia/MUStARD

| 날짜 | 공지 사항 |

|---|---|

| 10/03/2024 | IQ 테스트 LLM에 관심이 있으시면 새로운 작업을 확인하십시오 : AlgopuzzleVQA |

| 03/08/2021 | ? ? 우리는 대화에서 유머 인식을위한 새로운 데이터 세트 M2H2 : Multimodal Multiparty Hindi 데이터 세트를 출시했습니다. 확인 : M2H2. M2H2 데이터 세트의 기준은 DialogUernn 및 BCLSTM을 기반으로 작성됩니다. |

| 18/05/2021 | ? ? 우리는 대화에서 감정 원인 인식의 문제를 해결하기 위해 새로운 리포지토리가 포함 된 모델을 발표했습니다. 확인하십시오 : 감정-원인-추출. 이것을 편집 한 Pengfei Hong에게 감사드립니다. |

| 24/12/2020 | ? ? 대화에서 감정의 원인을 인식하는 주제에 관심이 있습니까? 우리는 이것을 위해 데이터 세트를 방금 출시했습니다. https://github.com/declare-lab/reccon으로 가십시오. |

| 06/10/2020 | ? ? 대화에서 감정 인식에 새로운 논문과 소타. 코드의 디렉토리 우주를 참조하십시오. 논문을 읽으십시오 - 우주 : 대화에서 감정 식별을위한 상식 지식. |

| 30/09/2020 | 발화 수준의 대화 이해의 새로운 논문과 기준이 발표되었습니다. 우리의 논문 발화 수준의 대화 이해 : 경험적 연구를 읽으십시오. 코드를 포크하십시오. |

| 26/07/2020 | 새로운 DialogueGCN 코드가 출시되었습니다. https://github.com/declare-lab/conv-emotion/tree/master/dialoguegcn-mianzhang을 방문하십시오. 모든 크레딧은 Mian Zhang (https://github.com/mianzhang/)에게 전달됩니다. |

| 11/07/2020 | ERC에 대한 논문을 읽거나 대화에서 풍자 탐지와 같은 관련 작업에 관심이 있으십니까? 우리는 종이에 대한 포괄적 인 독서 목록을 작성했습니다. https://github.com/declare-lab/awesome-emotion-recenition-in-conversations를 방문하십시오 |

| 07/06/2020 : | ERC 작업에 대한 새로운 최첨단 결과가 곧 발표 될 예정입니다. |

| 07/06/2020 : | Conv-Emotion Repo는 https://github.com/declare-lab/에서 유지됩니다. |

| 22/12/2019 : | DialogueGCN 코드가 공개되었습니다. |

| 11/10/2019 : | 새로운 논문 : 감정 인식을위한 대화 전이 학습. |

| 09/08/2019 : | 대화에서 감정 인식에 관한 새로운 논문 (ERC). |

| 06/03/2019 : | MELD 데이터 세트에서 DialogUernn을 훈련시키는 기능 및 코드가 출시되었습니다. |

| 20/11/2018 : | 아이콘과 대화식의 엔드 투 엔드 버전이 출시되었습니다. |

Cosmic 은이 Repo에서 가장 성능이 좋은 모델이며 아래 링크를 방문하여 다른 ERC 데이터 세트의 모델을 비교하십시오.

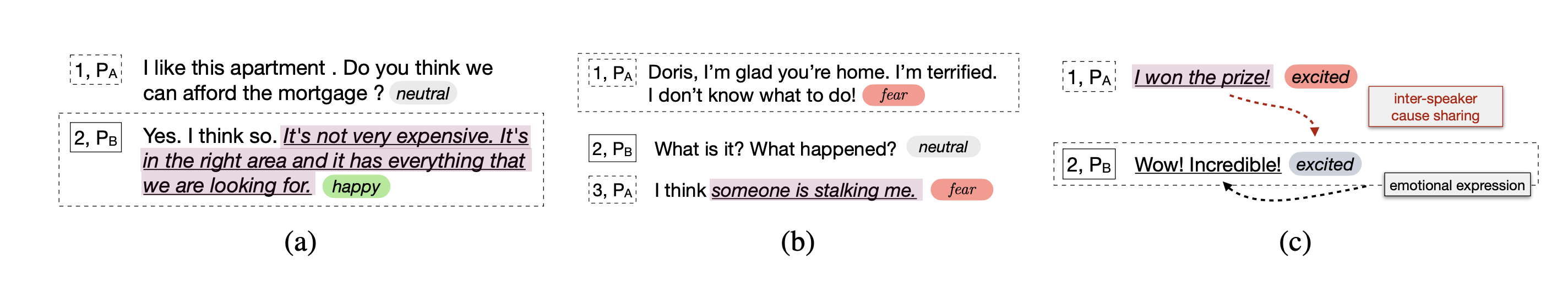

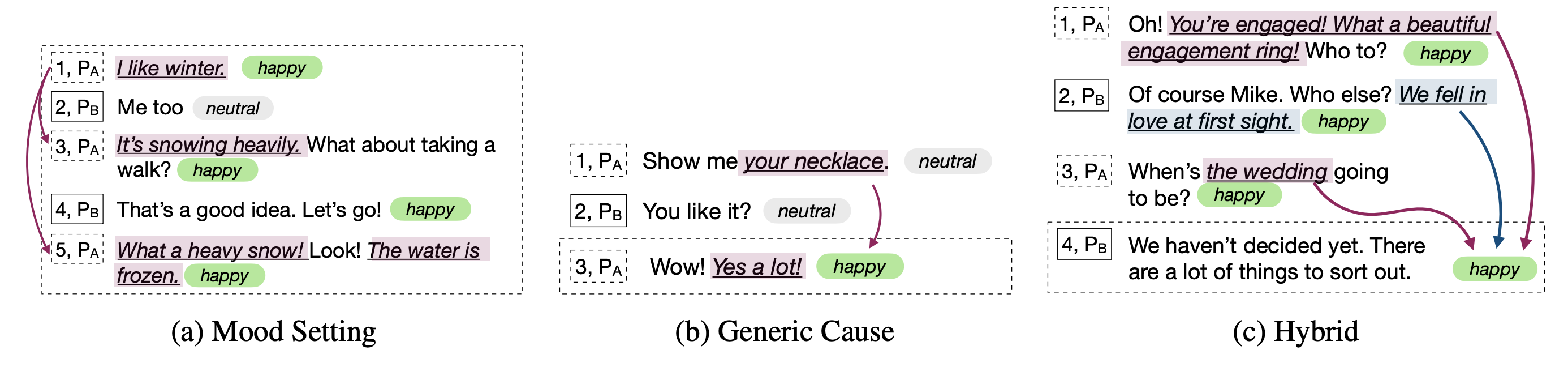

이 저장소에는 대화에서 여러 감정 인식을위한 구현과 대화에서 감정 원인을 인식하기위한 알고리즘이 포함되어 있습니다.

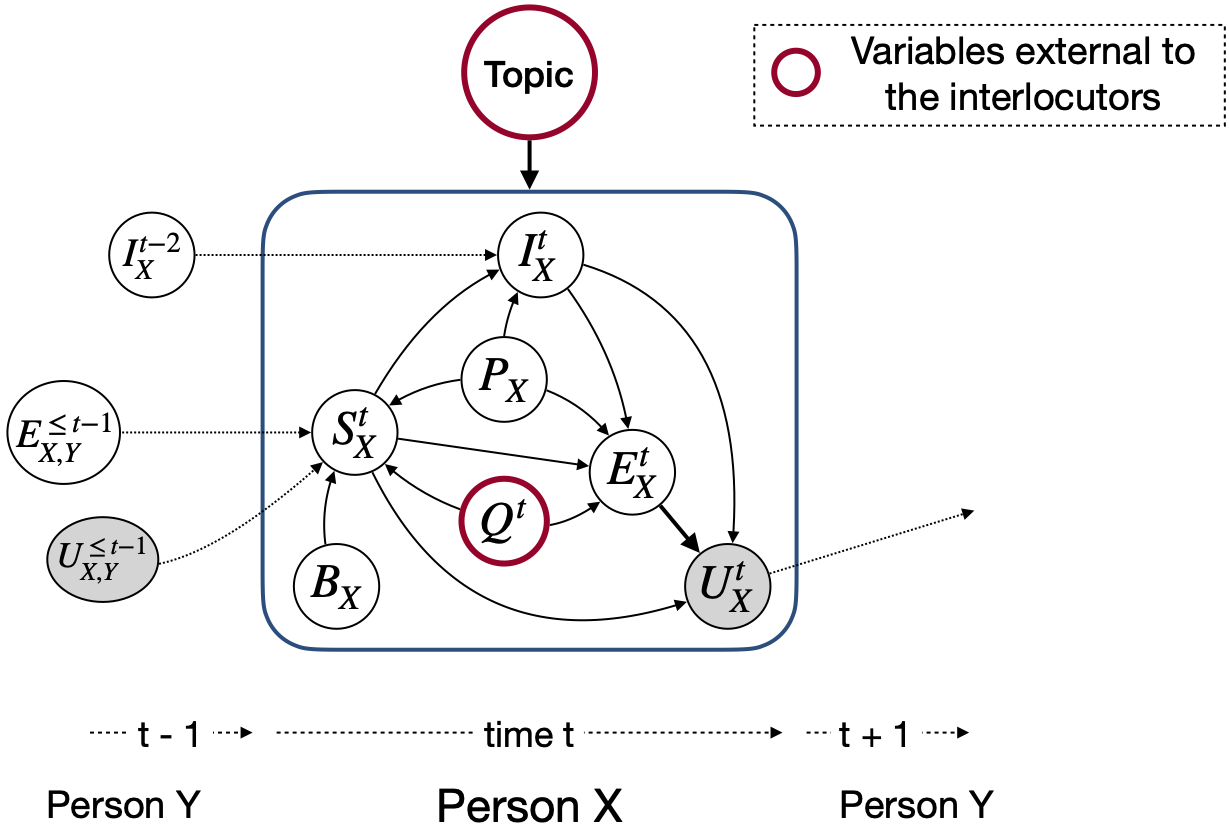

다른 감정 탐지 모델과 달리, 이러한 기술은 감정 인식과 관련된 대화 컨텍스트를 모델링하기위한 파티 상태와 당사자의 종속성을 고려합니다. 이러한 모든 기술의 주요 목적은 공감 대화 생성을위한 감정 탐지 모델을 사전에 전하는 것입니다.

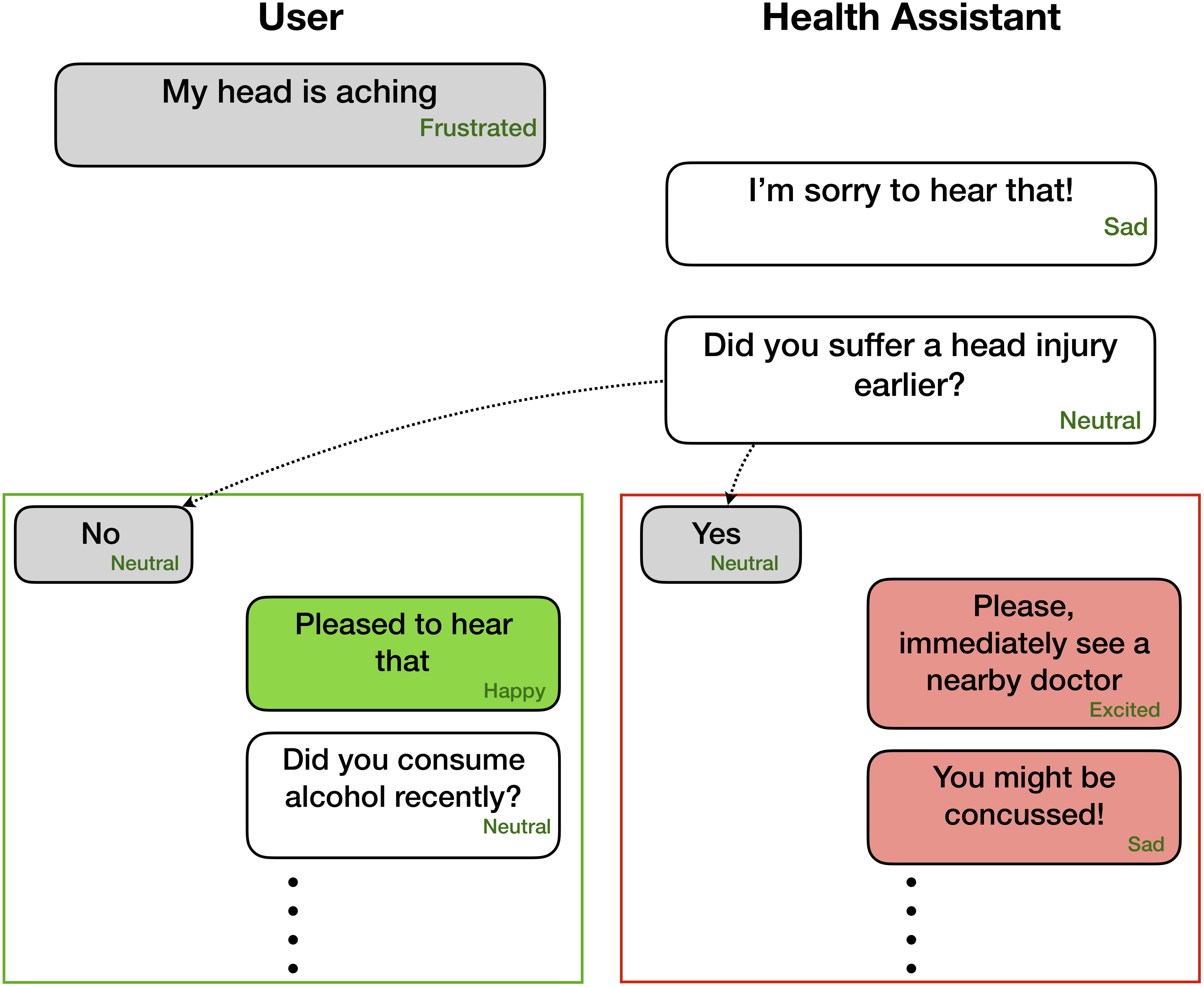

감정 인식은 공감적이고 정서적 대화 생성에 매우 유용 할 수 있습니다.

이 네트워크는 대화에있는 각 발화에 대한 감정/감정 레이블 및 스피커 정보를 기대합니다.

Party 1: I hate my girlfriend (angry)

Party 2: you got a girlfriend?! (surprise)

Party 1: yes (angry)

그러나 코드는 해당 레이블없이 선행 발화 만 사용할 수있는 작업을 수행하기 위해 경작 할 수 있습니다. 컨텍스트와 목표는 현재/대상 발화 만 레이블을 지정하는 것이기 때문입니다. 예를 들어, 컨텍스트 는입니다

Party 1: I hate my girlfriend

Party 2: you got a girlfriend?!

목표 는입니다

Party 1: yes (angry)

대상 감정이 화를내는 곳. 또한이 코드는 또한 엔드 투 엔드 방식으로 네트워크를 훈련시키기 위해 성형 될 수 있습니다. 우리는 곧 이러한 유용한 변화를 추진할 것입니다.

| 행동 양식 | IEMOCAP | DailyDialog | 멜드 | Emorynlp | |||

|---|---|---|---|---|---|---|---|

| W-AVG F1 | 매크로 F1 | 마이크로 F1 | W-AVG F1 (3-Cls) | W-AVG F1 (7-Cls) | W-AVG F1 (3-Cls) | W-AVG F1 (7-Cls) | |

| 로베르타 | 54.55 | 48.20 | 55.16 | 72.12 | 62.02 | 55.28 | 37.29 |

| Roberta Dialoguernn | 64.76 | 49.65 | 57.32 | 72.14 | 63.61 | 55.36 | 37.44 |

| Roberta Cosmic | 65.28 | 51.05 | 58.48 | 73.20 | 65.21 | 56.51 | 38.11 |

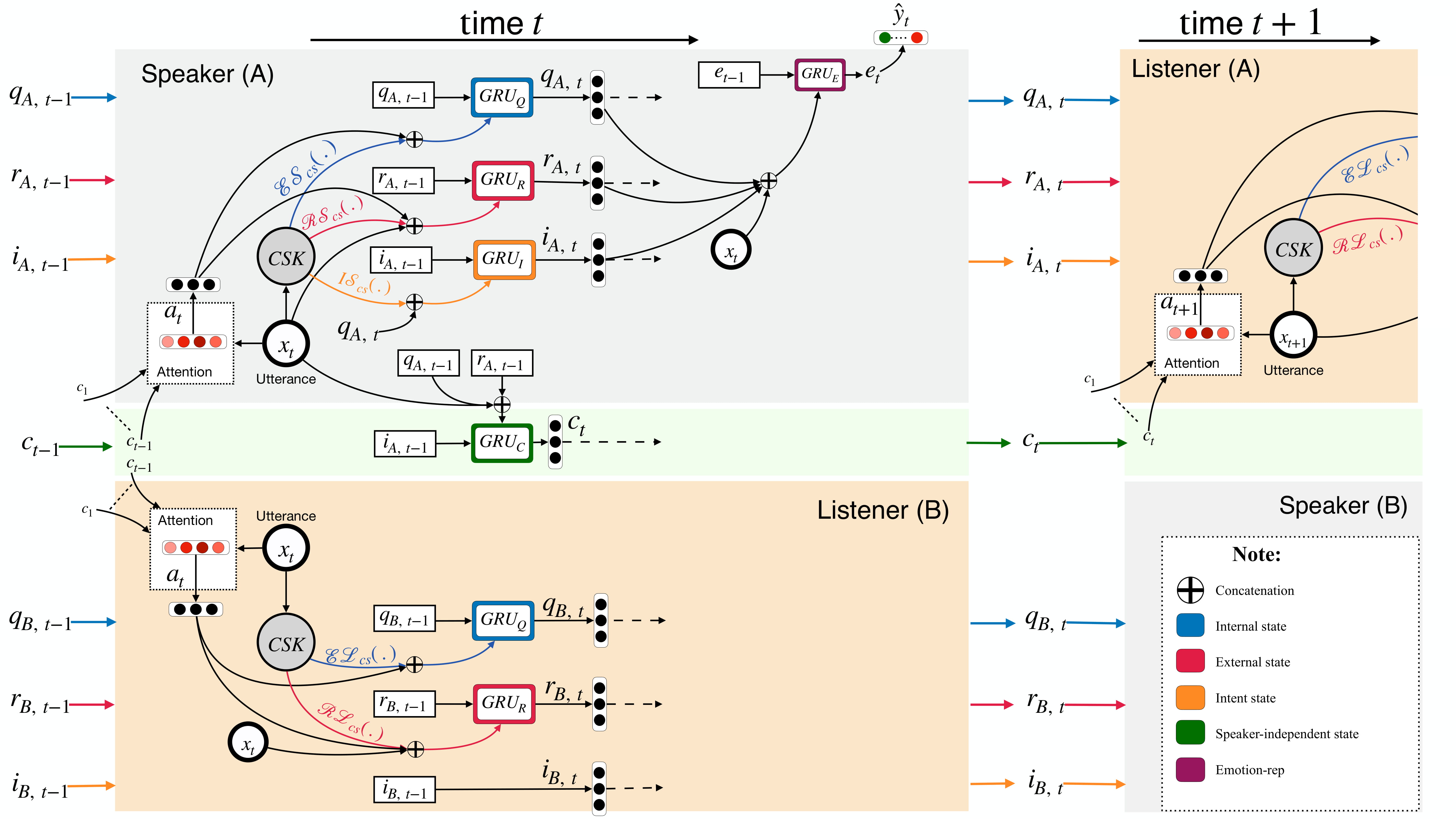

우주는 상식 지식을 사용하여 대화에서 발화 수준의 감정 인식의 과제를 다룹니다. 그것은 정신 상태, 사건 및 인과 관계와 같은 다양한 상식 요소를 통합하고 대화에 참여하는 대담 자 사이의 상호 작용을 배우는 새로운 틀입니다. 현재의 최첨단 방법은 종종 상황 전파, 감정 이동 탐지 및 관련 감정 클래스를 구별하는 데 어려움을 겪습니다. Cosmic은 독특한 상식 표현을 배우면서 이러한 과제를 해결하고 4 가지 벤치 마크 대화 데이터 세트에서 감정 인식을위한 새로운 최첨단 결과를 달성합니다.

먼저 Roberta 및 Comet 기능을 여기에서 다운로드하여 COSMIC/erc-training 의 적절한 디렉토리로 유지하십시오. 그런 다음 4 개의 데이터 세트에 대한 교육 및 평가는 다음과 같이 수행됩니다.

python train_iemocap.py --active-listenerpython train_dailydialog.py --active-listener --class-weight --residualpython train_meld.py --active-listener --attention simple --dropout 0.5 --rec_dropout 0.3 --lr 0.0001 --mode1 2 --classify emotion --mu 0 --l2 0.00003 --epochs 60python train_meld.py --active-listener --class-weight --residual --classify sentimentpython train_emorynlp.py --active-listener --class-weight --residualpython train_emorynlp.py --active-listener --class-weight --residual --classify sentiment이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

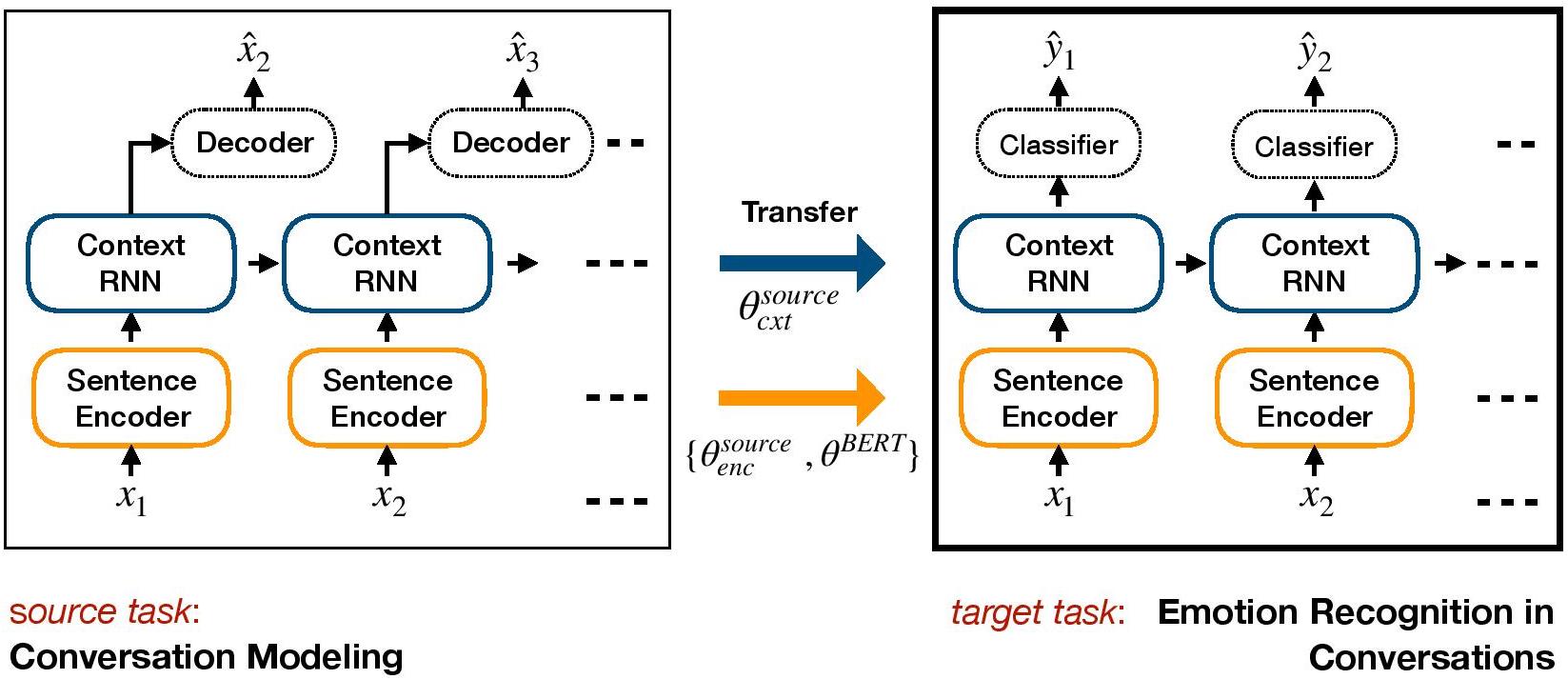

COSMIC: COmmonSense knowledge for eMotion Identification in Conversations. D. Ghosal, N. Majumder, A. Gelbukh, R. Mihalcea, & S. Poria. Findings of EMNLP 2020.TL-ERC는 ERC를위한 전송 학습 기반 프레임 워크입니다. 그것은 생성 대화 모델을 사전 훈련시키고 정서적 지식을 ERC의 목표 판별 모델에 포함시키는 컨텍스트 수준 가중치를 전송합니다.

콘다로 환경 설정 :

conda env create -f environment.yml

conda activate TL_ERC

cd TL_ERC

python setup.py 데이터 세트 파일 IEMOCAP, DailyDialog를 다운로드하여 ./datasets/ 에 저장하십시오.

Cornell 및 Ubuntu 데이터 세트에서 미리 훈련 된 Hred 중량을 다운로드하여 ./generative_weights/ 에 저장하십시오.

[선택 사항] : 대화 모델에서 새로운 생성 가중치를 훈련하려면 https://github.com/ctr4si/-hierarchical-latent-structure-for-variational-conversation-modeling을 참조하십시오.

cd bert_modelpython train.py --load_checkpoint=../generative_weights/cornell_weights.pkl --data=iemocap .cornell ubuntu 로, iemocap 다른 데이터 세트 조합에 대해 dailydialog 로 변경하십시오.load_checkpoint 드롭.configs.py 확인하십시오python iemocap_preprocess.py . dailydialog 도 마찬가지입니다.이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

Conversational transfer learning for emotion recognition. Hazarika, D., Poria, S., Zimmermann, R., & Mihalcea, R. (2020). Information Fusion.DialogueGCN (Dialogue Graph Convolutional Network)은 ERC에 대한 그래프 신경망 기반 접근법입니다. 우리는 대담 자의 자기 및 스피커 간 종속성을 활용하여 감정 인식을위한 대화 맥락을 모델링합니다. 그래프 네트워크를 통해 DialogueGCN은 현재 RNN 기반 방법에 존재하는 컨텍스트 전파 문제를 다룹니다. DialogueGCN은 자연스럽게 다자간 대화에 적합합니다.

참고 : Pytorch 기하학적 인은 Cuda Atomic 작업을 많이 사용하며 비 결정의 원천입니다. 논문에보고 된 결과를 재현하려면 다음 실행 명령을 사용하는 것이 좋습니다. 이 스크립트는 CPU에서 실행됩니다. 우리는 우리 기계에서 64.67의 가중 평균 F1 점수를, 다음 명령을 가진 IEMOCAP 데이터 세트의 Google 공동 작업에서 64.44의 순종했습니다.

python train_IEMOCAP.py --base-model 'LSTM' --graph-model --nodal-attention --dropout 0.4 --lr 0.0003 --batch-size 32 --class-weight --l2 0.0 --no-cuda이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.종이에 대한 Pytorch 구현 "DialogueGCN : 대화에서 감정 인식을위한 그래프 컨볼 루션 신경망".

전체 프로세스를 매우 쉽게 실행할 수 있습니다. 예를 들어 IEMOCAP 코퍼스를 사용하십시오.

./scripts/iemocap.sh preprocess./scripts/iemocap.sh train| - | 데이터 세트 | 가중 F1 |

|---|---|---|

| 원래의 | IEMOCAP | 64.18% |

| 이 구현 | IEMOCAP | 64.10% |

Mian Zhang (Github : Mianzhang)

이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

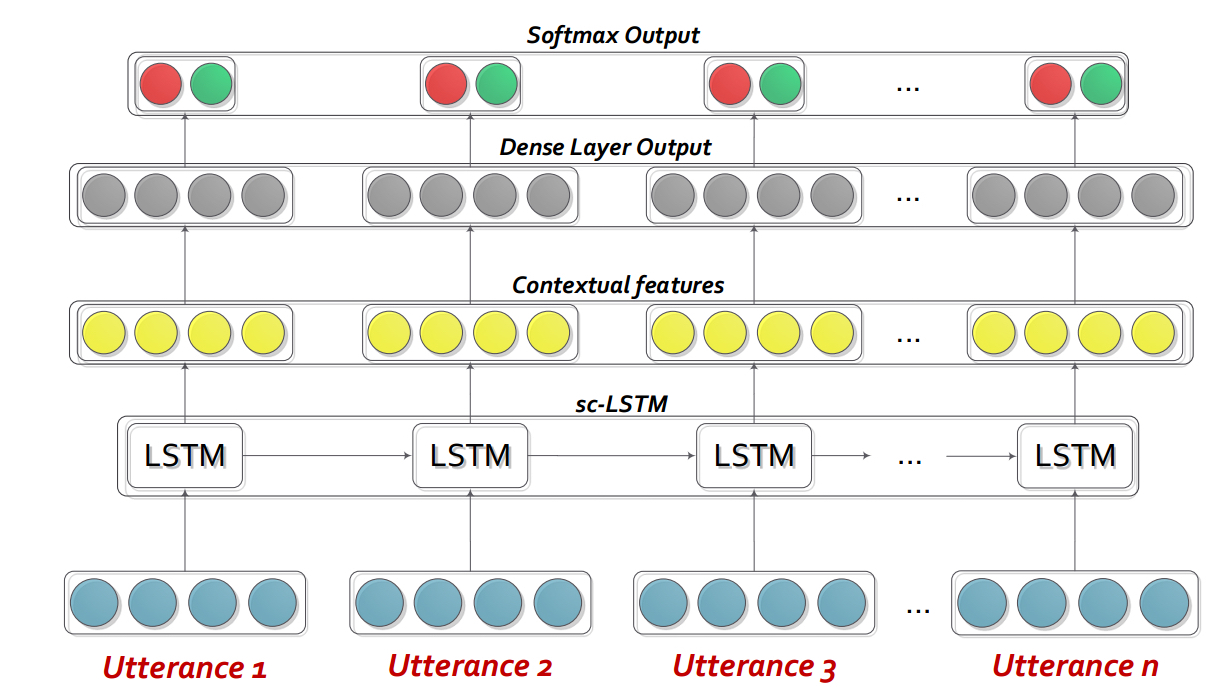

DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation. D. Ghosal, N. Majumder, S. Poria, N. Chhaya, & A. Gelbukh. EMNLP-IJCNLP (2019), Hong Kong, China.Dialoguernn 은 기본적으로 대화/대화에서 각 스피커를 즉시 프로파일 링하는 맞춤형 반복 신경 네트워크 (RNN)이며 동시에 대화의 맥락을 모델링합니다. 이 모델은 다당 시나리오로 쉽게 확장 될 수 있습니다. 또한 공감 대화 생성을위한 사전 조정 모델로 사용될 수 있습니다.

참고 : 코드의 기본 설정 (하이퍼 파라미터 및 명령 라인 인수)은 Bidialoguernn+att 용입니다. 사용자는 다른 변형 및 변경 사항에 대한 설정을 최적화해야합니다.

DialogueRNN_features.zip 의 내용을 추출하십시오.

python train_IEMOCAP.py <command-line arguments>python train_AVEC.py <command-line arguments>--no-cuda : GPU를 사용하지 않습니다--lr : 학습 속도--l2 : L2 정규화 중량--rec-dropout : 반복 드롭 아웃--dropout : 드롭 아웃--batch-size : 배치 크기--epochs : 에포크 수--class-weight : 클래스 가중치 (AVEC에 적용 할 수 없음)--active-listener : 명시 적리스 너도 모드--attention :주의 유형--tensorboard : Tensorboard 로그를 활성화합니다--attribute : 속성 1 ~ 4 (avec; 1 = 밸런스, 2 = 활성화/각성, 3 = 기대/기대, 4 = 전력)이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

DialogueRNN: An Attentive RNN for Emotion Detection in Conversations. N. Majumder, S. Poria, D. Hazarika, R. Mihalcea, E. Cambria, and G. Alexander. AAAI (2019), Honolulu, Hawaii, USA대화 형 대화 메모리 네트워크 (ICON)는 대화 비디오에서 멀티 모달 기능을 추출하고 textit {self} 및 textit {inter-speaker} 감정적 영향을 글로벌 메모리로 모델링하는 멀티 모드 감정 감지 프레임 워크입니다. 그러한 기억은 발화권의 정서적 방향을 예측하는 데 도움이되는 맥락 적 요약을 생성합니다.

cd ICON

다음과 같이 데이터를 압축 해제하십시오.

/ICON/IEMOCAP/data/ . 이를 달성하기위한 샘플 명령 : unzip {path_to_zip_file} -d ./IEMOCAP/아이콘 모델 교육 :

python train_iemocap.pyICON: Interactive Conversational Memory Networkfor Multimodal Emotion Detection. D. Hazarika, S. Poria, R. Mihalcea, E. Cambria, and R. Zimmermann. EMNLP (2018), Brussels, Belgium CMN 은 이진 대화에서 감정 탐지를위한 신경 틀입니다. 텍스트, 오디오 및 시각적 방식에서 Mutlimodal 신호를 활용합니다. 특히 컨텍스트 모델링을 위해 스피커 별 종속성을 아키텍처에 통합합니다. 그런 다음 다중 홉 메모리 네트워크를 사용 하여이 컨텍스트에서 요약이 생성됩니다.

cd CMN

다음과 같이 데이터를 압축 해제하십시오.

/CMN/IEMOCAP/data/ . 이를 달성하기위한 샘플 명령 : unzip {path_to_zip_file} -d ./IEMOCAP/아이콘 모델 교육 :

python train_iemocap.py이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

Hazarika, D., Poria, S., Zadeh, A., Cambria, E., Morency, L.P. and Zimmermann, R., 2018. Conversational Memory Network for Emotion Recognition in Dyadic Dialogue Videos. In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers) (Vol. 1, pp. 2122-2132).BC-LSTM-PYTORCH 는 대화에서 발화의 감정을 탐지하기 위해 컨텍스트를 사용하기위한 네트워크입니다. 이 모델은 단순하지만 효율적이며 LSTM을 사용하여 발화 간의 시간 관계를 모델링합니다. 이 저장소에서 우리는 Semeval 2019 Task 3의 데이터를 제공했습니다. 우리는 Semeval 2019 Task 3- "컨텍스트에서 감정 인식"주최자가 발표 한 데이터를 사용하고 제공했습니다. 이 작업에서는 Utterance1 (User1), Unterance2 (user2), Utterance3 (User1) 연속적인 3 개의 발화 만 제공되었습니다. 작업은 발화의 감정 레이블을 예측하는 것입니다 3. 각 발화의 감정 레이블은 제공되지 않았습니다. 그러나 데이터에 각 발화의 감정 레이블이 포함되어 있다면이 코드를 사용하여 그에 따라 적응할 수 있습니다. 따라서이 코드는 여전히 MOSI, Mosei, IEMOCAP, AVEC, DailyDialogue 등과 같은 데이터 세트에 대해 여전히 제거 할 수 있습니다.

cd bc-LSTM-pytorch

BC-LSTM 모델 교육 :

python train_IEMOCAP.py이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).BC-LSTM 의 Keras 구현.

cd bc-LSTM

BC-LSTM 모델 교육 :

python baseline.py -config testBaseline.config for IEMOCap이 코드가 작업에 유용하다고 생각되면 다음 논문을 인용하십시오.

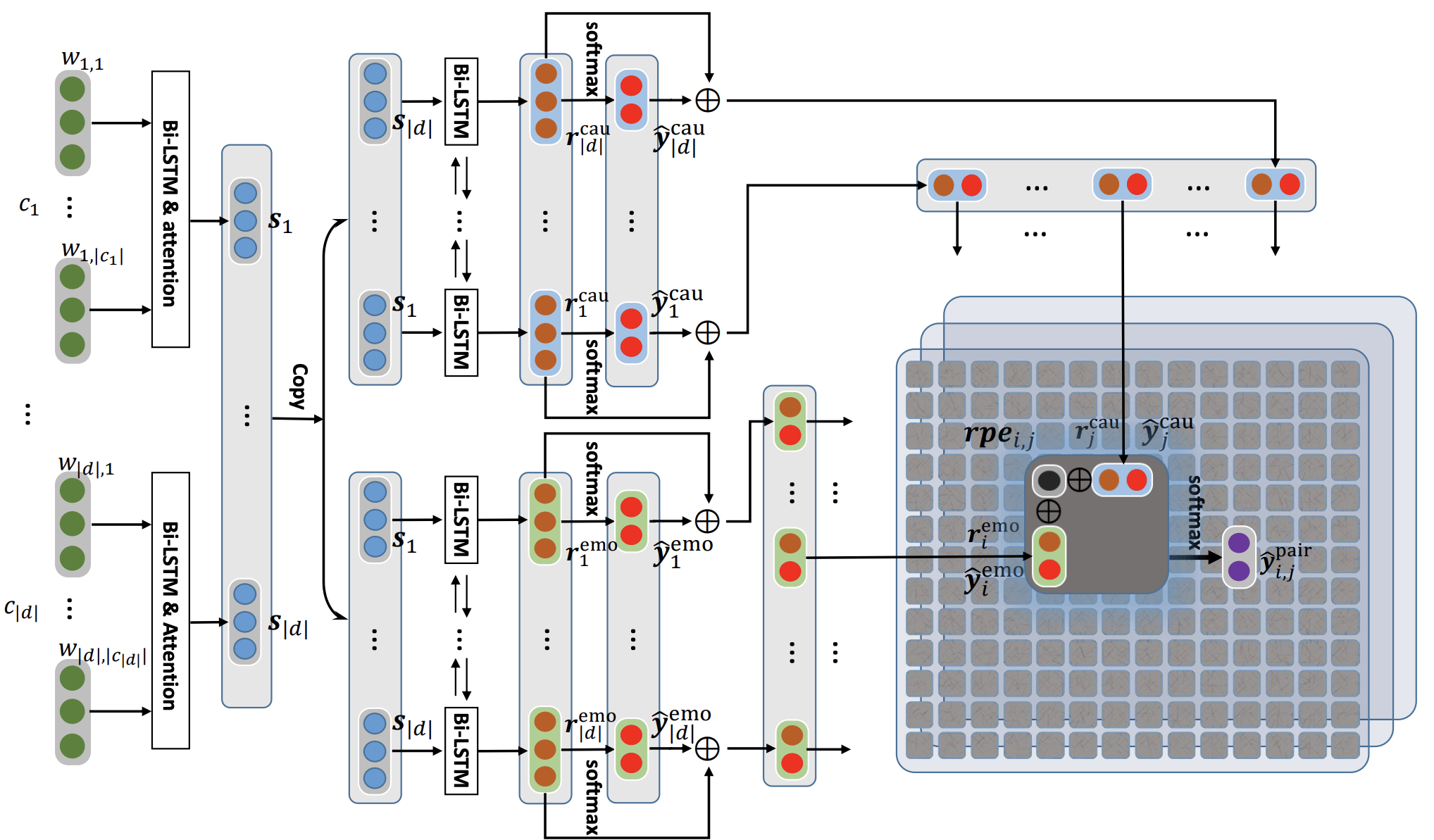

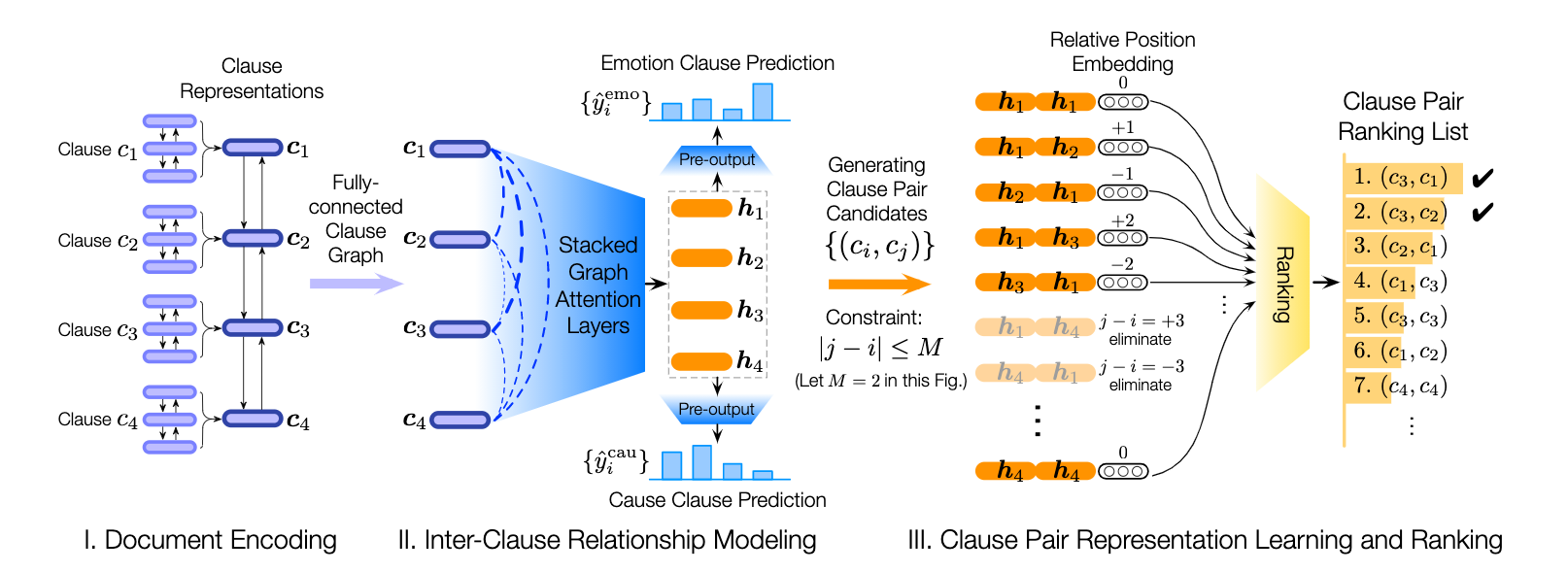

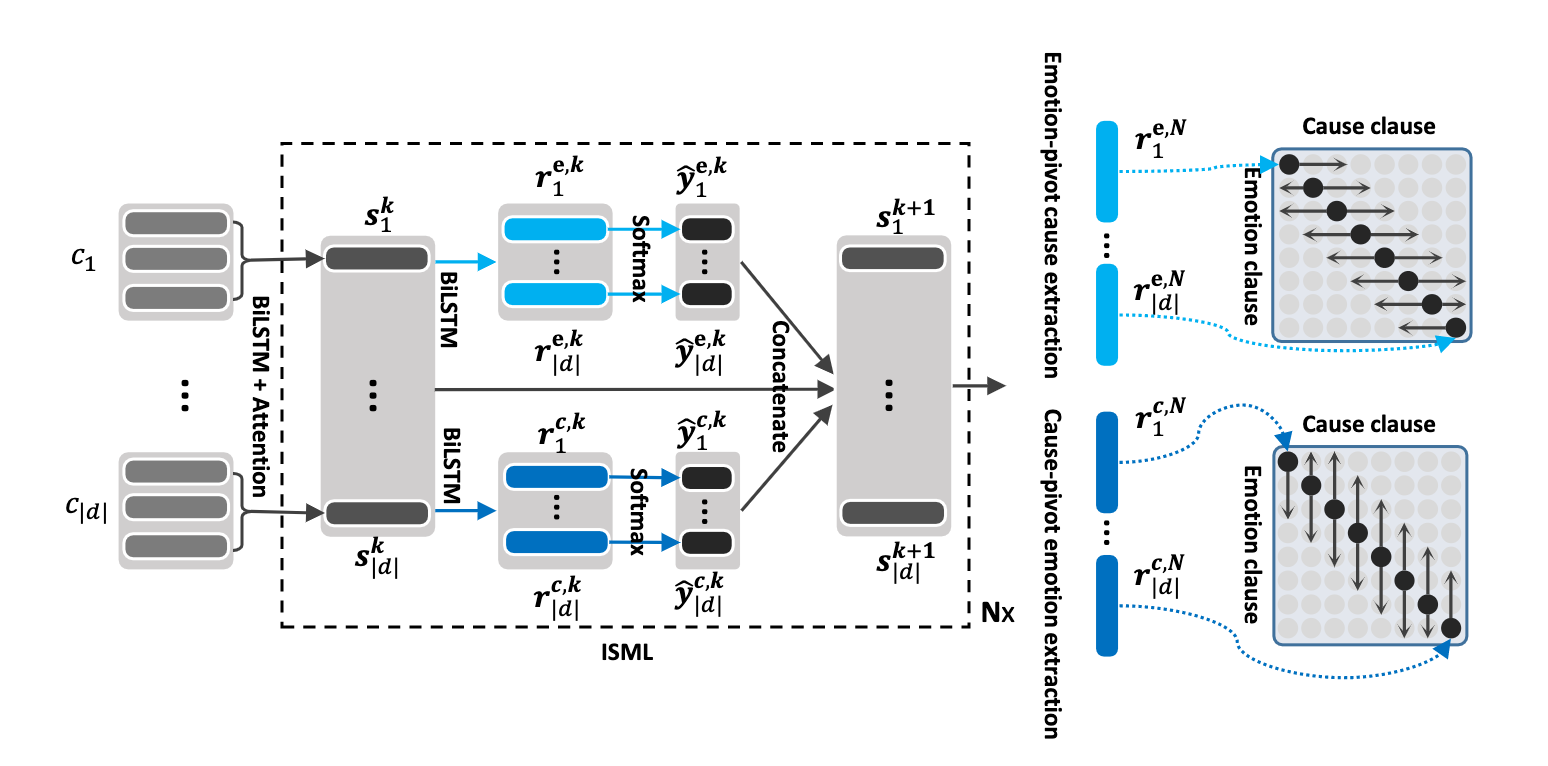

Poria, S., Cambria, E., Hazarika, D., Majumder, N., Zadeh, A. and Morency, L.P., 2017. Context-dependent sentiment analysis in user-generated videos. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers) (Vol. 1, pp. 873-883).이 저장소에는 대화의 감정 원인을 감지하기위한 다양한 아키텍처의 구현도 포함되어 있습니다.

| 모델 | EMO_F1 | pos_f1 | NEG_F1 | macro_avg |

|---|---|---|---|---|

| ECPE-2D Cross_road (0 변환 레이어) | 52.76 | 52.39 | 95.86 | 73.62 |

| ecpe-2d window_constrained (1 변환 계층) | 70.48 | 48.80 | 93.85 | 71.32 |

| ECPE-2D Cross_road (2 변환 레이어) | 52.76 | 55.50 | 94.96 | 75.23 |

| ecpe-mll | - | 48.48 | 94.68 | 71.58 |

| 감정 원인 순위 | - | 33.00 | 97.30 | 65.15 |

| Roberta-Base | - | 64.28 | 88.74 | 76.51 |

| Roberta-Large | - | 66.23 | 87.89 | 77.06 |

인용 :이 코드를 사용하는 경우 다음 논문을 인용하십시오.

인용 :이 코드를 사용하는 경우 다음 논문을 인용하십시오.

인용 :이 코드를 사용하는 경우 다음 논문을 인용하십시오.

Roberta와 Spanbert Baselines는 원래 Reccon Paper에 설명 된 바와 같이. 이것을 참조하십시오.

인용 :이 코드를 사용하는 경우 다음 논문을 인용하십시오.