Yunqing Zhao * , Keshigeyan Chandrasegaran * , Milad Abdollahzadeh * , Ngai - Man Cheung †

มหาวิทยาลัยเทคโนโลยีและการออกแบบสิงคโปร์

Neurips 2022, Ernest N. Morial Convention Center, New Orleans, LA, USA * การมีส่วนร่วมที่เท่าเทียมกัน

[หน้าโครงการ] [โปสเตอร์] [สไลด์] [กระดาษ]

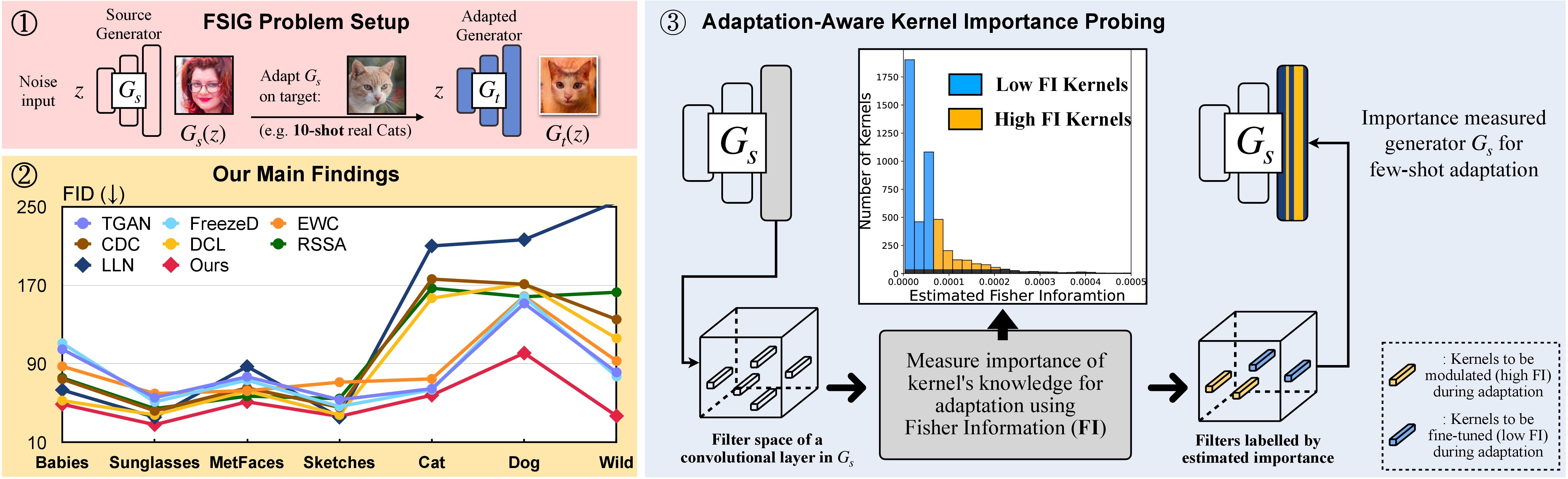

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

อีกทางเลือกหนึ่งสภาพแวดล้อมคอนดาที่เหมาะสมชื่อ adam สามารถสร้างและเปิดใช้งานได้ด้วย:

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

เราวิเคราะห์แหล่งที่มาของความสัมพันธ์โดเมนเป้าหมายในวินาที 3 (และเสริม) ดูด้านล่างสำหรับขั้นตอนที่เกี่ยวข้องในการวิเคราะห์นี้

ขั้นตอนที่ 1. git clone https://github.com/rosinality/stylegan2-pytorch.git

ขั้นตอนที่ 2. ย้าย ./visualization ถึง ./stylegan2-pytorch

ขั้นตอนที่ 3 จากนั้นอ้างถึงรหัสการสร้างภาพข้อมูลใน ./visualization visualization

เตรียมชุดข้อมูลการฝึกอบรมไม่กี่นัดโดยใช้รูปแบบ LMDB

ตัวอย่างเช่นดาวน์โหลดชุดเป้าหมาย 10-shot, Babies (ลิงก์) และ AFHQ-Cat (ลิงก์) และจัดระเบียบไดเรกทอรีของคุณดังนี้:

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

จากนั้นเปลี่ยนเป็นรูปแบบ LMDB:

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

เตรียมชุดข้อมูลเป้าหมายทั้งหมดสำหรับการประเมินผล

ตัวอย่างเช่นดาวน์โหลดชุดข้อมูลทั้งหมด Babies (ลิงก์) และ AFHQ-Cat (ลิงก์) และจัดระเบียบไดเรกทอรีของคุณดังนี้:

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

จากนั้นเปลี่ยนเป็นรูปแบบ LMDB สำหรับการประเมินผล

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

ดาวน์โหลดรุ่น GAN ที่ถูกปรับแต่งบน FFHQ จากที่นี่ จากนั้นบันทึกไปที่ ./_pretrained/style_gan_source_ffhq.pt

สร้างอินพุตสัญญาณรบกวนแบบเกาส์เซียนแบบสุ่ม (มิติเดียวกับอินพุตไปยังเครื่องกำเนิด) สำหรับการตรวจสอบความสำคัญ, บันทึกไว้ที่ ./_noise/ ::

python noise_generation.py

bash _bash_importance_probing.sh เราสามารถรับข้อมูลฟิชเชอร์โดยประมาณของเมล็ดที่มอดูเลตและจะถูกบันทึกไว้ใน ./_output_style_gan/args.exp/checkpoints/filter_fisher_g.pt และ ./_output_style_gan/args.exp/checkpoints/filter_fisher_d.pt

# you can tune hyperparameters here

bash _bash_main_adaptation.sh พลวัตการฝึกอบรมและผลการประเมินผลจะแสดงบน wandb

เราทราบว่าขั้นตอนที่ 1 และขั้นตอนที่ 2 สามารถรวมกันได้ ที่นี่เพื่อความเรียบง่ายเราใช้สองขั้นตอนเป็นการสาธิต

ใช้ทารกและ AFHQ-CAT เป็นตัวอย่าง: ดาวน์โหลดภาพจากที่นี่จากนั้นย้ายโฟลเดอร์ที่ยังไม่ได้ซิปไปยัง ./cluster_center cluster_center จากนั้นอ้างถึง Evaluator ใน AdAM_main_adaptation.py

ข้อมูลฟิชเชอร์โดยประมาณ (เช่นผลลัพธ์ของการตรวจสอบความสำคัญ) และน้ำหนัก (เช่นเอาต์พุตของการปรับตัวหลักที่สอดคล้องกับรูปที่ 4 ในกระดาษหลัก) สามารถพบได้ที่นี่

เราให้ภาพและรุ่นเป้าหมายทั้งหมด 10 นัดที่ใช้ในบทความหลักและเสริม นอกจากนี้คุณยังสามารถปรับให้เข้ากับภาพอื่น ๆ ที่เลือกด้วยตัวเอง

แหล่งที่มา:

ตัวอย่างเป้าหมาย: ลิงก์

ทำตามส่วนการทดลองใน repo นี้และคุณสามารถสร้างผลลัพธ์ที่กำหนดเองของคุณ

หากคุณพบว่าโครงการนี้มีประโยชน์ในการวิจัยของคุณโปรดพิจารณาอ้างถึงบทความของเรา:

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

ในขณะเดียวกันเรายังแสดงให้เห็นถึงการวิจัยที่เกี่ยวข้องซึ่งมีจุดมุ่งหมายเพื่อระบุและลบความรู้ที่เข้ากันไม่ได้ (Rick, CVPR-20123) สำหรับการสร้างภาพไม่กี่ภาพ:

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

เราขอขอบคุณการใช้งานพื้นฐานที่ยอดเยี่ยมของ Stylegan-V2 จาก @rosinality เราขอขอบคุณ @mseitzer, @ojha และ @richzhang สำหรับการใช้งานของพวกเขาในคะแนน FID และ intra-lpips

นอกจากนี้เรายังขอขอบคุณสำหรับเครื่องมือการฝึกอบรมและการประเมินผลที่เป็นประโยชน์ที่ใช้ในงานนี้จาก @MiaOyun