Yunqing Zhao * , Keshigeyan Chandrasegaran * , Milad Abdollahzadeh * , Ngai -Man Cheung †

싱가포르 기술 및 디자인

Neurips 2022, Ernest N. Morial Convention Center, 뉴 올리언스, LA, 미국. * 동등한 기여

[프로젝트 페이지] [포스터] [슬라이드] [종이]

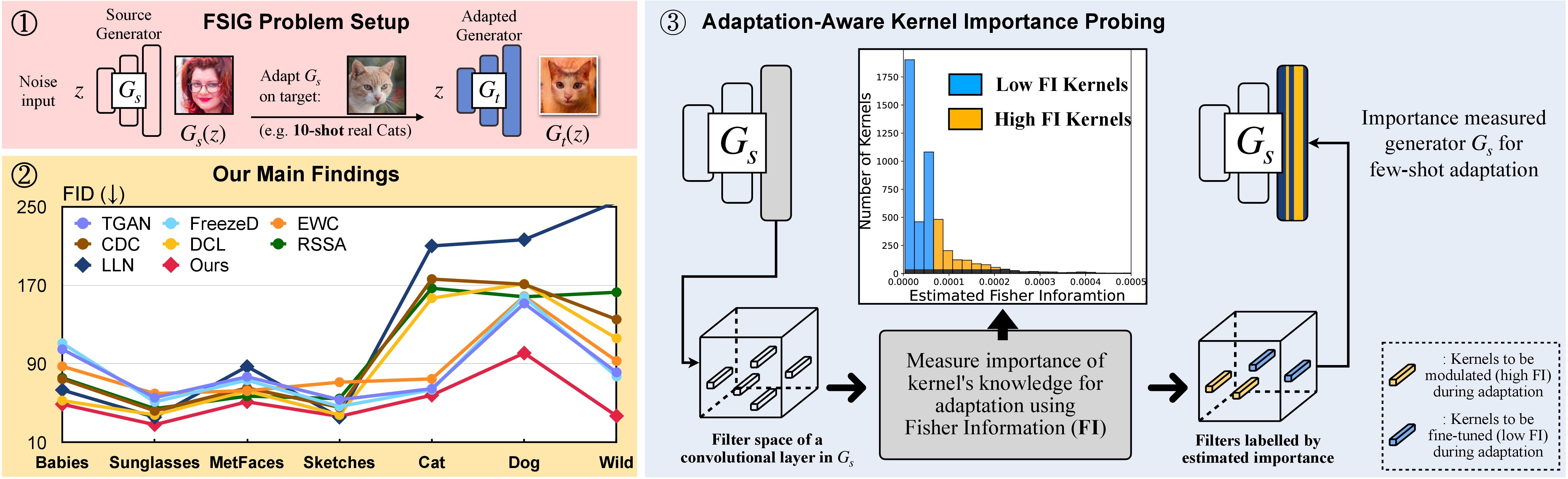

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

또는 adam 이라는 적절한 콘다 환경이 다음과 같이 만들어지고 활성화 될 수 있습니다.

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

SEC에서 소스 source 대상 도메인 관계를 분석합니다. 3 (그리고 보충). 이 분석의 관련 단계는 아래를 참조하십시오.

1 단계. git clone https://github.com/rosinality/stylegan2-pytorch.git

2 단계 ./visualization ./stylegan2-pytorch 이동합니다

3 단계. 그런 다음 ./visualization 의 시각화 코드를 참조하십시오.

LMDB 형식을 사용하여 소수의 교육 데이터 세트를 준비하십시오

예를 들어, 10 샷 대상 세트, Babies (Link) 및 AFHQ-Cat (Link)를 다운로드하고 다음과 같이 디렉토리를 구성하십시오.

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

그런 다음 LMDB 형식으로 변환합니다.

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

평가를 위해 전체 대상 데이터 세트를 준비하십시오

예를 들어, 전체 데이터 세트, Babies (링크) 및 AFHQ-Cat (링크)를 다운로드하고 다음과 같이 디렉토리를 구성하십시오.

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

그런 다음 평가를 위해 LMDB 형식으로 변환하십시오

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

여기에서 FFHQ에서 사전에 사는 GAN 모델을 다운로드하십시오. 그런 다음 ./_pretrained/style_gan_source_ffhq.pt 로 저장하십시오.

중요성 프로브를 위해 가우스 노이즈 입력 (발전기에 입력과 동일한 차원)을 무작위로 생성하고 ./_noise/ 로 저장하십시오.

python noise_generation.py

bash _bash_importance_probing.sh 우리는 변조 된 커널의 추정 피셔 정보를 얻을 수 있으며 ./_output_style_gan/args.exp/checkpoints/filter_fisher_g.pt 및 ./_output_style_gan/args.exp/checkpoints/filter_fisher_d.pt 에 저장됩니다.

# you can tune hyperparameters here

bash _bash_main_adaptation.sh wandb 에 훈련 역학 및 평가 결과가 표시됩니다.

우리는 이상적으로 1 단계와 2 단계를 함께 결합 할 수 있습니다. 여기에서 단순화를 위해 두 단계를 데모로 사용합니다.

Babies와 Afhq-Cat을 예를 들어, 여기에서 이미지를 다운로드 한 다음 압축되지 않은 폴더를 ./cluster_center 로 이동 한 다음 AdAM_main_adaptation.py 의 Evaluator 를 참조하십시오.

추정 된 Fisher 정보 (즉, 중요성 프로브의 출력) 및 가중치 (즉, 메인 논문에서 그림 4에 해당하는 주요 적응의 출력)는 여기에서 찾을 수 있습니다.

우리는 메인 용지 및 보충에 사용되는 모든 10 샷 대상 이미지 및 모델을 제공합니다. 직접 선택한 다른 이미지에 적응할 수도 있습니다.

소스 간 :

대상 샘플 : 링크

이 repo의 실험 부분을 따르면 맞춤형 결과를 생성 할 수 있습니다.

이 프로젝트가 귀하의 연구에 유용하다고 생각되면, 우리의 논문을 인용하는 것을 고려하십시오.

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

한편, 우리는 소수의 이미지 생성에 대한 양립 할 수없는 지식 (Rick, CVPR-2023)을 식별하고 제거하는 것을 목표로하는 관련 연구를 보여줍니다.

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

@Rosinality에서 Stylegan-V2의 훌륭한 기본 구현에 감사드립니다. FID 점수 및 인트라 LPIPS에 대한 구현에 대해 @Mseitzer, @Ojha 및 @Richzhang에게 감사드립니다.

또한 @Miaoyun 의이 작업에 사용 된 유용한 교육 및 평가 도구에 감사드립니다.