Yunqing Zhao * ، Keshigeyan Chandrasegaran * ، Milad Abdalahzadeh * ، Ngai -Man Cheung †

جامعة سنغافورة للتكنولوجيا والتصميم

Neurips 2022 ، مركز إرنست ن. موريال للمؤتمرات ، نيو أورليانز ، لوس أنجلوس ، الولايات المتحدة الأمريكية. * مساهمة متساوية

[صفحة المشروع] [ملصق] [شرائح] [ورقة]

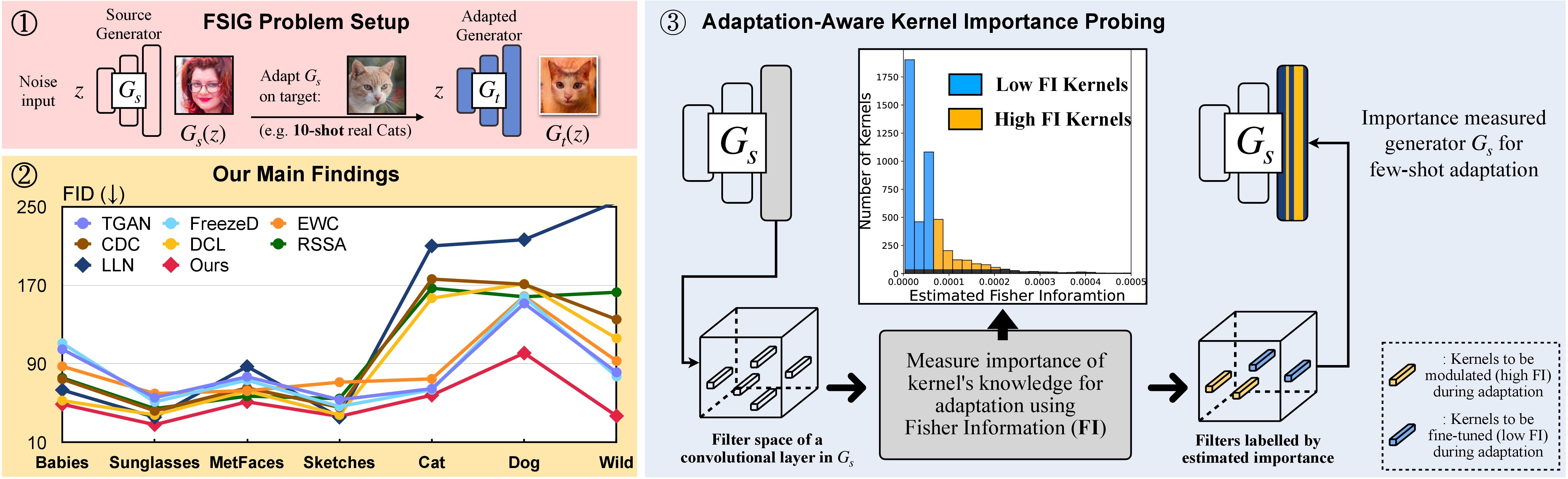

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

بدلاً من ذلك ، يمكن إنشاء بيئة كوندا مناسبة تدعى adam وتفعيلها مع:

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

نقوم بتحليل علاقة المجال المستهدف المصدر في المجلس الأعلى للتعليم. 3 (والتكميلية). انظر أدناه للحصول على الخطوات ذات الصلة في هذا التحليل.

الخطوة 1. git clone https://github.com/rosinality/stylegan2-pytorch.git

الخطوة ./stylegan2-pytorch تحرك ./visualization

الخطوة 3. ثم ، ارجع إلى رمز التصور في ./visualization .

قم بإعداد مجموعة بيانات التدريب القليلة باستخدام تنسيق LMDB

على سبيل المثال ، قم بتنزيل مجموعة الهدف 10 طلقات ، Babies (الرابط) و AFHQ-Cat (LINK) ، وقم بتنظيم دليلك على النحو التالي:

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

ثم ، التحول إلى تنسيق LMDB:

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

قم بإعداد مجموعة البيانات المستهدفة بالكامل للتقييم

على سبيل المثال ، قم بتنزيل مجموعة البيانات بالكامل ، Babies (الرابط) و AFHQ-Cat (الرابط) ، وقم بتنظيم دليلك على النحو التالي:

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

ثم ، التحويل إلى تنسيق LMDB للتقييم

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

قم بتنزيل نموذج GAN PretRied على FFHQ من هنا. ثم ، احفظه على ./_pretrained/style_gan_source_ffhq.pt .

توليد بشكل عشوائي إدخال الضوضاء الغوسية (نفس البعد مثل الإدخال إلى المولد) للتحقيق الأهمية ، احفظها على ./_noise/ :

python noise_generation.py

bash _bash_importance_probing.sh يمكننا الحصول على معلومات فيشر المقدرة من النواة المعدلة وسيتم حفظها في ./_output_style_gan/args.exp/checkpoints/filter_fisher_g.pt و ./_output_style_gan/args.exp/checkpoints/filter_fisher_d.pt

# you can tune hyperparameters here

bash _bash_main_adaptation.sh سيتم عرض ديناميات التدريب ونتائج التقييم على wandb

نلاحظ أنه من الناحية المثالية الخطوة 1. والخطوة 2. يمكن دمجها معًا. هنا ، من أجل البساطة نستخدم خطوتين كظاهرة.

استخدم Babies و AFHQ-CAT على سبيل المثال: قم بتنزيل الصور من هنا ، ثم انقل المجلد غير المصدفة إلى ./cluster_center ، ثم ارجع إلى Evaluator في AdAM_main_adaptation.py .

يمكن العثور هنا على معلومات Fisher المقدرة (أي إخراج الأهمية) والأوزان (أي إخراج التكيف الرئيسي المقابل للشكل 4 في الورقة الرئيسية).

نحن نقدم جميع الصور والموديلات المستهدفة 10 طلقات المستخدمة في الورق الرئيسي والتكميلي. يمكنك أيضًا التكيف مع الصور الأخرى التي حددها بنفسك.

المصدر جان:

العينات المستهدفة: رابط

اتبع جزء التجربة في هذا الريبو ويمكنك إنتاج نتائجك المخصصة.

إذا وجدت هذا المشروع مفيدًا في بحثك ، فيرجى التفكير في ذكر ورقتنا:

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

وفي الوقت نفسه ، نقدم أيضًا بحثًا ذا صلة يهدف إلى تحديد وإزالة المعرفة غير المتوافقة (Rick ، CVPR-2023) لتوليد صور قليلة:

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

نحن نقدر التنفيذ الأساسي الرائع لـ Stylegan-V2 من Rosinality. نشكر mseitzer و @ @ @Richzhang على تطبيقاتها على درجة FID و intra-LPIPs.

نشكر أيضًا على أداة التدريب والتقييم المفيدة المستخدمة في هذا العمل ، من Miaoyun.