Юньцин Чжао * , Кешигеян Чандрасегаран * , Милад Абдоллахзаде * , Нгай -Человек Чеунг †

Сингапурский технологический университет и дизайн

Neurips 2022, Ernest N. Morial Convention Center, Новый Орлеан, Ла, США. * Равный вклад

[Страница проекта] [плакат] [слайды] [бумага]

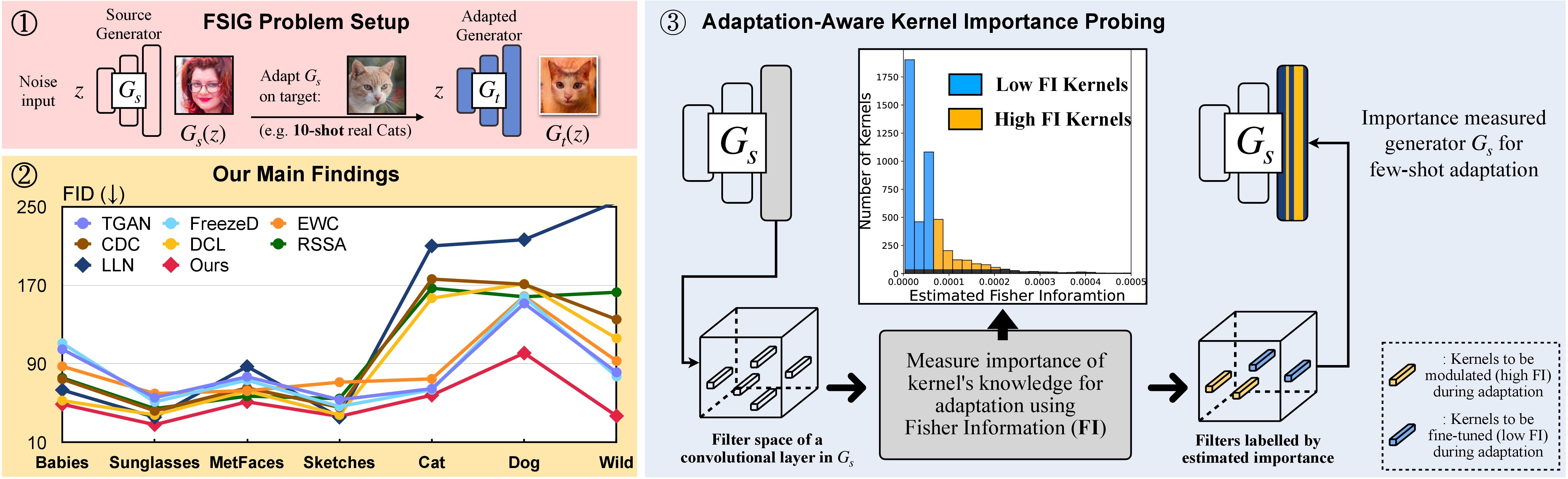

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

В качестве альтернативы, подходящая среда Conda под названием adam может быть создана и активирована с помощью:

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

Мы анализируем источник ↦ Целевое доменное отношение в гл. 3 (и дополнительная). См. Ниже для связанных этапов в этом анализе.

Шаг 1. git clone https://github.com/rosinality/stylegan2-pytorch.git

Шаг 2. Переместить ./visualization в ./stylegan2-pytorch

Шаг 3. Затем см. Код визуализации в ./visualization .

Подготовьте несколько выстрелов, используя формат LMDB

Например, загрузите набор целевого набора 10 выстрелов, Babies (ссылка) и AFHQ-Cat (ссылка) и организуйте свой каталог следующим образом:

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

Затем преобразуйте в формат LMDB:

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

Подготовьте весь целевой набор данных для оценки

Например, загрузите весь набор данных, Babies (ссылка) и AFHQ-Cat (ссылка) и организуйте свой каталог следующим образом:

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

Затем трансформируйте в формат LMDB для оценки

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

Загрузите модель GAN, предварительную на FFHQ отсюда. Затем сохраните его до ./_pretrained/style_gan_source_ffhq.pt .

Случайно генерируйте вход гауссовского шума (тот же измерение, что и вход в генератор) для значения, сохраните их до ./_noise/ :

python noise_generation.py

bash _bash_importance_probing.sh Мы можем получить предполагаемую информацию о рыбаке модулированных ядер, и она будет сохранена в ./_output_style_gan/args.exp/checkpoints/filter_fisher_g.pt и ./_output_style_gan/args.exp/checkpoints/filter_fisher_d.pt

# you can tune hyperparameters here

bash _bash_main_adaptation.sh Динамика обучения и результаты оценки будут показаны на wandb

Мы отмечаем, что в идеале шаг 1. и шаг 2. Может быть объединен вместе. Здесь для простоты мы используем два шага в качестве демонстрации.

Используйте детей и AFHQ-CAT в качестве примера: Загрузите изображения отсюда, затем переместите распадную папку в ./cluster_center , затем обратитесь к Evaluator в AdAM_main_adaptation.py .

Предполагаемая информация о Фишере (т. Е. Выходные исследования значения) и веса (то есть вывод основной адаптации, соответствующей рисунке 4 в основной статье), можно найти здесь.

Мы предоставляем все целевые изображения и модели с 10 выстрелами, используемые в нашей основной статье и дополнительные. Вы также можете адаптироваться к другим изображениям, выбранным самим.

Источник Ган:

Целевые образцы: ссылка

Следуйте экспериментальной части в этом репо, и вы можете получить свои индивидуальные результаты.

Если вы найдете этот проект полезным в своем исследовании, рассмотрите возможность ссылаться на нашу статью:

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

Между тем, мы также демонстрируем соответствующее исследование, которое направлено на выявление и удаление несовместимых знаний (RICK, CVPR-2013) для получения нескольких выстрелов:

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

Мы ценим замечательную базовую реализацию Stylegan-V2 от @rosinality. Мы благодарим @mseitzer, @ojha и @richzhang за их реализации на FID Score и Intra-LPIPS.

Мы также благодарим за полезный инструмент обучения и оценки, используемый в этой работе, от @miaoyun.