Yunqing Zhao * , Keshigeyan Chandrasegaran * , Milad Abdollahzadeh * , Ngai -Man Cheung †

Singapur Universität für Technologie und Design

Neurips 2022, Ernest N. Morial Convention Center, New Orleans, LA, USA. * Gleicher Beitrag

[Projektseite] [Poster] [Folien] [Papier]

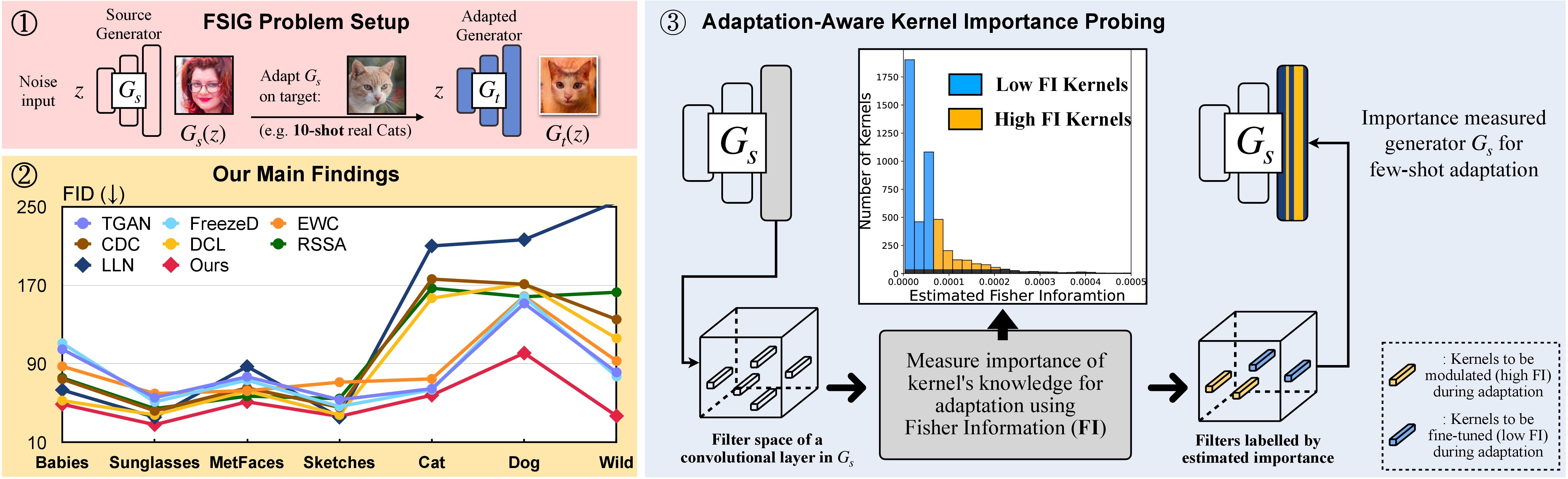

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

Alternativ kann eine geeignete Conda -Umgebung namens adam erstellt und aktiviert werden mit:

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

Wir analysieren die Quelle ↦ Zieldomänenbeziehung in der Sec. 3 (und ergänzend). In dieser Analyse finden Sie unten verwandte Schritte.

Schritt 1. git clone https://github.com/rosinality/stylegan2-pytorch.git

Schritt ./stylegan2-pytorch ./visualization

Schritt 3. Anschließend finden Sie den Visualisierungscode in ./visualization .

Bereiten Sie den wenigen Schuss-Trainingsdatensatz mit dem LMDB-Format vor

Laden Sie beispielsweise das 10-Shot-Zielsatz, Babies (Link) und AFHQ-Cat (Link) herunter und organisieren Sie Ihr Verzeichnis wie folgt:

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

Dann verwandeln Sie sich in das LMDB -Format:

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

Bereiten Sie den gesamten Zieldatensatz für die Bewertung vor

Laden Sie beispielsweise den gesamten Datensatz, Babies (Link) und AFHQ-Cat (Link) herunter und organisieren Sie Ihr Verzeichnis wie folgt:

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

Verwenden Sie dann zur Bewertung in das LMDB -Format

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

Laden Sie hier das GAN -Modell herunter, das auf FFHQ vorbereitet ist. Speichern Sie es dann auf ./_pretrained/style_gan_source_ffhq.pt .

Erzeugen Sie zufällig Gaußsche Rauscheingabe (dieselbe Dimension wie Eingabe für den Generator), um eine Wichtigkeitsuntersuchung zu erhalten, und speichern Sie sie auf ./_noise/ :

python noise_generation.py

bash _bash_importance_probing.sh We can obtain the estimated Fisher information of modulated kernels and it will be saved in ./_output_style_gan/args.exp/checkpoints/filter_fisher_g.pt and ./_output_style_gan/args.exp/checkpoints/filter_fisher_d.pt

# you can tune hyperparameters here

bash _bash_main_adaptation.sh Trainingsdynamik- und Bewertungsergebnisse werden auf wandb angezeigt

Wir stellen fest, dass, im Idealfall Schritt 1. und Schritt 2. Zusammen kombiniert werden kann. Der Einfachheit halber verwenden wir zwei Schritte als Demonstration.

Verwenden Sie Babys und AFHQ-CAT als Beispiel: Laden Sie die Bilder von hier herunter und verschieben Sie den unzippierten Ordner in ./cluster_center und beziehen Sie sich dann auf Evaluator unter AdAM_main_adaptation.py .

Die geschätzten Fischerinformationen (dh die Ausgabe von Wichtigkeitsuntersuchungen) und Gewichten (dh die Ausgabe der Hauptanpassung, die Abbildung 4 im Hauptpapier entspricht) finden Sie hier.

Wir stellen alle 10-Schuss-Zielbilder und Modelle an, die in unserem Hauptpapier und ergänzend verwendet werden. Sie können sich auch an andere von Ihnen ausgewählte Bilder anpassen.

Quelle Gan:

Zielproben: Link

Folgen Sie dem Experimententeil in diesem Repo und Sie können Ihre individuellen Ergebnisse erzielen.

Wenn Sie dieses Projekt in Ihrer Forschung nützlich finden, erwägen Sie bitte unser Papier zu zitieren:

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

In der Zwischenzeit zeigen wir auch eine relevante Forschung, die darauf abzielt, inkompatible Kenntnisse (Rick, CVPR-2023) für wenige Bildgenerierung zu identifizieren und zu entfernen:

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

Wir schätzen die wunderbare Basisimplementierung von Stylegan-V2 von @rosinality. Wir danken @mseeitzer, @ojha und @richzhang für ihre Implementierungen in FID-Score und Intra-LPIPS.

Wir danken auch für das nützliche Trainings- und Evaluierungstool, das in dieser Arbeit von @Miaoyun verwendet wird.