Yunqing Zhao * 、Keshigeyan Chandrasegaran * 、Milad Abdollahzadeh * 、Ngai ‑ Man Cheung †

シンガポール工科大学デザイン

Neurips 2022、アーネストN.モリアンコンベンションセンター、ニューオーリンズ、LA、米国。 *平等な貢献

[プロジェクトページ] [ポスター] [スライド] [紙]

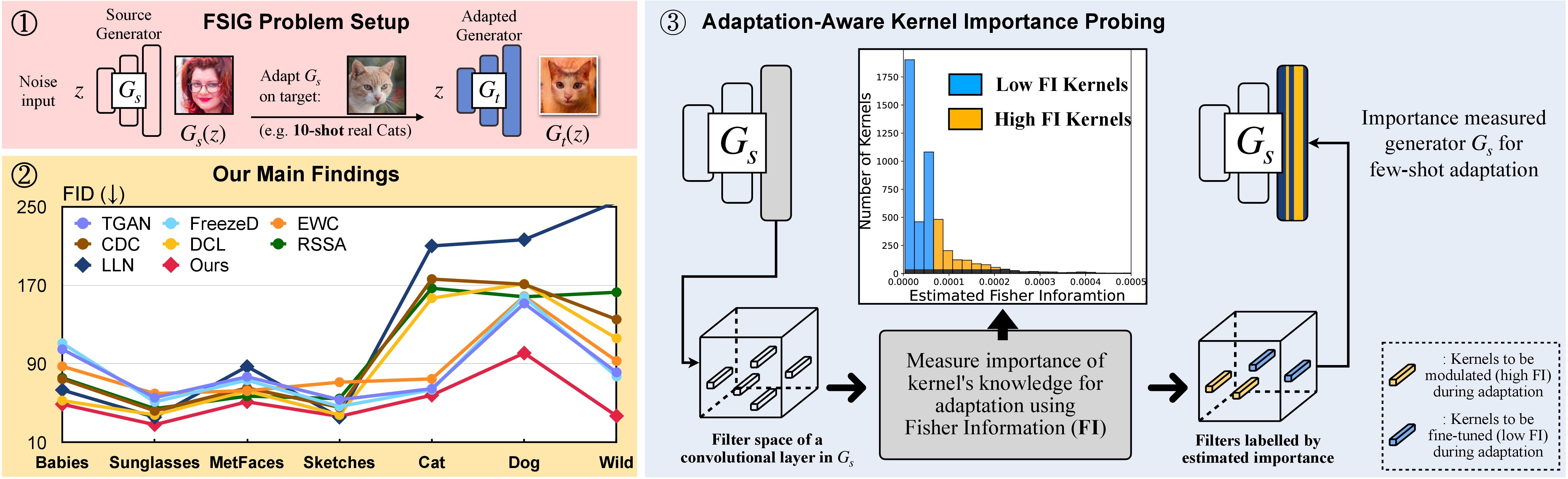

In this research, we propose Adaptation-Aware Kernel Modulation (AdAM) for few-shot image generation, that aims to identify kernels in source GAN important for target adaptation.

The model can perform GAN adaptation using very few samples from target domains with different proximity to the source.

あるいは、 adamという名前の適切なコンドラ環境を作成してアクティブにすることができます。

git clone https://github.com/yunqing-me/AdAM.git

conda env create -f environment.yml

conda activate adam

cd AdAM

SECのソース↦ターゲットドメイン関係を分析します。 3(および補足)。この分析の関連手順については、以下を参照してください。

ステップ1。GIT git clone https://github.com/rosinality/stylegan2-pytorch.git

ステップ2 ./visualizationへの移動./stylegan2-pytorch

ステップ3。次に、 ./visualization Visualizationの視覚化コードを参照してください。

LMDB形式を使用して、少数のショットトレーニングデータセットを準備します

たとえば、10ショットターゲットセット、 Babies (リンク)、 AFHQ-Cat (リンク)をダウンロードし、次のようにディレクトリを整理します。

10-shot-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-10.png

次に、LMDB形式に変換します。

python prepare_data.py --input_path [your_data_path_of_{babies/afhq_cat}] --output_path ./_processed_train/[your_lmdb_data_path_of_{babies/afhq_cat}]

評価のためにターゲットデータセット全体を準備します

たとえば、データセット、 Babies (リンク)、 AFHQ-Cat (リンク)全体をダウンロードし、次のようにディレクトリを整理します。

entire-{babies/afhq_cat}

└── images

└── image-1.png

└── image-2.png

└── ...

└── image-n.png

次に、評価のためにLMDB形式に変換します

python prepare_data.py --input_path [your_data_path_of_entire_{babies/afhq_cat}] --output_path ./_processed_test/[your_lmdb_data_path_of_entire_{babies/afhq_cat}]

ここからFFHQで事前に処理されたGANモデルをダウンロードしてください。次に、 ./_pretrained/style_gan_source_ffhq.pt style_gan_source_ffhq.ptに保存します。

重要な調査のためにガウスノイズ入力(ジェネレーターへの入力と同じ次元)をランダムに生成するには、 ./_noise/ noise/に保存します。

python noise_generation.py

bash _bash_importance_probing.sh変調されたカーネルの推定フィッシャー情報を取得することができ、それは./_output_style_gan/args.exp/checkpoints/filter_fisher_g.ptおよび./_output_style_gan/args.exp/checkpoints/filter_fisher_d.ptで保存されます。

# you can tune hyperparameters here

bash _bash_main_adaptation.shトレーニングのダイナミクスと評価の結果はwandbに表示されます

理想的にはステップ1とステップ2を組み合わせることができることに注意してください。ここでは、簡単にするために、2つのステップをデモとして使用します。

例としてBabiesとAFHQ-CATを使用します。ここから画像をダウンロードしてから、解凍されたフォルダーを./cluster_centerに移動し、 AdAM_main_adaptation.pyのEvaluatorを参照してください。

推定されたフィッシャー情報(つまり、重要性のあるプロービングの出力)と重み(つまり、メインペーパーの図4に対応する主要な適応の出力)は、ここにあります。

メインペーパーおよび補足で使用される10ショットのターゲット画像とモデルをすべて提供します。自分で選択した他の画像に適応することもできます。

ソースガン:

ターゲットサンプル:リンク

このリポジトリの実験部分に従うと、カスタマイズされた結果を作成できます。

このプロジェクトがあなたの研究で役立つと思うなら、私たちの論文を引用することを検討してください:

@inproceedings{zhao2022fewshot,

title={Few-shot Image Generation via Adaptation-Aware Kernel Modulation},

author={Yunqing Zhao and Keshigeyan Chandrasegaran and Milad Abdollahzadeh and Ngai-man Cheung},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Z5SE9PiAO4t}

}

一方、少数のショット画像生成のための互換性のない知識(Rick、CVPR-2023)を特定して削除することを目的とする関連する研究も実証します。

@inproceedings{zhao2023exploring,

title={Exploring incompatible knowledge transfer in few-shot image generation},

author={Zhao, Yunqing and Du, Chao and Abdollahzadeh, Milad and Pang, Tianyu and Lin, Min and Yan, Shuicheng and Cheung, Ngai-Man},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={7380--7391},

year={2023}

}

@rosinalityからのStylegan-V2の素晴らしい基本実装に感謝します。 @mseitzer、@ojha、 @richzhangに、FIDスコアとLPIPSの実装に感謝します。

また、この作業で使用されている有用なトレーニングおよび評価ツールの@MiaOyunからも感謝しています。