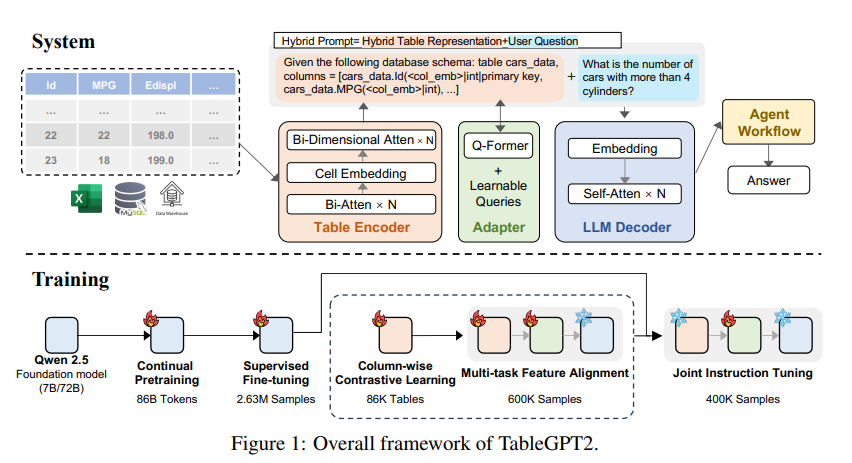

Модель крупного языка (LLM) имеет недостатки в данных обработки таблиц, и исследовательская группа Института вычислительных инноваций Университета Чжэцзян разработала модель TableGPT2 для этой цели. Эта модель обеспечивает эффективную интеграцию и обработку табличных данных, обеспечивая новые возможности для бизнес-аналитики (BI) и других приложений, управляемых данными. Основное инновация TableGPT2 заключается в его уникальном табличном кодере, который может эффективно захватить информацию о структуре и содержание ячейки таблицы и улучшить способность модели обрабатывать нечеткие запросы, отсутствующие имена столбцов и нерегулярные таблицы. Благодаря крупномасштабному предварительному обучению и тонко настраиванию, а также непрерывному предварительному обучению (CPT) и контролируемой тонкой настройке (SFT) TableGPT2 демонстрирует сильные возможности кодирования и рассуждений, которые могут выполнять сложные BI-задачи.

Рост крупных языковых моделей (LLM) революционизировал использование искусственного интеллекта, но у них есть очевидные недостатки в обработке табличных данных. Исследовательская группа из Института компьютерных инноваций Университета Чжэцзян запустила новую модель под названием TableGPT2, которая может напрямую и эффективно интегрировать и обрабатывать данные таблицы, открываясь для бизнес-аналитики (BI) и других приложений, управляемых данными.

Основным инновациями TableGPT2 является его уникальный табличный энкодер, разработанный специально для захвата структуры и содержания ячейки таблиц, тем самым улучшая способность модели обрабатывать нечеткие запросы, отсутствующие имена столбцов и нерегулярные таблицы, обычно встречающиеся в реальных приложениях. TableGPT2 основан на архитектуре QWEN2.5 и подвергается крупномасштабной предварительной тренировке и тонкой настройке, включая более 593 800 таблиц и 2,36 миллиона высококачественных платков-запросов-столе Данные в предыдущих исследованиях.

Чтобы улучшить возможности кодирования и вывода TableGPT2, исследователи провели на нем непрерывное предварительное обучение (CPT), при этом 80% данных тщательно аннотируют код, чтобы убедиться, что он обладает сильными возможностями кодирования. Кроме того, они собрали большое количество данных о рассуждениях и учебников, содержащих знания, специфичные для домена, для повышения способности модели. Окончательные данные CPT содержит 86 миллиардов строго отфильтрованных символов слова, которые предоставляют необходимые возможности кодирования и рассуждения для TableGPT2 для выполнения сложных BI -задач и других связанных задач.

Чтобы учесть ограничения TableGPT2 в адаптации к конкретным BI -задачам и сценариям, исследователи выполнили контролируемую тонкую настройку (SFT). Они построили набор данных, охватывающий различные критические и реалистичные сценарии, в том числе множество раундов разговоров, сложных рассуждений, использования инструментов и высокотехнологичных запросов. Этот набор данных объединяет ручную аннотацию и экспертный процесс автоматического аннотации, чтобы обеспечить качество и актуальность данных. В процессе SFT используется в общей сложности 2,36 млн. Образцов, дополнительно переработав модель для удовлетворения конкретных потребностей BI и других связанных с таблицей сред.

TableGPT2 также инновационно внедрила энкодер для семантической таблицы, который принимает всю таблицу в качестве входных данных для создания компактного набора векторов встраивания для каждого столбца. Эта архитектура настроена для уникальных свойств табличных данных и эффективно отражает взаимосвязь между строками и столбцами посредством двухстороннего механизма внимания и процесса извлечения иерархических признаков. Кроме того, метод столбчатого контрастного обучения используется для поощрения модели изучать значимые, с учетом структурных табличных семантических представлений.

Чтобы бесшовно интегрировать TableGPT2 с инструментами анализа данных на уровне предприятия, исследователи также разработали среду выполнения рабочего процесса агента. Структура содержит три основных компонента: инженерная инженерия времени выполнения, песочница безопасности и модуль оценки прокси, которые совместно повышают возможности и надежность прокси. Рабочий процесс поддерживает сложные задачи анализа данных с помощью модульных шагов (нормализация ввода, выполнение прокси и инструментальные вызовы), которые работают вместе для управления и мониторинга производительности прокси. Интегрируя генерацию, усиленную поиском (RAG) для эффективного извлечения контекста и кодовой песочницей для безопасного выполнения, структура гарантирует, что TableGPT2 предоставляет точную, чувствительную контекстную информацию в реальных проблемах.

Исследователи провели обширные оценки TableGPT2 в различных широко используемых таблицах и общих критериях, и результаты показывают, что TableGPT2 хорошо выполнял в понимании, обработке и рассуждениях таблицы со средним повышением производительности моделей 7 миллиардов параметров на 35,20%и 720% Средняя производительность модели параметров 100 миллионов увеличилась на 49,32%, сохраняя при этом сильную общую производительность. Для справедливой оценки они сравнивали только TableGPT2 с нейтральными моделями с открытым исходным кодом, такими как QWEN и DeepSeek, обеспечивая сбалансированную, универсальную производительность модели на различных задачах без переживания какого -либо одностолового теста. Они также представили и частично выпустили новый эталон, Realtabbench, который подчеркивает нетрадиционные таблицы, анонимные поля и сложные запросы, которые в большей степени соответствуют реальным сценариям.

Хотя TableGPT2 достиг современной работы в экспериментах, существуют проблемы при развертывании LLM в реальных средах BI. Исследователи отметили, что будущие направления исследования включают в себя:

Кодирование, специфичное для домена: позволяет LLM быстро адаптироваться к специфическому домену языку (DSL) или псевдо-коду, чтобы лучше удовлетворить конкретные потребности инфраструктуры корпоративных данных.

Многоагентный дизайн: изучите, как эффективно интегрировать несколько LLM в единую систему для обработки сложности реальных приложений.

Многофункциональная обработка таблицы: улучшает способность моделей обрабатывать нерегулярные таблицы, такие как объединенные ячейки и непоследовательные структуры, обычно встречающиеся в Excel и страницах, чтобы лучше обрабатывать табличные данные в различных формах в реальном мире.

Запуск TableGPT2 отмечает значительный прогресс в LLM в обработке данных таблицы, что обеспечивает новые возможности для бизнес-аналитики и других приложений, управляемых данными. Я считаю, что по мере того, как исследование продолжает углубляться, TableGPT2 будет играть все более важную роль в области анализа данных в будущем.

Бумажный адрес: https://arxiv.org/pdf/2411.02059v1

В целом, TableGPT2 достигла замечательных результатов в обработке данных таблицы, поскольку ее инновационная архитектура и методы обучения, которые выделяют его для нескольких критериев. Будущие направления исследований будут продолжать сосредоточиться на адаптивности и практичности моделей, чтобы лучше удовлетворить потребности реальных приложений бизнес-аналитики.