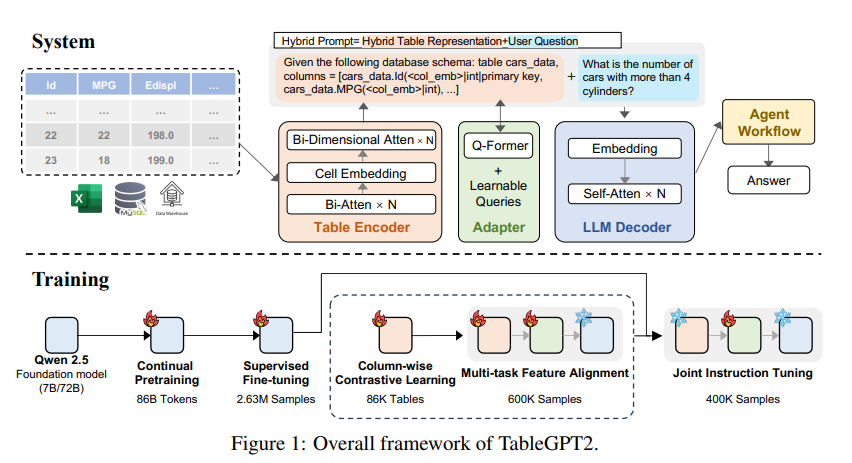

El modelo de lenguaje grande (LLM) tiene deficiencias en los datos de la tabla de procesamiento, y el equipo de investigación del Instituto de Innovación de la Computación de la Universidad de Zhejiang ha desarrollado el modelo TABLEGPT2 para este propósito. Este modelo permite la integración y el procesamiento eficientes de datos tabulares, lo que brinda nuevas posibilidades a la inteligencia empresarial (BI) y otras aplicaciones basadas en datos. La innovación central de TABLEGPT2 se encuentra en su codificador de tabla único, que puede capturar efectivamente la información de la estructura y la información de contenido celular de la tabla, y mejorar la capacidad del modelo para manejar consultas difusas, nombres de columnas faltantes y tablas irregulares. A través de la capacitación y el ajuste fino a gran escala, así como el pre-entrenamiento continuo (CPT) y el ajuste fino supervisado (SFT), TABLEGPT2 demuestra fuertes capacidades de codificación y razonamiento que pueden manejar tareas de BI complejas.

El aumento de los modelos de idiomas grandes (LLM) ha revolucionado el uso de la inteligencia artificial, pero tienen deficiencias obvias en el procesamiento de datos tabulares. El equipo de investigación del Instituto de Innovación de la Computación de la Universidad de Zhejiang ha lanzado un nuevo modelo llamado TABLEGPT2, que puede integrar y procesar directa y de manera eficiente los datos de la tabla, abriéndose para la inteligencia empresarial (BI) y otras aplicaciones basadas en datos.

La innovación central de TABLEGPT2 es su codificador de tabla único diseñado específicamente para capturar la estructura y la información de contenido celular de las tablas, mejorando así la capacidad del modelo para manejar consultas difusas, nombres de columnas faltantes y tablas irregulares que se encuentran comúnmente en aplicaciones del mundo real. TableGPT2 se basa en la arquitectura Qwen2.5 y ha sufrido un pre-entrenamiento y ajuste fino a gran escala, que implica más de 593,800 tablas y 2.36 millones de tuves de consultas de alta calidad-Table, que es una escala sin precedentes de mesa relacionada con la tabla Datos en estudios anteriores.

Para mejorar las capacidades de codificación e inferencia de TABLEGPT2, los investigadores realizaron un pre-entrenamiento continuo (CPT), con el 80% de los datos que se anotan cuidadosamente el código para garantizar que tenga fuertes capacidades de codificación. Además, recopilaron una gran cantidad de datos de razonamiento y libros de texto que contienen conocimiento específico del dominio para mejorar la capacidad de razonamiento del modelo. Los datos finales de CPT contienen 86 mil millones de símbolos de palabras estrictamente filtrados, que proporcionan las capacidades de codificación y razonamiento necesarias para TABLEPT2 para manejar tareas de BI complejas y otras tareas relacionadas.

Para abordar las limitaciones de TABLEGPT2 en la adaptación a tareas y escenarios de BI específicos, los investigadores realizaron un ajuste fino supervisado (SFT). Construyeron un conjunto de datos que cubre una variedad de escenarios críticos y realistas, incluidas múltiples rondas de conversaciones, razonamiento complejo, uso de herramientas y consultas altamente orientadas al negocio. Este conjunto de datos combina la anotación manual y el proceso de anotación automática impulsada por expertos para garantizar la calidad y relevancia de los datos. El proceso SFT utiliza un total de 2.36 millones de muestras, refinando aún más el modelo para satisfacer las necesidades específicas de BI y otros entornos relacionados con la mesa.

TABLEGPT2 también introdujo innovativamente un codificador de tabla semántica que toma la tabla completa como entrada para generar un conjunto compacto de vectores de incrustación para cada columna. Esta arquitectura está personalizada para las propiedades únicas de los datos tabulares, y captura efectivamente la relación entre filas y columnas a través de un mecanismo de atención bidireccional y un proceso de extracción de características jerárquicas. Además, se utiliza un método de aprendizaje de contraste columnar para alentar al modelo a aprender representaciones semánticas tabulares significativas y conscientes de la estructura.

Para integrar a la perfección TABLEGPT2 con herramientas de análisis de datos de nivel empresarial, los investigadores también diseñaron un marco de tiempo de ejecución de flujo de trabajo de agentes. El marco contiene tres componentes centrales: ingeniería de tiempo de ejecución, código de seguridad de código de seguridad y módulo de evaluación proxy, que mejoran conjuntamente las capacidades y la confiabilidad del proxy. El flujo de trabajo admite tareas complejas de análisis de datos a través de pasos modulares (normalización de entrada, ejecución del proxy y llamadas de herramientas) que trabajan juntas para administrar y monitorear el rendimiento del proxy. Al integrar la generación mejorada de búsqueda (RAG) para recuperación de contexto eficiente y Code Sandbox para una ejecución segura, el marco garantiza que TableGPT2 proporcione ideas precisas y sensibles al contexto en los problemas del mundo real.

Los investigadores realizaron evaluaciones extensas de TABLEGPT2 en una variedad de tablas y puntos de referencia generales ampliamente utilizados, y los resultados muestran que TABLEGPT2 funcionó bien en la comprensión, procesamiento y razonamiento de la tabla, con una mejora promedio de rendimiento de 7 mil millones de modelos de parámetros en 35.20%y 720% El rendimiento promedio del modelo de parámetros de 100 millones ha aumentado en un 49.32%, al tiempo que mantiene un fuerte rendimiento general. Para una evaluación justa, solo compararon TABLEGPT2 con modelos neutrales de referencia de código abierto como QWEN y Deepseek, asegurando el rendimiento equilibrado y versátil del modelo en una variedad de tareas sin exagerar ninguna prueba de referencia única. También presentaron y lanzaron parcialmente un nuevo punto de referencia, RealTabBench, que enfatiza las tablas no convencionales, los campos anónimos y las consultas complejas, que están más en línea con los escenarios de la vida real.

Aunque TABLEGPT2 alcanzó el rendimiento de vanguardia en los experimentos, existen desafíos en la implementación de LLM a entornos de BI del mundo real. Los investigadores señalaron que las instrucciones de investigación futuras incluyen:

Codificación específica del dominio: permite a LLM adaptarse rápidamente al lenguaje específico de dominio (DSL) específico de la empresa o un pseudocódigo para satisfacer mejor las necesidades específicas de la infraestructura de datos empresariales.

Diseño de múltiples agentes: explore cómo integrar de manera efectiva múltiples LLM en un sistema unificado para manejar la complejidad de las aplicaciones del mundo real.

Procesamiento de tabla multifuncional: mejora la capacidad de los modelos para manejar tablas irregulares, como células fusionadas y estructuras inconsistentes que se encuentran comúnmente en Excel y páginas para manejar mejor los datos tabulares en varias formas en el mundo real.

El lanzamiento de TABLEGPT2 marca un progreso significativo en LLM en los datos de procesamiento de la tabla, lo que brinda nuevas posibilidades a la inteligencia empresarial y otras aplicaciones basadas en datos. Creo que a medida que la investigación continúa profundizándose, TABLEPT2 desempeñará un papel cada vez más importante en el campo del análisis de datos en el futuro.

Dirección en papel: https://arxiv.org/pdf/2411.02059v1

En general, TABLEGPT2 ha logrado resultados notables en los datos de la tabla de procesamiento, con sus innovadores métodos de arquitectura y capacitación que se destaca en múltiples puntos de referencia. Las direcciones de investigación futuras continuarán centrándose en la adaptabilidad y la practicidad de los modelos para satisfacer mejor las necesidades de las aplicaciones de inteligencia empresarial del mundo real.