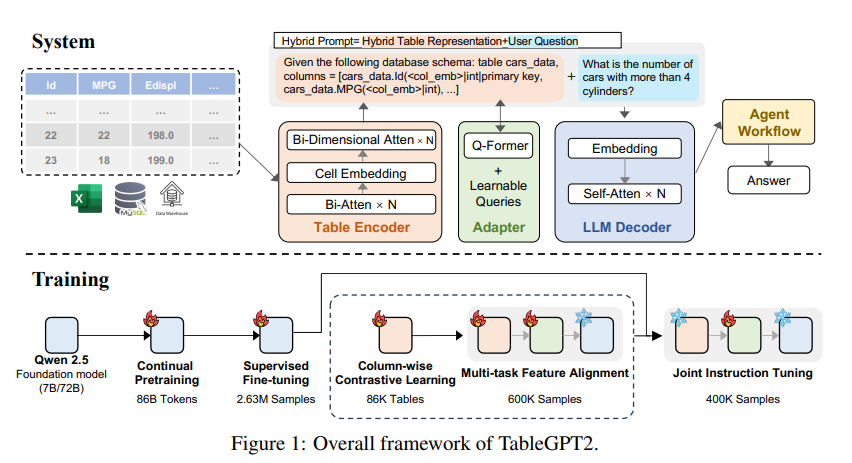

大規模な言語モデル(LLM)には、テーブルデータの処理に欠点があり、Zhejiang Universityのコンピューティングイノベーション研究所の研究チームは、この目的のためにTableGPT2モデルを開発しました。このモデルにより、表形式データの効率的な統合と処理が可能になり、ビジネスインテリジェンス(BI)およびその他のデータ駆動型アプリケーションに新しい可能性がもたらされます。 TableGPT2のコアイノベーションは、テーブルの構造情報とセルコンテンツ情報を効果的にキャプチャし、ファジークエリ、列名の欠落、不規則なテーブルを処理するモデルの能力を高めることができる独自のテーブルエンコーダーにあります。 TableGPT2は、大規模なトレーニングと微調整、および連続前トレーニング(CPT)および監視された微調整(SFT)だけでなく、複雑なBIタスクを処理できる強力なコーディングおよび推論機能を実証します。

大規模な言語モデル(LLM)の台頭は、人工知能の使用に革命をもたらしましたが、表形式データの処理に明らかな欠点があります。 Zhejiang Universityのコンピューティングイノベーション研究所の研究チームは、TableGPT2と呼ばれる新しいモデルを立ち上げました。

TableGPT2のコアイノベーションは、テーブルの構造とセルのコンテンツ情報をキャプチャするために特別に設計されているため、ファジークエリ、欠落している列名、および実際のアプリケーションで一般的に見られる不規則なテーブルが強化されています。 TableGPT2はQWEN2.5アーキテクチャに基づいており、593,800を超えるテーブルと236百万の高品質のクエリテーブル出力タプルを含む大規模な事前トレーニングと微調整を受けています。以前の研究のデータ。

TableGpt2のエンコーディングおよび推論機能を改善するために、研究者はその上で連続前トレーニング(CPT)を実施しました。データの80%は、強力なエンコーディング機能があることを確認するために慎重に注釈付きコードになりました。 さらに、モデルの推論能力を高めるために、ドメイン固有の知識を含む大量の推論データと教科書を収集しました。 最終的なCPTデータには、860億個の厳密にフィルタリングされた単語記号が含まれています。これにより、TableGPT2が複雑なBIタスクやその他の関連タスクを処理するために必要なコーディングおよび推論機能が提供されます。

特定のBIタスクとシナリオに適応する際のTableGpt2の制限に対処するために、研究者は監視された微調整(SFT)を実行しました。 彼らは、複数のラウンドの会話、複雑な推論、ツールの使用、非常にビジネス指向のクエリなど、さまざまな重要かつ現実的なシナリオをカバーするデータセットを構築しました。 このデータセットは、手動注釈と専門家主導の自動注釈プロセスを組み合わせて、データの品質と関連性を確保します。 SFTプロセスでは、合計236万サンプルを使用しており、モデルをさらに改良して、BIおよびその他のテーブル関連環境の特定のニーズを満たしています。

TableGpt2は、各列のコンパクトな埋め込みベクターのセットを生成するために入力としてテーブル全体を入力するセマンティックテーブルエンコーダーを革新的に導入しました。 このアーキテクチャは、表形式データの一意の特性に合わせてカスタマイズされ、双方向の注意メカニズムと階層特徴抽出プロセスを介して行と列の関係を効果的にキャプチャします。 さらに、カラムコントラスト学習方法を使用して、モデルが意味のある構造認識の表現表現を学習するように促します。

TableGPT2をエンタープライズレベルのデータ分析ツールとシームレスに統合するために、研究者はエージェントワークフローランタイムフレームワークも設計しました。 フレームワークには、ランタイムプロンプトエンジニアリング、セキュリティコードサンドボックス、プロキシ評価モジュールの3つのコアコンポーネントが含まれており、プロキシの機能と信頼性を共同で強化します。 ワークフローは、プロキシのパフォーマンスを管理および監視するために連携するモジュラーステップ(入力正規化、プロキシ実行、およびツールコール)を介した複雑なデータ分析タスクをサポートします。 Search-Enhanced Generation(RAG)を効率的なコンテキスト検索とコードサンドボックスの安全な実行のために統合することにより、フレームワークにより、TableGPT2は、実際の問題に関する正確でコンテキストに敏感な洞察を提供します。

研究者は、さまざまな広く使用されているテーブルと一般的なベンチマークでTableGPT2の広範な評価を実施し、結果はTableGPT2がテーブルの理解、処理、および推論でうまく機能し、平均パフォーマンス改善が70億パラメーターモデルの平均パフォーマンス改善、および35.20%、および35.20%、および720%1億パラメーターモデルの平均パフォーマンスは49.32%増加し、強力な一般的なパフォーマンスを維持しています。 公正な評価のために、彼らはTableGPT2をQwenやDeepSeekなどのオープンソースベンチマークのニュートラルモデルとのみ比較し、単一のベンチマークテストを過剰に適合せずに、さまざまなタスクでモデルのバランスの取れた多用途パフォーマンスを確保しました。 彼らはまた、新しいベンチマークであるRealtabbenchを導入し、部分的にリリースしました。これは、型にはまらないテーブル、匿名のフィールド、複雑なクエリを強調しています。

TableGpt2は実験で最先端のパフォーマンスを達成しましたが、LLMを実際のBI環境に展開することには課題があります。 研究者は、将来の研究の方向性には次のとおりであると指摘しました。

ドメイン固有のコーディング:LLMは、エンタープライズデータインフラストラクチャの特定のニーズをより適切に満たすために、エンタープライズ固有のドメイン固有の言語(DSL)または擬似コードに迅速に適応できます。

マルチエージェント設計:複数のLLMを統合システムに効果的に統合して、実際のアプリケーションの複雑さを処理する方法を探ります。

多機能テーブル処理:エクセルやページによく見られるマージされたセルや一貫性のない構造など、不規則なテーブルを処理するモデルの能力が向上し、現実世界のさまざまな形式の表形式データをよりよく処理します。

TableGPT2の発売は、テーブルデータの処理におけるLLMの大幅な進歩を示し、ビジネスインテリジェンスやその他のデータ駆動型アプリケーションに新しい可能性をもたらします。 研究が深まり続けるにつれて、TableGpt2は将来のデータ分析の分野でますます重要な役割を果たすと信じています。

紙の住所:https://arxiv.org/pdf/2411.02059v1

全体として、TableGPT2はテーブルデータの処理において顕著な結果を達成しており、革新的なアーキテクチャとトレーニング方法が複数のベンチマークにわたって際立っています。 将来の研究の方向性は、現実世界のビジネスインテリジェンスアプリケーションのニーズをよりよく満たすために、モデルの適応性と実用性に引き続き焦点を当てます。