Le modèle de grande langue (LLM) présente des lacunes dans le traitement des données de table, et l'équipe de recherche de l'Institut d'innovation de l'informatique de l'Université Zhejiang a développé le modèle TableGPT2 à cet effet. Ce modèle permet une intégration et un traitement efficaces des données tabulaires, apportant de nouvelles possibilités à Business Intelligence (BI) et à d'autres applications basées sur les données. L'innovation principale de Tablegpt2 réside dans son codeur de table unique, qui peut capturer efficacement les informations de structure et les informations de contenu cellulaire de la table, et améliorer la capacité du modèle à gérer les requêtes floues, les noms de colonne manquants et les tableaux irréguliers. Grâce à la pré-formation et au réglage fin à grande échelle, ainsi qu'à la pré-formation continue (CPT) et à un réglage fin supervisé (SFT), Tablegpt2 démontre de fortes capacités de codage et de raisonnement qui peuvent gérer les tâches BI complexes.

La montée des modèles de grands langues (LLM) a révolutionné l'utilisation de l'intelligence artificielle, mais ils ont des lacunes évidentes dans le traitement des données tabulaires. L'équipe de recherche de l'Institut d'innovation informatique de l'Université de Zhejiang a lancé un nouveau modèle appelé Tablegpt2, qui peut intégrer directement et efficacement les données de la table, s'ouvrir pour l'intelligence commerciale (BI) et d'autres applications basées sur les données.

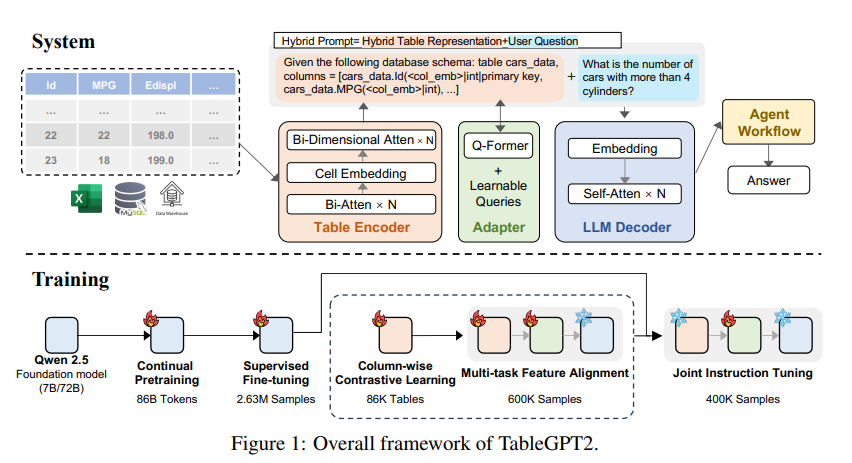

L'innovation principale de Tablegpt2 est son codeur de table unique conçu spécifiquement pour capturer la structure et les informations de contenu cellulaire des tables, améliorant ainsi la capacité du modèle à gérer les requêtes floues, les noms de colonne manquants et les tables irrégulières généralement trouvées dans les applications réelles. Tablegpt2 est basé sur l'architecture QWEN2.5 et a subi une pré-formation et un réglage préalables à grande échelle, impliquant plus de 593 800 tables et 2,36 millions Données dans les études précédentes.

Pour améliorer les capacités de codage et d'inférence de Tablegpt2, les chercheurs ont effectué une pré-formation continue (CPT), 80% des données étant soigneusement annotées de code pour s'assurer qu'elle a de fortes capacités d'encodage. De plus, ils ont collecté une grande quantité de données de raisonnement et de manuels contenant des connaissances spécifiques au domaine pour améliorer la capacité de raisonnement du modèle. Les données CPT finales contient 86 milliards de symboles de mots filtrés strictement, qui fournit les capacités de codage et de raisonnement nécessaires pour TableGPT2 pour gérer les tâches BI complexes et d'autres tâches connexes.

Pour répondre aux limites de Tablegpt2 en s'adaptant à des tâches et scénarios BI spécifiques, les chercheurs ont effectué un réglage fin supervisé (SFT). Ils ont construit un ensemble de données couvrant une variété de scénarios critiques et réalistes, y compris plusieurs cycles de conversations, un raisonnement complexe, une utilisation des outils et des requêtes hautement orientées vers l'entreprise. Cet ensemble de données combine l'annotation manuelle et le processus d'annotation automatique axé sur les experts pour garantir la qualité et la pertinence des données. Le processus SFT utilise un total de 2,36 millions d'échantillons, affinant davantage le modèle pour répondre aux besoins spécifiques de la BI et d'autres environnements liés à la table.

Tablegpt2 a également introduit de manière innovante un encodeur de table sémantique qui emmène toute la table en entrée pour générer un ensemble compact de vecteurs d'intégration pour chaque colonne. Cette architecture est personnalisée pour les propriétés uniques des données tabulaires et capture efficacement la relation entre les lignes et les colonnes via un mécanisme d'attention bidirectionnel et un processus d'extraction de caractéristiques hiérarchiques. De plus, une méthode d'apprentissage en contraste colonnel est utilisée pour encourager le modèle à apprendre des représentations sémantiques tabulaires significatives et consacrées à la structure.

Pour intégrer de manière transparente TableGPT2 aux outils d'analyse de données au niveau de l'entreprise, les chercheurs ont également conçu un framework d'exécution de workflow d'agent. Le cadre contient trois composants principaux: l'ingénierie rapide d'exécution, le code de sécurité et le module d'évaluation proxy, qui améliorent conjointement les capacités et la fiabilité du proxy. Le flux de travail prend en charge les tâches d'analyse des données complexes via des étapes modulaires (normalisation d'entrée, exécution proxy et appels d'outils) qui fonctionnent ensemble pour gérer et surveiller les performances du proxy. En intégrant la génération (RAG) améliorée par la recherche pour la récupération de contexte efficace et le code de code pour l'exécution sécurisée, le framework garantit que TableGPT2 fournit des informations précises et sensibles au contexte dans les problèmes du monde réel.

Les chercheurs ont effectué des évaluations approfondies de Tablegpt2 dans une variété de tableaux largement utilisés et de repères généraux, et les résultats montrent que Tablegpt2 a bien fonctionné dans la compréhension, le traitement et le raisonnement de la table, avec une amélioration moyenne des performances de 7 milliards de modèles de paramètres de 35,20%, et 720% La performance moyenne du modèle de 100 millions de paramètres a augmenté de 49,32%, tout en maintenant de fortes performances générales. Pour une évaluation équitable, ils ne comparent que TableGPT2 avec des modèles neutres open source tels que Qwen et Deepseek, garantissant des performances équilibrées et polyvalentes du modèle sur une variété de tâches sans sur-ajustement à aucun test de référence unique. Ils ont également introduit et publié partiellement une nouvelle référence, Realtabbench, qui met l'accent sur des tables non conventionnelles, des champs anonymes et des requêtes complexes, qui sont plus conformes aux scénarios réels.

Bien que TableGPT2 ait atteint des performances de pointe dans les expériences, il y a des défis dans le déploiement de LLM dans des environnements BI du monde réel. Les chercheurs ont souligné que les orientations de recherche futures incluent:

Codage spécifique au domaine: permet à LLM de s'adapter rapidement au langage (DSL) spécifique au domaine spécifique à l'entreprise (DSL) pour mieux répondre aux besoins spécifiques de l'infrastructure de données d'entreprise.

Conception multi-agents: explorez comment intégrer efficacement plusieurs LLM dans un système unifié pour gérer la complexité des applications du monde réel.

Traitement des tableaux multifonctionnels: améliore la capacité des modèles à gérer les tables irrégulières, telles que les cellules fusionnées et les structures incohérentes couramment trouvées dans Excel et Pages pour mieux gérer les données tabulaires sous diverses formes dans le monde réel.

Le lancement de Tablegpt2 marque des progrès significatifs dans LLM dans le traitement des données de la table, apportant de nouvelles possibilités à Business Intelligence et à d'autres applications basées sur les données. Je crois que, alors que la recherche continue de s'approfondir, TableGPT2 jouera un rôle de plus en plus important dans le domaine de l'analyse des données à l'avenir.

Adresse papier: https://arxiv.org/pdf/2411.02059v1

Dans l'ensemble, TableGPT2 a obtenu des résultats remarquables dans le traitement des données de table, avec ses méthodes d'inarchite et de formation innovantes, ce qui le fait se démarquer à travers plusieurs repères. Les orientations de recherche futures continueront de se concentrer sur l'adaptabilité et la praticité des modèles pour mieux répondre aux besoins des applications de renseignement commercial du monde réel.