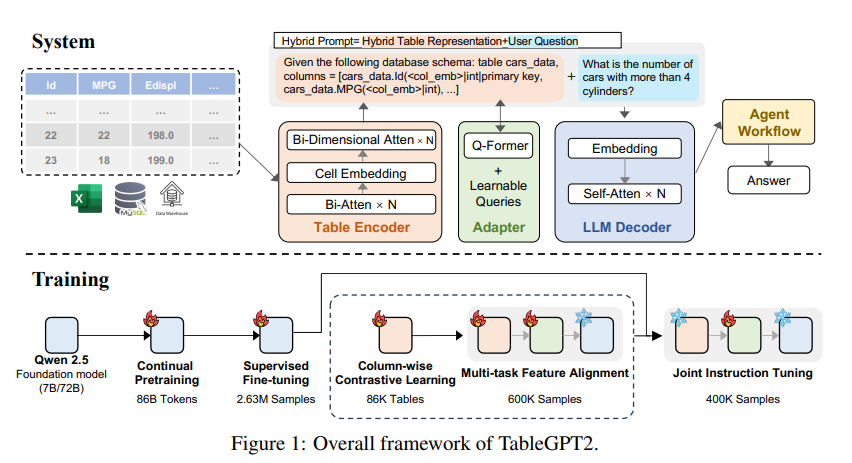

O Modelo de Linguagem de Grande (LLM) possui deficiências nos dados da tabela de processamento e a equipe de pesquisa do Instituto de Innovação de Computação da Universidade de Zhejiang desenvolveu o modelo TableGPT2 para esse fim. Esse modelo permite integração e processamento eficientes de dados tabulares, trazendo novas possibilidades para a inteligência de negócios (BI) e outros aplicativos orientados a dados. A inovação central do TableGPT2 está em seu codificador de tabela exclusivo, que pode efetivamente capturar as informações da estrutura e o conteúdo de células da tabela e aprimorar a capacidade do modelo de lidar com consultas difusas, nomes de colunas ausentes e tabelas irregulares. Através de pré-treinamento em larga escala e ajuste fino, bem como o pré-treinamento contínuo (CPT) e o ajuste fino supervisionado (SFT), o TableGPT2 demonstra fortes recursos de codificação e raciocínio que podem lidar com tarefas complexas de BI.

A ascensão de grandes modelos de linguagem (LLM) revolucionou o uso da inteligência artificial, mas eles têm deficiências óbvias no processamento de dados tabulares. A equipe de pesquisa do Instituto de Innovação da Computação da Universidade de Zhejiang lançou um novo modelo chamado Tablegpt2, que pode integrar e eficientemente os dados da tabela de processos, abrindo para a inteligência de negócios (BI) e outros aplicativos orientados a dados.

A inovação principal do TableGPT2 é o seu codificador exclusivo, projetado especificamente para capturar as informações de estrutura e conteúdo de células das tabelas, melhorando a capacidade do modelo de lidar com consultas difusas, nomes de colunas ausentes e tabelas irregulares comumente encontradas em aplicações do mundo real. A tabelagpt2 é baseada na arquitetura QWEN2.5 e passou por pré-treinamento em larga escala e ajuste fino, envolvendo mais de 593.800 tabelas e 2,36 milhões de consultas de alta qualidade, tuplos-table output, que é uma escala sem precedentes de mesa relacionada Dados em estudos anteriores.

Para melhorar os recursos de codificação e inferência do TableGPT2, os pesquisadores realizaram pré-treinamento contínuo (CPT), com 80% dos dados sendo cuidadosamente anotados, para garantir que ele tenha fortes recursos de codificação. Além disso, eles coletaram uma grande quantidade de dados de raciocínio e livros didáticos contendo conhecimento específico do domínio para aprimorar a capacidade de raciocínio do modelo. Os dados finais do CPT contêm 86 bilhões de símbolos de palavras filtrados estritamente, que fornecem os recursos necessários de codificação e raciocínio para a TableGPT2 para lidar com tarefas complexas de BI e outras tarefas relacionadas.

Para abordar as limitações do TableGPT2 na adaptação a tarefas e cenários específicos de BI, os pesquisadores realizaram ajuste fino supervisionado (SFT). Eles construíram um conjunto de dados cobrindo uma variedade de cenários críticos e realistas, incluindo várias rodadas de conversas, raciocínio complexo, uso de ferramentas e consultas altamente orientadas para os negócios. Esse conjunto de dados combina anotação manual e processo de anotação automática orientada a especialistas para garantir a qualidade e a relevância dos dados. O processo SFT usa um total de 2,36 milhões de amostras, refinando ainda mais o modelo para atender às necessidades específicas de BI e outros ambientes relacionados à tabela.

A TableGPT2 também introduziu um codificador de tabela semântica que toma toda a tabela como entrada para gerar um conjunto compacto de vetores de incorporação para cada coluna. Essa arquitetura é personalizada para as propriedades exclusivas dos dados tabulares e captura efetivamente a relação entre linhas e colunas através de um mecanismo de atenção de mão dupla e um processo de extração de recursos hierárquicos. Além disso, um método de aprendizado de contraste colunar é usado para incentivar o modelo a aprender representações semânticas tabulares significativas e com conhecimento de estrutura.

Para integrar perfeitamente o TableGPT2 às ferramentas de análise de dados em nível corporativo, os pesquisadores também projetaram uma estrutura de tempo de execução do fluxo de trabalho do agente. A estrutura contém três componentes principais: engenharia imediata de tempo de execução, Código de segurança Sandbox e módulo de avaliação de proxy, que aprimoram conjuntamente os recursos e a confiabilidade do proxy. O fluxo de trabalho suporta tarefas complexas de análise de dados por meio de etapas modulares (normalização de entrada, execução de proxy e chamadas de ferramentas) que funcionam juntas para gerenciar e monitorar o desempenho do proxy. Ao integrar a geração aprimorada de pesquisa (RAG) para recuperação eficiente de recuperação de contexto e Sandbox para execução segura, a estrutura garante que a TableGPT2 forneça informações precisas e sensíveis ao contexto nos problemas do mundo real.

Os pesquisadores realizaram avaliações extensas do TableGPT2 em uma variedade de tabelas e benchmarks gerais amplamente utilizados, e os resultados mostram que a tabelagpt2 teve um bom desempenho na compreensão, processamento e raciocínio da tabela, com uma melhoria média de desempenho de 7 bilhões de modelos de parâmetros em 35,20%e e 720% O desempenho médio do modelo de 100 milhões de parâmetros aumentou 49,32%, mantendo um forte desempenho geral. Para avaliação justa, eles compararam apenas o TableGPT2 com modelos neutros de referência de código aberto, como QWEN e Deepseek, garantindo desempenho equilibrado e versátil do modelo em uma variedade de tarefas sem ajustar demais nenhum teste de referência. Eles também introduziram e lançaram parcialmente um novo benchmark, RealTabbench, que enfatiza mesas não convencionais, campos anônimos e consultas complexas, que estão mais alinhadas com os cenários da vida real.

Embora a TableGPT2 tenha alcançado desempenho de ponta em experimentos, há desafios na implantação de LLM em ambientes de BI no mundo real. Os pesquisadores apontaram que futuras direções de pesquisa incluem:

Codificação específica do domínio: permite que o LLM se adapte rapidamente à linguagem específica de domínio (DSL) específica da empresa para atender melhor às necessidades específicas da infraestrutura de dados corporativos.

Design multi-agente: Explore como integrar efetivamente vários LLMs em um sistema unificado para lidar com a complexidade dos aplicativos do mundo real.

Processamento de tabela multifuncional: melhora a capacidade dos modelos de lidar com tabelas irregulares, como células mescladas e estruturas inconsistentes comumente encontradas no Excel e páginas para lidar melhor com dados tabulares em várias formas no mundo real.

O lançamento do TableGPT2 marca progresso significativo no LLM nos dados da tabela de processamento, trazendo novas possibilidades para a inteligência de negócios e outros aplicativos orientados a dados. Acredito que, à medida que a pesquisa continua a se aprofundar, o TableGPT2 desempenhará um papel cada vez mais importante no campo da análise de dados no futuro.

Endereço em papel: https://arxiv.org/pdf/2411.02059v1

Em suma, a TableGPT2 alcançou resultados notáveis no processamento de dados da tabela, com seus métodos inovadores de arquitetura e treinamento, destacando -se em vários benchmarks. As instruções futuras de pesquisa continuarão a se concentrar na adaptabilidade e praticidade dos modelos para melhor atender às necessidades dos aplicativos de inteligência de negócios do mundo real.