Model Bahasa Besar (LLM) memiliki kekurangan dalam pemrosesan data tabel, dan tim peneliti Institut Inovasi Komputasi Universitas Zhejiang telah mengembangkan model TableGpt2 untuk tujuan ini. Model ini memungkinkan integrasi dan pemrosesan data tabular yang efisien, membawa kemungkinan baru ke Business Intelligence (BI) dan aplikasi yang digerakkan data lainnya. Inovasi inti dari TableGPT2 terletak pada encoder tabel uniknya, yang secara efektif dapat menangkap informasi struktur dan informasi konten sel tabel, dan meningkatkan kemampuan model untuk menangani permintaan fuzzy, nama kolom yang hilang, dan tabel tidak teratur. Melalui pra-pelatihan dan penyesuaian skala besar, serta pra-pelatihan berkelanjutan (CPT) dan diawasi fine-tuning (SFT), TableGPT2 menunjukkan pengkodean yang kuat dan kemampuan penalaran yang dapat menangani tugas BI yang kompleks.

Munculnya Model Bahasa Besar (LLM) telah merevolusi penggunaan kecerdasan buatan, tetapi mereka memiliki kekurangan yang jelas dalam memproses data tabel. Tim peneliti dari Institut Inovasi Komputasi Universitas Zhejiang telah meluncurkan model baru yang disebut TableGPT2, yang dapat secara langsung dan efisien mengintegrasikan dan memproses data tabel, membuka untuk Business Intelligence (BI) dan aplikasi yang digerakkan data lainnya.

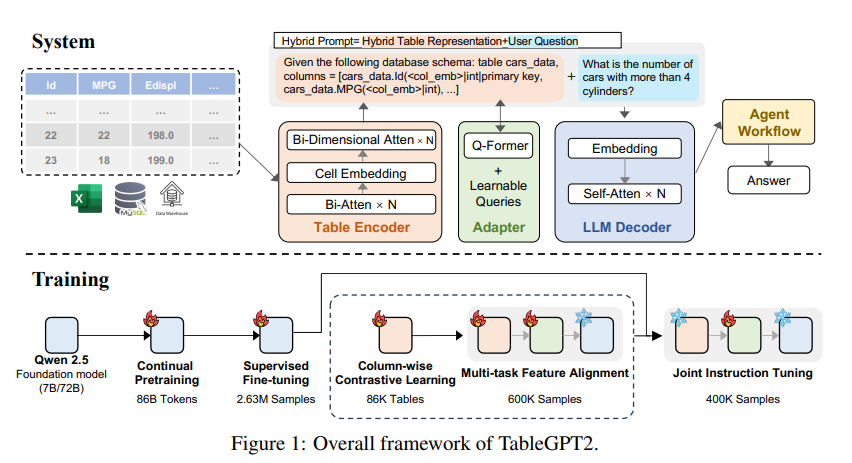

Inovasi inti dari TableGPT2 adalah tabel uniknya yang dirancang khusus untuk menangkap struktur dan informasi konten sel tabel, sehingga meningkatkan kemampuan model untuk menangani permintaan fuzzy, nama kolom yang hilang, dan tabel tidak teratur yang biasa ditemukan dalam aplikasi dunia nyata. TableGPT2 didasarkan pada arsitektur QWEN2.5 dan telah menjalani pra-pelatihan dan penyesuaian skala besar, yang melibatkan lebih dari 593.800 tabel dan 2,36 juta tupput output-tabel berkualitas tinggi, yang merupakan skala yang belum pernah terjadi sebelumnya terkait meja yang terkait dengan meja yang belum pernah terjadi sebelumnya sebelumnya telah telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya telah sebelumnya data dalam penelitian sebelumnya.

Untuk meningkatkan kemampuan penyandian dan inferensi dari TableGpt2, para peneliti melakukan kontinu pra-pelatihan (CPT) di atasnya, dengan 80% data yang dianotasi dengan hati-hati untuk memastikan bahwa ia memiliki kemampuan pengkodean yang kuat. Selain itu, mereka mengumpulkan sejumlah besar data penalaran dan buku teks yang berisi pengetahuan khusus domain untuk meningkatkan kemampuan penalaran model. Data CPT akhir berisi 86 miliar simbol kata yang disaring secara ketat, yang menyediakan kemampuan pengkodean dan penalaran yang diperlukan untuk TableGPT2 untuk menangani tugas -tugas BI yang kompleks dan tugas terkait lainnya.

Untuk mengatasi keterbatasan TableGPT2 dalam beradaptasi dengan tugas dan skenario BI tertentu, para peneliti melakukan fine tuning (SFT) yang diawasi. Mereka membangun dataset yang mencakup berbagai skenario kritis dan realistis, termasuk beberapa putaran percakapan, penalaran yang kompleks, penggunaan alat, dan pertanyaan yang sangat berorientasi pada bisnis. Dataset ini menggabungkan anotasi manual dan proses anotasi otomatis yang digerakkan oleh ahli untuk memastikan kualitas dan relevansi data. Proses SFT menggunakan total 2,36 juta sampel, lebih lanjut menyempurnakan model untuk memenuhi kebutuhan spesifik BI dan lingkungan terkait meja lainnya.

TableGPT2 juga secara inovatif memperkenalkan encoder tabel semantik yang mengambil seluruh tabel sebagai input untuk menghasilkan satu set kompak vektor embedding untuk setiap kolom. Arsitektur ini disesuaikan untuk sifat unik dari data tabel, dan secara efektif menangkap hubungan antara baris dan kolom melalui mekanisme perhatian dua arah dan proses ekstraksi fitur hierarkis. Selain itu, metode pembelajaran kontras kolom digunakan untuk mendorong model untuk mempelajari representasi semantik yang bermakna dan sadar struktur.

Untuk mengintegrasikan TableGPT2 dengan mulus dengan alat analisis data tingkat perusahaan, para peneliti juga merancang kerangka kerja runtime alur kerja agen. Kerangka kerja ini berisi tiga komponen inti: Runtime Prompt Engineering, Security Code Sandbox dan Modul Evaluasi Proxy, yang bersama -sama meningkatkan kemampuan dan keandalan proxy. Alur kerja mendukung tugas analisis data yang kompleks melalui langkah -langkah modular (normalisasi input, eksekusi proxy, dan panggilan alat) yang bekerja bersama untuk mengelola dan memantau kinerja proxy. Dengan mengintegrasikan Generasi Peningkatan Pencarian (RAG) untuk pengambilan konteks yang efisien dan kotak pasir kode untuk eksekusi yang aman, kerangka kerja memastikan TableGPT2 memberikan wawasan yang akurat dan peka konteks dalam masalah dunia nyata.

Para peneliti melakukan evaluasi yang luas terhadap TableGpt2 dalam berbagai tabel yang banyak digunakan dan tolok ukur umum, dan hasilnya menunjukkan bahwa TableGPT2 berkinerja baik dalam pemahaman tabel, pemrosesan, dan penalaran, dengan peningkatan kinerja rata -rata 7 miliar model parameter sebesar 35,20%, dan dan 720% Kinerja rata -rata model parameter 100 juta telah meningkat sebesar 49,32%, sambil mempertahankan kinerja umum yang kuat. Untuk evaluasi yang adil, mereka hanya membandingkan TableGPT2 dengan model netral benchmark open source seperti Qwen dan Deepseek, memastikan kinerja model yang seimbang dan serbaguna pada berbagai tugas tanpa berlebihan tes benchmark tunggal. Mereka juga memperkenalkan dan sebagian merilis tolok ukur baru, Realtabbench, yang menekankan tabel yang tidak konvensional, bidang anonim dan pertanyaan kompleks, yang lebih sesuai dengan skenario kehidupan nyata.

Meskipun TableGpt2 mencapai kinerja canggih dalam eksperimen, ada tantangan dalam menggunakan LLM ke lingkungan BI dunia nyata. Para peneliti menunjukkan bahwa arahan penelitian di masa depan meliputi:

Pengkodean khusus domain: Memungkinkan LLM untuk dengan cepat beradaptasi dengan bahasa khusus domain khusus perusahaan (DSL) atau kode pseudo untuk lebih memenuhi kebutuhan spesifik infrastruktur data perusahaan.

Desain multi-agen: Jelajahi bagaimana mengintegrasikan beberapa LLM secara efektif ke dalam sistem terpadu untuk menangani kompleksitas aplikasi dunia nyata.

Pemrosesan tabel multi-fungsional: Meningkatkan kemampuan model untuk menangani tabel yang tidak teratur, seperti sel gabungan dan struktur yang tidak konsisten yang biasa ditemukan di Excel dan halaman untuk menangani data tabel yang lebih baik dalam berbagai bentuk di dunia nyata.

Peluncuran TableGPT2 menandai kemajuan yang signifikan dalam LLM dalam pemrosesan data tabel, membawa kemungkinan baru untuk intelijen bisnis dan aplikasi berbasis data lainnya. Saya percaya bahwa ketika penelitian terus semakin dalam, TableGPT2 akan memainkan peran yang semakin penting dalam bidang analisis data di masa depan.

Alamat kertas: https://arxiv.org/pdf/2411.02059v1

Secara keseluruhan, TableGPT2 telah mencapai hasil yang luar biasa dalam pemrosesan data tabel, dengan arsitektur inovatif dan metode pelatihan membuatnya menonjol di berbagai tolok ukur. Arahan penelitian di masa depan akan terus fokus pada kemampuan beradaptasi dan kepraktisan model untuk lebih memenuhi kebutuhan aplikasi intelijen bisnis dunia nyata.