Langport-это платформа с большой языковой моделью с открытым исходным кодом. Наша цель - построить супер быстрый сервис вывода LLM.

Этот проект вдохновлен LMSYS/FASTCHAT, мы надеемся, что сервировочная платформа легкая и быстрая, но FastChat включает в себя другие функции, такие как обучение и оценка, усложняют ее.

Основные особенности включают:

ChatProto .pip install langportили:

pip install git+https://github.com/vtuber-plan/langport.git Если вам нужен работник генерации GGML, используйте эту команду:

pip install langport[ggml]Если вы хотите использовать GPU:

CT_CUBLAS=1 pip install langport[ggml]git clone https://github.com/vtuber-plan/langport.git

cd langportpip install --upgrade pip

pip install -e . Это просто запустить локальный сервис API в чате:

Во -первых, запустите рабочий процесс в терминале:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >Затем запустите службу API в другом терминале:

python -m langport.service.gateway.openai_apiТеперь вы можете использовать API вывода по протоколу Openai.

Это просто запустить один узел API -сервис чата:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >

python -m langport.service.gateway.openai_apiЕсли вам нужен один узел API API -сервер:

python -m langport.service.server.embedding_worker --port 21002 --model-path bert-base-chinese --gpus 0 --num-gpus 1

python -m langport.service.gateway.openai_api --port 8000 --controller-address http://localhost:21002Если вам нужен API Entceddings или другие функции, вы можете развернуть распределенный кластер с выводом:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.embedding_worker --model-path < your model path > --neighbors http://localhost:21001

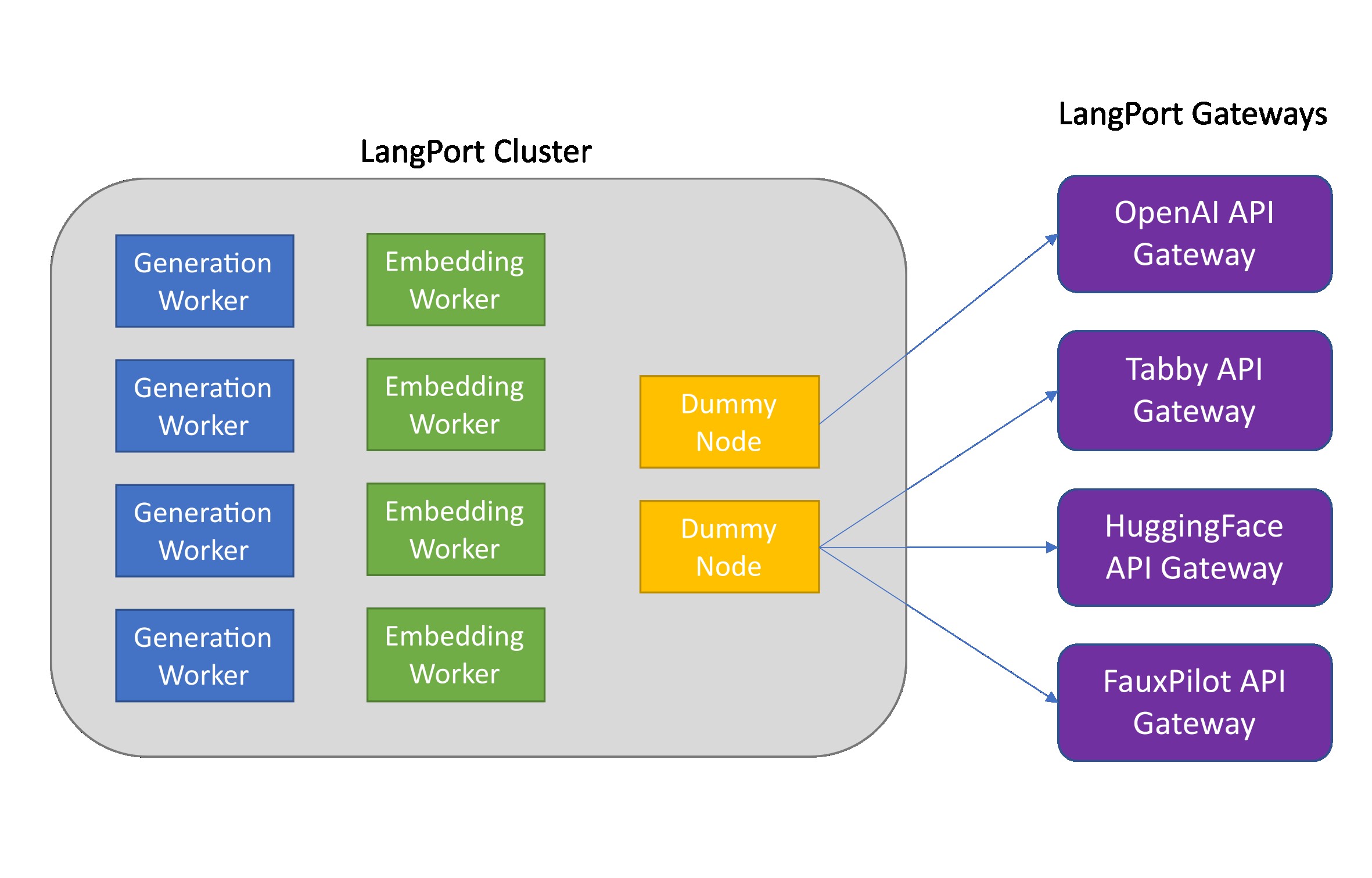

python -m langport.service.gateway.openai_api --controller-address http://localhost:21001На практике шлюз может подключаться к любому узлу для распространения задач вывода:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --port 21002 --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.generation_worker --port 21003 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21002

python -m langport.service.server.generation_worker --port 21004 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21003

python -m langport.service.server.generation_worker --port 21005 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21004

python -m langport.service.gateway.openai_api --controller-address http://localhost:21003 # 21003 is OK!

python -m langport.service.gateway.openai_api --controller-address http://localhost:21002 # Any worker is also OK!Запустите генерацию текста с помощью нескольких графических процессоров:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path > --gpus 0,1 --num-gpus 2

python -m langport.service.gateway.openai_apiЗапустите генерацию текста с работником GGML:

python -m langport.service.server.ggml_generation_worker --port 21001 --model-path < your model path > --gpu-layers < num layer to gpu (resize this for your VRAM) >Запустить Openai Worth Server:

python -m langport.service.server.chatgpt_generation_worker --port 21001 --api-url < url > --api-key < key > Langport выпускается по лицензии Apache Software.