Langport adalah platform penyajian model bahasa besar open-source. Tujuan kami adalah membangun layanan inferensi LLM yang sangat cepat.

Proyek ini terinspirasi oleh LMSys/Fastchat, kami berharap platform penyajiannya ringan dan cepat, tetapi Fastchat menyertakan fitur lain seperti pelatihan dan evaluasi membuatnya rumit.

Fitur inti meliputi:

ChatProto .pip install langportatau:

pip install git+https://github.com/vtuber-plan/langport.git Jika Anda membutuhkan pekerja generasi GGML, gunakan perintah ini:

pip install langport[ggml]Jika Anda ingin menggunakan GPU:

CT_CUBLAS=1 pip install langport[ggml]git clone https://github.com/vtuber-plan/langport.git

cd langportpip install --upgrade pip

pip install -e . Sederhana untuk memulai layanan API obrolan lokal:

Pertama, mulailah proses pekerja di terminal:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >Kemudian, mulailah layanan API di terminal lain:

python -m langport.service.gateway.openai_apiSekarang, Anda dapat menggunakan API Inference oleh Openai Protocol.

Sederhana untuk memulai layanan API obrolan node tunggal:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >

python -m langport.service.gateway.openai_apiJika Anda membutuhkan satu node embeddings API server:

python -m langport.service.server.embedding_worker --port 21002 --model-path bert-base-chinese --gpus 0 --num-gpus 1

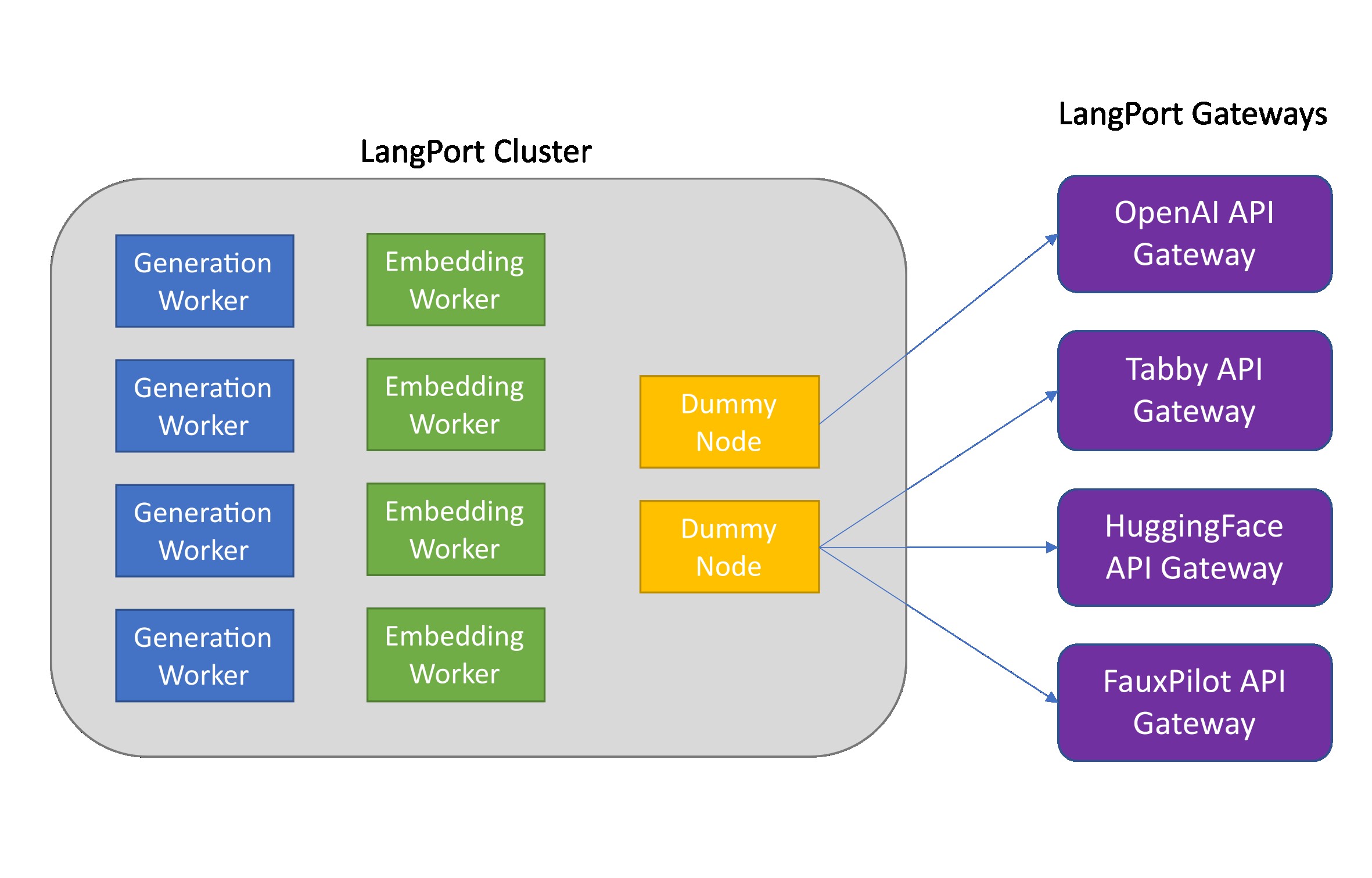

python -m langport.service.gateway.openai_api --port 8000 --controller-address http://localhost:21002Jika Anda membutuhkan API Embeddings atau fitur lainnya, Anda dapat menggunakan cluster inferensi terdistribusi:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.embedding_worker --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.gateway.openai_api --controller-address http://localhost:21001Dalam praktiknya, gateway dapat terhubung ke node apa pun untuk mendistribusikan tugas inferensi:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --port 21002 --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.generation_worker --port 21003 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21002

python -m langport.service.server.generation_worker --port 21004 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21003

python -m langport.service.server.generation_worker --port 21005 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21004

python -m langport.service.gateway.openai_api --controller-address http://localhost:21003 # 21003 is OK!

python -m langport.service.gateway.openai_api --controller-address http://localhost:21002 # Any worker is also OK!Jalankan pembuatan teks dengan multi gpus:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path > --gpus 0,1 --num-gpus 2

python -m langport.service.gateway.openai_apiJalankan pembuatan teks dengan pekerja GGML:

python -m langport.service.server.ggml_generation_worker --port 21001 --model-path < your model path > --gpu-layers < num layer to gpu (resize this for your VRAM) >Jalankan server Forward OpenAi:

python -m langport.service.server.chatgpt_generation_worker --port 21001 --api-url < url > --api-key < key > Langport dirilis di bawah lisensi perangkat lunak Apache.