Langport هو منصة خدمة لغة كبيرة مفتوحة المصدر. هدفنا هو بناء خدمة استنتاج فائقة LLM.

هذا المشروع مستوحى من LMSYS/FastChat ، ونأمل أن تكون منصة التقديم خفيفة الوزن وسريعة ، ولكن FastChat يتضمن ميزات أخرى مثل التدريب والتقييم يجعلها معقدة.

تشمل الميزات الأساسية:

ChatProto .pip install langportأو:

pip install git+https://github.com/vtuber-plan/langport.git إذا كنت بحاجة إلى عامل توليد GGML ، فاستخدم هذا الأمر:

pip install langport[ggml]إذا كنت تريد استخدام GPU:

CT_CUBLAS=1 pip install langport[ggml]git clone https://github.com/vtuber-plan/langport.git

cd langportpip install --upgrade pip

pip install -e . من السهل بدء خدمة API محلية للدردشة:

أولاً ، ابدأ عملية العمال في المحطة:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >ثم ، ابدأ خدمة API في محطة أخرى:

python -m langport.service.gateway.openai_apiالآن ، يمكنك استخدام API الاستدلال بواسطة بروتوكول Openai.

من السهل بدء خدمة API للدردشة العقدة:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path >

python -m langport.service.gateway.openai_apiإذا كنت بحاجة إلى خادم API لعقدة واحدة:

python -m langport.service.server.embedding_worker --port 21002 --model-path bert-base-chinese --gpus 0 --num-gpus 1

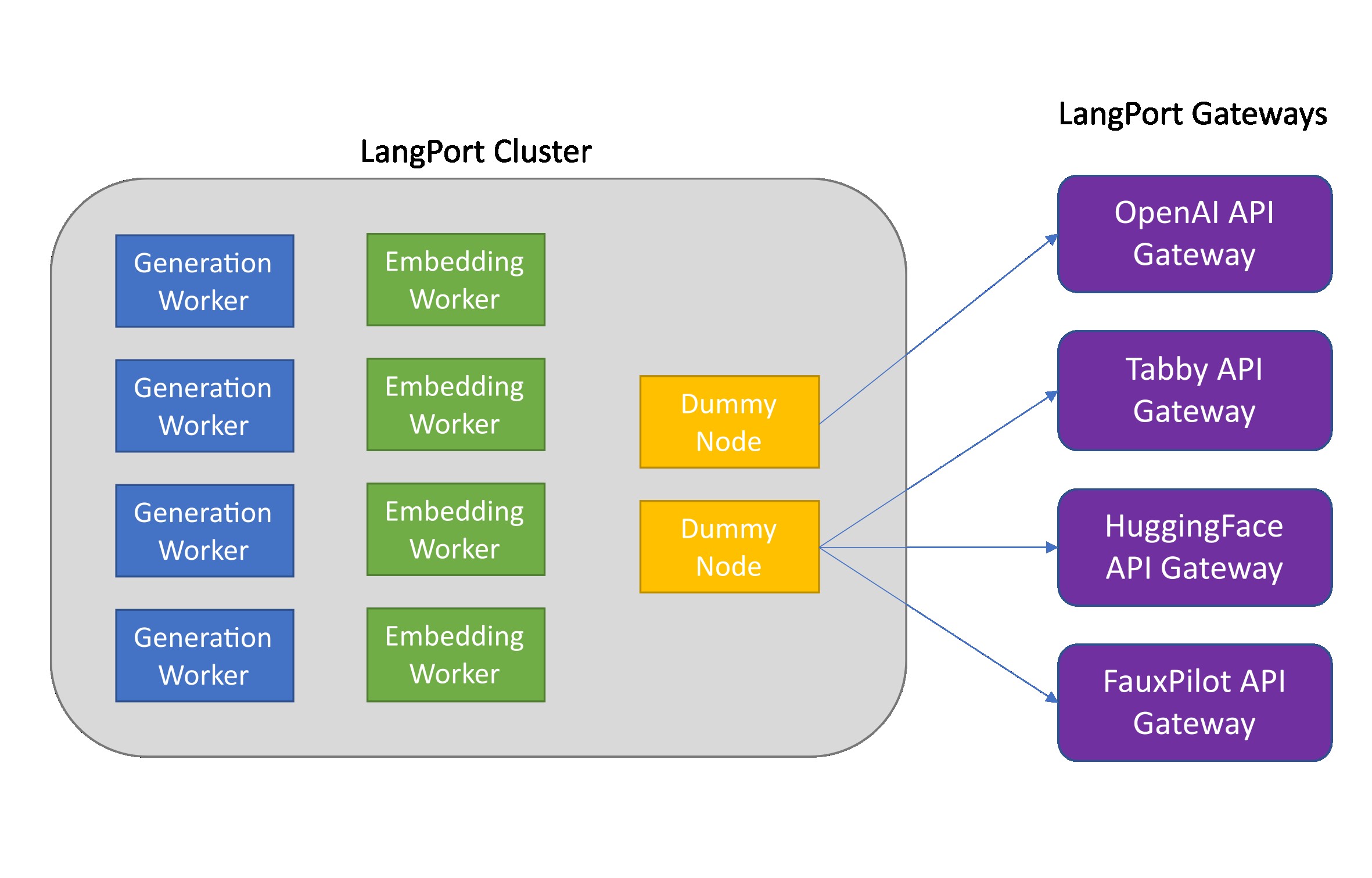

python -m langport.service.gateway.openai_api --port 8000 --controller-address http://localhost:21002إذا كنت بحاجة إلى API أو ميزات أخرى ، فيمكنك نشر مجموعة استنتاج موزعة:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.embedding_worker --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.gateway.openai_api --controller-address http://localhost:21001في الممارسة العملية ، يمكن للبوابة الاتصال بأي عقدة لتوزيع مهام الاستدلال:

python -m langport.service.server.dummy_worker --port 21001

python -m langport.service.server.generation_worker --port 21002 --model-path < your model path > --neighbors http://localhost:21001

python -m langport.service.server.generation_worker --port 21003 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21002

python -m langport.service.server.generation_worker --port 21004 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21003

python -m langport.service.server.generation_worker --port 21005 --model-path < your model path > --neighbors http://localhost:21001 http://localhost:21004

python -m langport.service.gateway.openai_api --controller-address http://localhost:21003 # 21003 is OK!

python -m langport.service.gateway.openai_api --controller-address http://localhost:21002 # Any worker is also OK!تشغيل توليد النص مع وحدات معالجة الرسومات المتعددة:

python -m langport.service.server.generation_worker --port 21001 --model-path < your model path > --gpus 0,1 --num-gpus 2

python -m langport.service.gateway.openai_apiتشغيل توليد النص مع عامل GGML:

python -m langport.service.server.ggml_generation_worker --port 21001 --model-path < your model path > --gpu-layers < num layer to gpu (resize this for your VRAM) >Run Openai Forward Server:

python -m langport.service.server.chatgpt_generation_worker --port 21001 --api-url < url > --api-key < key > يتم إصدار Langport بموجب ترخيص برنامج Apache.