Читать DetRex Benderking Paper | ? Project Page | ? ️Cite detRex | ? DeepDataspace

Документация | Установка | ? Модель зоопарка | Потрясающий Детр | ? Новости | ? Проблемы отчетности

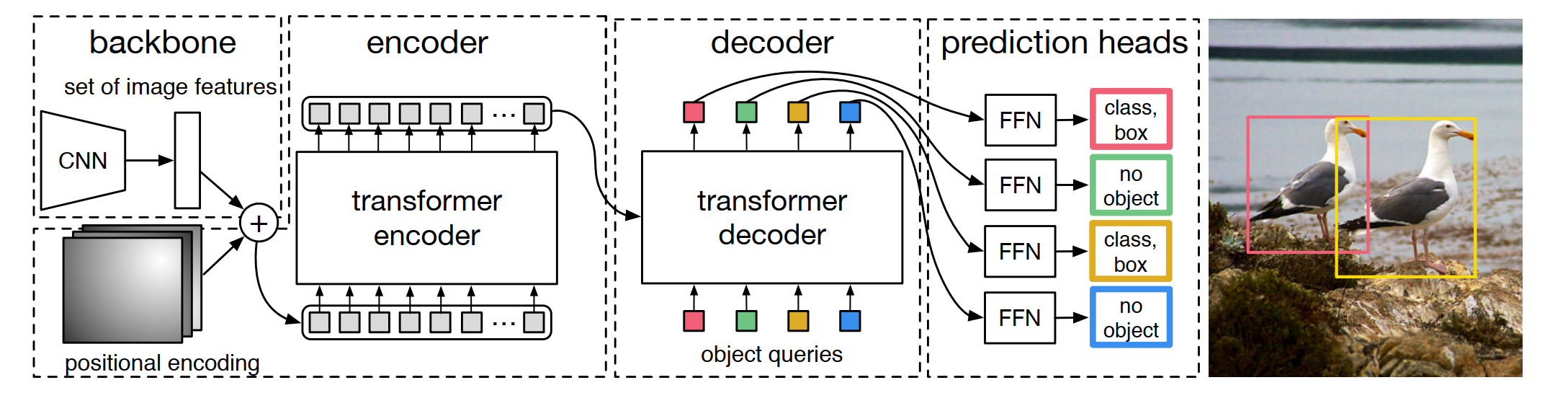

DetRex-это набор инструментов с открытым исходным кодом, который обеспечивает самые современные алгоритмы обнаружения на основе трансформаторов. Он построен на вершине Detectron2, а его конструкция модуля частично заимствована из MMDetection и Detr. Большое спасибо за их хорошо организованный код. Основная ветвь работает с Pytorch 1.10+ или выше (мы рекомендуем Pytorch 1.12 ).

Модульный дизайн. DetRex разлагает структуру обнаружения на основе трансформатора на различные компоненты, которые помогают пользователям легко создавать свои собственные индивидуальные модели.

Сильные базовые показатели. DetRex предоставляет серию сильных базовых показателей для моделей обнаружения на основе трансформатора. Мы также повысили производительность модели с 0,2 AP до 1,1 AP за счет оптимизации гиперпараметров среди большинства поддерживаемых алгоритмов.

Простой в использовании. DetRex разработан, чтобы быть легким и простым для пользователей:

Помимо DetRex, мы также выпустили Awesome Transformer Repo, чтобы представить документы о трансформаторе для обнаружения и сегментации.

Имя репо, DetRex имеет несколько интерпретаций:

DETR-EX : Мы снимаем шляпы в DETR и рассматриваем это репо как расширение алгоритмов обнаружения на основе трансформаторов.

Det-Rex : Rex буквально означает «король» на латыни. Мы надеемся, что этот репо может помочь продвинуть состояние искусства по обнаружению объектов, предоставив лучшие алгоритмы обнаружения на основе трансформамеров от исследовательского сообщества.

de-t.rex : de означает «на голландском языке». T.Rex, также называемый Tyrannosaurus rex, означает «король ящериц тирана» и соединяется с нашей исследовательской работой «Dino», которая коротко для динозавра.

V0.5.0 был выпущен 16/07/2023:

Пожалуйста, смотрите Changelog.md для деталей и истории выпуска.

Пожалуйста, обратитесь к инструкциям по установке для получения подробной информации об установке.

Пожалуйста, обратитесь к началу работы с DetRex для базового использования DetRex. Мы также предоставляем другие уроки для:

Хотя некоторые учебники в настоящее время представлены с относительно простым контентом, мы будем постоянно улучшать нашу документацию, чтобы помочь пользователям достичь лучшего пользовательского опыта.

Пожалуйста, смотрите документацию для полной документации API и учебных пособий.

Результаты и модели доступны в модельном зоопарке.

Пожалуйста, смотрите проекты для подробностей о проектах, которые создаются на основе DetRex.

Этот проект выпущен по лицензии Apache 2.0.

Если вы используете этот набор инструментов в своем исследовании или хотите ссылаться на базовые результаты, опубликованные здесь, используйте следующие записи Bibtex:

@misc { ren2023detrex ,

title = { detrex: Benchmarking Detection Transformers } ,

author = { Tianhe Ren and Shilong Liu and Feng Li and Hao Zhang and Ailing Zeng and Jie Yang and Xingyu Liao and Ding Jia and Hongyang Li and He Cao and Jianan Wang and Zhaoyang Zeng and Xianbiao Qi and Yuhui Yuan and Jianwei Yang and Lei Zhang } ,

year = { 2023 } ,

eprint = { 2306.07265 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { carion2020end ,

title = { End-to-end object detection with transformers } ,

author = { Carion, Nicolas and Massa, Francisco and Synnaeve, Gabriel and Usunier, Nicolas and Kirillov, Alexander and Zagoruyko, Sergey } ,

booktitle = { European conference on computer vision } ,

pages = { 213--229 } ,

year = { 2020 } ,

organization = { Springer }

}

@inproceedings {

zhu2021deformable,

title = { Deformable {{}DETR{}}: Deformable Transformers for End-to-End Object Detection } ,

author = { Xizhou Zhu and Weijie Su and Lewei Lu and Bin Li and Xiaogang Wang and Jifeng Dai } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2021 } ,

url = { https://openreview.net/forum?id=gZ9hCDWe6ke }

}

@inproceedings { meng2021-CondDETR ,

title = { Conditional DETR for Fast Training Convergence } ,

author = { Meng, Depu and Chen, Xiaokang and Fan, Zejia and Zeng, Gang and Li, Houqiang and Yuan, Yuhui and Sun, Lei and Wang, Jingdong } ,

booktitle = { Proceedings of the IEEE International Conference on Computer Vision (ICCV) } ,

year = { 2021 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

zhang2023dino,

title = { {DINO}: {DETR} with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel Ni and Heung-Yeung Shum } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=3mRwyG5one }

}

@InProceedings { Chen_2023_ICCV ,

author = { Chen, Qiang and Chen, Xiaokang and Wang, Jian and Zhang, Shan and Yao, Kun and Feng, Haocheng and Han, Junyu and Ding, Errui and Zeng, Gang and Wang, Jingdong } ,

title = { Group DETR: Fast DETR Training with Group-Wise One-to-Many Assignment } ,

booktitle = { Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) } ,

month = { October } ,

year = { 2023 } ,

pages = { 6633-6642 }

}

@InProceedings { Jia_2023_CVPR ,

author = { Jia, Ding and Yuan, Yuhui and He, Haodi and Wu, Xiaopei and Yu, Haojun and Lin, Weihong and Sun, Lei and Zhang, Chao and Hu, Han } ,

title = { DETRs With Hybrid Matching } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 19702-19712 }

}

@InProceedings { Li_2023_CVPR ,

author = { Li, Feng and Zhang, Hao and Xu, Huaizhe and Liu, Shilong and Zhang, Lei and Ni, Lionel M. and Shum, Heung-Yeung } ,

title = { Mask DINO: Towards a Unified Transformer-Based Framework for Object Detection and Segmentation } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 3041-3050 }

}

@article { yan2023bridging ,

title = { Bridging the Gap Between End-to-end and Non-End-to-end Multi-Object Tracking } ,

author = { Yan, Feng and Luo, Weixin and Zhong, Yujie and Gan, Yiyang and Ma, Lin } ,

journal = { arXiv preprint arXiv:2305.12724 } ,

year = { 2023 }

}

@InProceedings { Chen_2023_CVPR ,

author = { Chen, Fangyi and Zhang, Han and Hu, Kai and Huang, Yu-Kai and Zhu, Chenchen and Savvides, Marios } ,

title = { Enhanced Training of Query-Based Object Detection via Selective Query Recollection } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 23756-23765 }

}