Lire Detrex Paper d'analyse comparative | ? Page du projet | ? ️Cite dedrex | ? Deepdataspace

Documentation | Installation | ? Modèle Zoo | Génial detr | ? News | ? Reporter des problèmes

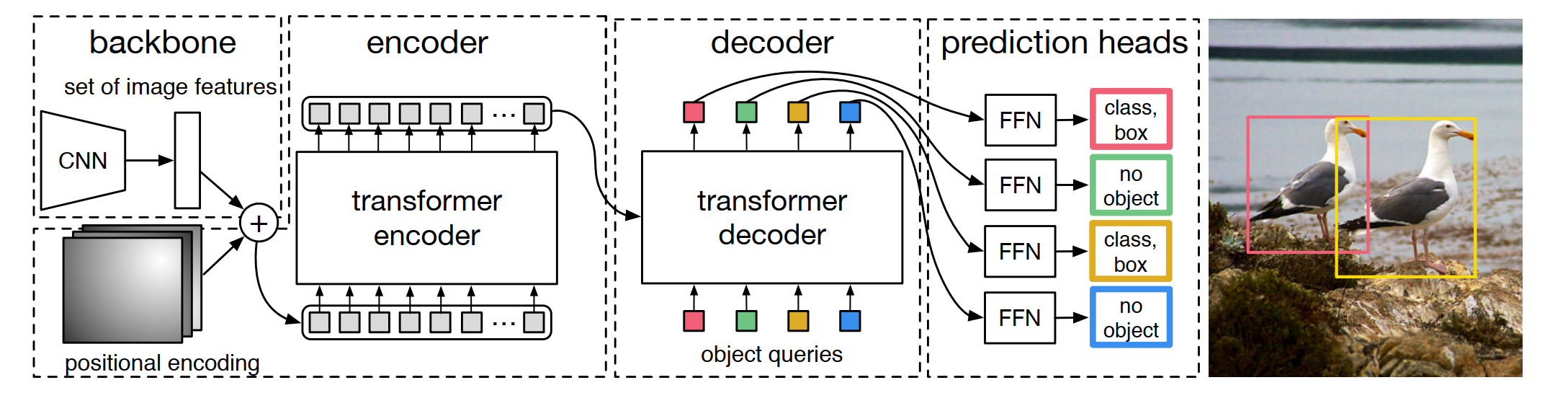

Dedrex est une boîte à outils open source qui fournit des algorithmes de détection basés sur un transformateur de pointe. Il est construit au-dessus de Detectron2 et sa conception de modules est partiellement empruntée à MMDection et DETR. Merci beaucoup pour leur code bien organisé. La branche principale fonctionne avec Pytorch 1.10+ ou plus (nous recommandons Pytorch 1.12 ).

Conception modulaire. Detrex décompose le cadre de détection basé sur le transformateur en différents composants qui aident les utilisateurs à construire facilement leurs propres modèles personnalisés.

Bâlines fortes. Dedrex fournit une série de lignes de base fortes pour les modèles de détection basés sur les transformateurs. Nous avons encore augmenté les performances du modèle de 0,2 AP à 1,1 AP en optimisant des hyper-paramètres parmi la plupart des algorithmes pris en charge.

Facile à utiliser. Dedrex est conçu pour être léger et facile à utiliser pour les utilisateurs:

Outre DeTrex, nous avons également publié un transformateur de détection impressionnant Repo pour présenter des articles sur le transformateur pour la détection et la segmentation.

Le nom de dépôt dedrex a plusieurs interprétations:

DETR-EX : Nous retirons nos chapeaux pour Detr et considérons ce dépôt comme une extension des algorithmes de détection basés sur le transformateur.

DET-REX : Rex signifie littéralement «roi» en latin. Nous espérons que ce repo pourra aider à faire progresser l'état de l'art sur la détection d'objets en fournissant les meilleurs algorithmes de détection basés sur les transformateurs de la communauté de la recherche.

de-t.rex : de signifie «le» en néerlandais. T.Rex, également appelé Tyrannosaurus Rex, signifie «roi des lézards tyran» et se connecte à notre travail de recherche «Dino», qui est abrégé pour Dinosaur.

V0.5.0 a été publié le 16/07/2023:

Veuillez consulter Changelog.md pour plus de détails et l'historique de la publication.

Veuillez vous référer aux instructions d'installation pour les détails de l'installation.

Veuillez vous référer à la mise en place avec DeTrex pour l'utilisation de base de Dedrex. Nous fournissons également d'autres tutoriels pour:

Bien que certains des tutoriels soient actuellement présentés avec un contenu relativement simple, nous améliorerons constamment notre documentation pour aider les utilisateurs à obtenir une meilleure expérience utilisateur.

Veuillez consulter la documentation pour la documentation complète de l'API et les tutoriels.

Les résultats et les modèles sont disponibles dans Model Zoo.

Veuillez consulter des projets pour les détails des projets construits sur la base de DeTrex.

Ce projet est publié sous la licence Apache 2.0.

Si vous utilisez cette boîte à outils dans votre recherche ou si vous souhaitez vous référer aux résultats de référence publiés ici, veuillez utiliser les entrées Bibtex suivantes:

@misc { ren2023detrex ,

title = { detrex: Benchmarking Detection Transformers } ,

author = { Tianhe Ren and Shilong Liu and Feng Li and Hao Zhang and Ailing Zeng and Jie Yang and Xingyu Liao and Ding Jia and Hongyang Li and He Cao and Jianan Wang and Zhaoyang Zeng and Xianbiao Qi and Yuhui Yuan and Jianwei Yang and Lei Zhang } ,

year = { 2023 } ,

eprint = { 2306.07265 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { carion2020end ,

title = { End-to-end object detection with transformers } ,

author = { Carion, Nicolas and Massa, Francisco and Synnaeve, Gabriel and Usunier, Nicolas and Kirillov, Alexander and Zagoruyko, Sergey } ,

booktitle = { European conference on computer vision } ,

pages = { 213--229 } ,

year = { 2020 } ,

organization = { Springer }

}

@inproceedings {

zhu2021deformable,

title = { Deformable {{}DETR{}}: Deformable Transformers for End-to-End Object Detection } ,

author = { Xizhou Zhu and Weijie Su and Lewei Lu and Bin Li and Xiaogang Wang and Jifeng Dai } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2021 } ,

url = { https://openreview.net/forum?id=gZ9hCDWe6ke }

}

@inproceedings { meng2021-CondDETR ,

title = { Conditional DETR for Fast Training Convergence } ,

author = { Meng, Depu and Chen, Xiaokang and Fan, Zejia and Zeng, Gang and Li, Houqiang and Yuan, Yuhui and Sun, Lei and Wang, Jingdong } ,

booktitle = { Proceedings of the IEEE International Conference on Computer Vision (ICCV) } ,

year = { 2021 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

zhang2023dino,

title = { {DINO}: {DETR} with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel Ni and Heung-Yeung Shum } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=3mRwyG5one }

}

@InProceedings { Chen_2023_ICCV ,

author = { Chen, Qiang and Chen, Xiaokang and Wang, Jian and Zhang, Shan and Yao, Kun and Feng, Haocheng and Han, Junyu and Ding, Errui and Zeng, Gang and Wang, Jingdong } ,

title = { Group DETR: Fast DETR Training with Group-Wise One-to-Many Assignment } ,

booktitle = { Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) } ,

month = { October } ,

year = { 2023 } ,

pages = { 6633-6642 }

}

@InProceedings { Jia_2023_CVPR ,

author = { Jia, Ding and Yuan, Yuhui and He, Haodi and Wu, Xiaopei and Yu, Haojun and Lin, Weihong and Sun, Lei and Zhang, Chao and Hu, Han } ,

title = { DETRs With Hybrid Matching } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 19702-19712 }

}

@InProceedings { Li_2023_CVPR ,

author = { Li, Feng and Zhang, Hao and Xu, Huaizhe and Liu, Shilong and Zhang, Lei and Ni, Lionel M. and Shum, Heung-Yeung } ,

title = { Mask DINO: Towards a Unified Transformer-Based Framework for Object Detection and Segmentation } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 3041-3050 }

}

@article { yan2023bridging ,

title = { Bridging the Gap Between End-to-end and Non-End-to-end Multi-Object Tracking } ,

author = { Yan, Feng and Luo, Weixin and Zhong, Yujie and Gan, Yiyang and Ma, Lin } ,

journal = { arXiv preprint arXiv:2305.12724 } ,

year = { 2023 }

}

@InProceedings { Chen_2023_CVPR ,

author = { Chen, Fangyi and Zhang, Han and Hu, Kai and Huang, Yu-Kai and Zhu, Chenchen and Savvides, Marios } ,

title = { Enhanced Training of Query-Based Object Detection via Selective Query Recollection } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 23756-23765 }

}