Detrex 벤치마킹 용지를 읽으십시오 | ? 프로젝트 페이지 | ? ØCITE DETREX | ? Deepdataspace

문서 | 설치 | ? 모델 동물원 | 굉장한 detr | ? 뉴스 | ?보고 문제

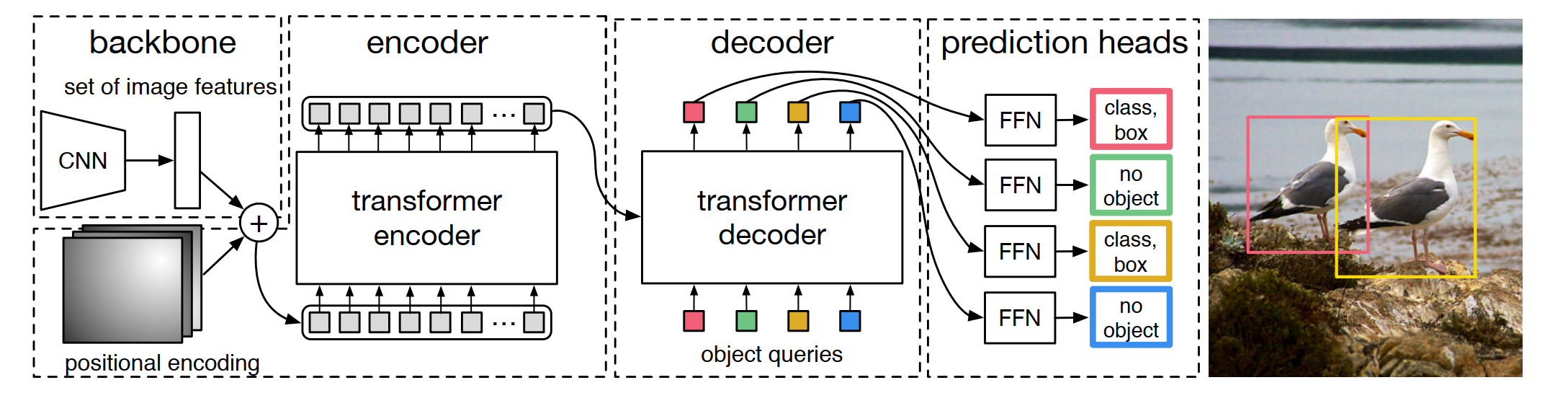

Detrex는 최첨단 변압기 기반 탐지 알고리즘을 제공하는 오픈 소스 도구 상자입니다. Detectron2 위에 구축되었으며 모듈 디자인은 MMDetection 및 Detr에서 부분적으로 빌려 있습니다. 잘 정리 된 코드에 감사드립니다. 메인 브랜치는 Pytorch 1.10+ 이상에서 작동합니다 ( Pytorch 1.12 권장).

모듈 식 디자인. Detrex는 변압기 기반 감지 프레임 워크를 다양한 구성 요소로 분해하여 사용자가 자신의 사용자 정의 모델을 쉽게 구축 할 수 있도록 도와줍니다.

강한 기준선. Detrex는 변압기 기반 탐지 모델을위한 일련의 강력한 기준선을 제공합니다. 대부분의 지원 알고리즘 중에서 하이퍼 파라미터를 최적화하여 모델 성능을 0.2 AP 에서 1.1 AP 로 향상 시켰습니다.

사용하기 쉽습니다. Detrex는 가벼운 가중치 이며 사용자가 사용하기 쉽도록 설계되었습니다.

Detrex 외에도 탐지 및 세분화를위한 변압기에 관한 논문을 제시하기 위해 REPO Awesome Detection Transformer를 발표했습니다.

REPO 이름 DETREX에는 몇 가지 해석이 있습니다.

DETR-EX : 우리는 모자를 DETR로,이 리포지기를 변압기 기반 탐지 알고리즘의 확장으로 간주합니다.

Det-Rex : Rex는 문자 그대로 라틴어로 '왕'을 의미합니다. 우리는이 repo가 연구 커뮤니티로부터 최고의 변압기 기반 탐지 알고리즘을 제공함으로써 객체 감지에 대한 최첨단을 발전시키는 데 도움이되기를 바랍니다.

de-t.rex : de는 네덜란드어로 'The'를 의미합니다. Tyrannosaurus Rex라고도 불리는 T.rex는 '폭군 도마뱀의 왕'을 의미하며 공룡에게는 짧은 연구 작업 'Dino'와 연결됩니다.

V0.5.0은 20123 년 16/07/2023에 출시되었습니다.

자세한 내용 및 출시 기록은 Changelog.md를 참조하십시오.

설치 세부 사항은 설치 지침을 참조하십시오.

Detrex의 기본 사용에 대해서는 Detrex를 시작하는 것을 참조하십시오. 우리는 또한 다음에 대한 다른 자습서를 제공합니다.

튜토리얼 중 일부에는 현재 비교적 간단한 콘텐츠가 제공되지만 사용자가 더 나은 사용자 경험을 달성 할 수 있도록 문서를 지속적으로 개선 할 것입니다.

전체 API 문서 및 튜토리얼은 문서를 참조하십시오.

결과와 모델은 모델 동물원에서 제공됩니다.

Detrex를 기반으로 구축 된 프로젝트에 대한 자세한 내용은 프로젝트를 참조하십시오.

이 프로젝트는 Apache 2.0 라이센스에 따라 릴리스됩니다.

연구 에서이 도구 상자를 사용하거나 여기에 게시 된 기준 결과를 참조하려면 다음 Bibtex 항목을 사용하십시오.

@misc { ren2023detrex ,

title = { detrex: Benchmarking Detection Transformers } ,

author = { Tianhe Ren and Shilong Liu and Feng Li and Hao Zhang and Ailing Zeng and Jie Yang and Xingyu Liao and Ding Jia and Hongyang Li and He Cao and Jianan Wang and Zhaoyang Zeng and Xianbiao Qi and Yuhui Yuan and Jianwei Yang and Lei Zhang } ,

year = { 2023 } ,

eprint = { 2306.07265 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { carion2020end ,

title = { End-to-end object detection with transformers } ,

author = { Carion, Nicolas and Massa, Francisco and Synnaeve, Gabriel and Usunier, Nicolas and Kirillov, Alexander and Zagoruyko, Sergey } ,

booktitle = { European conference on computer vision } ,

pages = { 213--229 } ,

year = { 2020 } ,

organization = { Springer }

}

@inproceedings {

zhu2021deformable,

title = { Deformable {{}DETR{}}: Deformable Transformers for End-to-End Object Detection } ,

author = { Xizhou Zhu and Weijie Su and Lewei Lu and Bin Li and Xiaogang Wang and Jifeng Dai } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2021 } ,

url = { https://openreview.net/forum?id=gZ9hCDWe6ke }

}

@inproceedings { meng2021-CondDETR ,

title = { Conditional DETR for Fast Training Convergence } ,

author = { Meng, Depu and Chen, Xiaokang and Fan, Zejia and Zeng, Gang and Li, Houqiang and Yuan, Yuhui and Sun, Lei and Wang, Jingdong } ,

booktitle = { Proceedings of the IEEE International Conference on Computer Vision (ICCV) } ,

year = { 2021 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

zhang2023dino,

title = { {DINO}: {DETR} with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel Ni and Heung-Yeung Shum } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=3mRwyG5one }

}

@InProceedings { Chen_2023_ICCV ,

author = { Chen, Qiang and Chen, Xiaokang and Wang, Jian and Zhang, Shan and Yao, Kun and Feng, Haocheng and Han, Junyu and Ding, Errui and Zeng, Gang and Wang, Jingdong } ,

title = { Group DETR: Fast DETR Training with Group-Wise One-to-Many Assignment } ,

booktitle = { Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) } ,

month = { October } ,

year = { 2023 } ,

pages = { 6633-6642 }

}

@InProceedings { Jia_2023_CVPR ,

author = { Jia, Ding and Yuan, Yuhui and He, Haodi and Wu, Xiaopei and Yu, Haojun and Lin, Weihong and Sun, Lei and Zhang, Chao and Hu, Han } ,

title = { DETRs With Hybrid Matching } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 19702-19712 }

}

@InProceedings { Li_2023_CVPR ,

author = { Li, Feng and Zhang, Hao and Xu, Huaizhe and Liu, Shilong and Zhang, Lei and Ni, Lionel M. and Shum, Heung-Yeung } ,

title = { Mask DINO: Towards a Unified Transformer-Based Framework for Object Detection and Segmentation } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 3041-3050 }

}

@article { yan2023bridging ,

title = { Bridging the Gap Between End-to-end and Non-End-to-end Multi-Object Tracking } ,

author = { Yan, Feng and Luo, Weixin and Zhong, Yujie and Gan, Yiyang and Ma, Lin } ,

journal = { arXiv preprint arXiv:2305.12724 } ,

year = { 2023 }

}

@InProceedings { Chen_2023_CVPR ,

author = { Chen, Fangyi and Zhang, Han and Hu, Kai and Huang, Yu-Kai and Zhu, Chenchen and Savvides, Marios } ,

title = { Enhanced Training of Query-Based Object Detection via Selective Query Recollection } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 23756-23765 }

}