Detrexベンチマークペーパーを読む| ?プロジェクトページ| ?€DETREX | ?deepdataspace

ドキュメント|インストール| ?モデル動物園|素晴らしいdetr | ?ニュース| ?報告の問題

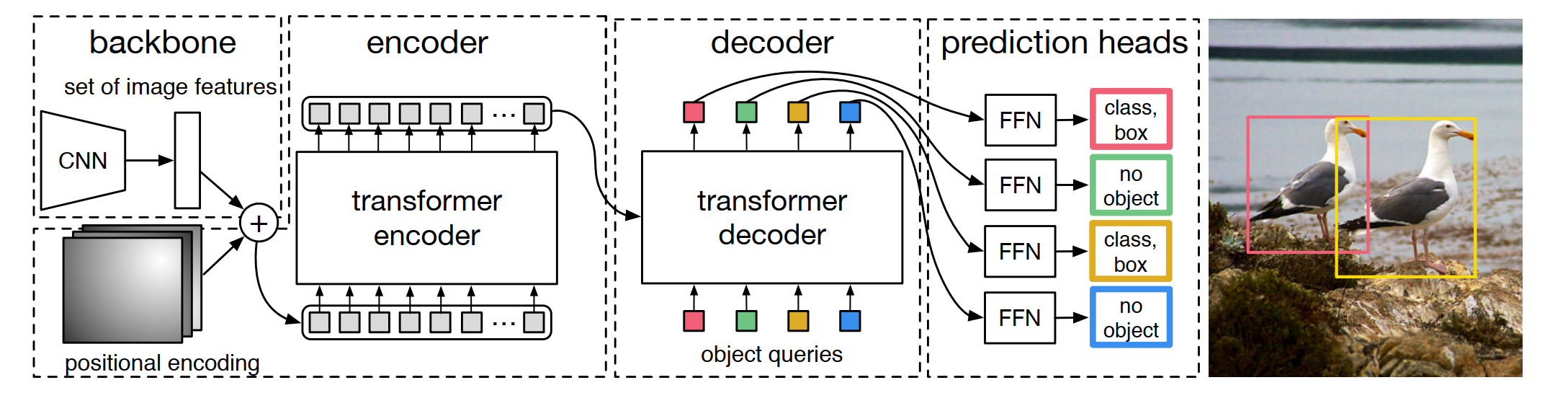

Detrexは、最先端の変圧器ベースの検出アルゴリズムを提供するオープンソースツールボックスです。 Detectron2の上に構築されており、そのモジュール設計はmmdeTectionとDetrから部分的に借用されています。うまく整理されたコードに感謝します。メインブランチは、 Pytorch 1.10+以上で動作します( Pytorch 1.12をお勧めします)。

モジュラー設計。 Detrexは、トランスベースの検出フレームワークをさまざまなコンポーネントに分解し、ユーザーが独自のカスタマイズされたモデルを簡単に構築するのに役立ちます。

強いベースライン。 Detrexは、変圧器ベースの検出モデルに一連の強力なベースラインを提供します。サポートされているほとんどのアルゴリズムの中で、ハイパーパラメーターを最適化することにより、モデルのパフォーマンスを0.2 APから1.1 APから1.1 APから1.1 APからさらに高めました。

使いやすい。 Detrexは、ユーザーが使用できるように、軽量で簡単に設計されています。

Detrexとは別に、レポは、検出とセグメンテーションのためのトランスに関する論文を提示するために、Repo Awesome Detection Transformerもリリースしました。

レポ名Detrexにはいくつかの解釈があります。

DETR-EX :私たちは帽子をDETRに脱ぎ、このレポは変圧器ベースの検出アルゴリズムの拡張と見なしています。

det-rex :レックスは文字通りラテン語の「王」を意味します。このリポジトリが、研究コミュニティから最高の変圧器ベースの検出アルゴリズムを提供することにより、オブジェクトの検出に関する最先端の最先端を前進させるのに役立つことを願っています。

de-t.rex :deはオランダ語で「」を意味します。 T.Rexは、Tyrannosaurus Rexとも呼ばれ、「Tyrant Lizardsの王」を意味し、Dinosaurの略である研究作業「Dino」とつながります。

V0.5.0は16/07/2023にリリースされました。

詳細とリリース履歴については、changelog.mdを参照してください。

インストールの詳細については、インストール手順を参照してください。

Detrexの基本的な使用については、Detrexの開始を参照してください。また、以下の他のチュートリアルも提供しています。

現在、チュートリアルの一部は比較的シンプルなコンテンツで提示されていますが、ユーザーがより良いユーザーエクスペリエンスを実現するのを支援するために、ドキュメントを常に改善します。

完全なAPIドキュメントとチュートリアルについては、ドキュメントを参照してください。

結果とモデルは、モデル動物園で利用できます。

Detrexに基づいて構築されたプロジェクトの詳細については、プロジェクトをご覧ください。

このプロジェクトは、Apache 2.0ライセンスの下でリリースされます。

このツールボックスを調査で使用する場合、またはここで公開されているベースラインの結果を参照する場合は、次のBibtexエントリを使用してください。

@misc { ren2023detrex ,

title = { detrex: Benchmarking Detection Transformers } ,

author = { Tianhe Ren and Shilong Liu and Feng Li and Hao Zhang and Ailing Zeng and Jie Yang and Xingyu Liao and Ding Jia and Hongyang Li and He Cao and Jianan Wang and Zhaoyang Zeng and Xianbiao Qi and Yuhui Yuan and Jianwei Yang and Lei Zhang } ,

year = { 2023 } ,

eprint = { 2306.07265 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { carion2020end ,

title = { End-to-end object detection with transformers } ,

author = { Carion, Nicolas and Massa, Francisco and Synnaeve, Gabriel and Usunier, Nicolas and Kirillov, Alexander and Zagoruyko, Sergey } ,

booktitle = { European conference on computer vision } ,

pages = { 213--229 } ,

year = { 2020 } ,

organization = { Springer }

}

@inproceedings {

zhu2021deformable,

title = { Deformable {{}DETR{}}: Deformable Transformers for End-to-End Object Detection } ,

author = { Xizhou Zhu and Weijie Su and Lewei Lu and Bin Li and Xiaogang Wang and Jifeng Dai } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2021 } ,

url = { https://openreview.net/forum?id=gZ9hCDWe6ke }

}

@inproceedings { meng2021-CondDETR ,

title = { Conditional DETR for Fast Training Convergence } ,

author = { Meng, Depu and Chen, Xiaokang and Fan, Zejia and Zeng, Gang and Li, Houqiang and Yuan, Yuhui and Sun, Lei and Wang, Jingdong } ,

booktitle = { Proceedings of the IEEE International Conference on Computer Vision (ICCV) } ,

year = { 2021 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

zhang2023dino,

title = { {DINO}: {DETR} with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel Ni and Heung-Yeung Shum } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=3mRwyG5one }

}

@InProceedings { Chen_2023_ICCV ,

author = { Chen, Qiang and Chen, Xiaokang and Wang, Jian and Zhang, Shan and Yao, Kun and Feng, Haocheng and Han, Junyu and Ding, Errui and Zeng, Gang and Wang, Jingdong } ,

title = { Group DETR: Fast DETR Training with Group-Wise One-to-Many Assignment } ,

booktitle = { Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) } ,

month = { October } ,

year = { 2023 } ,

pages = { 6633-6642 }

}

@InProceedings { Jia_2023_CVPR ,

author = { Jia, Ding and Yuan, Yuhui and He, Haodi and Wu, Xiaopei and Yu, Haojun and Lin, Weihong and Sun, Lei and Zhang, Chao and Hu, Han } ,

title = { DETRs With Hybrid Matching } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 19702-19712 }

}

@InProceedings { Li_2023_CVPR ,

author = { Li, Feng and Zhang, Hao and Xu, Huaizhe and Liu, Shilong and Zhang, Lei and Ni, Lionel M. and Shum, Heung-Yeung } ,

title = { Mask DINO: Towards a Unified Transformer-Based Framework for Object Detection and Segmentation } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 3041-3050 }

}

@article { yan2023bridging ,

title = { Bridging the Gap Between End-to-end and Non-End-to-end Multi-Object Tracking } ,

author = { Yan, Feng and Luo, Weixin and Zhong, Yujie and Gan, Yiyang and Ma, Lin } ,

journal = { arXiv preprint arXiv:2305.12724 } ,

year = { 2023 }

}

@InProceedings { Chen_2023_CVPR ,

author = { Chen, Fangyi and Zhang, Han and Hu, Kai and Huang, Yu-Kai and Zhu, Chenchen and Savvides, Marios } ,

title = { Enhanced Training of Query-Based Object Detection via Selective Query Recollection } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 23756-23765 }

}