BACA DETREX Benchmarking Paper | ? Halaman Proyek | ? ️Cite Detrex | ? DeepDataSpace

Dokumentasi | Instalasi | ? Model Zoo | Detr yang mengagumkan | ? Berita | Masalah pelaporan

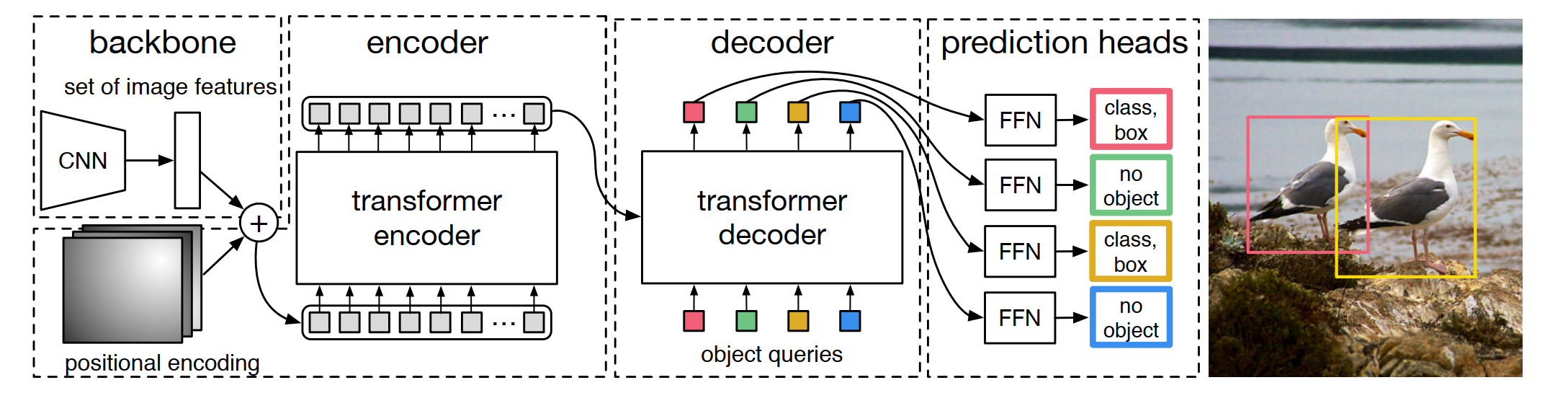

Detrex adalah kotak alat open-source yang menyediakan algoritma deteksi berbasis transformator canggih. Ini dibangun di atas detectron2 dan desain modulnya sebagian dipinjam dari mmdetection dan detr. Terima kasih banyak atas kode mereka yang terorganisir dengan baik. Cabang utama bekerja dengan Pytorch 1.10+ atau lebih tinggi (kami sarankan Pytorch 1.12 ).

Desain Modular. Detrex menguraikan kerangka deteksi berbasis transformator menjadi berbagai komponen yang membantu pengguna dengan mudah membangun model yang disesuaikan sendiri.

Garis dasar yang kuat. Detrex menyediakan serangkaian garis dasar yang kuat untuk model deteksi berbasis transformator. Kami lebih lanjut meningkatkan kinerja model dari 0,2 AP menjadi 1,1 AP melalui mengoptimalkan hyper-parameter di antara sebagian besar algoritma yang didukung.

Mudah digunakan. Detrex dirancang untuk menjadi berat dan mudah untuk digunakan pengguna:

Selain Detrex, kami juga merilis repo transformator deteksi yang luar biasa untuk menyajikan makalah tentang transformator untuk deteksi dan segmentasi.

Nama repo Detrex memiliki beberapa interpretasi:

DETR-EX : Kami melepas topi kami untuk melakukan detr dan menganggap repo ini sebagai perpanjangan dari algoritma deteksi berbasis transformator.

Det-Rex : Rex secara harfiah berarti 'raja' dalam bahasa Latin. Kami berharap repo ini dapat membantu memajukan keadaan seni pada deteksi objek dengan memberikan algoritma deteksi berbasis transformator terbaik dari komunitas penelitian.

de-t.rex : de berarti 'the' dalam bahasa Belanda. T.Rex, juga disebut Tyrannosaurus Rex, berarti 'Raja kadal tiran' dan terhubung ke pekerjaan penelitian kami 'Dino', yang merupakan kependekan dari Dinosaur.

V0.5.0 dirilis pada 16/07/2023:

Silakan lihat changelog.md untuk detail dan riwayat rilis.

Silakan merujuk ke instruksi instalasi untuk detail instalasi.

Silakan merujuk untuk memulai dengan Detrex untuk penggunaan dasar Detrex. Kami juga menyediakan tutorial lain untuk:

Meskipun beberapa tutorial saat ini disajikan dengan konten yang relatif sederhana, kami akan terus meningkatkan dokumentasi kami untuk membantu pengguna mencapai pengalaman pengguna yang lebih baik.

Silakan lihat dokumentasi untuk dokumentasi dan tutorial API lengkap.

Hasil dan model tersedia di Model Zoo.

Silakan lihat proyek untuk detail tentang proyek yang dibangun berdasarkan Detrex.

Proyek ini dirilis di bawah lisensi Apache 2.0.

Jika Anda menggunakan kotak alat ini dalam penelitian Anda atau ingin merujuk ke hasil dasar yang diterbitkan di sini, silakan gunakan entri Bibtex berikut:

@misc { ren2023detrex ,

title = { detrex: Benchmarking Detection Transformers } ,

author = { Tianhe Ren and Shilong Liu and Feng Li and Hao Zhang and Ailing Zeng and Jie Yang and Xingyu Liao and Ding Jia and Hongyang Li and He Cao and Jianan Wang and Zhaoyang Zeng and Xianbiao Qi and Yuhui Yuan and Jianwei Yang and Lei Zhang } ,

year = { 2023 } ,

eprint = { 2306.07265 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { carion2020end ,

title = { End-to-end object detection with transformers } ,

author = { Carion, Nicolas and Massa, Francisco and Synnaeve, Gabriel and Usunier, Nicolas and Kirillov, Alexander and Zagoruyko, Sergey } ,

booktitle = { European conference on computer vision } ,

pages = { 213--229 } ,

year = { 2020 } ,

organization = { Springer }

}

@inproceedings {

zhu2021deformable,

title = { Deformable {{}DETR{}}: Deformable Transformers for End-to-End Object Detection } ,

author = { Xizhou Zhu and Weijie Su and Lewei Lu and Bin Li and Xiaogang Wang and Jifeng Dai } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2021 } ,

url = { https://openreview.net/forum?id=gZ9hCDWe6ke }

}

@inproceedings { meng2021-CondDETR ,

title = { Conditional DETR for Fast Training Convergence } ,

author = { Meng, Depu and Chen, Xiaokang and Fan, Zejia and Zeng, Gang and Li, Houqiang and Yuan, Yuhui and Sun, Lei and Wang, Jingdong } ,

booktitle = { Proceedings of the IEEE International Conference on Computer Vision (ICCV) } ,

year = { 2021 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

zhang2023dino,

title = { {DINO}: {DETR} with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel Ni and Heung-Yeung Shum } ,

booktitle = { The Eleventh International Conference on Learning Representations } ,

year = { 2023 } ,

url = { https://openreview.net/forum?id=3mRwyG5one }

}

@InProceedings { Chen_2023_ICCV ,

author = { Chen, Qiang and Chen, Xiaokang and Wang, Jian and Zhang, Shan and Yao, Kun and Feng, Haocheng and Han, Junyu and Ding, Errui and Zeng, Gang and Wang, Jingdong } ,

title = { Group DETR: Fast DETR Training with Group-Wise One-to-Many Assignment } ,

booktitle = { Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) } ,

month = { October } ,

year = { 2023 } ,

pages = { 6633-6642 }

}

@InProceedings { Jia_2023_CVPR ,

author = { Jia, Ding and Yuan, Yuhui and He, Haodi and Wu, Xiaopei and Yu, Haojun and Lin, Weihong and Sun, Lei and Zhang, Chao and Hu, Han } ,

title = { DETRs With Hybrid Matching } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 19702-19712 }

}

@InProceedings { Li_2023_CVPR ,

author = { Li, Feng and Zhang, Hao and Xu, Huaizhe and Liu, Shilong and Zhang, Lei and Ni, Lionel M. and Shum, Heung-Yeung } ,

title = { Mask DINO: Towards a Unified Transformer-Based Framework for Object Detection and Segmentation } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 3041-3050 }

}

@article { yan2023bridging ,

title = { Bridging the Gap Between End-to-end and Non-End-to-end Multi-Object Tracking } ,

author = { Yan, Feng and Luo, Weixin and Zhong, Yujie and Gan, Yiyang and Ma, Lin } ,

journal = { arXiv preprint arXiv:2305.12724 } ,

year = { 2023 }

}

@InProceedings { Chen_2023_CVPR ,

author = { Chen, Fangyi and Zhang, Han and Hu, Kai and Huang, Yu-Kai and Zhu, Chenchen and Savvides, Marios } ,

title = { Enhanced Training of Query-Based Object Detection via Selective Query Recollection } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 23756-23765 }

}