Этот проект реализует пользовательский вопрос, отвечающий на чат -бот с использованием Langchain и Google Gemini Language Model (LLM). Чатбот обучен промышленным данным с платформы онлайн -обучения, состоящий из вопросов и соответствующих ответов.

Рабочий процесс проекта включает в себя следующие шаги:

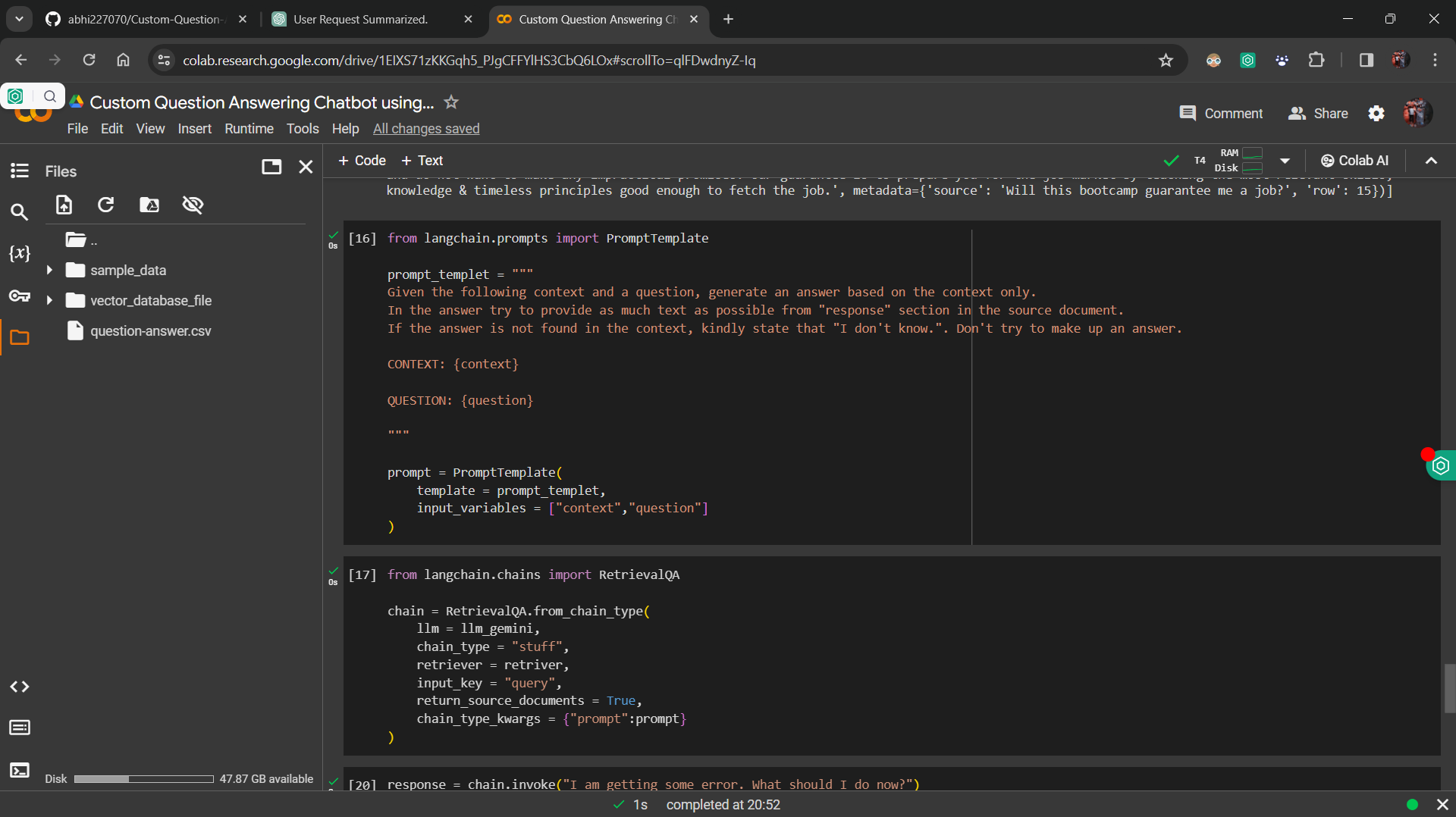

FIN-настройка данных : Google Gemini LLM точно настроена на промышленные данные, гарантируя, что модель может точно отвечать на вопросы на основе предоставленного контекста.

Внедрение и векторная база данных : встраивание предложений HuggingFace используется для преобразования вопросов и ответов в векторы, которые хранятся в векторной базе данных.

Реализация Retriever : разработанный компонент для извлечения аналогичных векторов из векторной базы данных на основе запроса пользователя.

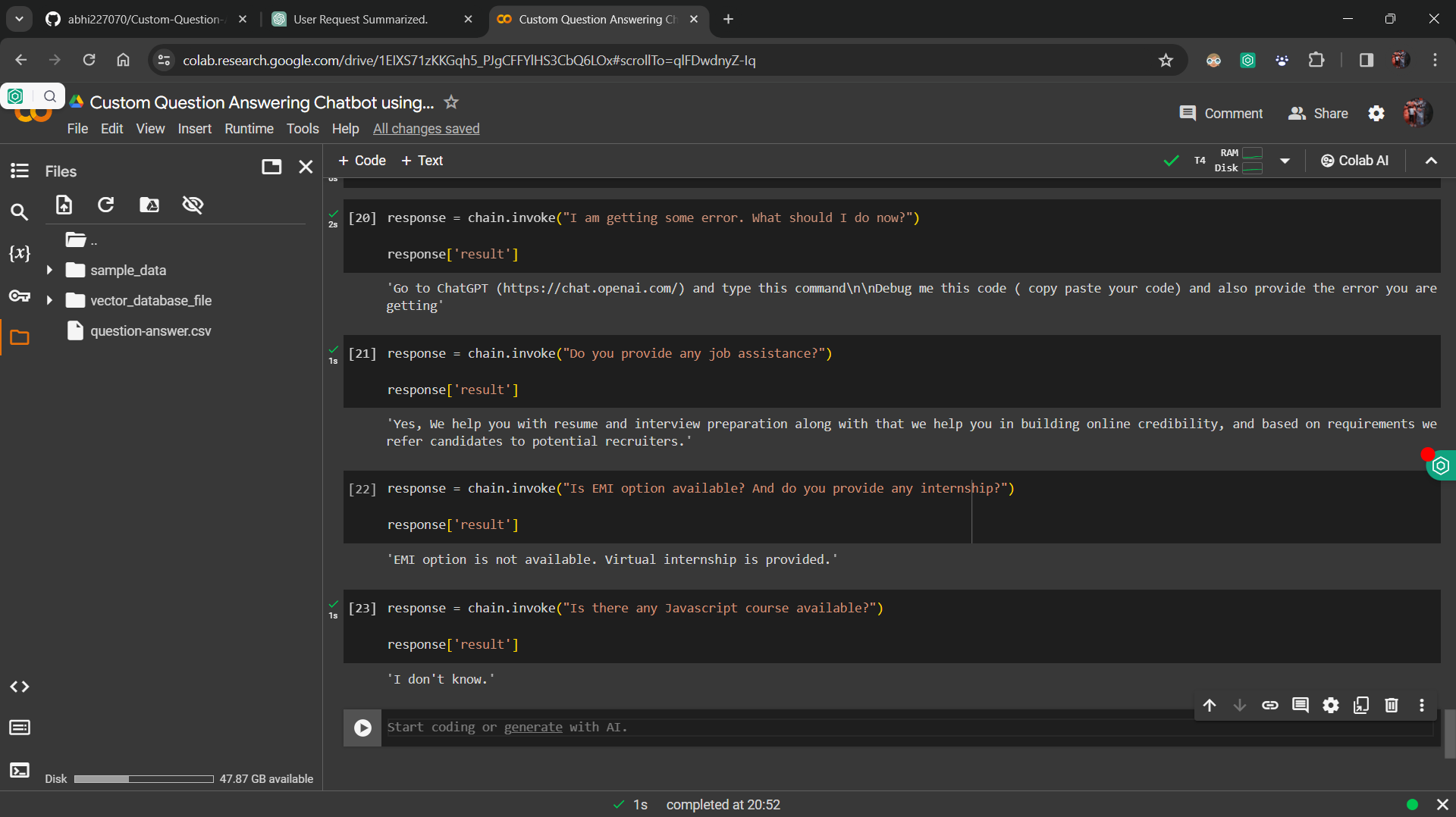

Интеграция с цепочкой Langchain Retrivalqa : компоненты интегрируются в цепь с использованием цепочки Langchain Retrivalqa, которая обрабатывает входящие запросы и извлекает соответствующие ответы.

Пользовательский интерфейс : Streamlit используется для создания простого пользовательского интерфейса, позволяя пользователям вводить свои вопросы и получать ответы от чат -бота.

Чтобы запустить проект локально, следуйте этим шагам:

requirements.txt .streamlit run app.py в вашем терминале.

Пользовательский вопрос, отвечающий на чат -бот, служит различным целям, в том числе:

Этот проект лицензирован по лицензии MIT.