Dieses Projekt implementiert eine benutzerdefinierte Frage, die Chatbot mit Langchain und Google Gemini Language Model (LLM) beantwortet. Der Chatbot ist auf industriellen Daten aus einer Online -Lernplattform geschult, die aus Fragen und entsprechenden Antworten besteht.

Der Projekt -Workflow umfasst die folgenden Schritte:

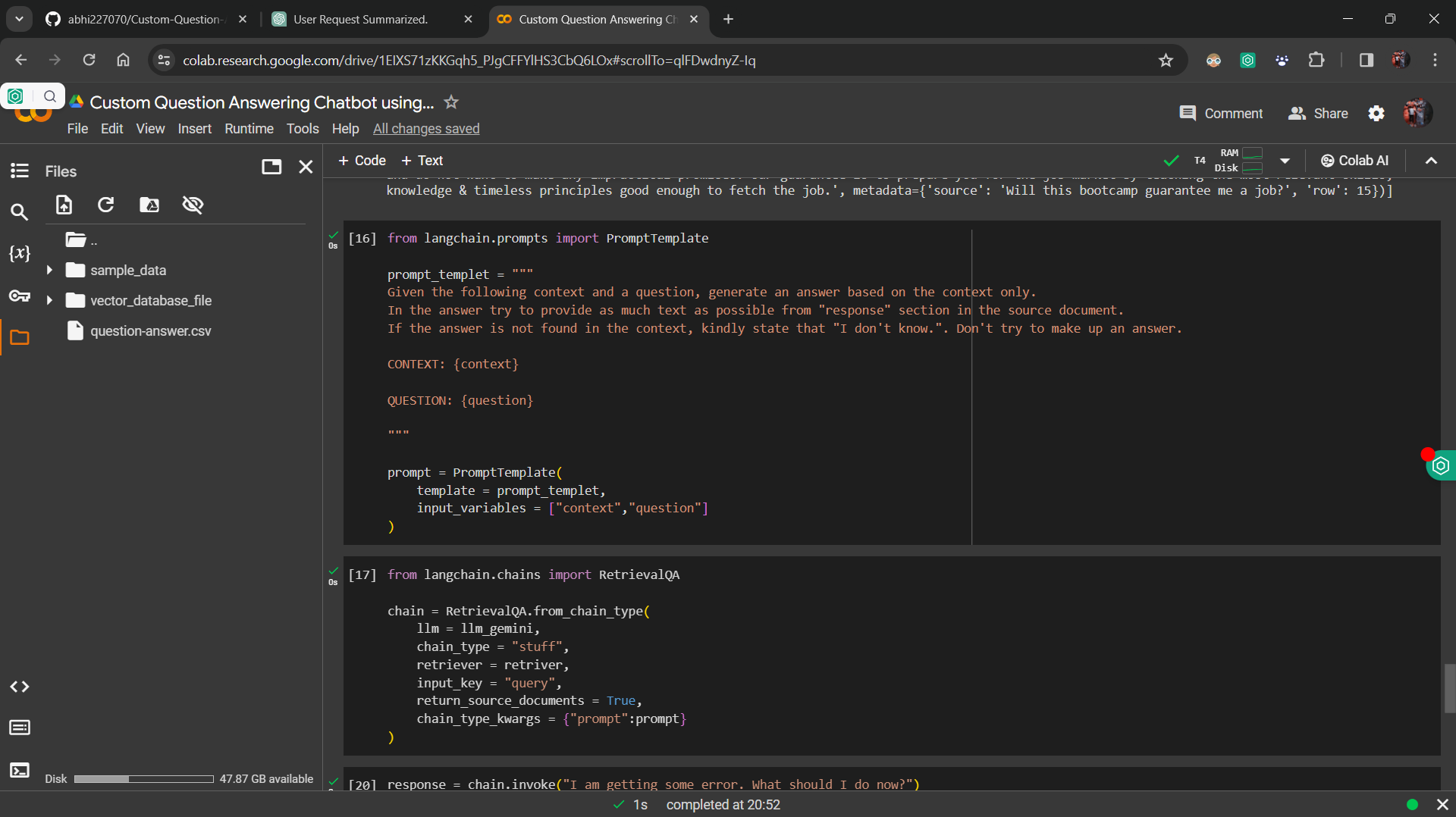

Datenfeineinstellung : Das Google Gemini LLM ist mit den industriellen Daten gut abgestimmt, um sicherzustellen, dass das Modell Fragen basierend auf dem bereitgestellten Kontext genau beantworten kann.

Einbettung und Vektordatenbank : Die Einbettung von Huggingface -Satz wird verwendet, um Fragen und Antworten in Vektoren umzuwandeln, die in einer Vektordatenbank gespeichert sind.

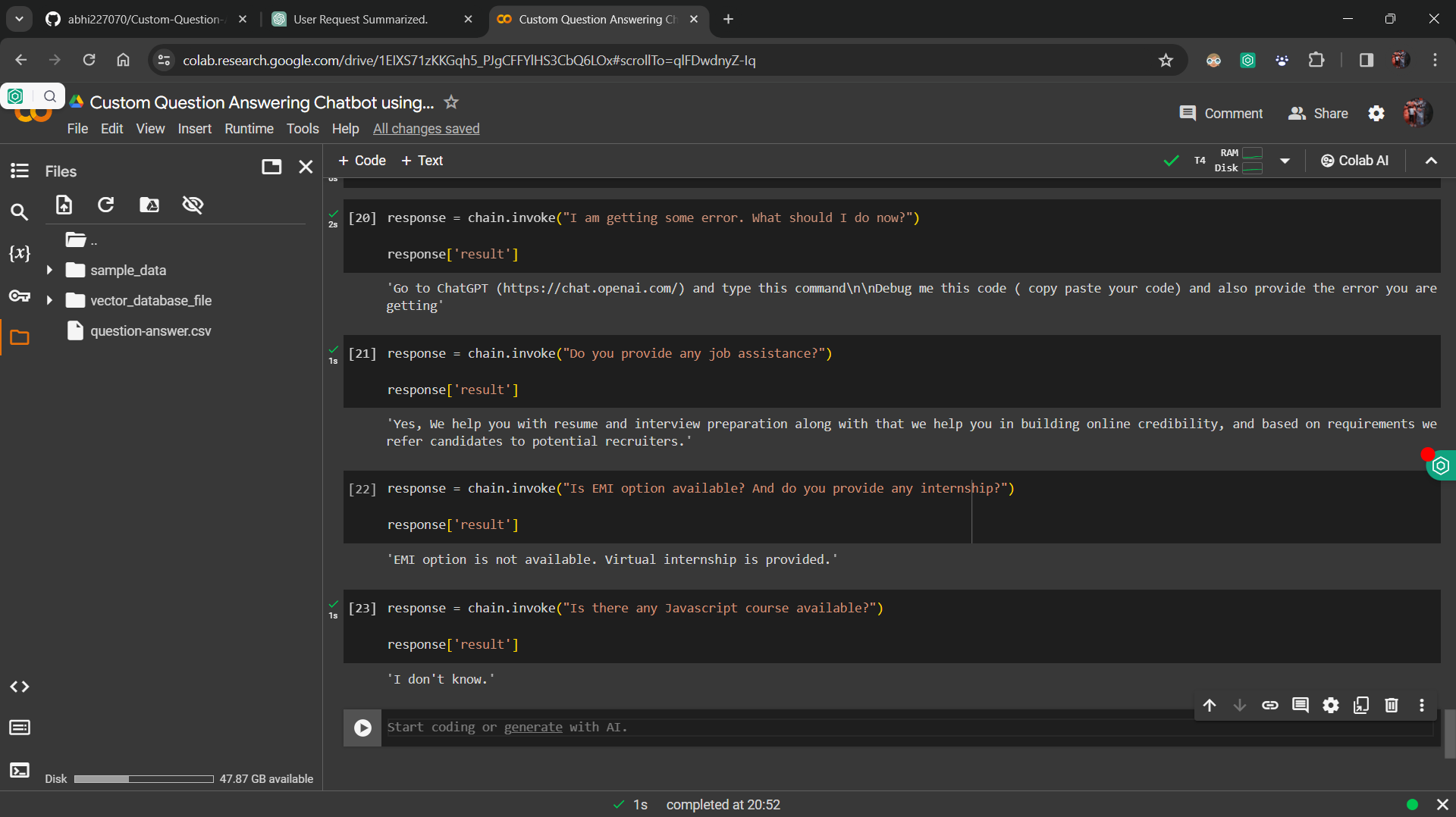

Retriever-Implementierung : Eine Retriever-Komponente wurde entwickelt, um ähnlich aussehende Vektoren aus der Vektor-Datenbank basierend auf der Abfrage des Benutzers abzurufen.

Integration mit Langchain RetivalQA -Kette : Die Komponenten werden unter Verwendung der Langchain -Retivalqa -Kette in eine Kette integriert, die eingehende Abfragen verarbeitet und relevante Antworten abruft.

Benutzeroberfläche : StreamLit wird verwendet, um eine einfache Benutzeroberfläche zu erstellen, mit der Benutzer ihre Fragen eingeben und Antworten aus dem Chatbot erhalten können.

Befolgen Sie die folgenden Schritte, um das Projekt lokal auszuführen:

requirements.txt aufgeführt sind.streamlit run app.py in Ihrem Terminal ausführen.

Die benutzerdefinierte Frage zur Beantwortung von Chatbot dient verschiedenen Zwecken, darunter:

Dieses Projekt ist unter der MIT -Lizenz lizenziert.