Este proyecto implementa una pregunta personalizada que responde a ChatBot usando Langchain y Google Gemini Language Model (LLM). El chatbot está capacitado en datos industriales de una plataforma de aprendizaje en línea, que consiste en preguntas y respuestas correspondientes.

El flujo de trabajo del proyecto implica los siguientes pasos:

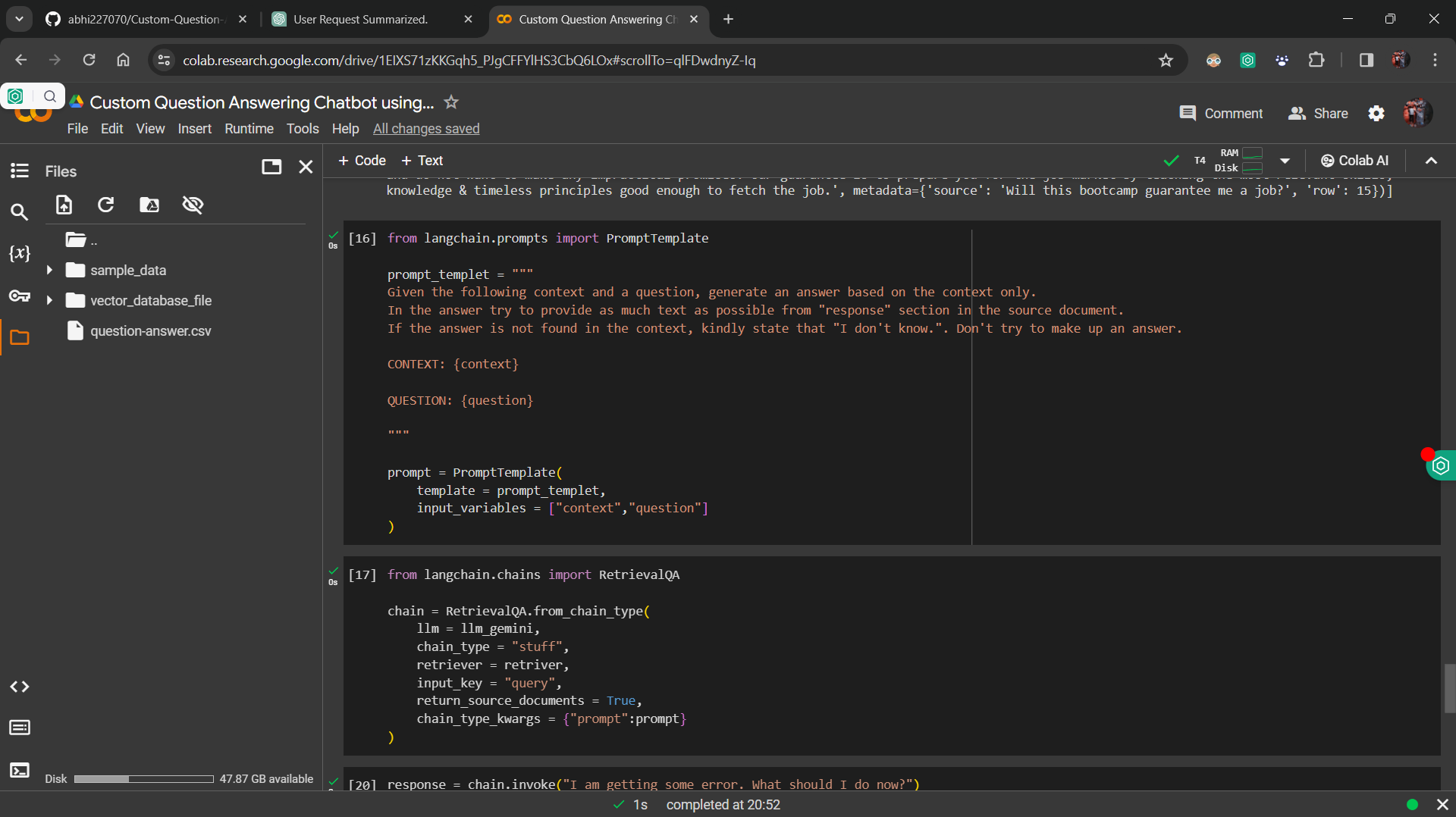

Datos ajustados : el Google Gemini LLM está ajustado con los datos industriales, asegurando que el modelo pueda responder con precisión las preguntas basadas en el contexto proporcionado.

Incrustación y base de datos de vectores : la incrustación de oración de Facefacface se utiliza para convertir preguntas y respuestas en vectores, que se almacenan en una base de datos vectorial.

Implementación de Retriever : se desarrolla un componente Retriever para recuperar vectores de aspecto similar de la base de datos Vector basada en la consulta del usuario.

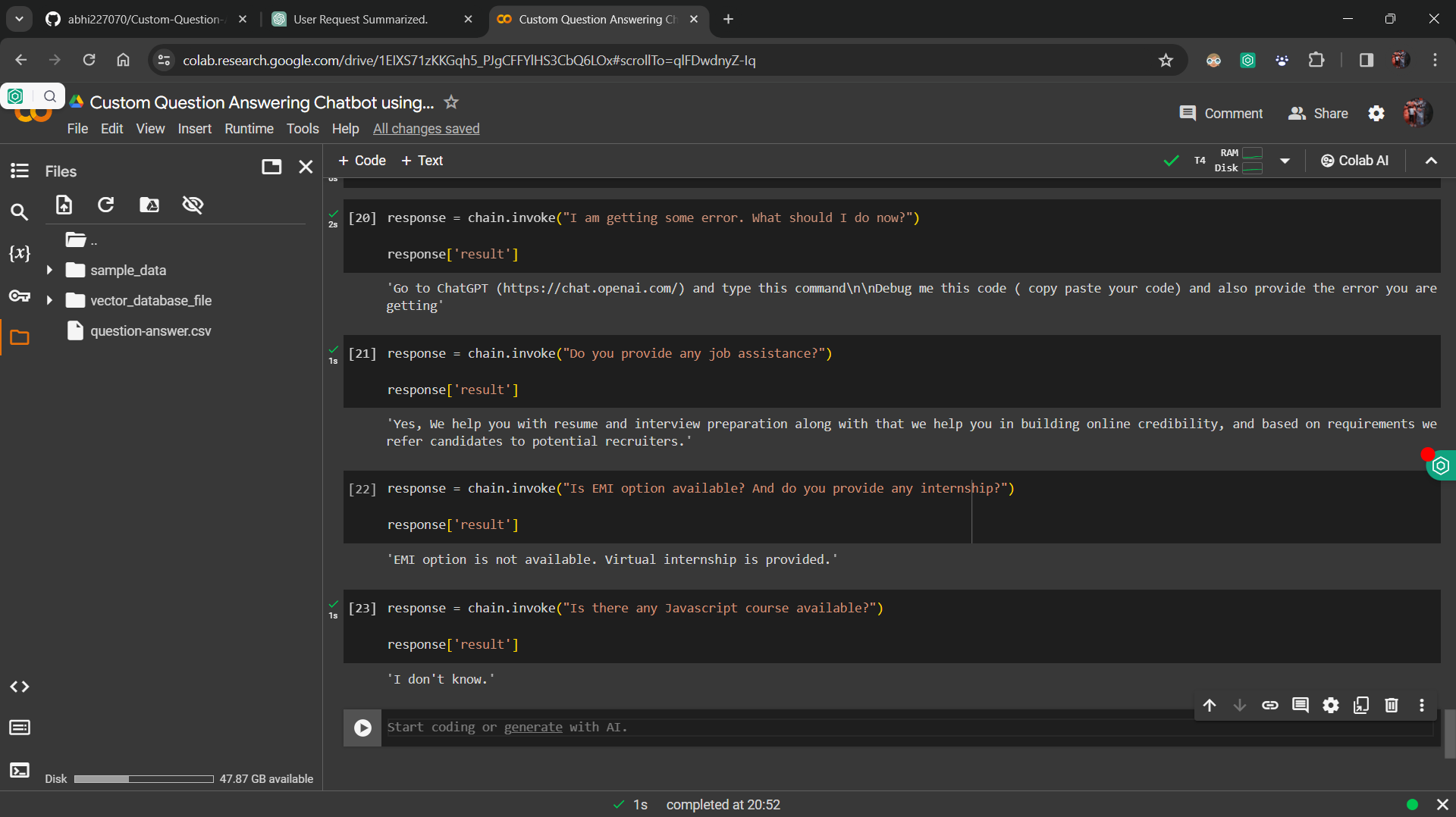

Integración con la cadena de recuperación de Langchain : los componentes se integran en una cadena utilizando la cadena de recuperación Langchain, que procesa consultas entrantes y recupera respuestas relevantes.

Interfaz de usuario : Streamlit se usa para crear una interfaz de usuario simple, lo que permite a los usuarios ingresar sus preguntas y recibir respuestas del chatbot.

Para ejecutar el proyecto localmente, siga estos pasos:

requirements.txt .streamlit run app.py en su terminal.

La pregunta personalizada que responde chatbot tiene varios propósitos, que incluyen:

Este proyecto tiene licencia bajo la licencia MIT.