Este projeto implementa um chatbot de perguntas personalizadas usando o Langchain e o Google Gemini Language Model (LLM). O chatbot é treinado em dados industriais de uma plataforma de aprendizado on -line, consistindo em perguntas e respostas correspondentes.

O fluxo de trabalho do projeto envolve as seguintes etapas:

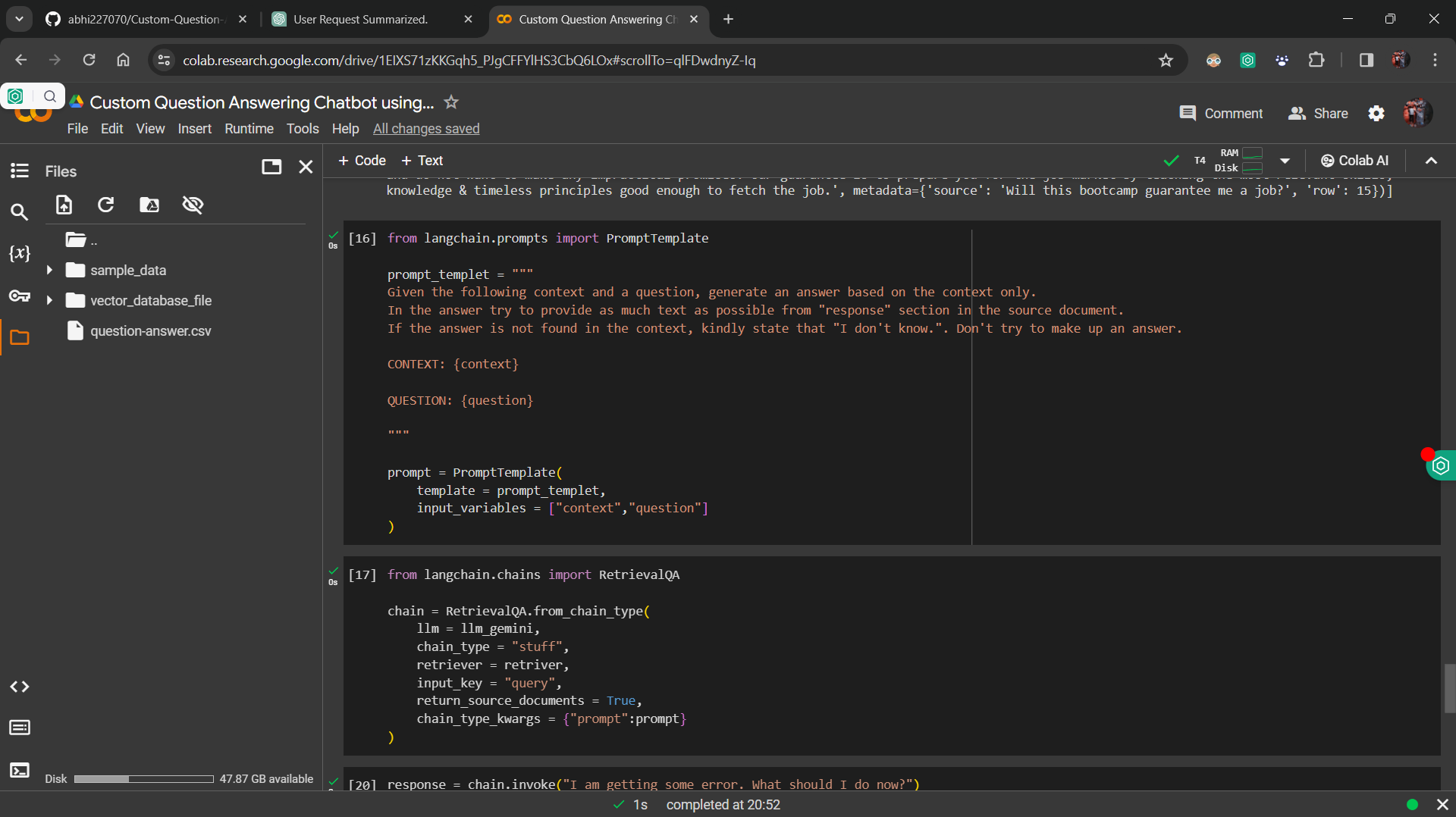

Data Fine Tuning : O Google Gemini LLM está ajustado com os dados industriais, garantindo que o modelo possa responder com precisão perguntas com base no contexto fornecido.

Banco de dados de incorporação e vetor : a incorporação da Sentença Huggingface é utilizada para converter perguntas e respostas em vetores, que são armazenados em um banco de dados vetorial.

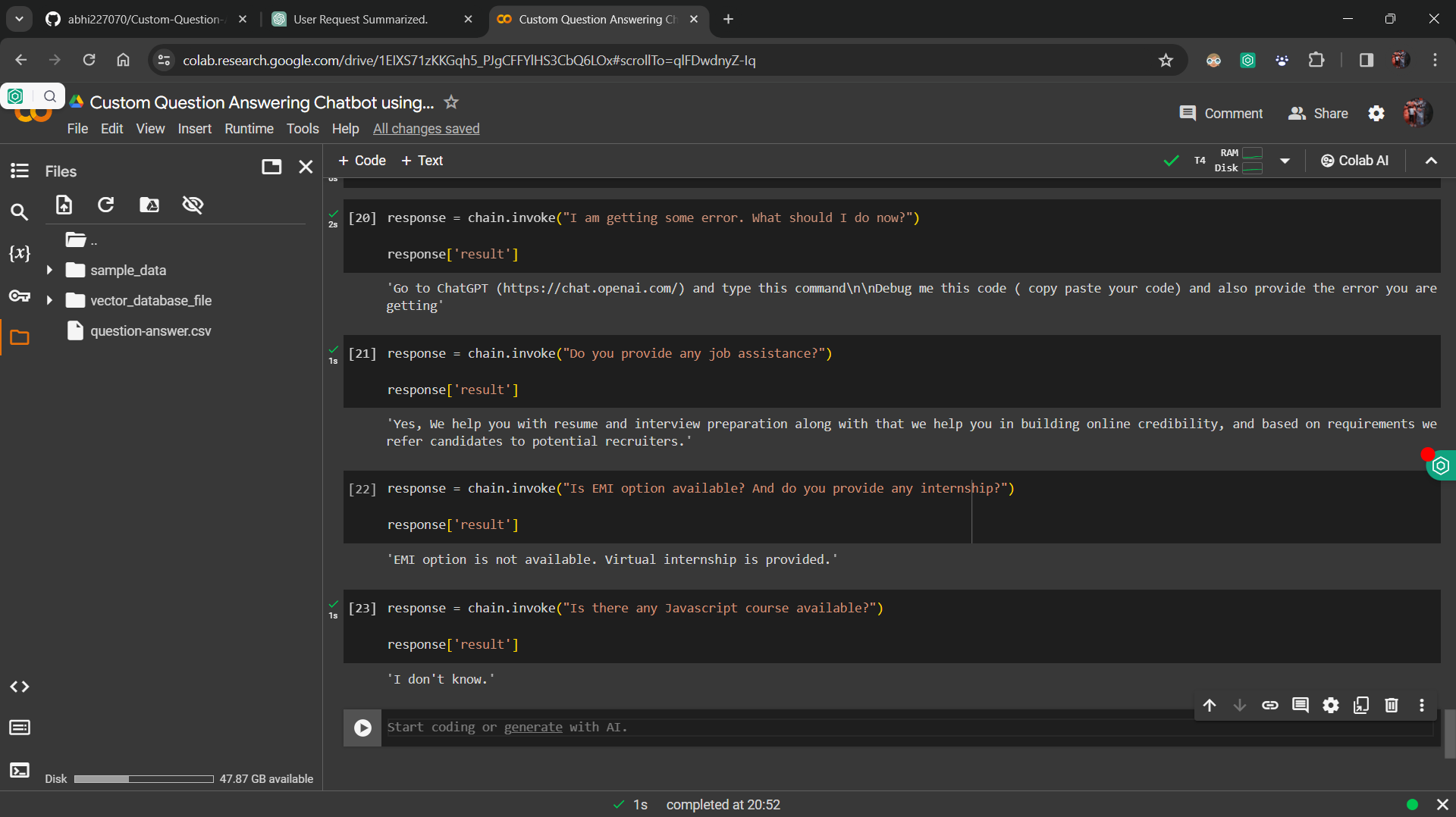

Implementação do Retriever : Um componente Retriever é desenvolvido para recuperar vetores de aparência semelhante do banco de dados do vetor com base na consulta do usuário.

Integração com a cadeia Langchain RetivalQA : os componentes são integrados a uma cadeia usando cadeia Langchain RetivalQA, que processa consultas recebidas e recupera respostas relevantes.

Interface do usuário : o streamlit é usado para criar uma interface simples do usuário, permitindo que os usuários inseram suas perguntas e recebam respostas do chatbot.

Para executar o projeto localmente, siga estas etapas:

requirements.txt .streamlit run app.py no seu terminal.

A pergunta personalizada que responde a chatbot serve a vários propósitos, incluindo:

Este projeto está licenciado sob a licença do MIT.