Ce projet met en œuvre une question personnalisée répondant au chatbot à l'aide de Langchain et Google Gemini Language Model (LLM). Le chatbot est formé sur les données industrielles d'une plate-forme d'apprentissage en ligne, composée de questions et de réponses correspondantes.

Le flux de travail du projet implique les étapes suivantes:

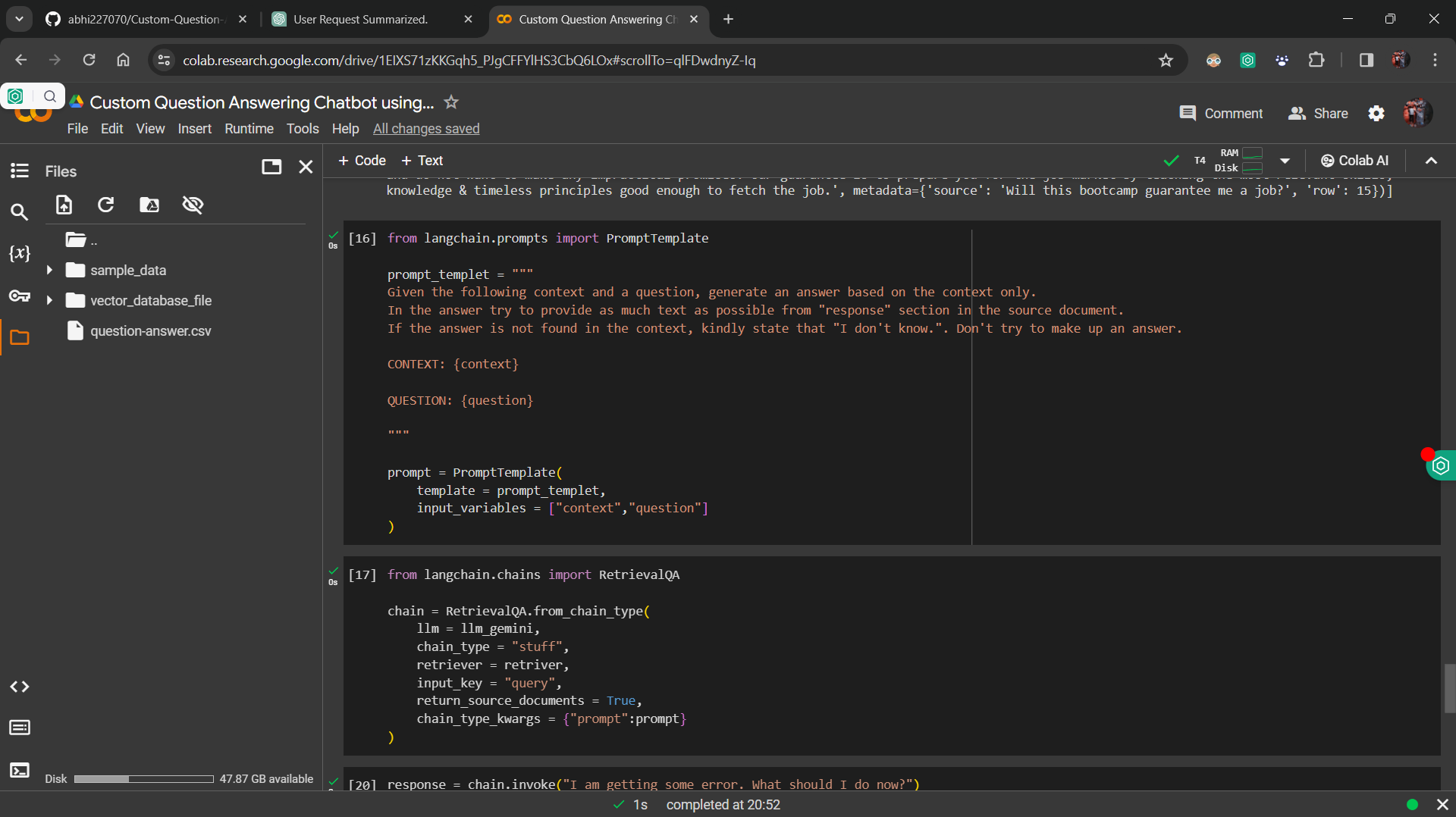

Données ajustées : le Google Gemini LLM est affiné avec les données industrielles, garantissant que le modèle peut répondre avec précision aux questions en fonction du contexte fourni.

Base de données d'incorporation et vectorielle : L'intégration de la phrase en étreinte est utilisée pour convertir des questions et des réponses en vecteurs, qui sont stockés dans une base de données vectorielle.

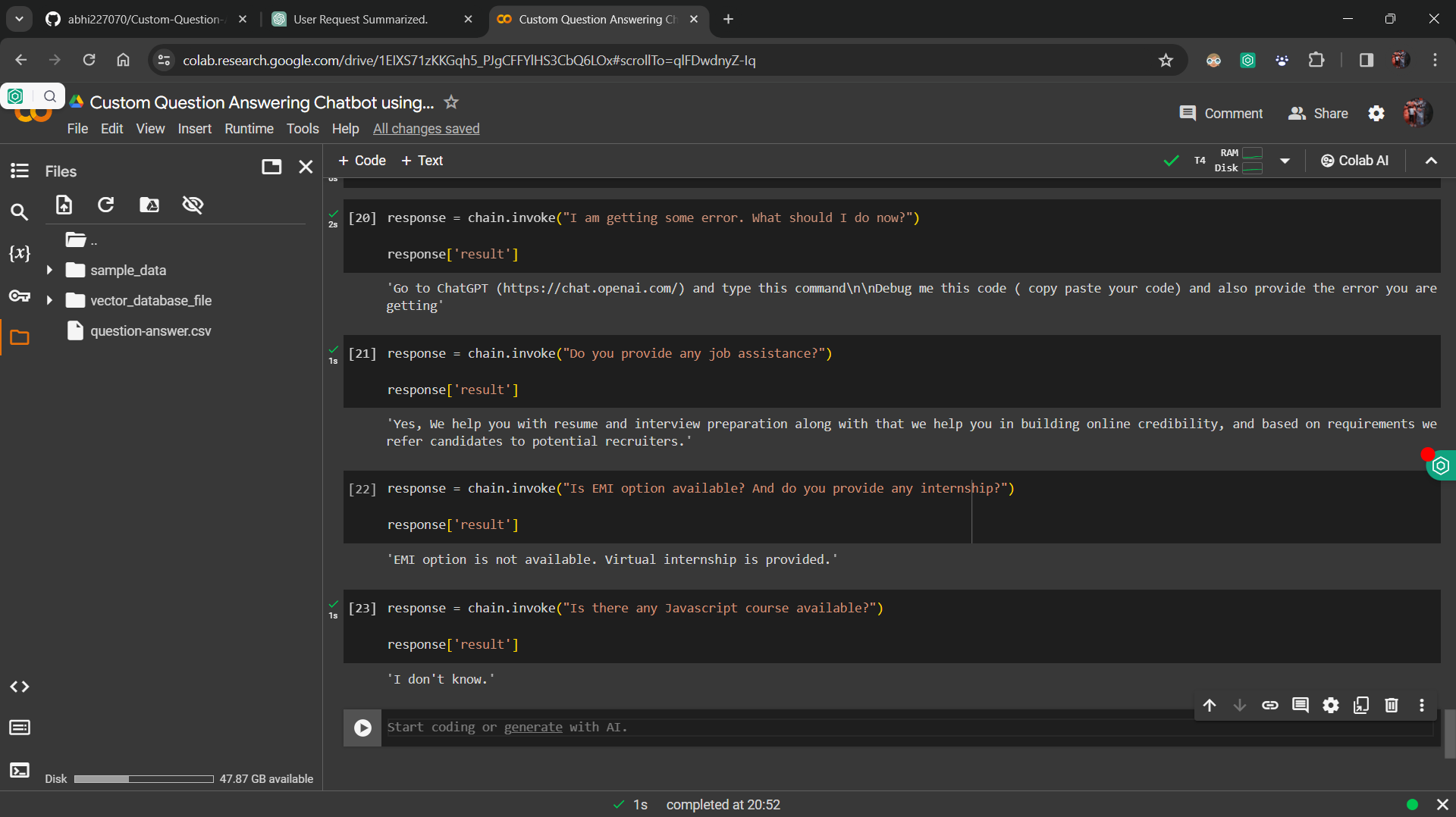

Implémentation de retriever : un composant Retriever est développé pour récupérer des vecteurs similaires à partir de la base de données vectorielle en fonction de la requête de l'utilisateur.

Intégration avec la chaîne Langchain RetrvalQA : les composants sont intégrés dans une chaîne à l'aide de la chaîne Langchain RetrvalQA, qui traite les requêtes entrantes et récupère les réponses pertinentes.

Interface utilisateur : Streamlit est utilisé pour créer une interface utilisateur simple, permettant aux utilisateurs de saisir leurs questions et de recevoir des réponses du chatbot.

Pour exécuter le projet localement, suivez ces étapes:

requirements.txt .streamlit run app.py dans votre terminal.

La question personnalisée répondant au chatbot sert à diverses fins, notamment:

Ce projet est autorisé sous la licence du MIT.