Веб -сайт | Документы | Учебные пособия | Детская площадка | Блог | Раздор

NOS - это быстрый и гибкий сервер вывода Pytorch, который работает в любом облаке или AI HW.

inf2 ).Мы настоятельно рекомендуем вам пойти в наше руководство по QuickStart, чтобы начать работу. Чтобы установить клиент NOS, вы можете запустить следующую команду:

conda create -n nos python=3.8 -y

conda activate nos

pip install torch-nos Как только клиент будет установлен, вы можете запустить NOS -сервер через CLI serve . Это автоматически обнаружит вашу локальную среду, загрузит изображение Docker Runtime и разверните сервер NOS:

nos serve up --http --logging-level INFO Теперь вы готовы запустить свой первый запрос о выводе с nos! Вы можете запустить любую из следующих команд, чтобы попробовать все. Вы можете установить уровень журнала для DEBUG , если вам нужна более подробная информация с сервера.

NOS предоставляет OpenAI-совместимый сервер с поддержкой потоковой передачи, чтобы вы могли подключить свой любимый клиент LLM, совместимый с OpenAI, чтобы поговорить с NOS.

GRPC API ⚡

from nos . client import Client

client = Client ()

model = client . Module ( "TinyLlama/TinyLlama-1.1B-Chat-v1.0" )

response = model . chat ( message = "Tell me a story of 1000 words with emojis" , _stream = True )REST API

curl

-X POST http://localhost:8000/v1/chat/completions

-H " Content-Type: application/json "

-d ' {

"model": "TinyLlama/TinyLlama-1.1B-Chat-v1.0",

"messages": [{

"role": "user",

"content": "Tell me a story of 1000 words with emojis"

}],

"temperature": 0.7,

"stream": true

} 'Построить боты дискордов в получении за секунды.

GRPC API ⚡

from nos . client import Client

client = Client ()

sdxl = client . Module ( "stabilityai/stable-diffusion-xl-base-1-0" )

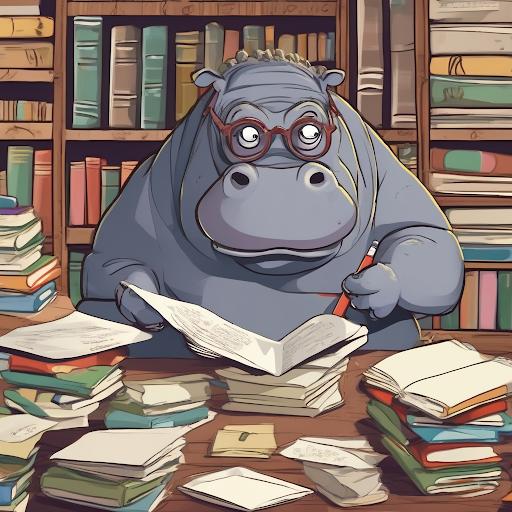

image , = sdxl ( prompts = [ "hippo with glasses in a library, cartoon styling" ],

width = 1024 , height = 1024 , num_images = 1 )REST API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "stabilityai/stable-diffusion-xl-base-1-0",

"inputs": {

"prompts": ["hippo with glasses in a library, cartoon styling"],

"width": 1024, "height": 1024,

"num_images": 1

}

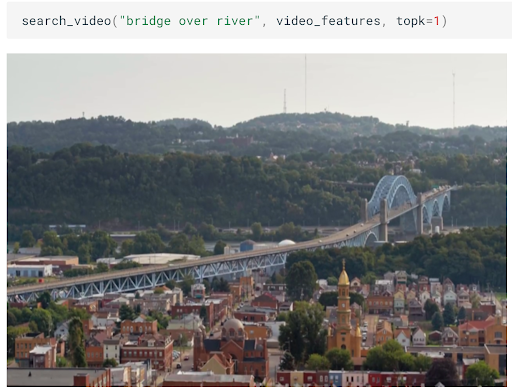

} 'Создайте масштабируемый семантический поиск изображений/видео за считанные минуты.

GRPC API ⚡

from nos . client import Client

client = Client ()

clip = client . Module ( "openai/clip-vit-base-patch32" )

txt_vec = clip . encode_text ( texts = [ "fox jumped over the moon" ])REST API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "openai/clip-vit-base-patch32",

"method": "encode_text",

"inputs": {

"texts": ["fox jumped over the moon"]

}

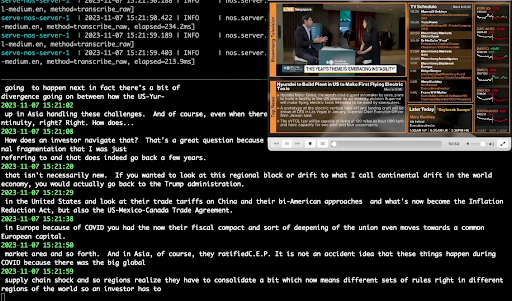

} 'Выполните транскрипцию звука в реальном времени, используя Whisper.

GRPC API ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "openai/whisper-small.en" )

with client . UploadFile ( Path ( "audio.wav" )) as remote_path :

response = model ( path = remote_path )

# {"chunks": ...}REST API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=openai/whisper-small.en '

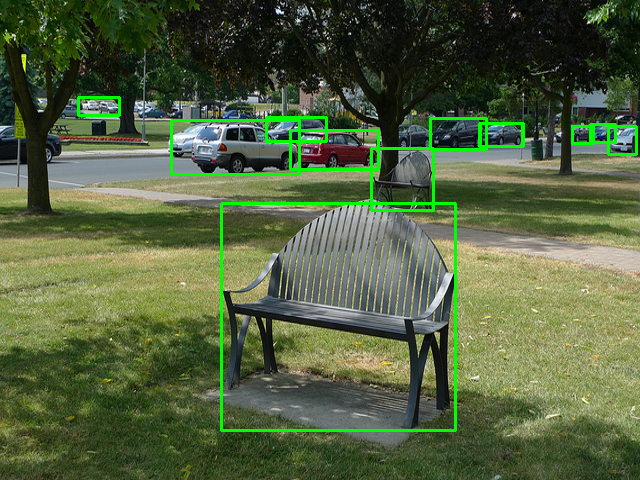

-F ' [email protected] 'Запустите классические задачи компьютерного видения в 2 строках кода.

GRPC API ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "yolox/medium" )

response = model ( images = [ Image . open ( "image.jpg" )])REST API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=yolox/medium '

-F ' [email protected] 'Хотите запустить модели, не поддерживаемые NOS? Вы можете легко добавить свои собственные модели, следуя примерам на игровой площадке NOS.

Этот проект лицензирован по лицензии Apache-2.0.

NOS собирает анонимные данные об использовании с использованием Sentry. Это используется, чтобы помочь нам понять, как сообщество использует NOS, и для того, чтобы помочь нам определить приоритеты функций. Вы можете отказаться от телеметрии, установив NOS_TELEMETRY_ENABLED=0 .

Мы приветствуем вклад! Пожалуйста, смотрите наше руководство для получения дополнительной информации.