Site | DOCs | Tutoriais | Playground | Blog | Discórdia

O NOS é um servidor de inferência Pytorch rápido e flexível que é executado em qualquer nuvem ou AI HW.

inf2 ).É altamente recomendável que você vá ao nosso Guia de Investimento Quick para começar. Para instalar o cliente NOS, você pode executar o seguinte comando:

conda create -n nos python=3.8 -y

conda activate nos

pip install torch-nos Depois que o cliente estiver instalado, você pode iniciar o servidor NOS através da CLI da serve . Isso detectará automaticamente o seu ambiente local, baixará a imagem do tempo de execução do Docker e aplicará o servidor NOS:

nos serve up --http --logging-level INFO Agora você está pronto para executar seu primeiro pedido de inferência com a NOS! Você pode executar qualquer um dos seguintes comandos para experimentar as coisas. Você pode definir o nível de log para DEBUG se quiser obter informações mais detalhadas do servidor.

O NOS fornece um servidor compatível com o OpenAI com suporte de streaming para que você possa conectar seu cliente LLM compatível com o OpenAI favorito para conversar com o NOS.

API GRPC ⚡

from nos . client import Client

client = Client ()

model = client . Module ( "TinyLlama/TinyLlama-1.1B-Chat-v1.0" )

response = model . chat ( message = "Tell me a story of 1000 words with emojis" , _stream = True )Rest API

curl

-X POST http://localhost:8000/v1/chat/completions

-H " Content-Type: application/json "

-d ' {

"model": "TinyLlama/TinyLlama-1.1B-Chat-v1.0",

"messages": [{

"role": "user",

"content": "Tell me a story of 1000 words with emojis"

}],

"temperature": 0.7,

"stream": true

} 'Construa os bots Discord Midjourney em segundos.

API GRPC ⚡

from nos . client import Client

client = Client ()

sdxl = client . Module ( "stabilityai/stable-diffusion-xl-base-1-0" )

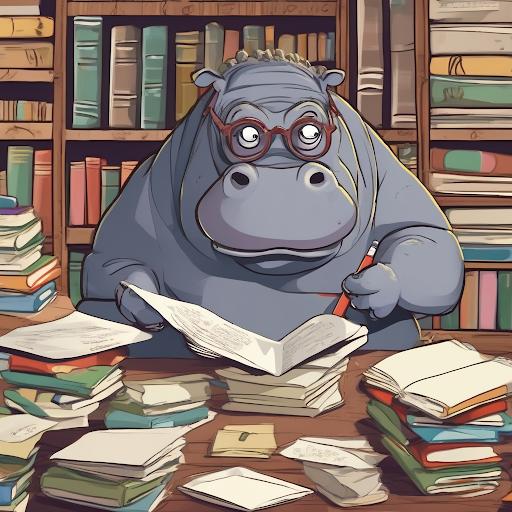

image , = sdxl ( prompts = [ "hippo with glasses in a library, cartoon styling" ],

width = 1024 , height = 1024 , num_images = 1 )Rest API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "stabilityai/stable-diffusion-xl-base-1-0",

"inputs": {

"prompts": ["hippo with glasses in a library, cartoon styling"],

"width": 1024, "height": 1024,

"num_images": 1

}

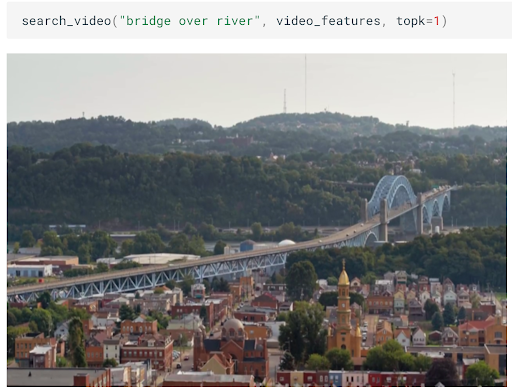

} 'Construa pesquisa semântica escalável de imagens/vídeos em minutos.

API GRPC ⚡

from nos . client import Client

client = Client ()

clip = client . Module ( "openai/clip-vit-base-patch32" )

txt_vec = clip . encode_text ( texts = [ "fox jumped over the moon" ])Rest API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "openai/clip-vit-base-patch32",

"method": "encode_text",

"inputs": {

"texts": ["fox jumped over the moon"]

}

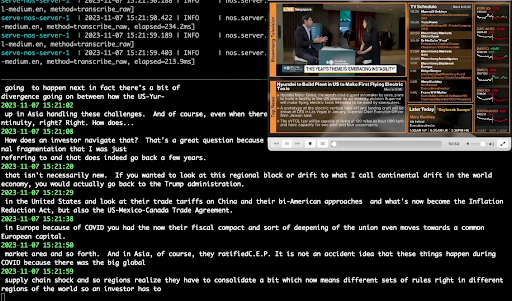

} 'Realize a transcrição de áudio em tempo real usando o Whisper.

API GRPC ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "openai/whisper-small.en" )

with client . UploadFile ( Path ( "audio.wav" )) as remote_path :

response = model ( path = remote_path )

# {"chunks": ...}Rest API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=openai/whisper-small.en '

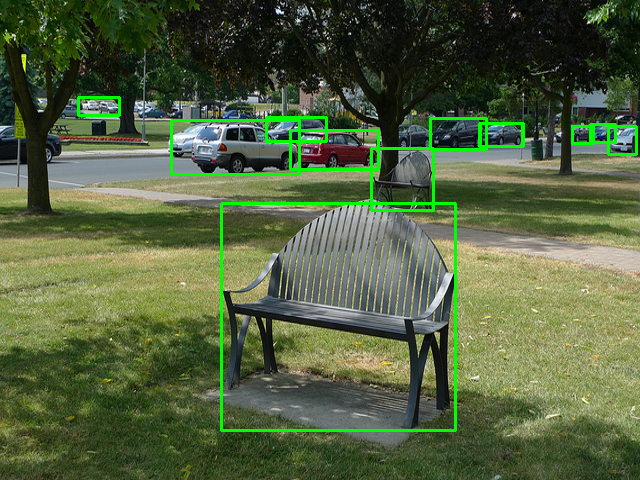

-F ' [email protected] 'Execute tarefas clássicas de visão de computador em 2 linhas de código.

API GRPC ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "yolox/medium" )

response = model ( images = [ Image . open ( "image.jpg" )])Rest API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=yolox/medium '

-F ' [email protected] 'Quer executar modelos não suportados pela NOS? Você pode adicionar facilmente seus próprios modelos seguindo os exemplos no playground da NOS.

Este projeto está licenciado sob a licença Apache-2.0.

O NOS coleta dados de uso anônimo usando sentinela. Isso é usado para nos ajudar a entender como a comunidade está usando o NOS e para nos ajudar a priorizar os recursos. Você pode optar por exclusão de telemetria definindo NOS_TELEMETRY_ENABLED=0 .

Congratulamo -nos com contribuições! Consulte nosso guia contribuinte para obter mais informações.