Site Web | Docs | Tutoriels | Terrain de jeu | Blog | Discorde

Nos est un serveur d'inférence Pytorch rapide et flexible qui s'exécute sur n'importe quel cloud ou AI HW.

inf2 ).Nous vous recommandons fortement d'aller à notre guide QuickStart pour commencer. Pour installer le client nos, vous pouvez exécuter la commande suivante:

conda create -n nos python=3.8 -y

conda activate nos

pip install torch-nos Une fois le client installé, vous pouvez démarrer le serveur NOS via le CLI NOS serve . Cela détectera automatiquement votre environnement local, téléchargera l'image d'exécution Docker et fera tourner le serveur NOS:

nos serve up --http --logging-level INFO Vous êtes maintenant prêt à exécuter votre première demande d'inférence avec nos! Vous pouvez exécuter l'une des commandes suivantes pour essayer les choses. Vous pouvez définir le niveau de journalisation pour DEBUG si vous souhaitez des informations plus détaillées du serveur.

NOS fournit un serveur compatible OpenAI avec prise en charge de streaming afin que vous puissiez connecter votre client LLM OpenAI-compatible préféré pour parler à nos.

API GRPC ⚡

from nos . client import Client

client = Client ()

model = client . Module ( "TinyLlama/TinyLlama-1.1B-Chat-v1.0" )

response = model . chat ( message = "Tell me a story of 1000 words with emojis" , _stream = True )API REST

curl

-X POST http://localhost:8000/v1/chat/completions

-H " Content-Type: application/json "

-d ' {

"model": "TinyLlama/TinyLlama-1.1B-Chat-v1.0",

"messages": [{

"role": "user",

"content": "Tell me a story of 1000 words with emojis"

}],

"temperature": 0.7,

"stream": true

} 'Construisez des bots de discorde MidJourney en quelques secondes.

API GRPC ⚡

from nos . client import Client

client = Client ()

sdxl = client . Module ( "stabilityai/stable-diffusion-xl-base-1-0" )

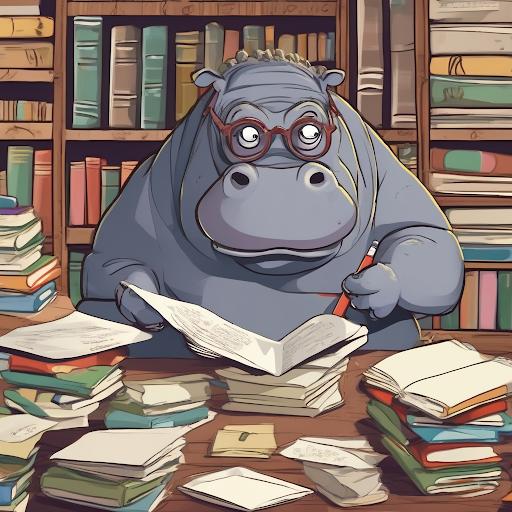

image , = sdxl ( prompts = [ "hippo with glasses in a library, cartoon styling" ],

width = 1024 , height = 1024 , num_images = 1 )API REST

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "stabilityai/stable-diffusion-xl-base-1-0",

"inputs": {

"prompts": ["hippo with glasses in a library, cartoon styling"],

"width": 1024, "height": 1024,

"num_images": 1

}

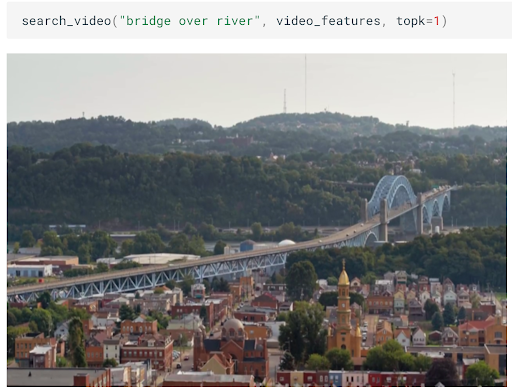

} 'Construisez une recherche sémantique évolutive d'images / vidéos en quelques minutes.

API GRPC ⚡

from nos . client import Client

client = Client ()

clip = client . Module ( "openai/clip-vit-base-patch32" )

txt_vec = clip . encode_text ( texts = [ "fox jumped over the moon" ])API REST

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "openai/clip-vit-base-patch32",

"method": "encode_text",

"inputs": {

"texts": ["fox jumped over the moon"]

}

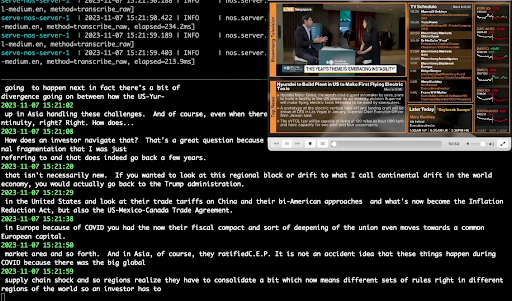

} 'Effectuez la transcription audio en temps réel à l'aide de Whisper.

API GRPC ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "openai/whisper-small.en" )

with client . UploadFile ( Path ( "audio.wav" )) as remote_path :

response = model ( path = remote_path )

# {"chunks": ...}API REST

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=openai/whisper-small.en '

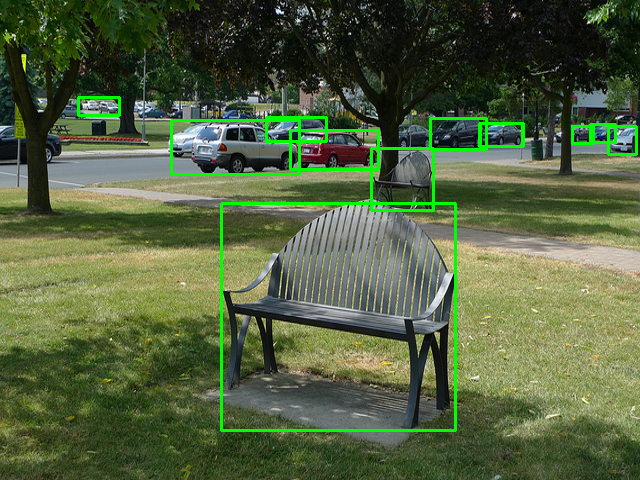

-F ' [email protected] 'Exécutez des tâches classiques de vision informatique en 2 lignes de code.

API GRPC ⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "yolox/medium" )

response = model ( images = [ Image . open ( "image.jpg" )])API REST

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=yolox/medium '

-F ' [email protected] 'Vous voulez exécuter des modèles non pris en charge par nos? Vous pouvez facilement ajouter vos propres modèles en suivant les exemples du terrain de jeu NOS.

Ce projet est concédé sous licence Apache-2.0.

NOS recueille des données d'utilisation anonymes à l'aide de Sentry. Ceci est utilisé pour nous aider à comprendre comment la communauté utilise les NOS et pour nous aider à hiérarchiser les fonctionnalités. Vous pouvez désactiver la télémétrie en définissant NOS_TELEMETRY_ENABLED=0 .

Nous accueillons les contributions! Veuillez consulter notre guide de contribution pour plus d'informations.